Command Palette

Search for a command to run...

SmartSnap:面向自验证Agent的主动证据获取

SmartSnap:面向自验证Agent的主动证据获取

摘要

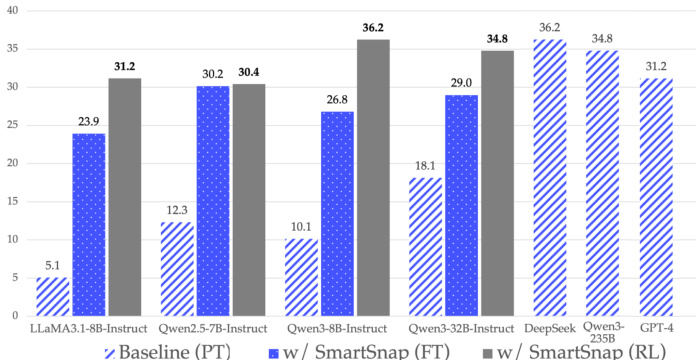

智能体强化学习(Agentic Reinforcement Learning, RL)在复杂图形用户界面(GUI)任务中自主智能体的开发方面展现出巨大潜力,但其可扩展性仍受到任务完成状态验证机制的严重制约。当前的任务验证通常被视为一种被动的、事后处理的过程:验证器(如基于规则的评分脚本、奖励函数或批评模型,以及作为裁判的大型语言模型,LLM-as-a-Judge)需分析智能体完整的交互轨迹,以判断其是否成功完成任务。这种对冗长且包含大量无关、噪声历史信息的上下文进行处理的方式,给验证协议带来了显著挑战,导致验证成本高昂且可靠性低下。为突破这一瓶颈,我们提出SmartSnap——一种范式变革:将传统的被动、事后验证转变为智能体自身主动、实时的自我验证机制。我们引入自验证智能体(Self-Verifying Agent)这一新型智能体架构,其具备双重使命:不仅完成任务,更通过精心筛选的快照证据来证明其完成成果。在所提出的“3C原则”(完整性、简洁性、创造性)指导下,该智能体利用对在线环境的实时访问能力,仅在最小且具有决定性的快照集合上执行自我验证。这些快照证据作为唯一输入材料,供通用的LLM-as-a-Judge验证器判断其有效性与相关性。在不同模型家族与规模下针对移动端任务的实验表明,SmartSnap范式能够实现可扩展的LLM驱动智能体训练,使8B与30B规模模型的性能分别提升达26.08%和16.66%。解决方案探索与证据获取之间的协同作用,有效促进了高效、具备自我验证能力的智能体的形成,其性能在多项指标上已可与DeepSeek V3.1和Qwen3-235B-A22B相媲美。

一句话总结

腾讯优图实验室与北京大学的作者提出 SmartSnap,这是一种在代理强化学习中的范式转变,使由大语言模型驱动的代理能够主动整理最小且具有决定性的快照证据——遵循完整性、简洁性和创造性原则——从而实现高效、可靠的自我验证,并在 Android 任务上使 8B 模型的性能提升高达 26.08%,其表现与 Qwen3-235B-A22B 等更大模型相比也具有竞争力。

主要贡献

-

我们提出 SmartSnap,实现了从被动、事后验证到主动、实时自我验证的范式转变,代理能够自主整理最小且具有决定性的证据快照以证明任务完成,显著提升了基于 GUI 的代理强化学习中的可扩展性和可靠性。

-

在完整性、简洁性和创造性(3C 原则)的引导下,自我验证代理学会生成高质量的证据集,这些证据集既充分又紧凑,使通用的 LLM-as-a-Judge 验证器能够高效评估,而无需依赖冗长或嘈杂的完整轨迹。

-

在 AndroidLab 基准上的实验表明,SmartSnap 使 8B 和 30B 模型的任务成功率分别提升高达 26.08% 和 16.66%,优于 DeepSeek V3.1 和 Qwen3-235B-A22B 等强基线模型,同时通过内在奖励塑造和结构化反馈降低了验证成本。

引言

作者针对代理强化学习中的一个关键挑战:在复杂 GUI 环境中,任务完成的低效且不可靠的事后验证导致可扩展性瓶颈。以往方法依赖于被动验证,即由规则系统、奖励模型或 LLM-as-a-Judge 等验证器分析完整的交互轨迹,导致计算成本高且可靠性下降,原因在于噪声大、无关上下文多。为克服这一问题,作者引入 SmartSnap,实现代理自身主动、实时的自我验证范式转变。核心贡献是自我验证代理,其在完整性、简洁性和创造性(3C 原则)指导下,自主在任务执行过程中收集最小且具有决定性的快照证据。这些整理后的证据随后由通用的 LLM-as-a-Judge 进行快速、可靠的验证。在移动任务上的实验表明,性能显著提升——8B 和 30B 模型分别提升高达 26.08% 和 16.66%,展示了可扩展、高效的训练,成功率更高,并在与 DeepSeek V3.1 和 Qwen3-235B-A22B 等大模型的对比中表现优异。

数据集

- 数据集源自 AndroidLab,这是一个可复现的基准,包含九个 Android 应用中的 138 个任务,每个任务在预定义的 Android 虚拟设备(AVD)上运行。

- 仅使用预定义任务及其初始环境,排除 AndroidLab 的基于规则的评估系统,以支持自我验证范式。

- 观测空间采用压缩的 XML 树表示,而非截图,强调规划与决策能力,而非视觉感知。

- 动作空间包括原生 AndroidLab 动作:点击(Tap)、滑动(Swipe)、输入(Type)、长按(Long Press)、返回主页(Home)、返回上一页(Back),以及用于证据快照的自定义提交工具。

- 训练阶段,作者复现了 Android Instruct 数据集中的 726 个任务,以确保实验间的可比性。

- 监督微调(SFT)数据集基于 VeRL 代理循环的 rollout 框架构建,使用两个大语言模型——DeepSeek V3.1 和 Qwen3-235B-A22B——在全部 726 个任务上生成轨迹。

- 轨迹在任务完成和证据提交两个方面进行收集,确保数据多样且高质量。

- 原始 Android Instruct 的响应更新为两个 LLM 代理的输出,最终生成约 55 万条可训练的问答对,来自 3 万条轨迹。

- 随机选取 10 万条问答对作为初始训练的冷启动数据集。

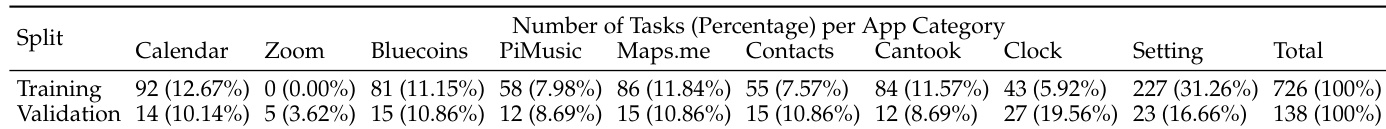

- 任务分布统计详见表 1,提供了各应用和任务类型的详细划分。

方法

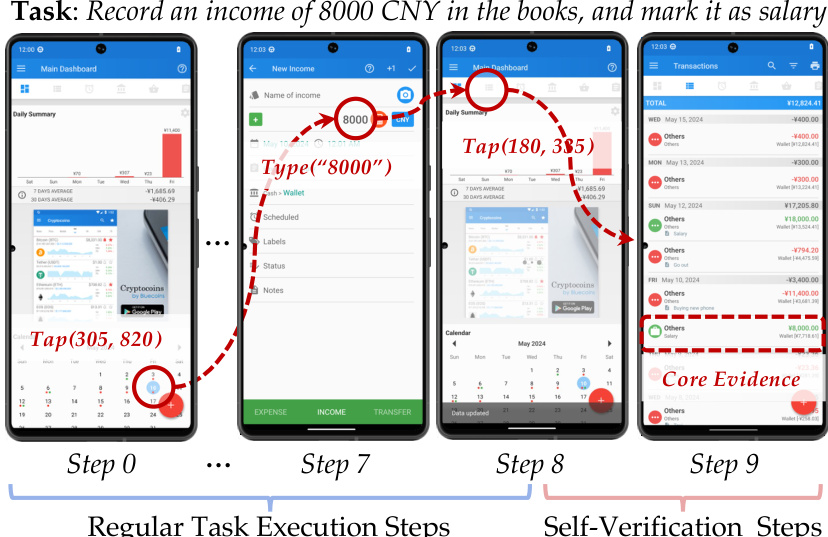

作者采用自我验证代理框架,形式化为增强的马尔可夫决策过程,以应对交互环境中可靠任务完成的挑战。代理在环境 M=(S,A′,P) 中运行,其中增强动作空间 A′ 是执行动作 Aexec(如点击、输入)与整理动作 Acurate(如提交)的并集。代理策略 πθ 将观测、动作历史及任务指令 I 映射到 A′ 上的概率分布。当代理从 Acurate 中选择终止动作(如 submit('text', E))时,轨迹终止,其中 text 为最终消息,E 为整理后的证据集。该证据并非自我声明的摘要,而是指向代理历史中关键交互对的整数索引集合。

SmartSnap 框架的核心在于将证据与工具交互相绑定。作者将单个证据(即展品)定义为原子元组 (at,st+1),表示工具调用 at 与其即时观测 st+1 之间的直接因果事件。该定义确保证据为客观、不可更改的事实,与自我声明摘要的不可靠性形成对比。代理的学习目标是从完整交互历史中选择一个最小但具有决定性的证据集 E。该整理后的证据随后通过 OpenAI 聊天模板进行程序化格式化,生成字符串表示,输入给验证器。

为引导代理的证据整理行为,作者形式化了 3C 原则:完整性、简洁性和创造性。这些原则作为元指令嵌入代理的系统提示中。完整性要求代理包含所有关键工具交互,以最大化验证器的真正例率,确保正确执行的任务不会被惩罚。简洁性旨在通过减少冗余信息来最小化假正例率,这对验证器的效率和鲁棒性至关重要,可缓解上下文退化等风险。创造性鼓励代理在必要时采取额外的、以证据为导向的动作,使其从被动的历史记录者转变为积极的调查者。该原则使代理能够通过检查环境来发现自身动作的间接后果,从而构建更稳健、更全面的任务完成证明。

证据验证与奖励塑造过程旨在提供密集、结构化的反馈。构建了一个由四个部分组成的多组件奖励函数 Rtotal:Rformat 惩罚格式错误;Rvalidity 奖励相关证据;Rcomplete 是基于“仅在明确证明下才算成功”的严格规则的二元奖励,包含零假设检查和可追溯推理验证;Rconcise 惩罚证据集的大小。该复合奖励函数指导代理的端到端学习。作者采用分组相对策略优化(GRPO)作为学习算法,通过从同一策略采样的轨迹组计算优势函数,消除了对独立评论网络的需求。该方法降低了训练成本和内存开销。

实验

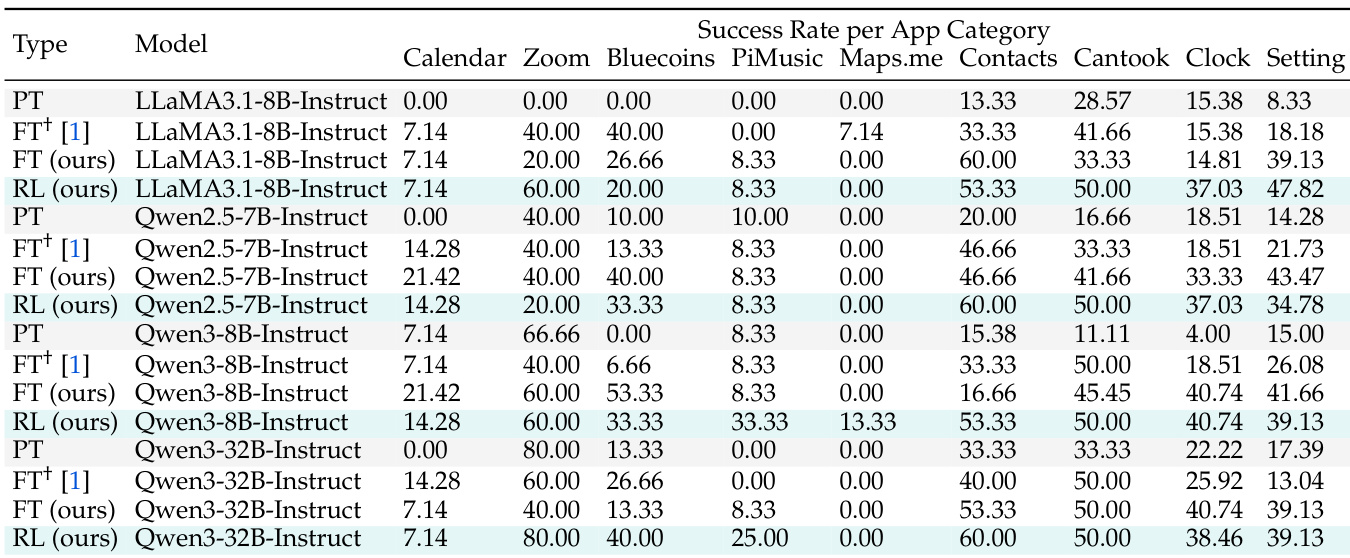

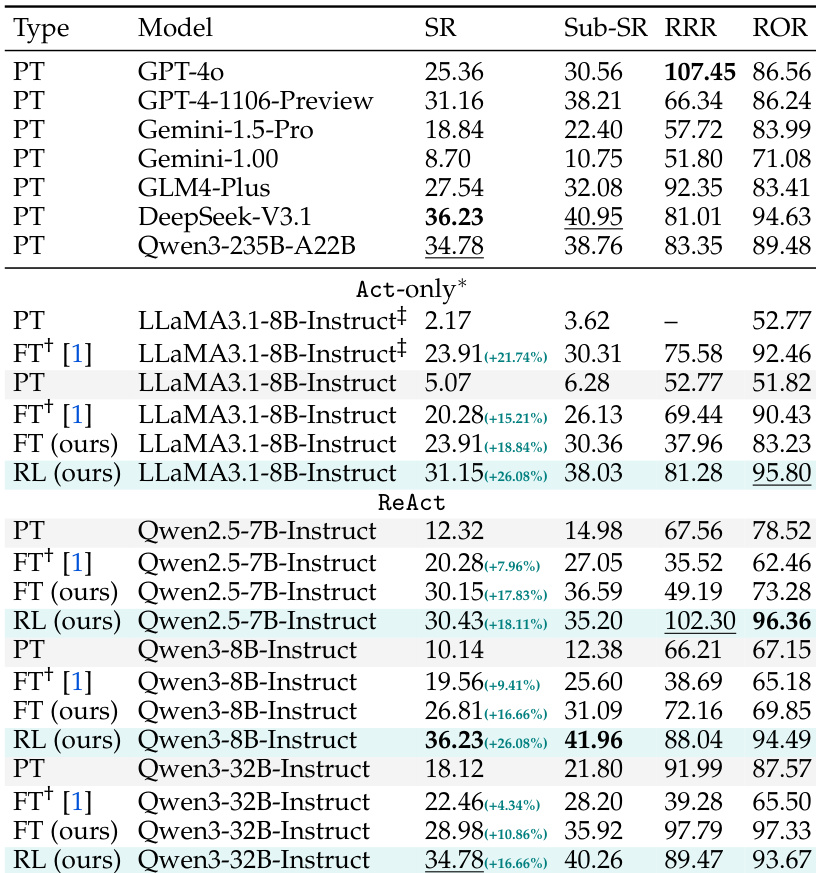

- SmartSnap 引入了自我验证代理范式,将任务执行与证据整理集成,显著提升了在 AndroidLab 上各类模型家族和规模下的性能,且无需依赖基于规则的验证器或任务特定奖励模型。

- 在使用 XML 模式的 AndroidLab 上,SmartSnap(Qwen3-8B-Instruct)和 SmartSnap(Qwen3-32B-Instruct)分别与 DeepSeek-V3.1 和 Qwen3-235B-A22B 达到相当的成功率,展示了在不同模型规模下的强泛化能力。

- 所有被研究的模型在性能上均超过原始提示和微调方法 16% 以上,大多数应用类别均有持续提升,仅 Maps.me 因知识差距限制了进展。

- 自我验证使代理能够整理最小且高质量的证据集——平均每任务 1.5 个证据——从而实现更高效、更紧凑的交互,减少对试错的依赖。

- 在 SmartSnap 下的强化学习持续提升训练奖励和验证准确率,交互轮次和响应长度不断下降,表明任务效率和策略优化显著改善。

- 案例研究显示,代理学会纠正对 UI 元素的误读,发现最优路径(如使用浮动按钮或搜索功能),并提交具有决定性的证据,展示了更强的问题分解与自我验证能力。

- 在 Calendar、Maps.me 和 Zoom 等复杂领域出现性能停滞,凸显了通过持续预训练注入领域特定知识以及构建更大、更均衡训练数据集的必要性。

作者使用 SmartSnap 提升了 LLM 驱动代理在 AndroidLab 上的性能,在各类应用类别和模型规模下均显著提升了成功率。结果表明,所提出的自我验证范式,尤其是通过强化学习,使代理能够更高效地完成任务,并生成简洁、相关性强的证据,相比原始提示和微调方法取得了更高的成功率。

作者使用 SmartSnap 提升了 LLM 驱动代理在 AndroidLab 上的性能,通过强化学习显著提升了成功率和证据整理能力。结果表明,所提出的方法在各类模型家族和规模下均持续优于原始提示和微调方法,最佳结果在 ReAct 模式下结合 Qwen3-32B-Instruct 时取得。

作者分析了 AndroidLab 基准中任务在应用类别中的分布,显示训练集严重依赖 Settings 应用的任务(占 31.26%),而验证集则包含更均衡的分布,Calendar、Bluecoins 和 Contacts 有显著代表。这种不平衡表明,模型性能可能特别受训练数据中某些应用领域过度代表的影响。

作者使用 SmartSnap 提升了 LLM 驱动代理在 AndroidLab 上的性能,在各类模型家族和规模下均显著提升了成功率。结果表明,SmartSnap 的微调与强化学习均带来显著增益,Qwen3-32B-Instruct 和 Qwen3-235B-A22B 等模型性能已可与 DeepSeek-V3.1 和 GPT-4 等更大模型相媲美。