Command Palette

Search for a command to run...

DreaMontage:任意帧引导的单次视频生成

DreaMontage:任意帧引导的单次视频生成

摘要

“一镜到底”(one-shot)技法在电影制作中代表了一种独特而精妙的美学风格。然而,其实际应用常受限于高昂的成本以及复杂的现实约束。尽管新兴的视频生成模型提供了虚拟实现的可能,但现有方法大多依赖于简单的片段拼接(naive clip concatenation),往往难以保证视觉流畅性与时间连贯性。本文提出DreaMontage,一个面向任意帧引导生成的综合性框架,能够从多样化的用户输入中合成无缝、富有表现力且时长较长的“一镜到底”视频。为实现这一目标,我们从三个核心维度展开攻关:(i)我们将轻量级的中间条件控制机制融入DiT(Diffusion Transformer)架构,通过采用自适应调优(Adaptive Tuning)策略,有效利用基础训练数据,从而实现对任意帧的强健控制能力;(ii)为提升视觉保真度与电影级表现力,我们构建了一个高质量数据集,并引入视觉表现力微调(Visual Expression SFT)阶段。针对主体运动合理性与转场平滑性等关键问题,我们设计了定制化的DPO(Direct Preference Optimization)优化方案,显著提升了生成内容的成功率与可用性;(iii)为支持长序列内容的生成,我们提出一种分段自回归(Segment-wise Auto-Regressive, SAR)推理策略,具备高效内存利用特性。大量实验表明,本方法在保持计算效率的同时,能够生成视觉冲击力强、时间连贯性优异的“一镜到底”效果,使用户得以将零散的视觉素材转化为生动、连贯的电影级一镜到底体验。

一句话总结

字节跳动研究者提出 DreaMontage 框架,通过 DiT 架构内的自适应调优与分段自回归推理,克服了传统片段拼接的局限性,实现从碎片化输入生成电影级长序列的无缝单镜头视频生成,关键技术包括视觉表达优化与定制化训练策略。

核心贡献

- 单镜头电影制作在现实世界中面临难以承受的成本与约束,而现有视频生成方法依赖简单的片段拼接,无法保证过渡过程中的视觉平滑性与时间连贯性。DreaMontage 在 DiT 架构中集成了轻量级中间条件机制,采用自适应调优策略利用基础训练数据,实现鲁棒的任意帧控制能力。

- 为解决生成内容中主体运动合理性与过渡平滑性等关键问题,该框架构建高质量数据集,并实施视觉表达监督微调阶段,随后采用定制化 DPO 方案。此流程显著提升电影表现力及无缝单镜头视频合成的成功率。

- 针对内存限制下的长序列单镜头生成需求,DreaMontage 设计分段自回归推理策略,在维持计算效率的同时支持长时长视频生产。大量实验证实该方法能生成视觉震撼、时间连贯的结果,将碎片化输入转化为连贯的电影体验。

引言

作者致力于解决无缝"单镜头"长视频生成的挑战——此类视频在电影制作中因沉浸式叙事备受重视,但传统方式需高昂制作成本与物理约束。尽管近期视频扩散模型展现出潜力,但依赖首尾帧条件的先前方法无法确保时间连贯性:潜空间对中间帧表征的局限、关键帧间语义偏移,以及长时生成的计算负担,常导致过渡断裂。为此,作者提出 DreaMontage,通过三项创新突破:1) 基于共享 RoPE 与自适应训练的中间条件机制实现精确帧级控制;2) 在精选数据集上采用差异化提示优化的监督微调,增强视觉连续性并减少突兀剪辑;3) 分段自回归推理策略在维持叙事完整性的同时实现内存高效的长视频生成。

数据集

作者对视觉表达 SFT 数据集的描述如下:

- 构成与来源:该数据集包含新采集的类别均衡视频样本,专门针对模型薄弱环节。其构建基于对失效案例的细粒度分析,并采用分层分类法组织。

- 关键子集细节:数据覆盖五大类别(镜头类型、视觉特效、运动场景、空间感知、高级转场),每类细分为精确子类(如镜头类型下的"基础运镜 – 推镜头";视觉特效下的"生成 – 光效")。作为小规模集合,每个子类的视频均经严格筛选以体现核心场景特征与高动态运动。相比先前自适应调优数据,这些视频时长更长(达 20 秒),且包含更流畅的场景过渡。

- 训练应用:作者直接在自适应调优阶段获得的模型权重上,使用该数据集进行监督微调(SFT),并复用前一阶段的相似训练策略与随机条件设置。

- 处理细节:主要处理差异在于刻意收集强调运动动态与转场的长时视频。除分层分类与筛选标准外,未提及特殊裁剪策略或元数据构建。

方法

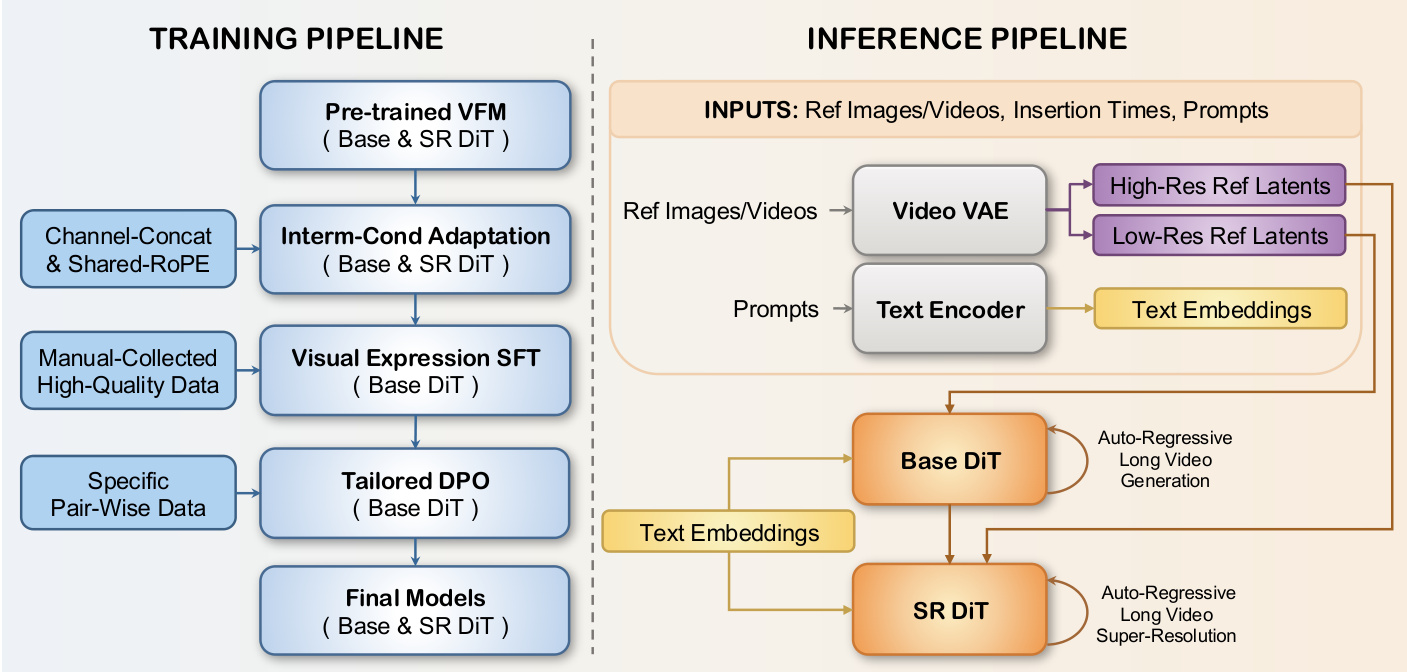

作者基于 DiT 视频生成框架,通过新型中间条件机制与渐进式训练流程,实现长时电影级单镜头视频的任意帧引导合成。整体架构(如下图所示)围绕两大核心组件:逐步提升模型能力的训练流水线,以及支持灵活高效生成的推理流水线。

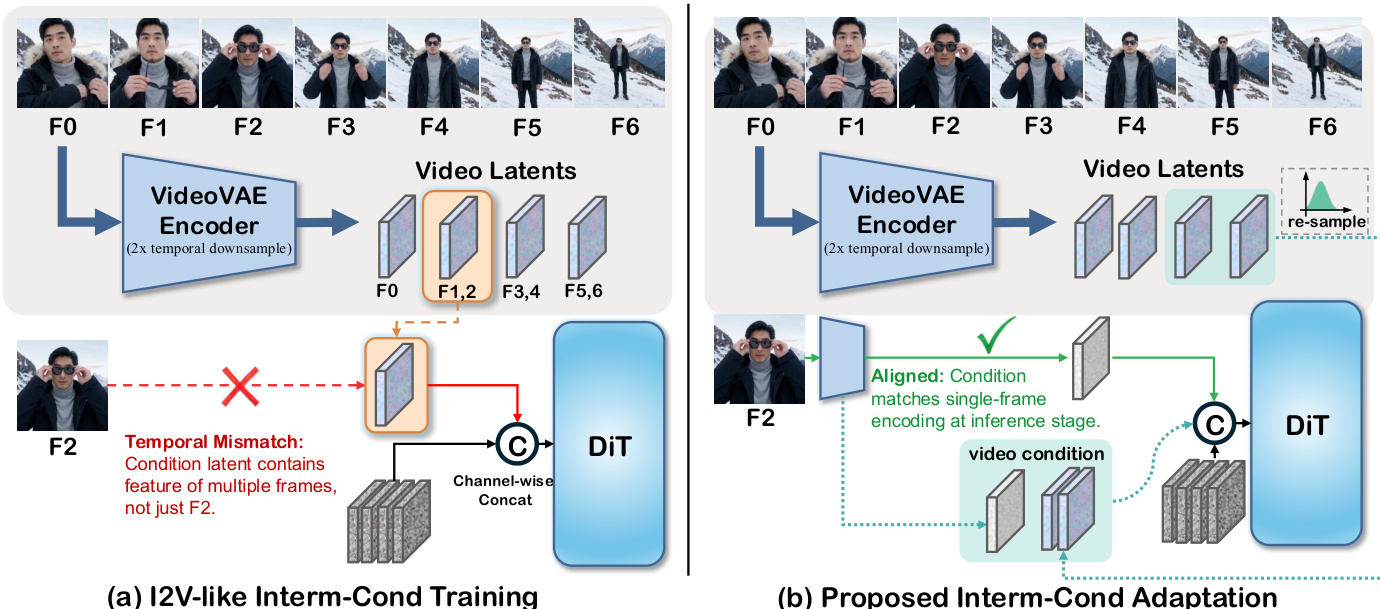

框架核心是中间条件自适应策略(Interm-Cond Adaptation),用于解决任意帧条件化固有的时间错位问题。VideoVAE 编码器执行 2 倍时域下采样,导致单帧潜表示对应多个生成帧,引发条件控制不精确。如下图所示,作者通过使训练分布与推理对齐解决此问题:对于单帧条件,重新编码该帧;对于视频条件,则从潜分布中重采样后续帧以匹配目标视频的时间粒度。这种轻量级调优无需修改架构即可实现鲁棒的任意帧控制。

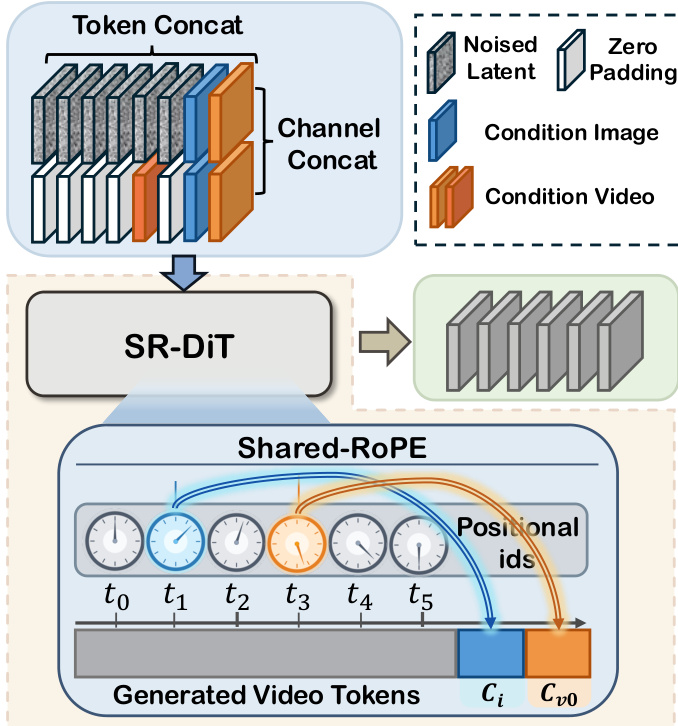

在超分辨率环节,作者引入共享 RoPE(Shared-RoPE)以缓解条件信号通道拼接导致的闪烁与色偏。如下图所示,除通道级条件化外,参考图像的 VAE 潜表示沿 token 序列维度拼接,其旋转位置编码(RoPE)与对应时间位置对齐。这种序列级条件化确保时空一致性,对维持高分辨率保真度尤为关键。对于视频条件,仅首帧应用共享 RoPE 以避免计算开销。

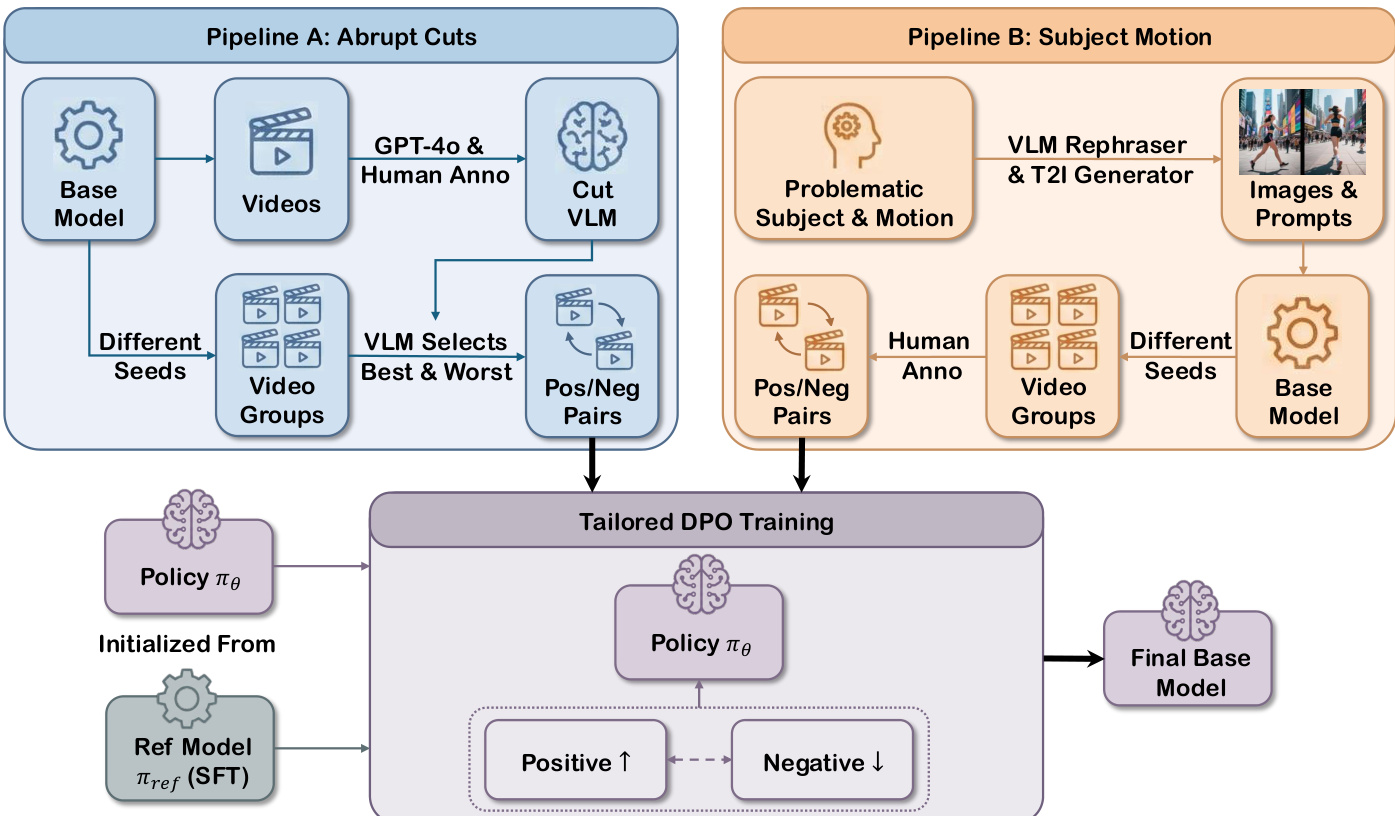

为提升视觉表现力与时间连贯性,作者使用人工精选高质量数据集实施视觉表达 SFT 阶段,随后进行定制化 DPO 训练,重点解决两类失效模式:突兀剪辑与主体运动物理不合理性。如下图所示,两条独立流水线生成对比偏好对:流水线 A 利用训练好的 VLM 判别器,从相同提示不同种子生成的视频组中自动筛选"最佳"与"最差"样本,聚焦剪辑严重性;流水线 B 依赖人工标注识别问题运动,生成引导模型趋向物理合理动态的样本对。DPO 目标函数直接优化策略 πθ 以对抗参考模型 πref:

LDPO=−E(c,vw,vl)∼D[logσ(βlogπref(vw∣c)πθ(vw∣c)−βlogπref(vl∣c)πθ(vl∣c))]其中 c 表示条件输入,β 控制偏离参考策略的程度。

针对长视频生成,作者设计分段自回归(SAR)推理策略。目标视频通过潜空间滑动窗口划分为连续片段,用户提供的条件作为候选边界。每片段 sn 基于前一片段尾部潜表示 τ(sn−1) 和局部条件 Cn 条件化生成:

sn=Gθ(τ(sn−1),Cn)其中 Cn={cn(1),…,cn(m)} 表示当前窗口内的异构条件。此自回归机制确保片段边界处的像素级连续性。重叠潜表示在解码前融合,最终生成时间连贯的长视频。整个流程在潜空间运行,避免像素级伪影,并复用先前训练阶段模型习得的一致性。

实验

- 通过定性示例展示任意帧引导的单镜头视频生成能力,在火车转赛博朋克、眼睛转草原等复杂场景中实现无变形伪影的连贯叙事过渡。

- 在多关键帧条件化测试中,整体偏好度比 Vidu Q2 高 15.79%,比 Pixverse V5 高 28.95%,提示遵循性显著提升(+23.68%),同时保持运动与视觉质量竞争力。

- 在首尾帧条件化测试中,整体偏好度超越 Kling 2.5 达 3.97%,运动效果与提示遵循性均提升 4.64%,视觉保真度与顶级模型相当。

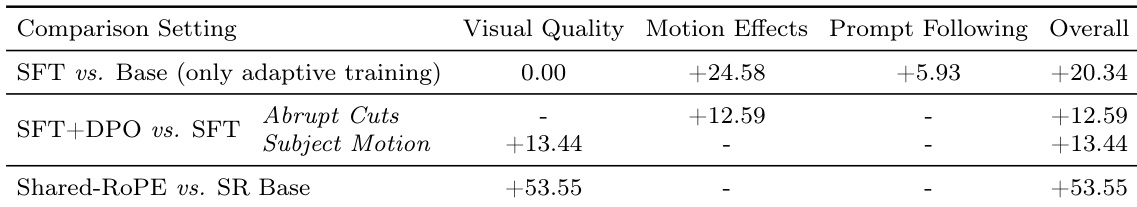

作者通过消融实验分离 DreaMontage 关键优化的影响:SFT 与 DPO 结合显著改善运动处理与整体性能,而共享 RoPE 对视觉质量提升最大。结果表明自适应训练单独提升运动与提示遵循性而不影响视觉保真度,共享 RoPE 相比基线变体大幅增强视觉质量。这些优化的累积效应在多指标上带来实质性性能提升。