Command Palette

Search for a command to run...

生成式重聚焦:从单张图像实现灵活的失焦控制

生成式重聚焦:从单张图像实现灵活的失焦控制

Chun-Wei Tuan Mu Jia-Bin Huang Yu-Lun Liu

摘要

景深控制在摄影中至关重要,但实现完美对焦往往需要多次尝试或依赖特殊设备。单张图像的重新对焦技术仍面临巨大挑战,其核心在于恢复清晰的图像内容并生成逼真的散景效果。现有方法存在显著局限:通常需要全焦输入图像,依赖模拟器生成的合成数据,且对光圈的控制能力有限。为此,我们提出了一种两阶段的生成式重对焦方法——Generative Refocusing。该方法首先利用DeblurNet从多种输入中恢复出全焦图像,再通过BokehNet生成可调控的散景效果。其主要创新在于采用半监督训练策略:将合成的成对数据与未配对的真实散景图像相结合,并利用EXIF元数据捕捉真实光学系统特性,突破了传统模拟器所能提供的信息边界。实验结果表明,我们的方法在失焦去模糊、散景合成及重对焦等多个基准测试中均达到领先水平。此外,Generative Refocusing还支持文本引导的参数调整以及自定义光圈形状的生成,显著提升了用户对成像效果的可控性与创作自由度。

一句话总结

来自国立阳明交通大学和马里兰大学的研究人员提出生成式重对焦(Generative Refocusing)技术,该DeblurNet-BokehNet系统通过半监督训练实现最先进的离焦去模糊与散景合成。该方法利用真实EXIF元数据结合合成数据,克服了先前对模拟器的依赖,支持文本引导的景深控制和心形散景等自定义光圈形状。

核心贡献

- 当前单图像重对焦方法需全焦输入、严重依赖模拟器生成的合成数据,且光圈控制有限,导致在无专业设备或多帧拍摄时难以实现实际景深调整。

- 作者提出生成式重对焦技术:采用两阶段流程,DeblurNet从多样输入恢复全焦图像,BokehNet负责散景合成;通过半监督训练融合合成配对数据与未配对真实散景图像,利用EXIF元数据建模超越模拟器能力的真实光学特性。

- 该方法在离焦去模糊、散景合成和重对焦基准测试中均达到最先进水平,同时支持文本引导调整和自定义光圈形状等新功能,实现创意后期控制。

引言

扩散模型通过生成先验推动了图像恢复技术发展,支持去模糊和伪影消除等任务。然而现有离焦去模糊方法常将其视为独立任务,未能与散景合成无缝集成以实现可控重对焦;而散景渲染通常需要纯净全焦输入和精确深度图——这对真实单图像应用不切实际。先前方案还难以处理空间变化的模糊伪影,且在处理离焦输入或真实镜头特性时缺乏灵活性。

作者通过引入明确分离离焦去模糊与散景合成的两阶段流程解决此问题。该方法可接受离焦或全焦图像,利用混合合成数据与未配对真实数据的半监督学习捕捉真实光学特性,实现对焦平面、散景强度和光圈形状的精确控制——无需专业拍摄硬件或配对训练数据即可达成场景一致的重对焦。

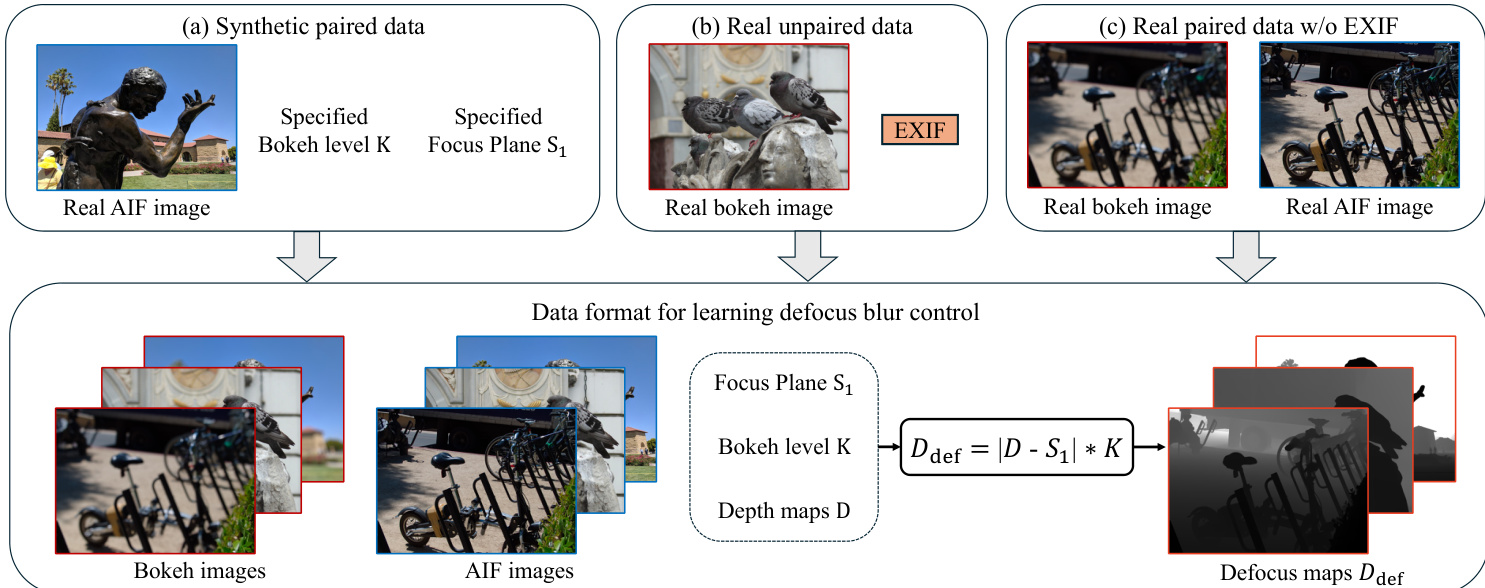

数据集

作者构建多阶段训练流程,使用经特殊处理的多样化数据集:

-

组成与来源:

融合合成配对数据、含EXIF元数据的真实未配对散景图像、无元数据的真实配对散景图像,以及自定义PointLight-1K数据集。来源包括DPDD、REALBOKEH_3MP、BOKEHDIFFUSION和Flickr衍生合成数据。 -

关键子集细节:

- DeblurNet训练:使用DPDD官方训练集(配对离焦/全焦图像)和REALBOKEH_3MP。通过拉普拉斯方差筛选REALBOKEH_3MP,保留最清晰的3,000张图像。

- BokehNet合成预训练:基于真实全焦图像(从[82]/[30]数据集筛选1.7k张)和估计深度渲染散景。使用模拟器[48]随机采样对焦平面S1和散景强度K。

- 真实未配对数据:利用含EXIF元数据的BOKEHDIFFUSION。通过K≈2F(S1−f)f2S1×pixel_ratio估算K。以DeblurNet输出为全焦输入,通过BiRefNet生成的合焦掩膜(人工筛选错误)优化对焦平面。

- 无元数据的真实配对数据(REALBOKEH_3MP):通过模拟器闭环校准伪K∗:K⋆=(Kmin,Kmax)argmax SSIM(B(Iaif,D;S1,K),Ireal)。

- PointLight-1K:通过Flickr关键词挖掘(如"夜景"、"散景")、GPT-4o提示扩展、FLUX.1-Dev图像生成(锐度微调)及DeblurNet优化,精选1k张夜景图像以消除残余模糊。

-

训练用途:

- DeblurNet仅使用DPDD和筛选后的REALBOKEH_3MP训练全焦重建。

- BokehNet先用合成配对数据预训练,再用真实未配对/配对数据微调。最终训练以真实数据为主以克服渲染器偏差。

- PointLight-1K支持形状感知合成:基础BokehNet(无形状控制训练)通过冻结主干网络微调,新增接收二值/光栅PSF核的形状条件分支。

-

处理细节:

- 所有全焦候选图像均经拉普拉斯方差滤波排除模糊图像。

- 离焦图由估计深度和对焦平面代理(S1)生成,真实数据使用BiRefNet掩膜(专家验证)获取可靠S1。

- REALBOKEH_3MP的EXIF元数据缺口通过SSIM优化K⋆补偿。

- PointLight-1K生成包含DeblurNet后处理,确保点光源线索的最小残余模糊。

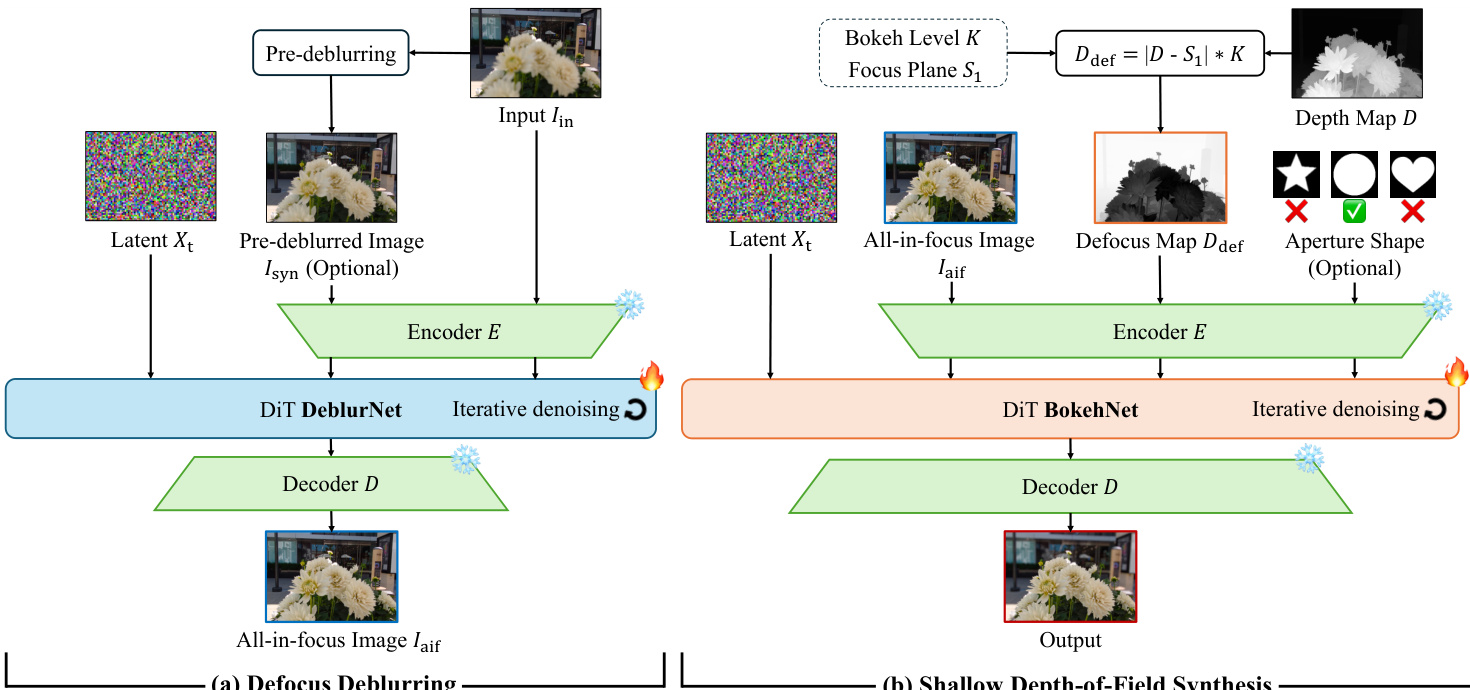

方法

作者采用两阶段架构(DeblurNet后接BokehNet),实现单输入图像的灵活后期景深控制。该分解方案先恢复清晰全焦表征,再合成用户可控散景效果,解决了先前方法需全焦输入或缺乏光圈形状控制的局限。

第一阶段中,DeblurNet处理输入图像Iin及可选的现成去模糊模型生成的预去模糊图像Ipd。该网络基于扩散框架(DiT架构),迭代去噪隐表示Xt生成全焦输出Iaif。为提升对预去模糊输入伪影的鲁棒性,作者引入双重条件机制:位置解耦使用空间偏移的2D位置网格编码Iin和Ipd,使模型将预去模糊图像视为低频锚点,同时从原始输入提取高频细节;预去模糊随机丢弃在训练中随机替换Ipd为零张量,确保测试时单输入推理的有效性。

如下图所示,第二阶段BokehNet接收全焦图像Iaif,基于用户指定参数(对焦平面S1、散景强度K、可选光圈形状)合成重对焦输出。离焦图计算为Ddef=∣D−S1∣K(D为估计深度图),引导BokehNet的扩散过程(同样采用DiT架构)渲染模拟真实光学行为的空间变化模糊。光圈形状可选二值掩膜调制散景核,实现心形散景等创意效果。

训练采用半监督方式,融合合成配对数据与未配对真实散景图像。合成数据通过深度与用户指定对焦参数提供几何一致性。含EXIF元数据的真实未配对数据使模型学习模拟器无法复现的真实镜头特性。作者通过估计深度和用户定义对焦平面构建真实图像离焦图,确保模型泛化能力超越合成渲染。该混合方法兼顾物理合理性和视觉真实性。

实验

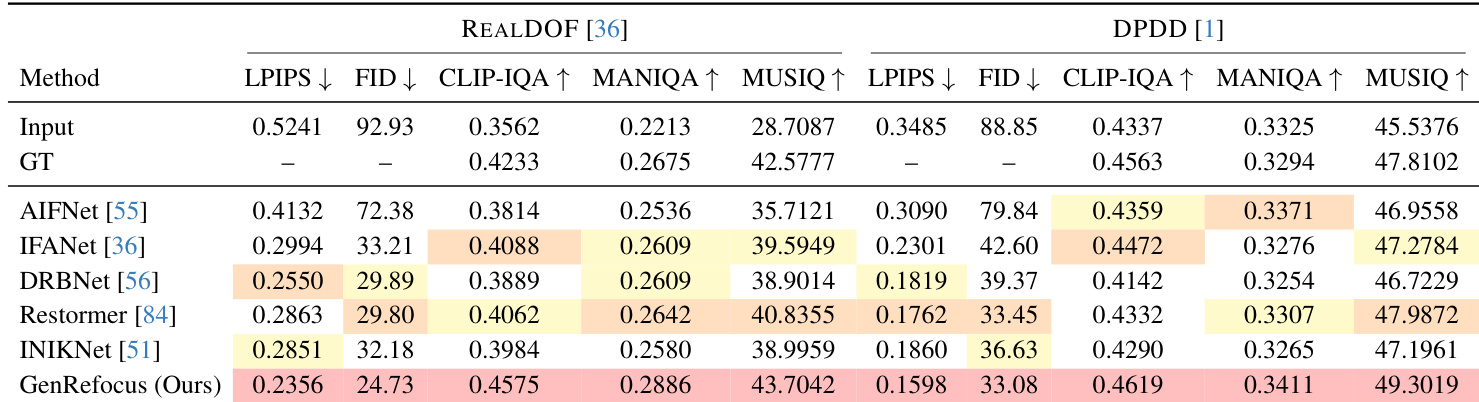

- 离焦去模糊:DeblurNet在参考指标上全面超越基线,部分无参考图像质量指标甚至优于真值;在复杂场景中实现精准文本恢复与结构一致结果.

- 散景合成:在LF-BOKEH数据集上,BokehNet取得最高保真度与感知分数;经单图像SSIM优化的散景水平验证,半监督训练消除基线中的过度平滑和离焦不一致等伪影。

- 重对焦:在LF-REFOCUS数据集上,DeblurNet+BokehNet流程在保真度与感知指标上超越所有两阶段基线组合,实现精确对焦平面定位与照片级散景合成。

- 消融实验:两阶段重对焦在LF-REFOCUS上比单阶段方案PSNR高0.82;BokehNet训练加入真实未配对散景数据使LF-BOKEH的SSIM提升0.03、LPIPS改善0.05。

- 附加验证:支持文本引导去模糊纠正幻觉,并合成用户指定光圈形状;相比Gemini-3 Nano Banana Pro等VLM重对焦方法,内容保留更佳。

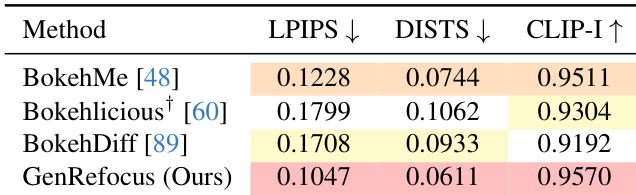

作者在REALDOF和DPDD数据集上对比GenRefocus与多个基线,显示其取得最低LPIPS和FID分数,以及最高CLIP-IQA、MANIQA和MUSIQ分数,表明感知质量与保真度优势。结果在双数据集上一致领先,GenRefocus在多指标下生成最真实去模糊输出。其两阶段设计与半监督训练使其优于单阶段及纯合成训练方案。

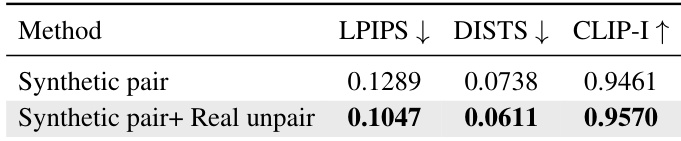

作者对比BokehNet是否使用真实未配对散景图像的训练效果,显示加入真实数据后所有指标均改善:LPIPS和DISTS下降,CLIP-I上升。结果证实半监督训练使模型学习比纯合成训练更真实光学行为。

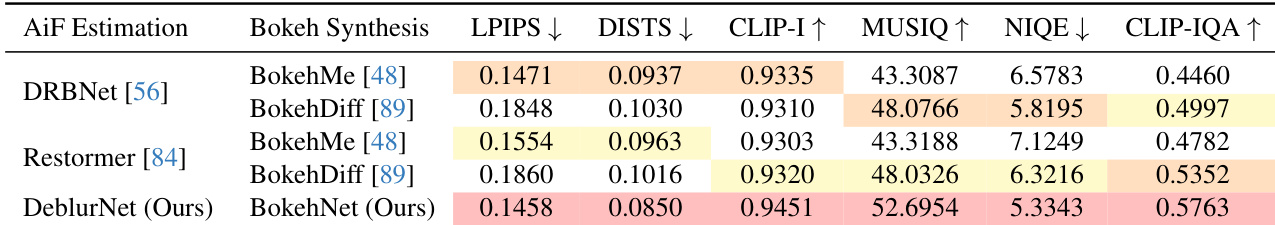

作者将DeblurNet+BokehNet流程与现有全焦估计器和散景合成器组合在重对焦基准上对比,显示该方法在所有指标(LPIPS/DISTS更低,CLIP-I/MUSIQ/NIQE/CLIP-IQA更高)取得最佳分数,表明保真度与感知质量优势。此提升源于联合优化与半监督训练,实现更精确对焦定位和物理一致散景合成。

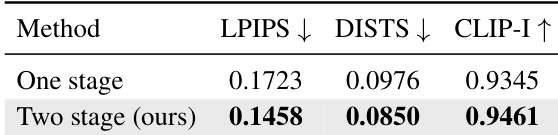

作者在LF-REFOCUS基准上对比单阶段与两阶段重对焦流程,显示两阶段方案在所有指标表现更优。结果表明该设计支持更好景深控制及每阶段独立半监督学习,实现更精确重对焦与真实散景合成。

作者在LF-BOKEH基准上用感知指标评估散景合成方法,GenRefocus全面超越基线。结果表明其取得最低LPIPS/DISTS分数和最高CLIP-I分数,显示感知保真度与语义对齐优势。此提升归因于真实散景图像的半监督训练,实现比模拟器方案更真实模糊渲染。