Command Palette

Search for a command to run...

StereoPilot:通过生成先验学习统一且高效的立体转换

StereoPilot:通过生成先验学习统一且高效的立体转换

Guibao Shen Yihua Du Wenhang Ge Jing He Chirui Chang Donghao Zhou Zhen Yang Luozhou Wang Xin Tao Ying-Cong Chen

摘要

立体显示技术的快速发展,包括虚拟现实(VR)头显和3D影院的广泛应用,推动了对高质量立体视频内容的日益增长的需求。然而,3D视频的制作仍然成本高昂且流程复杂,而现有的单目图像到立体图像的自动转换方法受限于多阶段“深度-扭曲-修复”(Depth-Warp-Inpaint, DWI)流水线的固有缺陷。该范式存在误差传播、深度歧义以及平行与汇聚式立体配置之间格式不一致等问题。为应对这些挑战,我们提出了UniStereo——首个大规模统一的立体视频转换数据集,涵盖两种立体视频格式,从而支持公平的基准测试与鲁棒的模型训练。基于该数据集,我们进一步提出StereoPilot,一种高效的前馈式模型,能够直接合成目标视图,无需依赖显式的深度图或迭代式扩散采样。StereoPilot引入可学习的域切换机制与循环一致性损失,可无缝适应不同立体格式,并显著提升视图间的一致性。大量实验表明,StereoPilot在视觉保真度与计算效率方面均显著优于现有最先进方法。项目主页:https://hit-perfect.github.io/StereoPilot/。

一句话总结

来自港科大(广州)和快手Kling团队等的研究人员提出了StereoPilot——一种高效的前馈模型,可直接合成目标视图进行单目转立体视频转换,无需深度图或扩散采样。该模型通过可学习域切换器和循环一致性损失,克服了传统深度映射-扭曲-修复流程中的误差累积问题,显著提升了VR和3D内容生成的质量与速度。

主要贡献

- 论文解决了单目转立体视频转换中的关键局限:传统多阶段"深度映射-扭曲-修复"流程存在误差累积、反射/半透明场景中的深度模糊,以及平行与汇聚式立体格式间的不一致性问题。

- 提出StereoPilot高效前馈模型,无需显式深度图或迭代扩散采样,通过单步直接合成目标视图;采用可学习域切换器实现跨格式兼容性,并利用循环一致性损失确保视图对齐。

- 基于首个覆盖两种立体格式的大规模统一数据集UniStereo,大量实验表明StereoPilot在视觉保真度和计算效率上显著优于现有最先进方法。

引言

VR头显和3D影院等立体显示设备推动了高质量立体视频的需求,但3D内容制作仍成本高昂且依赖人工。当前单目转立体转换依赖多阶段深度映射-扭曲-修复流程,存在误差累积、深度模糊及平行/汇聚式立体格式处理不一致等问题。现有新视角合成方法也因需要多视角训练数据或相机控制受限而效果不佳。作者提出UniStereo——首个覆盖两种立体格式的大规模统一数据集,以及StereoPilot高效前馈模型。该模型无需显式深度图或迭代扩散即可直接合成目标视图,通过可学习域切换器和循环一致性损失实现立体格式无缝适配,在视觉质量和计算速度上显著超越现有方法。

数据集

作者提出UniStereo——首个用于立体视频转换的大规模统一数据集,融合平行与汇聚式立体格式以解决先前工作中的评估不一致问题。数据集包含两个关键子集:

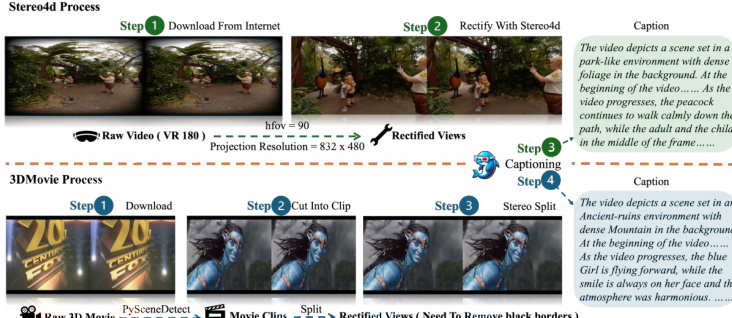

• Stereo4D(平行格式):源自7,000个YouTube VR180视频,经处理后获得约60,000个片段。片段标准化为832×480分辨率、16 fps帧率及固定81帧长度(5秒)。过滤非信息性内容后,使用ShareGPT4Video为左眼视图生成描述文本。

• 3DMovie(汇聚格式):基于142部经验证的3D电影构建,产出约48,000个片段。作者手动排除"伪立体"内容及非SBS格式。处理流程包括移除片头/标识、对称黑边裁剪、重采样至16 fps,并通过ShareGPT4Video生成描述文本后分割为81帧片段。

训练集混合58,000个Stereo4D和44,879个3DMovie片段。评估使用各子集独立的400片段测试集。所有数据经严格标准化:分辨率固定832×480,时序对齐至81帧,且仅对左眼视频生成描述文本以支持文本引导转换。

方法

作者采用创新的"扩散即前馈"架构解决单目转立体视频转换的确定性问题,规避迭代扩散或深度映射-扭曲-修复流程固有的低效与伪影。核心创新在于将预训练视频扩散Transformer重构为单步确定性预测器——不再作为需数十次采样的生成模型,而是通过固定扩散时间步至近零值t0=0.001(此时模型输入状态接近真实数据分布)。左右视图转换表达为直接映射:zr=vθ(zl,t0,c),其中zl和zr分别表示左右视图的潜在表示,c为文本条件信号。此设计使推理仅需单次前向传播,在大幅降低计算成本的同时保留预训练模型丰富的生成先验以完成遮挡补全。

为处理几何关系迥异的平行与汇聚式立体格式共存问题,作者引入可学习域切换器s。该切换器作为一维向量添加至扩散模型的时间嵌入,使单一统一架构能条件化生成任一格式:对于归属汇聚域Dc的立体对(zl,zr),输出为vθ(zl,t0,c,sc);平行域Dp则使用vθ(zl,t0,c,sp)。此设计避免了独立模型需求,缓解了域特异性偏差,使模型能稳健泛化至多样内容类型(包括通常挑战单格式训练模型的合成动画风格)。

训练架构框架图展示了模型采用两个对称Transformer:vl→r,θl用于左转右合成,vr→l,θr用于右转左合成。二者均以相同时间步t0、文本描述c及域切换器s为条件。训练目标结合重建损失与循环一致性损失:重建损失Lrecon=∥z^r−zr∥22+∥z^l−zl∥22确保与真实视图的保真度;循环一致性损失Lcycle=∥zl−z^lc∥22(其中z^lc=vr→l,θr(z^r,t0,c,s))通过要求视图经对侧眼转换后能恢复原视图来保证几何对齐。总损失L=Lrecon+λ⋅Lcycle联合优化双生成器,输出高保真、时序一致的立体视频。

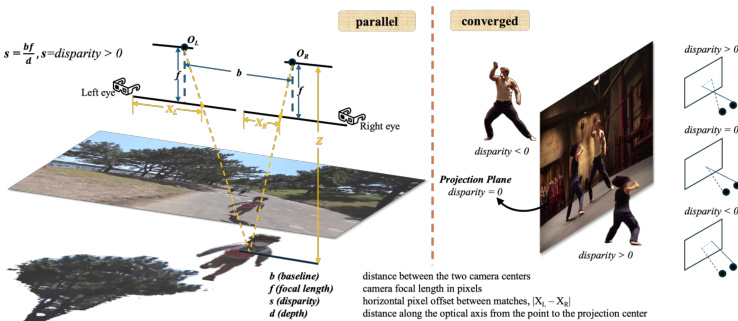

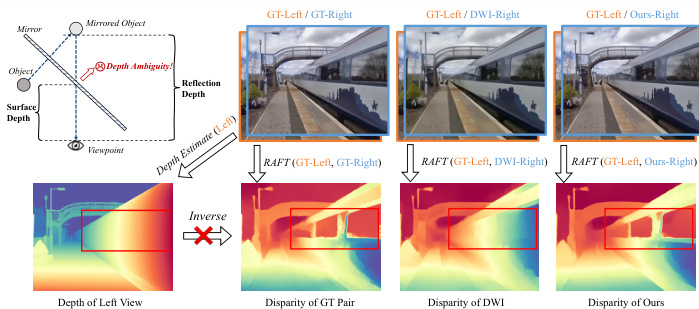

下图显示平行与汇聚式立体配置的几何视差关系差异显著。平行设置中,视差d与深度Z成反比,遵循Z=f⋅B/d(f为焦距,B为基线)。汇聚设置中,光轴相交于会聚距离,引入梯形失真并打破简单反比关系。StereoPilot中的域切换器隐式学习适配这些不同几何结构,无需显式深度估计或扭曲操作,从而规避了多阶段流程中深度模糊导致的伪影(如镜面反射出现的虚拟图像),如深度模糊示意图所示。

数据预处理流程(如下图)将VR180和并排式(SBS)3D电影等多源输入统一为标准格式:对VR180内容,使用Stereo4D以90∘水平视场角和832×480投影分辨率进行校正;对SBS电影则分割片段、过滤非信息段、转换为左右单目视图并移除黑边。所有输出视频均通过ShareGPT4Video生成描述文本,提供训练与推理所需的文本条件信号c。

深度模糊示意图进一步揭示了先前方法的失效模式:依赖单像素单深度图的多阶段流程无法解析反射/透明材质场景(单像素对应多深度值),导致虚拟图像"固化"于镜面等伪影。相比之下,StereoPilot基于扩散的直接合成完全绕过深度估计,生成物理合理的立体视图而避免此类问题。

实验

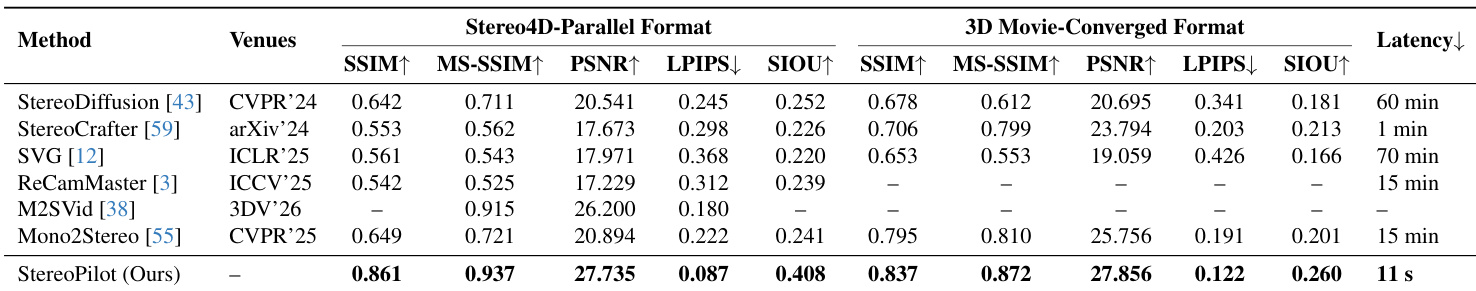

- StereoPilot在Stereo4D和3DMovies数据集上以11秒处理81帧视频的速度,在5项定量指标上全面超越StereoDiffusion、SVG和Mono2Stereo等最先进方法。

- 消融实验验证域切换器对泛化的关键作用,在未见的UE5合成数据上实现平行式立体转换的显著性能提升。

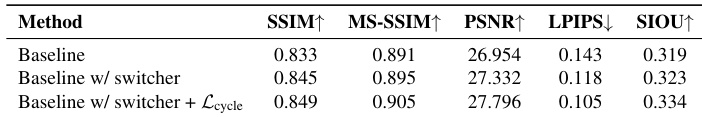

作者在Stereo4D和3DMovie测试集上使用5项定量指标评估StereoPilot变体。结果表明:添加域切换器较基线提升所有指标,进一步引入循环一致性损失后在SSIM、MS-SSIM、PSNR、LPIPS和SIOU上均达最优性能。

StereoPilot在Stereo4D和3DMovie数据集上以11秒完成81帧视频立体转换的速度,在5项定量指标上全面超越所有对比方法。结果在SSIM、MS-SSIM、PSNR、LPIPS和SIOU上均保持领先,且显著低于所有基线的延迟。该方法无需域特异性训练数据即展现强泛化能力。

作者通过比较带/不带域切换器的基线模型评估其影响(基于双数据集平均性能)。结果显示:添加切换器后SSIM、MS-SSIM、PSNR和SIOU提升,LPIPS下降,表明结构相似性、感知质量与语义一致性均改善。这证实了切换器对增强泛化与模型性能的作用。