Command Palette

Search for a command to run...

深度任意全景图:一种全景深度估计的基础模型

深度任意全景图:一种全景深度估计的基础模型

Xin Lin Meixi Song Dizhe Zhang Wenxuan Lu Haodong Li Bo Du Ming-Hsuan Yang Truong Nguyen Lu Qi

摘要

在本工作中,我们提出了一种全景度量深度基础模型,该模型能够跨多种场景距离实现良好泛化。我们从数据构建与框架设计两个角度,探索了一种“数据闭环”(data-in-the-loop)范式。通过整合公开数据集、基于UE5模拟器生成的高质量合成数据以及文本到图像模型生成的内容,结合网络获取的真实全景图像,我们构建了一个大规模数据集。为缩小室内/室外以及合成数据与真实数据之间的域差距,我们设计了一套三阶段伪标签筛选流程,用于为未标注图像生成可靠的真值标签。在模型设计方面,我们采用DINOv3-Large作为主干网络,利用其强大的预训练泛化能力;同时引入即插即用的距离掩码头(range mask head)、以清晰度为中心的优化策略以及以几何一致性为核心的优化机制,显著提升了模型在不同距离下的鲁棒性,并强化了多视角之间的几何一致性。在多个基准测试(如Stanford2D3D、Matterport3D和Deep360)上的实验结果表明,该模型展现出优异的性能与零样本泛化能力,在各类真实场景中均能实现稳健且可靠的度量深度预测。项目主页详见:https://insta360-research-team.github.io/DAP_website/

一句话总结

Insta360 Research、加州大学圣地亚哥分校与武汉大学提出DAP——一种采用数据闭环范式的全景度量深度基础模型,通过融合合成数据与真实数据并结合三阶段伪标签流程。该模型基于DINOv3-Large架构,集成距离掩码头与几何优化策略,可在多样化真实场景中实现鲁棒的零样本深度估计,在距离鲁棒性与跨视角一致性方面超越Stanford2D3D等基准方法。

核心贡献

- 本研究解决了全景深度估计在多样化真实场景(尤其是户外环境)中泛化能力差的问题,该问题源于训练数据规模有限且多样性不足,导致机器人导航等应用无法获得鲁棒的度量深度预测。

- 提出三阶段伪标签筛选流程,通过逐步优化未标注图像的真实深度,弥合室内外与合成-真实域之间的差距;同时设计基础模型,集成即插即用的距离掩码头及以几何/清晰度为核心的优化策略,确保不同距离下的度量一致性。

- 在Stanford2D3D、Matterport3D和Deep360基准测试中,该模型展现出强大的零样本泛化能力与复杂真实场景下的鲁棒度量深度预测,以感知连贯且尺度一致的输出实现最先进性能。

引言

全景深度估计通过捕获360°×180°环境覆盖,为机器人提供关键空间智能(如全向障碍物规避)。然而,现有方法(包括全景专用相对深度模型与统一度量深度框架)因数据采集与标注成本高昂导致训练数据规模与多样性受限,难以在多样化真实场景(尤其是户外)中泛化。作者提出数据闭环范式,构建跨越合成/真实域及室内外场景的200万+样本数据集,包含精选室内数据、高保真户外仿真与网络来源全景图。同时开发三阶段伪标签筛选流程弥合域间差异,并设计集成几何感知损失与即插即用深度范围掩码的基础模型,实现复杂真实场景中度量一致、尺度不变的深度估计。

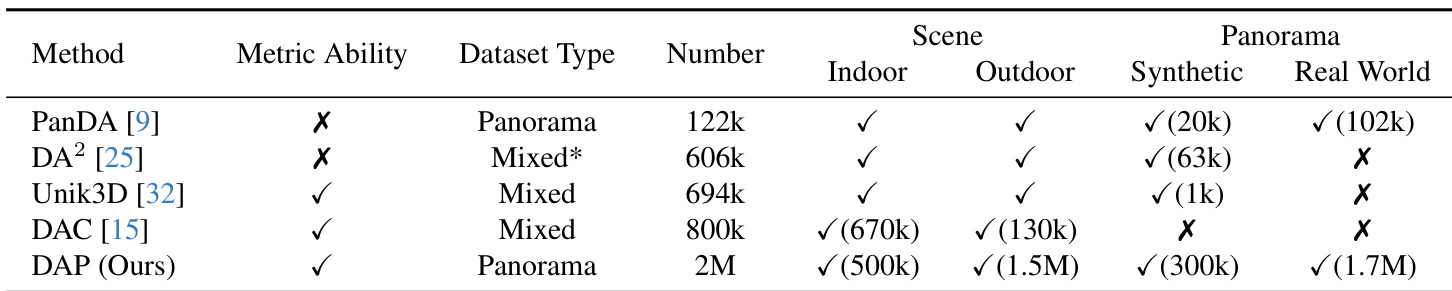

数据集

作者提出DAP数据引擎,构建覆盖合成/真实域及室内外场景的200万张全景图统一数据集,核心组件包括:

-

DAP-2M-Labeled(9万样本):

- 来源:基于Airsim360的无人机飞行高保真仿真

- 内容:5个户外场景(如纽约、罗马)的像素对齐深度图与全景图,覆盖26,600+序列

- 筛选:仅基于仿真参数过滤

-

DAP-2M-Unlabeled(170万样本):

- 来源:网络全景视频(25万视频→处理后170万帧)

- 筛选:地平线验证剔除无效样本;通过Qwen2-VL分类为25万室内/145万户外

- 增强:使用DiT-360生成20万额外室内样本以缓解稀缺性

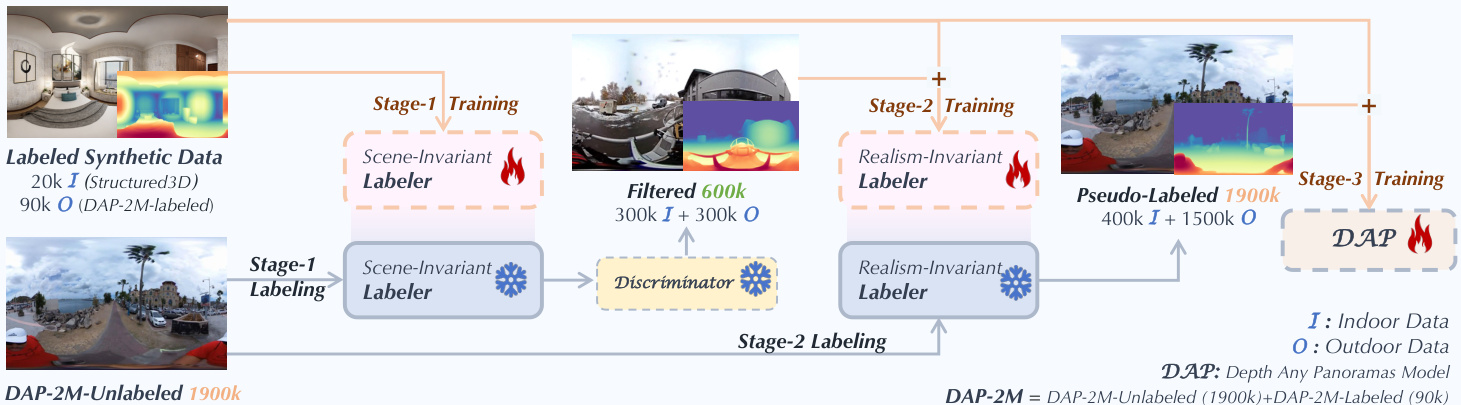

该数据通过三阶段半监督流程使用:

- 阶段1:在DAP-2M-Labeled上训练场景不变标注器进行初始化

- 阶段2:利用PatchGAN判别器从DAP-2M-Unlabeled筛选60万高置信度伪标注样本(室内外各30万),弥合合成-真实域差距

- 阶段3:在全部标注/伪标注数据(总计200万)上训练最终模型,实现跨域泛化

处理细节包括基于地平线的真实数据过滤、Qwen2-VL场景分类及DiT-360合成室内数据扩展。未提及裁剪策略,合成数据深度图保持像素对齐。

方法

作者通过三阶段伪标签筛选流程构建大规模高质量全景度量深度训练数据集,有效弥合合成-真实、室内外场景的域间差异。流程始于阶段1:在2万合成室内与9万合成户外图像(含精确度量深度标注)上训练场景不变标注器,学习跨场景几何与光照条件的深度线索,为伪标签生成奠定基础。如框架图所示,该标注器随后应用于190万未标注真实全景图生成初始深度预测。

阶段2中,预训练深度质量判别器区分合成真实深度图(真)与场景不变标注器输出(假),实现场景无关的质量评估。按判别器排序选取前30万室内/30万户外真实图像作为高置信度伪标注数据,结合合成数据集训练现实不变标注器,使其超越合成纹理与光照限制,增强对真实外观变化的鲁棒性。阶段3则在190万伪标注数据及历史标注数据上训练最终DAP模型,提供密集监督并实现强泛化能力。

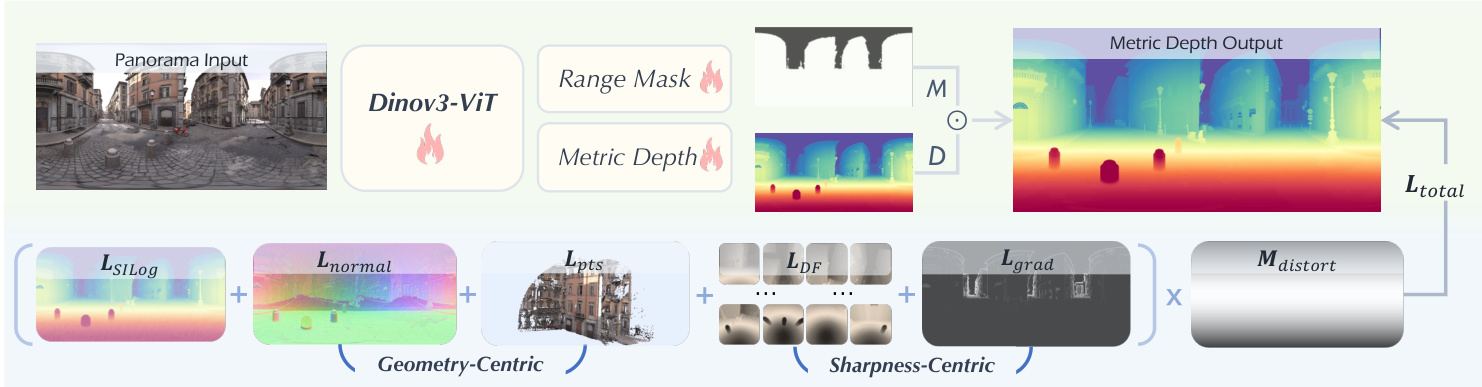

模型架构采用DINOv3-Large作为视觉骨干网络(因其强大的预训练泛化能力),设计双头结构:预测密集深度图D的度量深度头,以及输出二值掩码M的即插即用范围掩码头(M定义预设距离阈值下的有效空间区域:10m/20m/50m/100m)。最终度量深度输出为M⊙D,确保跨场景尺度的物理有效性与尺度一致性。范围掩码头通过加权BCE与Dice损失优化:

Lmask=∥M−Mgt∥2+0.5LDice(M,Mgt),其中M和Mgt分别表示预测与真实掩码。

训练由多目标损失函数引导,融合几何与清晰度优化。几何优化包含法向损失Lnormal,计算预测与真实表面法向量npred,ngt∈RH×W×3的L1距离:

Lnormal=∥npred(i,j)−ngt(i,j)∥1.同时应用点云损失Lpts,将深度图投影至球坐标系获得3D点云Ppred,Pgt∈RH×W×3:

Lpts=∥Ppred(i,j)−Pgt(i,j)∥1.清晰度优化引入密集保真度损失LDF,通过二十面体顶点的虚拟相机将等距柱面投影分解为12个透视块,对每块计算预测/真实深度图的Gram相似度:

LDF=N1k=1∑NDpred(k)⊙Dpred(k)T−Dgt(k)⊙Dgt(k)TF2,其中N=12。为直接在ERP域保留边缘保真度,对Sobel算子掩码的边缘区域应用梯度损失Lgrad:

Lgrad=LSILog(ME⊙Dpred,ME⊙Dgt).总训练目标为加权损失和,通过扭曲图Mdistort调节以应对等距柱面投影的非均匀像素分布:

Ltotal=Mdistort⊙(λ1LSILog+λ2LDF+λ3Lgrad+λ4Lnormal+λ5Lpts+λ6Lmask),(ℓ=1,2,3,4,5,6).如架构图所示,该多维度优化策略确保全景视图的度量精度、边缘保真度与几何一致性。

作者进一步集成扭曲感知深度解码器,抑制极点区域的拉伸伪影,提升高扭曲区域的深度预测保真度。该综合设计使DAP能自适应多样化空间尺度与场景类型,在真实全景环境中提供稳定精确的度量深度估计。

实验

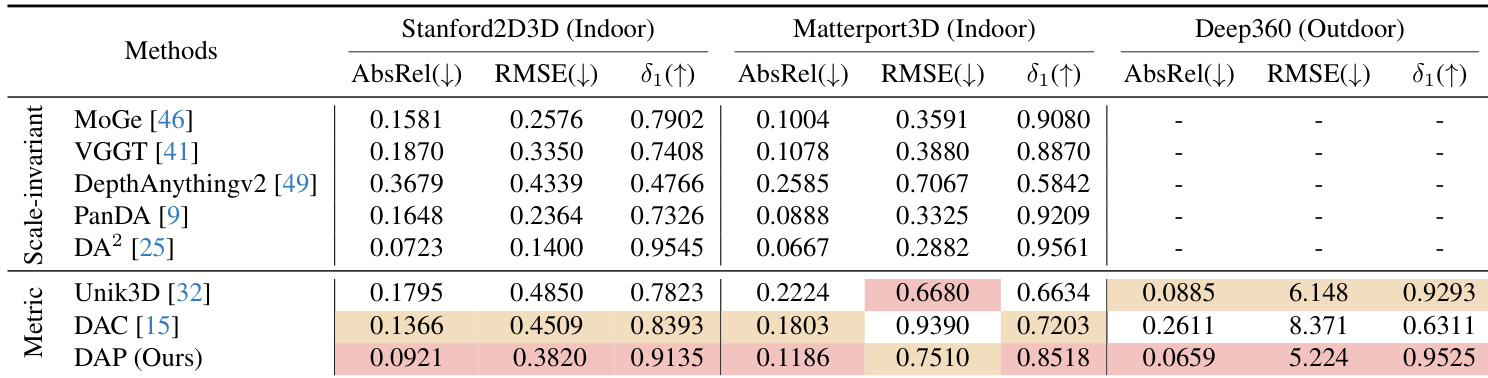

- DAP模型在Stanford2D3D、Matterport3D和Deep360基准测试中实现最先进的零样本度量深度估计(无需微调),显著降低AbsRel并提升δ₁,超越DAC和Unik3D等先前方法。

- 在DAP-Test基准上,DAP将AbsRel从0.2517降至0.0781,RMSE从10.563降至6.804,同时δ₁从0.6086提升至0.9307。

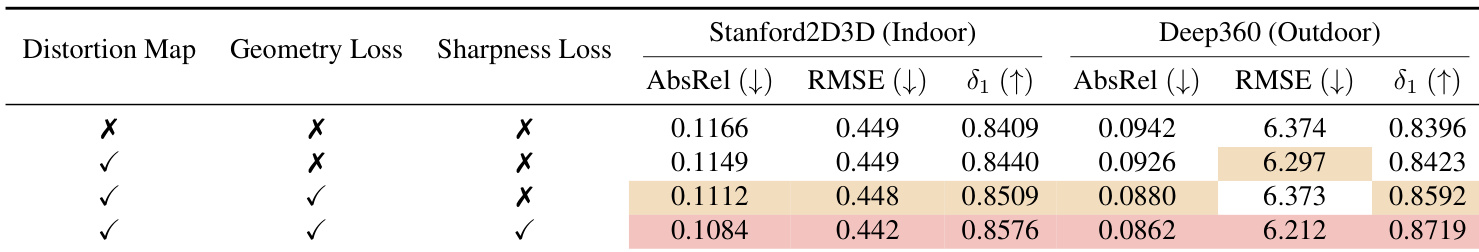

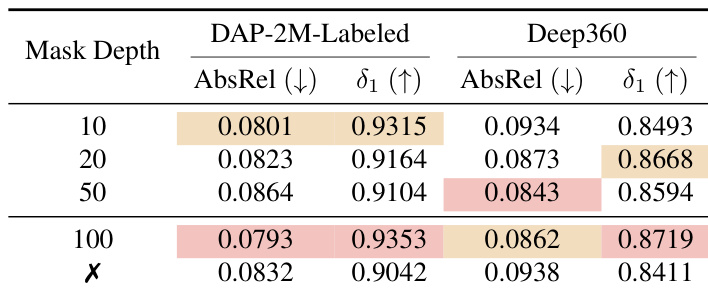

- 消融实验验证核心组件:添加清晰度损失(ℒ_DF, ℒ_grad)效果最佳(Stanford2D3D/Deep360的AbsRel达0.1084/0.0862),100m阈值的范围掩码头优化性能(DAP-2M-Labeled上AbsRel 0.0793, δ₁ 0.9353)。

- DAP在室内外场景中均展现鲁棒度量一致性,在先前方法失效的远距离天空与复杂布局等挑战区域保持精确深度结构。

作者评估不同深度掩码阈值对性能的影响,发现100m阈值在DAP-2M-Labeled和Deep360上均取得最低AbsRel与最高δ1的最佳平衡。移除掩码头将导致性能下降,证实其稳定训练与过滤不可靠远距离预测的作用。结果表明:较小阈值(10m/20m)利于近距精度,而100m设置最能保持跨场景尺度的度量一致性。

作者在三大基准上对比尺度不变与度量深度方法,显示DAP在所有数据集上均取得最低AbsRel/RMSE与最高δ1。结果表明DAP在Deep360户外场景中显著优于Unik3D/DAC等度量方法(AbsRel降至0.0659,δ1达0.9525),体现其无需后对齐即可提供度量一致深度的能力,实现室内外全景环境的鲁棒泛化。

作者在DAP-Test基准上验证DAP性能,显示其在所有指标上超越DAC与Unik3D,AbsRel降至0.0781,RMSE降至6.804,δ₁提升至0.9370。该结果证明大规模数据扩展与统一训练框架对度量一致全景深度估计的有效性。

作者通过DAP实现全景输入的直接度量深度估计(无需后对齐),在室内外基准测试中全面超越先前方法。结果表明:基于200万全景样本的训练赋予模型强泛化能力,在Stanford2D3D、Matterport3D和Deep360上均取得AbsRel、RMSE与δ1指标的优越表现。其扭曲处理与范围感知掩码设计,支持多样化真实场景中鲁棒且度量一致的预测。

作者通过消融实验评估扭曲图、几何损失与清晰度损失的影响。结果显示:三者结合时性能最优,在Stanford2D3D和Deep360上均取得最低AbsRel与最高δ₁。其中清晰度损失对提升度量精度与结构保真度贡献最为显著。