Command Palette

Search for a command to run...

代理型AI的适应性调整

代理型AI的适应性调整

摘要

前沿的智能体式人工智能系统建立在基础模型之上,这些模型能够被适配以实现规划、推理,并与外部工具交互,从而完成日益复杂且专业化的任务。随着这些系统能力与应用范围的不断扩展,适应性逐渐成为提升性能、可靠性与泛化能力的核心机制。本文将快速发展的研究领域整合为一个系统性框架,涵盖智能体适应与工具适应两个方面。我们进一步将智能体适应细分为“工具执行信号触发”与“智能体输出信号触发”两种形式,将工具适应划分为“与智能体无关”与“由智能体监督”两种形式。我们证明,该框架有助于厘清智能体式人工智能中适应策略的设计空间,明确各类策略之间的权衡关系,并为系统设计过程中策略的选择或切换提供切实可行的指导。随后,我们对各类代表性方法进行了综述,分析其优势与局限性,并指出关键的开放性挑战与未来机遇。总体而言,本文旨在为致力于构建更强大、高效且可靠的智能体式人工智能系统的研究人员与实践者,提供一个概念基础与实用路线图。

一句话总结

伊利诺伊大学厄本那-香槟分校、斯坦福大学、普林斯顿大学、加州大学伯克利分校、加州理工学院、华盛顿大学、加州大学圣地亚哥分校、佐治亚理工学院、西北大学、德州农工大学、麻省总医院、Keiji AI 和 Unity 的研究者提出了一种统一框架,将智能体 AI 中的适应性划分为四种范式:基于工具执行信号或智能体输出信号的智能体适应(A1/A2),以及基于无智能体依赖或智能体监督信号的工具适应(T1/T2)。该框架明确了设计空间,揭示了成本、灵活性、泛化能力和模块化之间的权衡,并为策略选择提供了实用指导。研究表明,T2 类型的智能体监督工具适应能够实现数据高效、模块化且可泛化的系统演进,尤其通过与冻结的基础模型共同进化的轻量级子智能体,为深度研究、软件开发和药物发现等领域的强大、可靠且高效的智能体系统提供了可扩展路径。

主要贡献

- 智能体 AI 系统在可靠性、长程规划和泛化能力方面面临挑战,需要通过修改智能体或其外部工具的适应性策略来提升性能与鲁棒性。

- 本文提出一个统一的四部分框架,将适应性划分为两个维度:智能体适应(A1:工具执行信号驱动,A2:智能体输出信号驱动)和工具适应(T1:无智能体依赖,T2:智能体监督),清晰阐明了设计权衡,指导实际系统设计。

- 该框架通过跨领域的代表性方法分析得到支持,表明将 T1 检索器与 A1 微调、T2 自适应搜索智能体相结合,可构建更强大且高效的智能体系统。

引言

基于大语言模型等基础模型构建的智能体 AI 系统,旨在自主规划、推理并交互外部工具,以应对科学探索、软件开发和药物发现等复杂现实任务。然而,这些系统常面临工具使用不可靠、长程规划能力差以及泛化能力有限的问题,尤其在未探索或动态环境中表现更差。以往工作通过适应性——即修改智能体或其工具——来解决这些问题,但现有方法缺乏统一框架,难以厘清其设计空间、权衡关系与相互作用。

本文提出一种系统性分类法,将适应性划分为四种范式:A1(利用工具执行信号进行智能体适应)、A2(利用智能体输出信号进行智能体适应)、T1(无智能体依赖的工具适应)和 T2(智能体监督的工具适应)。该框架明确映射了成本、灵活性、泛化能力和模块化之间的权衡,表明智能体适应虽具高灵活性,但计算成本高且存在灾难性遗忘风险;而工具适应则能实现高效、模块化的升级,无需重训练核心智能体。作者进一步展示了这些范式的实际应用,如使用 T2 类搜索子智能体提升 RAG 系统的检索能力,或采用 A1 类闭环执行实现代码生成,并强调了它们的互补性。

主要贡献在于提供了一个统一的概念与实践路线图,不仅组织了快速演进的领域,还指出了关键未来方向:智能体与工具的协同适应、动态环境中的持续适应、防止奖励劫持与不安全探索的安全适应,以及通过参数高效和设备端方法实现的高效适应。该框架使研究人员和实践者能够战略性地组合适应策略,构建更强大、可靠且可扩展的智能体系统。

方法

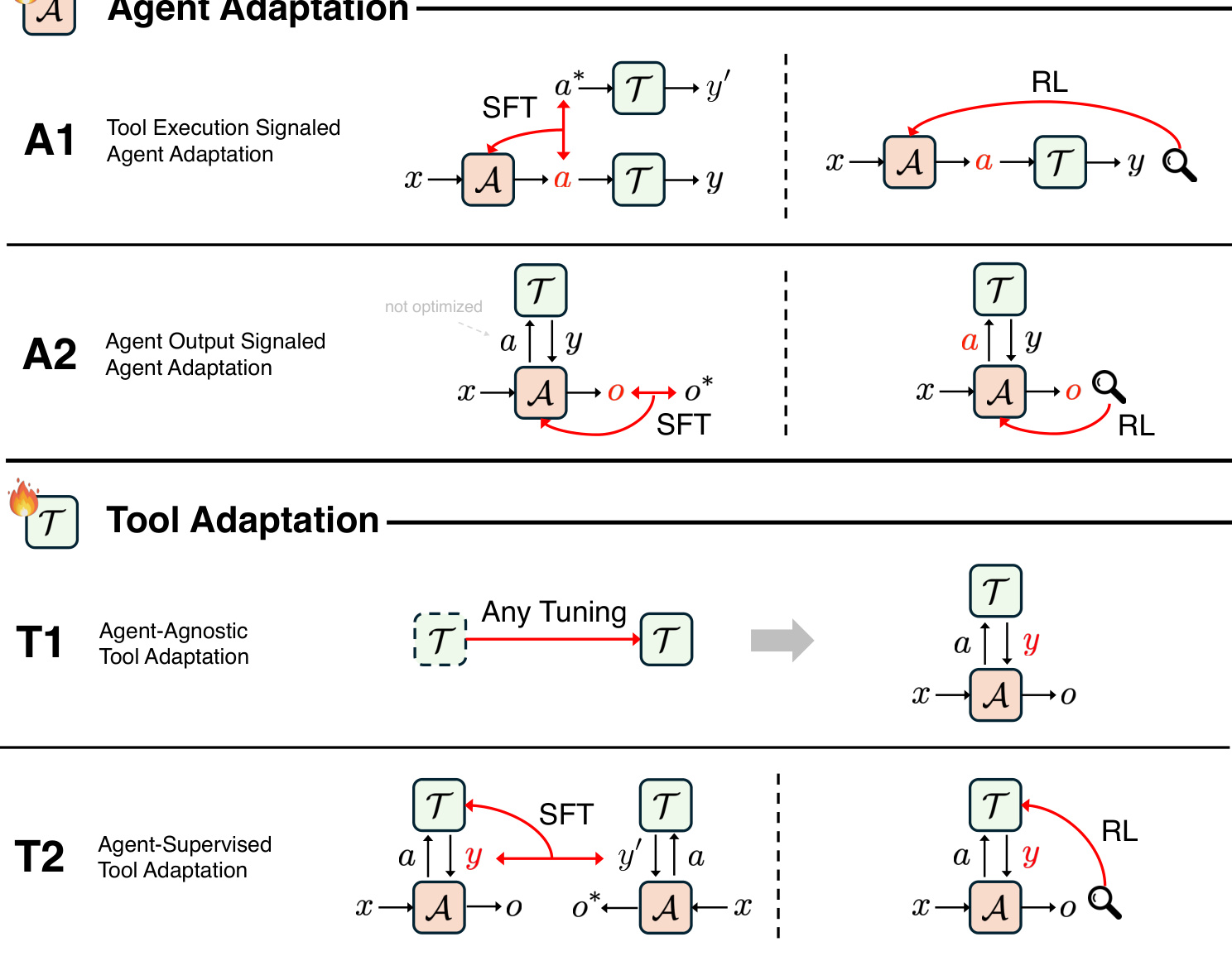

本文提出一个全面的智能体 AI 系统适应框架,根据优化目标和适应信号来源,将适应方法划分为四个主要范式。该框架如概念图所示,将适应过程分为两个主要维度:以智能体为中心的适应(A1、A2)和以工具为中心的适应(T1、T2)。框架的核心在于区分对智能体内部策略的优化与对外部交互工具的优化。

以智能体为中心的范式 A1 和 A2 均涉及修改智能体参数以提升性能。A1 范式,即“工具执行信号驱动的智能体适应”,聚焦于通过工具执行的直接反馈来优化智能体正确使用工具的能力。适应信号是工具动作的可验证结果,如代码执行的成功与否或检索文档的质量。该方法被形式化为一个优化问题,即调整智能体策略以最大化基于工具输出的奖励函数。A1 范式可通过在成功工具调用轨迹上进行监督微调(SFT)实现,也可通过强化学习(RL)实现,其中智能体从工具执行结果中获得标量奖励。相比之下,A2 范式,即“智能体输出信号驱动的智能体适应”,则通过智能体最终输出的质量作为适应信号,优化智能体使用工具的整体策略。目标是使智能体的最终答案与正确性或质量标准对齐,这可能依赖于工具输出的整合。该范式同样支持 SFT 和 RL,但奖励来源于最终输出而非中间工具执行。A2 范式在学习复杂多步推理策略方面尤为有效,例如何时搜索、搜索什么以及如何整合结果,因为它优化的是智能体的整体推理策略。

以工具为中心的范式 T1 和 T2 将适应焦点从智能体转向外部工具。T1 范式,即“无智能体依赖的工具适应”,指在不依赖特定智能体的情况下独立训练或优化工具。目标是提升工具的独立性能,如检索准确率或代码生成质量,使用离线数据或环境反馈。该方法将工具视为即插即用组件,可被任何智能体使用。T2 范式,即“智能体监督的工具适应”,代表了一种概念上的反转。与其适应智能体以更好地使用工具,T2 则适应工具以更好地服务于一个固定、冻结的智能体。适应信号来源于智能体自身的输出,如最终答案质量或任务成功率。这使得工具能够专门针对特定智能体的需求进行优化,从而实现更高效、更有效的性能。T2 范式支持构建共生生态系统:强大的冻结智能体提供高质量监督信号,而轻量级、可适应的工具则学习如何翻译、过滤和呈现信息,以最有效的方式服务智能体。该方法特别数据高效,因为智能体已具备必要的领域知识和推理能力,工具只需学习有效的交互程序技能。

实验

- A1:以工具执行结果作为反馈,可利用实际工具输出(如正确性、改进程度)作为可验证信号,实现监督学习与强化学习,从而优化智能体行为。

- T2:通过轻量级子智能体(如 s3)实现工具适应,其性能可与 A2 方法(如 Search-R1)相当,但所需数据量显著减少——仅需 2.4k 样本 vs. 170k,表明数据需求降低 70 倍,训练速度提升 33 倍。

- 在检索增强生成任务中,s3(T2)平均准确率达 58.9%,医学问答任务达 76.6%,优于 Search-R1(A2)的 71.8%,表明其具备更强的泛化能力与可迁移性。

- T2 方法展现出更优的模块化特性:新工具可独立训练并替换,无需重训核心智能体,避免灾难性遗忘;而 A2 方法在任何变更时均需完整重训智能体。

- T2 方法通过聚焦子智能体的狭窄程序技能,简化了学习过程,利用冻结的主干模型进行推理与知识处理,推动系统更高效、可扩展的演进。

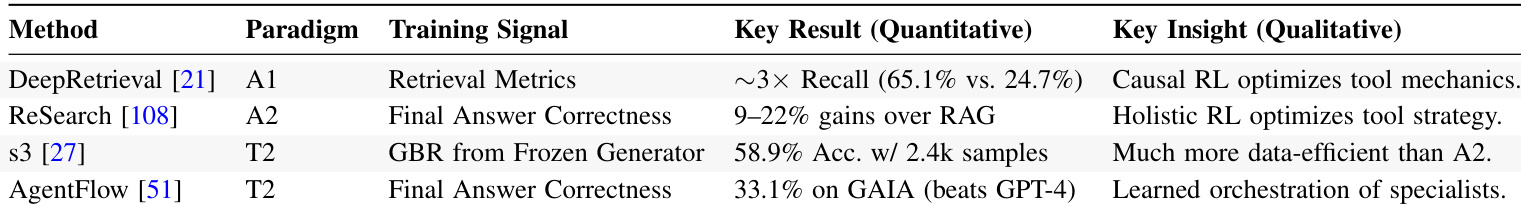

作者使用表格对比不同智能体系统中的适应范式,重点关注 DeepRetrieval、ReSearch、s3 和 AgentFlow 等方法。结果表明,T2 方法如 s3 在显著更少的训练数据(仅 2.4k 样本)下即可达到与 A2 方法如 ReSearch 相当的性能,且在专业领域展现出更优的泛化能力。

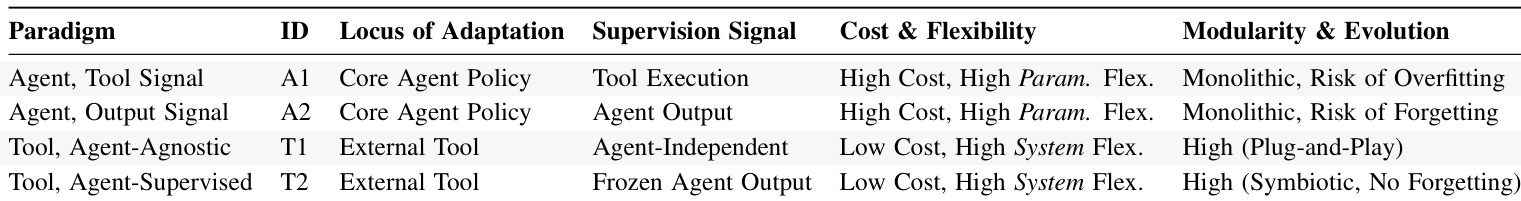

作者使用框架对比四种适应范式在成本、灵活性、数据效率和模块化方面的表现,表 4 总结了其定性差异。结果表明,以工具为中心的方法(T1 和 T2)相比以智能体为中心的方法(A1 和 A2)具有更低的成本、更高的系统级灵活性和更强的模块化能力,而后者虽更昂贵且结构封闭,但提供更高的参数灵活性。

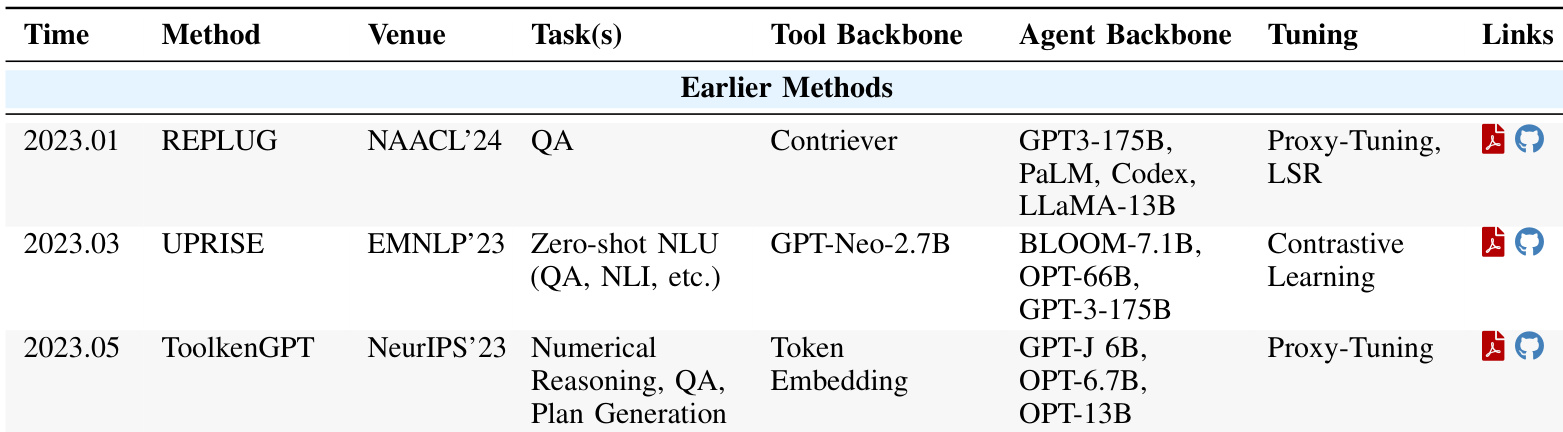

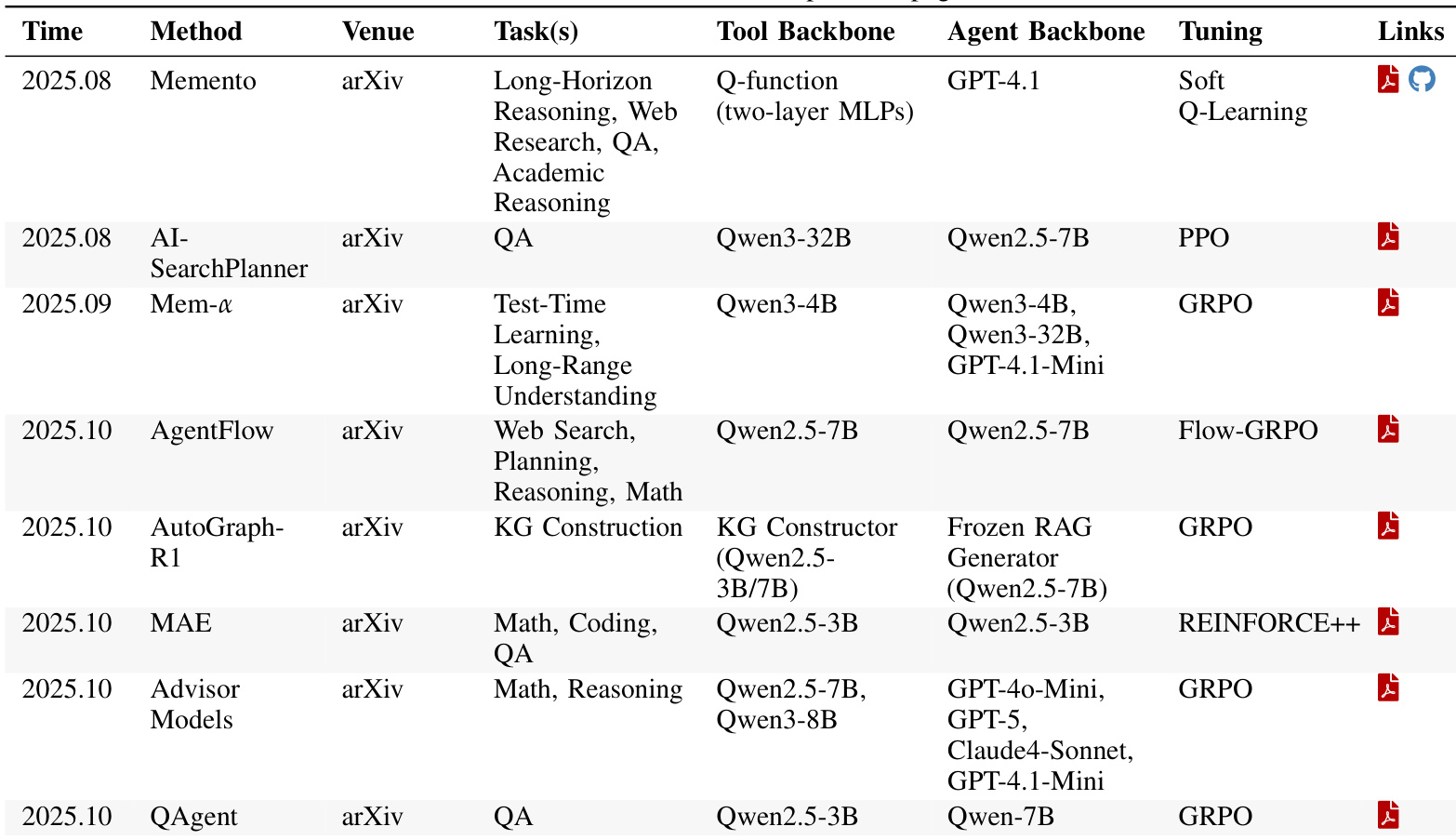

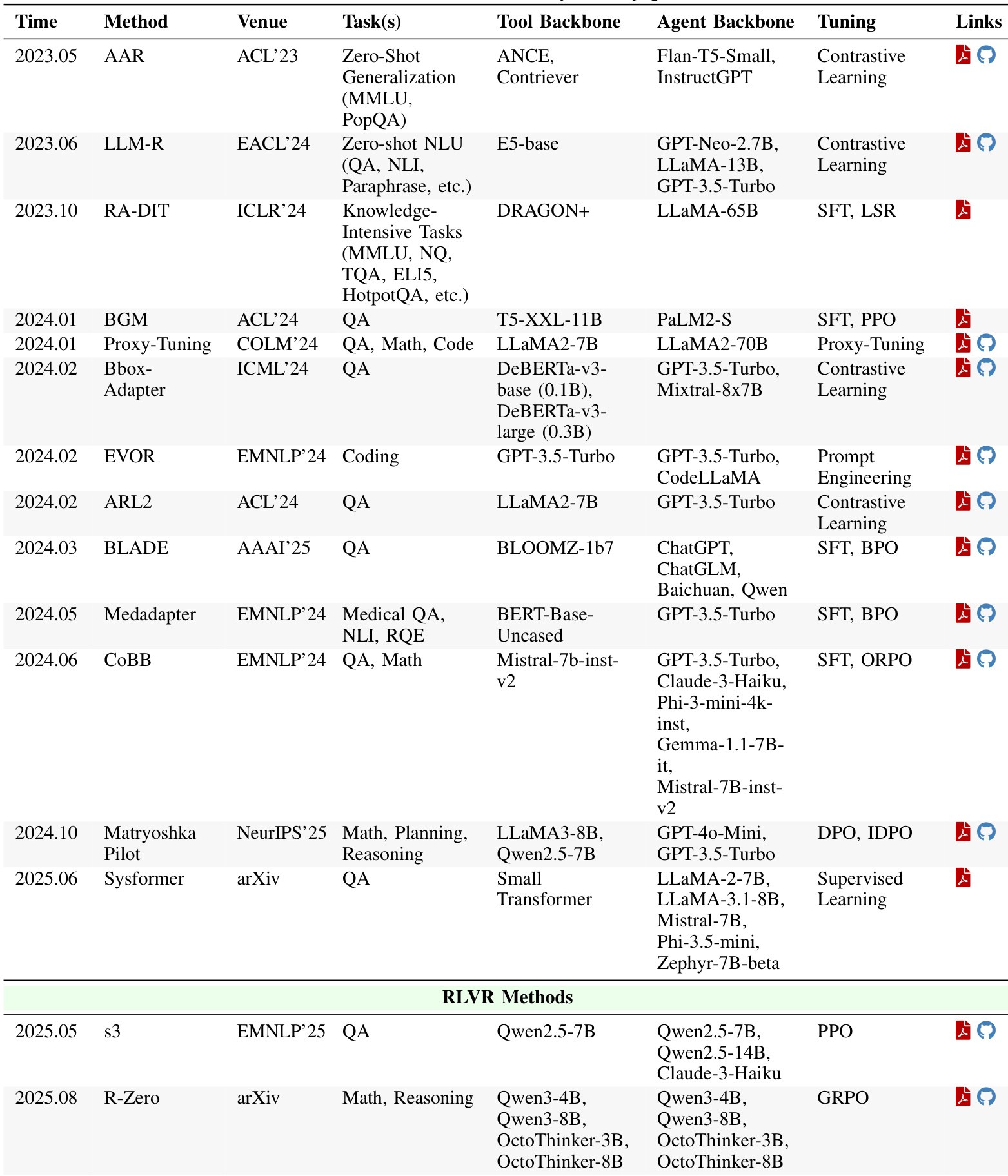

作者使用表格对比各类工具增强型智能体系统的不同方法,重点关注其主干模型、任务类型和训练方式。结果表明,T2 方法如 s3 在显著更少的数据和更快的训练速度下,性能可与 A2 方法如 Search-R1 相当,凸显其在数据效率和模块化方面的显著优势。

作者使用表格对比各类工具适应方法,重点关注其性能、主干模型和训练方式。结果表明,T2 方法如 s3 在显著更少的数据和更快的训练速度下,性能可与或优于 A2 方法如 Search-R1,凸显其在数据效率和模块化方面的显著提升。

作者使用表格对比早期工具执行信号方法,突出其发展时间线、任务类型、工具与智能体主干模型、调优技术及可用性。结果表明,这些方法在主干模型上差异显著,部分依赖 GPT-3-175B 等大语言模型,部分使用 GPT-Neo-2.7B 等小型模型,并采用代理调优、对比学习等不同调优策略。