Command Palette

Search for a command to run...

Mimic-Video:面向可泛化机器人控制的视频-动作模型,超越VLAs

Mimic-Video:面向可泛化机器人控制的视频-动作模型,超越VLAs

Jonas Pai Liam Achenbach Victoriano Montesinos Benedek Forrai Oier Mees Elvis Nava

摘要

当前主流的视觉-语言-动作模型(Vision-Language-Action Models, VLAs)用于机器人操作任务,其基础是基于大规模但彼此孤立的静态网络数据预训练的视觉-语言主干网络。因此,尽管这类模型在语义泛化能力上有所提升,其策略仍需仅通过机器人轨迹隐式推断复杂的物理动态与时间依赖关系。这种依赖带来了不可持续的数据负担,迫使研究者持续投入大量人力与资源进行大规模专家数据采集,以弥补模型缺乏内在物理理解的缺陷。我们认为,尽管视觉-语言预训练能够有效捕捉语义先验知识,却仍然无法感知物理因果关系。相比之下,一种更有效的范式应利用视频数据,在预训练阶段联合建模语义信息与视觉动态,从而将低层控制任务从整体系统中解耦出来。为此,我们提出 mimick-video,一种新型的视频-动作模型(Video-Action Model, VAM),该模型将一个在互联网规模视频数据上预训练的视频主干网络与一个基于流匹配(flow matching)的、以视频潜在表征为条件的动作解码器相结合。该解码器充当逆动力学模型(Inverse Dynamics Model, IDM),能够从视频空间中动作规划的潜在表示中生成底层机器人动作。大量实验评估表明,我们的方法在模拟与真实世界机器人操作任务中均达到了当前最优性能,相较传统VLA架构,样本效率提升10倍,收敛速度提高2倍。

一句话总结

来自Mimic Robotics、微软苏黎世研究院、苏黎世联邦理工学院、苏黎世人工智能中心以及加州大学伯克利分校的作者们提出了mimic-video,一种新型的视频-动作模型(Video-Action Model),该模型将机器人策略建立在预训练视频扩散主干网络之上,通过基于流匹配的逆动力学解码器,利用部分去噪的视频潜在表示,直接恢复低级机器人动作,从而绕过完整视频生成的需要,并利用互联网规模视频预训练所蕴含的物理先验知识,实现了在灵巧操作任务中10倍更高的样本效率和2倍更快的收敛速度,性能优于视觉-语言-动作(Vision-Language-Action)模型。

主要贡献

- 现有的视觉-语言-动作(VLA)模型依赖静态图像-文本预训练,缺乏内在的物理动态理解,迫使策略从稀缺的机器人演示中学习复杂的时序与因果关系,导致样本效率低下且数据需求量大。

- 本文提出mimic-video,一种新型的视频-动作模型(VAM),利用预训练视频扩散主干网络生成潜在视觉规划,采用基于流匹配的动作解码器作为逆动力学模型,直接从这些表示中恢复低级机器人动作,从而实现高层规划与控制的解耦。

- 在模拟和真实世界操作任务中进行评估,mimic-video实现了最先进的性能,相比传统VLA架构,样本效率提高10倍,收敛速度加快2倍,证明了将策略建立在基于视频的动态先验上的优势。

引言

作者利用预训练视频模型来解决当前视觉-语言-动作(VLA)模型在机器人领域中的一个关键局限:由于依赖静态图像-文本预训练,缺乏内在的物理动态理解。尽管VLA在语义泛化方面表现出色,但必须从稀缺的机器人演示中学习复杂的时序与物理交互,导致样本效率差且数据需求高。为克服这一问题,作者提出mimic-video,一种新型的视频-动作模型(VAM),将机器人策略建立在冻结的、互联网规模的视频扩散模型的潜在表示之上。该模型在潜在空间中生成视觉动作规划,并使用基于流匹配的动作解码器——作为逆动力学模型——直接将这些表示映射到低级机器人动作。这一设计实现了高层规划与控制的解耦,使动作解码器能够专注于更简单的、非因果的逆动力学任务。该方法在灵巧操作任务上达到最先进性能,同时相比传统VLA模型,样本效率提升10倍,收敛速度提升2倍,证明了丰富的视频先验能够显著减少对专家机器人数据的需求。

数据集

- 数据集结合了三个来源:BridgeDataV2、LIBERO 和 mimic,各自提供多样化的机器人操作数据。

- BridgeDataV2 包含 3,046 个非信息性语言标签,并移除了每个任务的初始状态和空动作,形成一个聚焦于有意义任务演示的清理子集。

- LIBERO 数据按照 Kim 等人 [27] 的方法进行预处理,排除在重放动作时失败的任务,确保仅保留成功轨迹。

- mimic 包含末端执行器位姿、手部关节状态、相对末端执行器位置以及先前动作的观测,动作定义为相对末端执行器运动和绝对手部关节指令。

- 所有图像以 480 x 640 像素渲染,方向以旋转矩阵前两行导出的 6D 向量表示。

- 作者在训练中使用这些数据集的混合,以特定比例组合,以平衡任务多样性和性能表现。

- 训练过程中,数据被处理以对齐观测与动作空间,所有子集均一致使用相对动作表示,以提升泛化能力。

方法

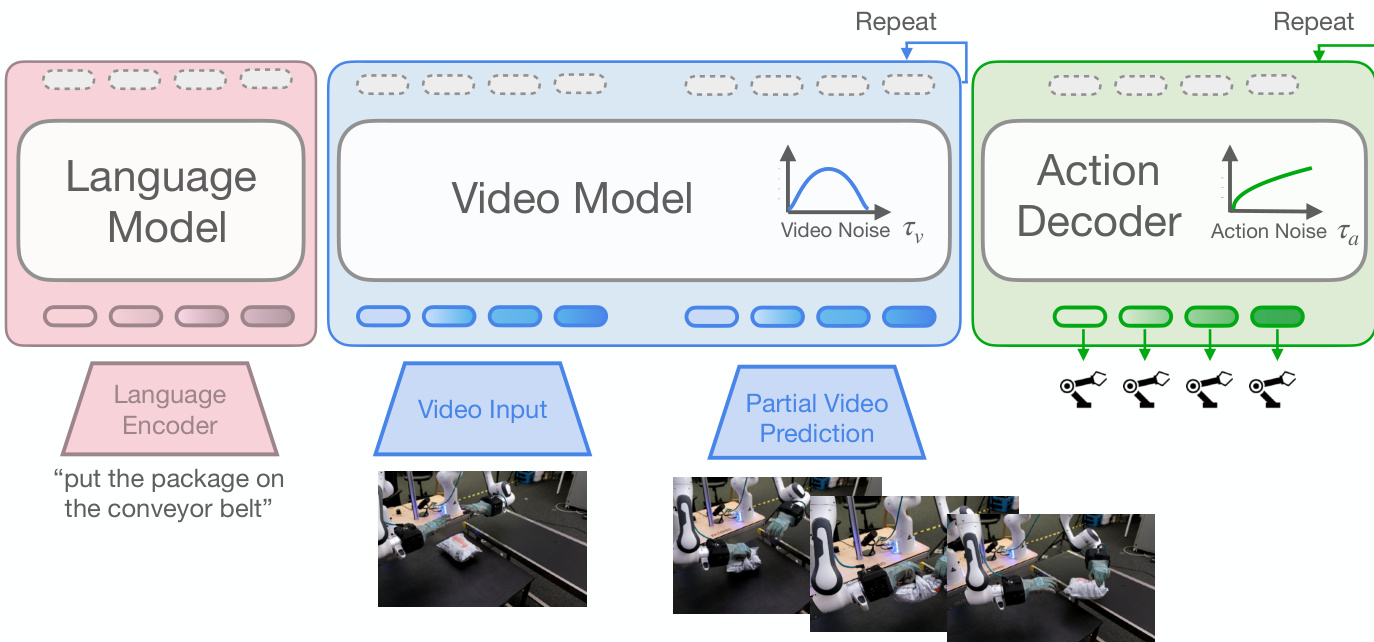

作者采用两阶段架构构建其视频-动作模型(VAM),将预训练视频生成主干与轻量级动作解码器相结合。该框架基于条件流匹配(Conditional Flow Matching, CFM)原则,使模型能够学习视频与机器人动作的联合分布。整体架构旨在高效地将机器人策略锚定在预训练视频模型之上,从而利用大规模视频数据中学习到的丰富物理动态先验。

模型的核心由两个独立组件构成:视频模型与动作解码器。视频模型采用一个预训练的 20 亿参数潜在扩散 Transformer(DiT),命名为 Cosmos-Predict2,其在由 3D 分词器编码的视频帧序列上运行。该模型处理由上下文前缀(通常为五帧)的干净潜在块嵌入与代表未来帧的噪声潜在块拼接而成的序列。模型中的每个 Transformer 层交替执行对完整视频序列的自注意力、对由 T5 模型编码的语言指令的交叉注意力,以及一个两层 MLP。该架构使视频模型能够基于当前观测和语言指令生成合理的未来视频帧。

动作解码器是一个更小的 DiT,用于预测机器人动作序列。它通过独立的 MLP 网络编码机器人的本体感觉状态和未来动作序列,随后将两者拼接。解码器引入了学习到的绝对位置编码以捕捉时间信息。训练过程中,使用一个学习到的掩码令牌替换本体感觉状态编码,以防止过拟合。解码器的各层包含对视频模型中间表示的交叉注意力、对动作序列的自注意力,以及一个两层 MLP。每个组件均通过残差路径连接,输出通过 AdaLN 调制,调制参数由视频和动作流时间 τv 与 τa 的低秩双线性仿射编码生成。

两个组件通过部分去噪策略耦合。视频模型从 τ=1 的高斯噪声状态逐步去噪至中间流时间 τv,以提取潜在视觉规划。这些表示记为 htauv,随后用于条件化动作解码器。视频与动作组件分别在独立的流时间调度 τv 与 τa 上运行,允许对每种模态的学习问题进行独立设计与训练。这种解耦是模型高效性的核心,使动作解码器能够独立于计算密集型视频生成过程进行训练与执行。

训练过程分为两个阶段。第一阶段通过低秩适配器(LoRA)对视频主干进行微调,使用机器人视频数据集。此步骤将通用主干与机器人任务的特定视觉领域和动态对齐,同时保留其预训练的时序推理能力。第二阶段专注于从零开始训练动作解码器,此时视频主干被冻结。在此阶段,解码器学习在视频表示 htauv 条件下回归动作流场。为确保在推理过程中对不同噪声水平的鲁棒性,训练中为每次迭代独立采样流时间 τv 与 τa,视频流时间采用逻辑正态分布,动作流时间采用 taua−0.001 分布。这种解耦训练方案显著提升了样本效率与收敛速度,相比标准 VLA 基线表现优异。

实验

- 在 SIMPLER-Bridge、LIBERO 以及真实世界双臂操作任务上评估,mimic-video 展现出强大的跨体态泛化能力与高样本效率。

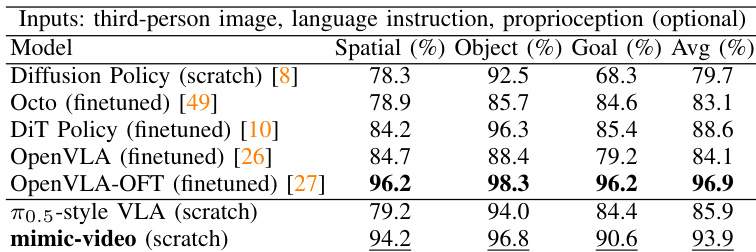

- 在 SIMPLER-Bridge 上,mimic-video 达到最高平均成功率,优于包括 π0.5 风格 VLA 在内的最先进基线,验证了视频主干条件化的优越性。

- 在 LIBERO 上,mimic-video 超越多个在更大数据集上训练的最先进方法,尽管仅在极少量任务特定数据上从零训练,仍取得更高成功率。

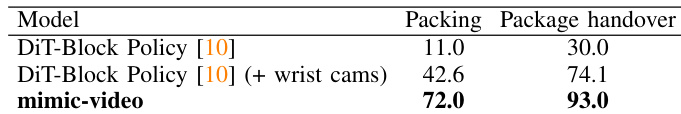

- 在真实世界双臂灵巧操作任务中,mimic-video 显著优于单任务 DiT-Block 策略,即使仅依赖单个工作区摄像头输入,也展现出对遮挡和数据稀缺的鲁棒性。

- mimic-video 的样本效率提升 10 倍:其在仅需 π0.5 风格 VLA 基线 10% 动作数据的情况下达到峰值性能,并在每任务仅一个演示时仍保持 77% 的成功率。

- 动作解码器的收敛速度更快,且达到更高的渐近成功率,即使 VLA 基线受益于任务特定预训练。

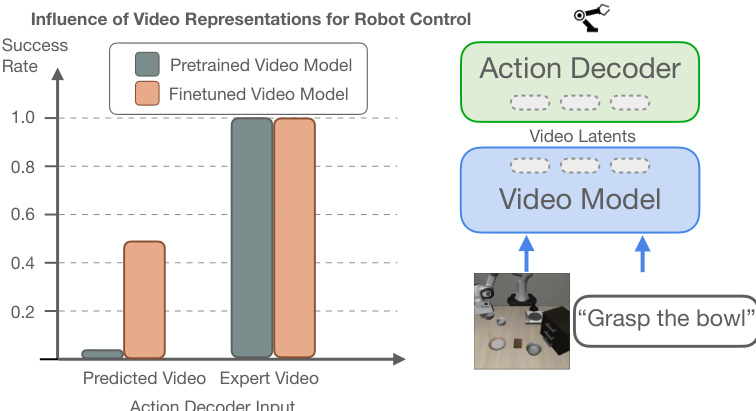

- 反直觉的是,最优策略性能出现在 τv=1(最大噪声)而非完全去噪,这是由于视频模型中存在分布不匹配以及中间表示更丰富。

- 对噪声视频潜在表示的条件化起到了有效的数据增强作用,提升了鲁棒性;而完全去噪则导致更高的动作重建误差和性能下降。

- 中间视频模型层(如第 19 层)与 5 帧观测时序可获得最佳策略性能。

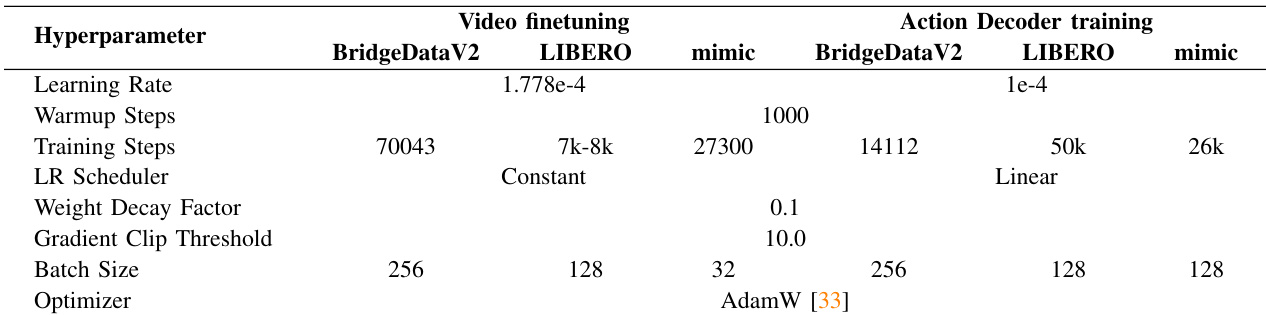

作者使用提供的表格详细说明了 mimic-video 在不同数据集与组件上的训练超参数,表明模型在视频微调与动作解码器训练中采用不同的设置。结果表明,超参数针对每项任务进行了精细调优,学习率、批量大小与训练步数的差异反映了 BridgeDataV2、LIBERO 与 mimic 系统的具体需求。

作者在真实世界双臂操作任务上评估 mimic-video,与 DiT-Block 策略基线进行比较。结果表明,尽管仅依赖单个工作区摄像头视角,mimic-video 的成功率显著高于两种 DiT-Block 策略变体,证明其在接触密集环境中处理视觉不确定性与遮挡的能力。

结果表明,mimic-video 在 SIMPLER-Bridge 基准测试中所有任务上的平均成功率最高,优于包括 Octo、DiT Policy 和 OpenVLA-OFT 在内的最先进基线,即使从零开始训练。该模型的优异表现表明,基于生成式视频主干的条件化能够实现比视觉-语言预训练模型更稳健的策略学习,尤其在跨任务泛化场景中。

结果表明,mimic-video 在从零开始训练时,于 SIMPLER-Bridge 基准测试中达到 46.9% 的最高平均成功率,超越所有最先进基线,包括 OpenVLA、Octo、ThinkAct 与 FLOWER。通过任务特定的 τv 调优,模型进一步提升至 56.3% 的平均成功率,表明即使在极少量任务特定数据下,基于生成式视频主干的条件化也能实现卓越性能。