Command Palette

Search for a command to run...

RecGPT-V2 技术报告

RecGPT-V2 技术报告

摘要

大规模语言模型(LLMs)在推动推荐系统从隐式行为模式匹配向显式意图推理转变方面展现出巨大潜力。尽管RecGPT-V1通过将基于大语言模型的推理机制融入用户兴趣挖掘与物品标签预测,成功开创了这一新范式,但仍面临四大根本性挑战:(1)多条推理路径间存在计算效率低下与认知冗余问题;(2)固定模板生成导致解释内容多样性不足;(3)在监督学习范式下泛化能力有限;(4)评估方式过于聚焦结果指标,难以契合人类判断标准。为应对上述挑战,我们提出RecGPT-V2,并实现四项关键技术突破:第一,构建分层多智能体系统(Hierarchical Multi-Agent System),通过协同机制重构意图推理流程,在消除认知重复的同时实现更广泛的意图覆盖;结合混合表示推理(Hybrid Representation Inference)对用户行为上下文进行高效压缩,使GPU资源消耗降低60%,独家召回率从9.39%提升至10.99%。第二,设计元提示框架(Meta-Prompting framework),动态生成上下文自适应提示,使解释多样性提升7.3%。第三,引入约束强化学习机制,有效缓解多奖励信号之间的冲突,实现标签预测性能提升24.1%,解释接受度提升13.0%。第四,提出“智能体即裁判”(Agent-as-a-Judge)评估框架,将评估过程分解为多步推理,显著提升与人类偏好的对齐程度。在淘宝平台的在线A/B测试中,RecGPT-V2表现显著:点击率(CTR)提升2.98%,独立访问用户数(IPV)增长3.71%,总浏览时长(TV)提高2.19%,新内容探索率(NER)提升11.46%。RecGPT-V2不仅验证了大语言模型驱动的意图推理在技术上的可行性,更证明了其在大规模工业场景中的商业应用价值,成功弥合了认知探索与产业落地之间的鸿沟。

一句话总结

作者提出RecGPT-V2,通过层次化多智能体系统消除认知冗余并实现多样化意图覆盖、元提示技术实现动态解释生成、约束强化学习优化多目标奖励,以及智能体裁判框架进行过程导向评估,解决了RecGPT-V1的四大局限,在淘宝平台取得显著性能提升(包括新颖性曝光率+11.46%)并降低60% GPU消耗。

核心贡献

- RecGPT-V2针对先前系统的关键缺陷(冗余意图推理导致的计算低效与低信息密度解释),引入具有混合表示推理的层次化多智能体系统,将GPU消耗降低60%,专属召回率从9.39%提升至10.99%。

- 该框架通过元提示技术实现动态上下文感知的解释生成,克服表达同质化与时间适应性弱的问题,在捕捉季节趋势等实时信号的同时提升解释多样性7.3%。

- 偏好感知强化学习解决复杂生成任务中的多目标奖励冲突,标签预测准确率提高24.1%,解释接受度提升13.0%;淘宝在线A/B测试证实关键指标显著增长:点击率(CTR) +2.98%、页面访问量(IPV) +3.71%、新颖性曝光率(NER) +11.46%。

引言

推荐系统日益依赖个性化解释提升用户对推荐商品的参与度,但静态解释方法因重复性高、忽略上下文而效果受限。先前工作如RecGPT-V1存在关键缺陷:刚性提示模板导致低信息密度解释,难以适应时间趋势或用户上下文;评估框架未能捕捉风格多样性等核心质量维度。作者通过引入元提示技术动态合成上下文感知提示模板,以及偏好感知强化学习(基于人类对齐的多目标建模优化解释),将解释生成从僵化模板转向自适应推理,直接解决线上部署中观察到的参与度不足问题。

数据集

作者使用双语电商商品标题数据集进行翻译任务,关键细节如下:

- 组成与来源:数据集包含成对的中文商品标题及其英文翻译,源自在线零售平台。

- 子集详情:

- 包含经验证翻译的用户生成商品列表。

- 具体划分规模未说明,但示例遵循严格的{中文: 英文}格式。

- 无明确过滤规则,条目经筛选确保直接翻译相关性。

- 训练用途:

- 数据构成序列到序列翻译模型的核心训练集。

- 作为单一任务混合使用,未添加其他数据源或调整比例。

- 处理流程:

- 原始标题仅进行基础预处理,示例显示字符级直接配对。

- 未应用裁剪策略——完整标题保留为输入输出对。

- 元数据隐式衍生于配对结构,无额外辅助标注。

方法

作者在RecGPT-V2中采用多组件架构,克服前代系统的计算低效、认知冗余及评估局限。系统围绕三大核心创新构建:智能体意图推理、动态解释生成与智能体裁判框架,分别解决推荐流程中的特定瓶颈。

智能体意图推理模块构成系统骨干,以协调式层次化多智能体系统(HMAS)替代RecGPT-V1的并行冗余大语言模型路径。该系统分三阶段运行:全局规划器融合用户行为历史、静态/动态画像属性及实时环境信号(如天气、热点事件),将用户意图分解为专业化角色;分布式专家智能体接收角色分配,各自生成符合特定意图维度的商品标签;最终决策仲裁器整合专家输出,对全候选标签池进行联合推理,筛选行为最相关、画像一致且无冗余的标签用于下游检索。此协调架构消除了冗余的全上下文编码与认知重叠,图示对比了RecGPT-V1孤立路径与RecGPT-V2 HMAS的差异。

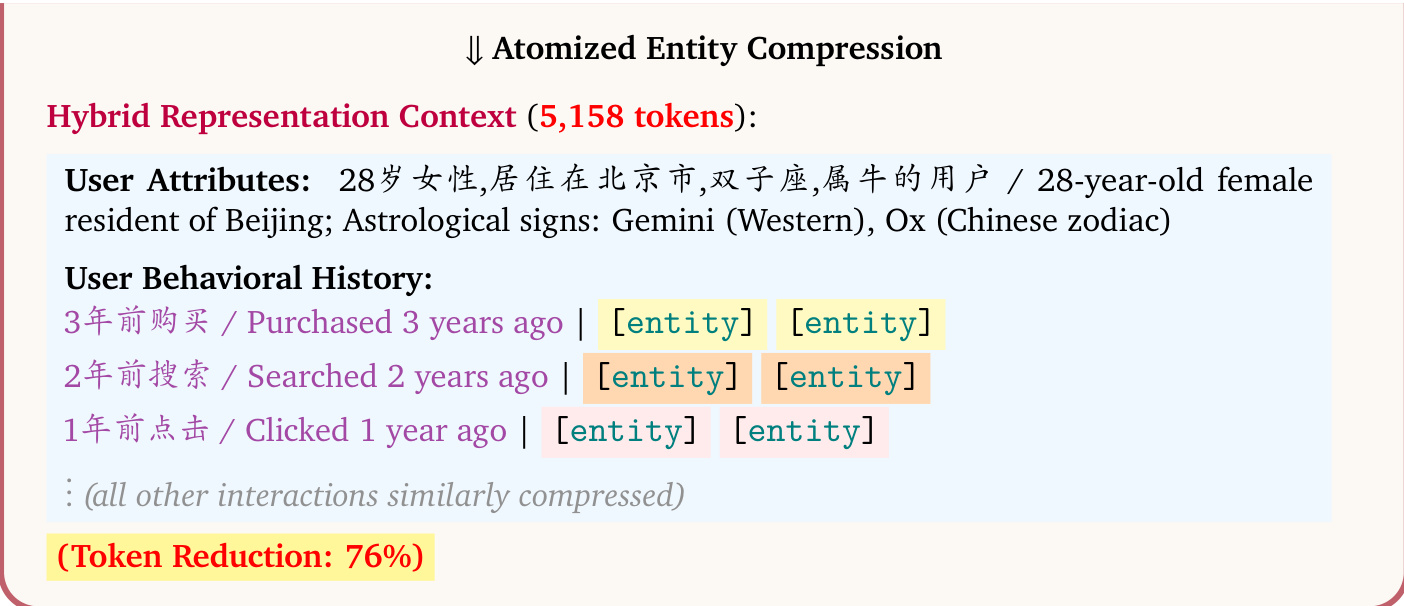

为实现规模化部署,作者引入混合表示推理技术。该技术将用户超长行为序列(常超32K tokens)压缩为紧凑混合上下文,核心是原子化实体压缩:使用预训练嵌入模型(如BGE, Qwen3-Embedding)将商品与查询描述编码为稠密向量,再通过轻量可训练适配器网络投影至大语言模型输入空间,以单原子标记[entity]替代多token文本描述。此过程在保持语义完整性的同时实现7倍压缩比,示例显示21,349 token用户画像被压缩至5,158 tokens。

作者进一步通过基础设施工程优化提升效率,包括解耦预填充-解码服务架构:为计算密集型预填充阶段(处理长上下文)与内存密集型解码阶段(生成输出)分配独立GPU池,显著提升模型FLOPs利用率(MFU)。结合XQA内核的FP8精度推理,这些优化使GPU消耗较RecGPT-V1降低60%,MFU提升53.7%。

在动态解释生成方面,作者通过元提示框架突破RecGPT-V1固定模板限制。该两阶段流程首先基于用户兴趣、商品属性及情境信号(如季节趋势)合成上下文自适应的风格指南;第二阶段据此生成最终解释,实现多样化、情感共鸣且时效性强的输出。该方法将解释多样性提升+7.3%,并在时效性、信息量与吸引力等扩展评估维度上更契合用户预期。

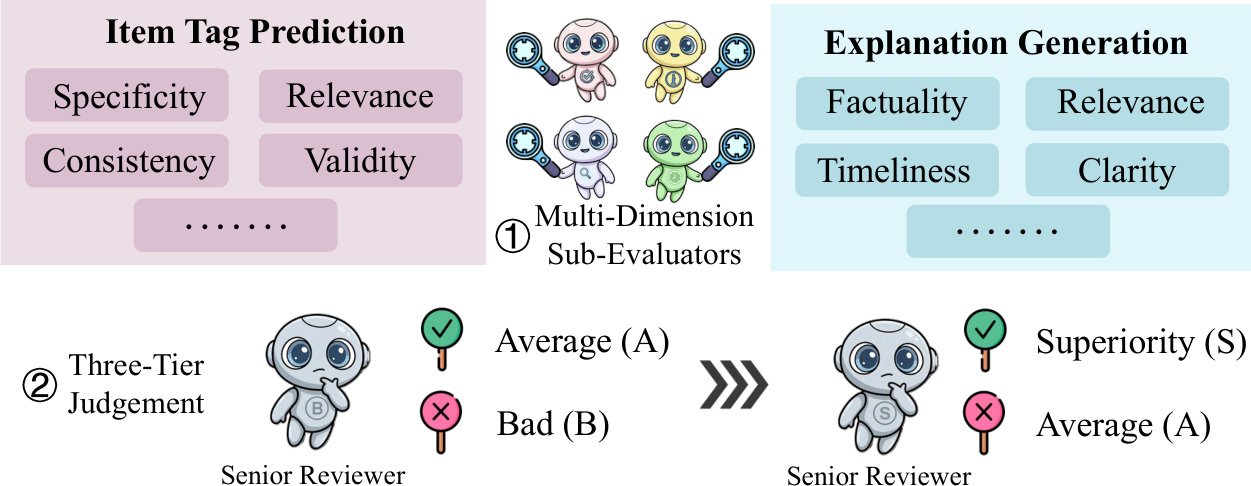

最后,为解决结果导向评估的局限,作者提出智能体作为裁判框架。该系统将整体质量评估分解为多维度子评估器(各专精特定标准如相关性、事实性、时效性),再由高级评审智能体通过结构化两阶段流程聚合子评估:先检测关键缺陷,再提升高质量输出,最终生成三级判断(优秀、平均、差)。此过程导向评估使标签预测与解释生成的人类偏好对齐度分别提升+0.46%与+1.76%。为实现持续优化,作者引入裁判即奖励(Judge-as-a-Reward)蒸馏框架,将离散判断转化为密集可微奖励信号驱动强化学习,建立策略优化的自增强飞轮。

实验

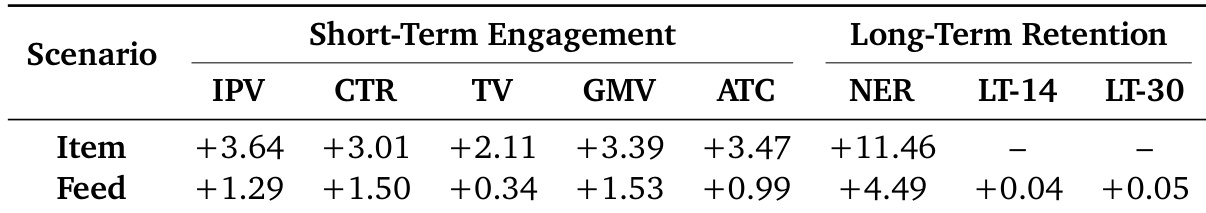

- 在淘宝平台开展为期两周的线上A/B测试,以1%流量分配对比RecGPT-V2与RecGPT-V1在商品及信息流推荐场景的表现

- 短期指标显著提升:页面访问量(IPV) +3.40%、点击率(CTR) +4.68%、总访问量(TV) +4.05%、新颖性曝光率(NER) +11.46%

- 长期留存改善:14日留存率(LT-14) +0.04%、30日留存率(LT-30) +0.05%

- 通过真实案例验证动态意图适应能力,推荐结果有效融合天气与节假日等环境信号

- 在提升商品标签预测与解释生成质量的同时,GPU消耗降低60%

作者在淘宝平台开展RecGPT-V2与RecGPT-V1的两周A/B测试,覆盖商品与信息流推荐场景。结果显示短期参与度与长期留存均显著提升:商品场景在页面访问量(IPV)(+3.64%)与新颖性曝光率(NER)(+11.46%)取得最高增益;信息流场景留存率提升虽小但具实际意义(LT-14 +0.04%,LT-30 +0.05%)。

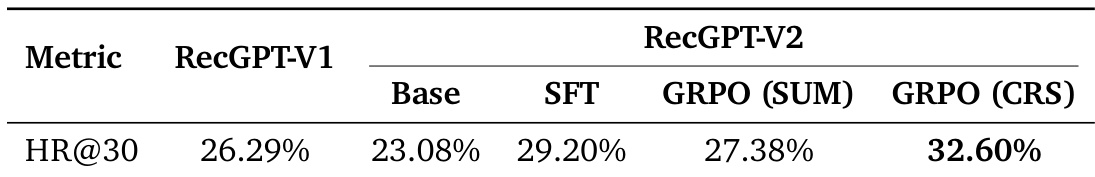

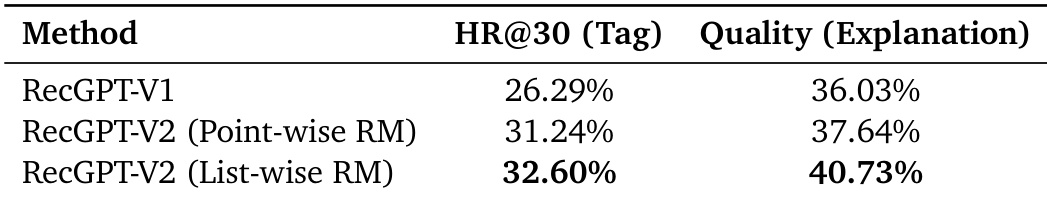

作者采用两种奖励建模方法对比RecGPT-V2与RecGPT-V1,结果表明列表式奖励建模(List-wise RM)在标签预测HR@30(32.60%)与解释质量(40.73%)均达最高值,验证其较点式奖励建模(Point-wise RM)及基线在检索效果与解释输出上的全面优势。

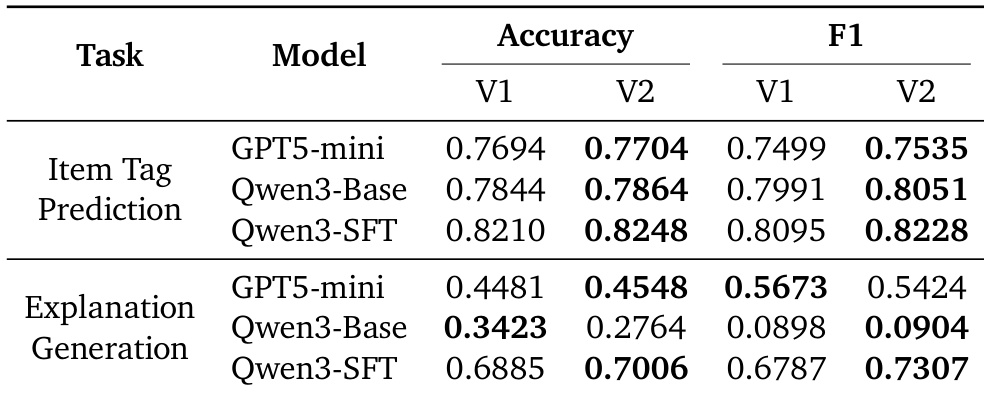

作者在商品标签预测与解释生成任务中对比RecGPT-V2与基线模型,结果显示所有测试模型在准确率与F1分数上均持续提升。标签预测中Qwen3-SFT在V2版本达到最高性能(准确率0.8248,F1值0.8228);解释生成中Qwen3-SFT同样领先(准确率0.7006,F1值0.7307),证实系统生成更精准上下文相关输出的能力。

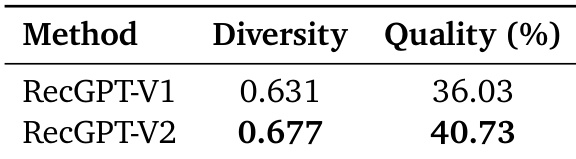

作者通过多样性和质量指标评估RecGPT-V2与RecGPT-V1,结果显示RecGPT-V2在多样性(0.677 vs. 0.631)与质量(40.73% vs. 36.03%)均更高,表明新版系统在推荐多样性与输出准确性上的提升。

作者通过HR@30指标在多配置下评估RecGPT-V2,CRS优化变体(GRPO (CRS))以32.60%的最高分显著优于RecGPT-V1基线(26.29%)及其他变体(SFT 29.20%,GRPO (SUM) 27.38%),表明CRS优化策略对召回性能贡献最大。