Command Palette

Search for a command to run...

OneStory:基于自适应记忆的一致性多轮视频生成

OneStory:基于自适应记忆的一致性多轮视频生成

摘要

现实世界中的视频叙事通常由多个镜头构成——这些镜头在时间上不连续,但语义上相互关联,共同传达出连贯的故事情节。然而,现有的多镜头视频生成(Multi-Shot Video Generation, MSV)方法在建模长距离跨镜头上下文方面存在局限,因其依赖有限的时间窗口或单一关键帧进行条件控制,导致在复杂叙事场景下性能显著下降。为此,本文提出 OneStory,一种能够实现全局且紧凑的跨镜头上下文建模的方法,从而支持一致且可扩展的叙事生成。OneStory 将 MSV 任务重新定义为“下一镜头生成”任务,在实现自回归式镜头合成的同时,充分利用预训练的图像到视频(Image-to-Video, I2V)模型以获得强大的视觉条件引导。本文引入两个核心模块:帧选择模块(Frame Selection Module),通过提取先前镜头中有信息量的关键帧,构建语义相关的全局记忆;以及自适应条件生成模块(Adaptive Conditioner),采用基于重要性的补丁化(patchification)策略,生成紧凑的上下文表示,用于直接条件输入。此外,我们构建了一个高质量的多镜头数据集,包含具有指代性描述的字幕,以更真实地反映现实中的叙事模式,并设计了适用于“下一镜头”范式的高效训练策略。在我们精心构建的包含 6 万条样本的数据集上,对预训练 I2V 模型进行微调后,OneStory 在文本与图像双重条件设置下,均在多样化且复杂的场景中实现了当前最优的叙事连贯性表现,显著提升了长篇视频叙事的可控性与沉浸感。

摘要

Meta AI 与哥本哈根大学的研究人员提出 OneStory,这是一种用于多镜头视频生成的新框架。该框架通过帧选择模块(Frame Selection)和自适应调节器(Adaptive Conditioner)建模全局跨镜头上下文,将任务重新定义为基于预训练图像到视频模型的自回归“下一镜头”预测,从而实现可扩展且连贯的长篇叙事生成。

主要贡献

- 本文提出了一种用于多镜头视频生成的新框架,通过自适应关键帧选择和跨镜头上下文传播,解决了现有方法的局限性,实现了具有一致性和可扩展性的叙事建模。

- 提出了一种高效的训练策略,使用包含指代表述的高质量多镜头视频数据集,使模型能够在不连续场景中保持叙事连贯性。

- 通过将多镜头生成重新定义为“下一镜头”预测任务,该方法增强了长时程时间一致性,并支持故事元素的动态演化,克服了以往单关键帧方法中的记忆丢失问题。

引言

作者利用扩散变换器(diffusion transformers)在视频生成方面的最新进展,解决多镜头视频合成的挑战。现有模型通常只能生成单个连续场景,限制了其在现实世界叙事应用中的使用。现有方法要么依赖固定窗口注意力机制,要么依赖关键帧条件控制,但由于随着镜头推进上下文窗口有限,两者都存在记忆丢失和叙事不一致的问题。

- 所提出的 OneStory 框架引入了三项关键技术:(1)帧选择模块,用于识别所有先前镜头中语义相关的帧;(2)自适应调节器,根据帧的重要性动态地对上下文信息进行分块并注入生成器;(3)使用统一的三镜头序列和渐进耦合的训练策略,以增强叙事连贯性和可扩展性。

数据集

- 作者使用了一个高质量的多镜头视频数据集,包含约 60,000 个视频,其中包括 50,000 个双镜头和 10,000 个三镜头序列,所有视频均围绕以人为中心的活动,并来源于受版权保护的研究视频。

- 使用 TransNetV2 检测镜头边界,仅保留至少包含两个镜头的视频。每个镜头的字幕分两个阶段生成:首先独立生成,然后参考前一个镜头的内容和字幕进行重写,引入指代表述(例如“同一个男人”),以确保叙事连续性。

- 字幕由视觉-语言模型生成,以产生连贯且上下文感知的描述。

- 数据集经过多阶段过滤:关键词过滤器去除不当内容;CLIP 和 SigLIP 过滤掉镜头转换无关的视频;DINOv2 剔除镜头过于相似的视频,确保叙事推进和视觉多样性。

- 为实现稳定训练,作者将所有样本统一为三镜头格式。对于双镜头视频,通过插入来自其他视频的随机镜头,或对第一个镜头进行空间或颜色变换来生成合成的中间或首个镜头。

- 每个序列中的最后一个镜头(真实或合成)作为预测目标。模型被训练以根据前两个镜头及其对应字幕生成该最后一个镜头,使用修正流扩散损失(rectified-flow diffusion loss)。

- 在评估方面,作者构建了一个包含 64 个六镜头测试用例的基准,分别用于文本到多镜头视频(T2MSV)和图像到多镜头视频(I2MSV)生成,涵盖三种叙事模式:主主体一致性、插入并回忆中间镜头、可组合生成,从而全面评估叙事连贯性和跨镜头推理能力。

方法

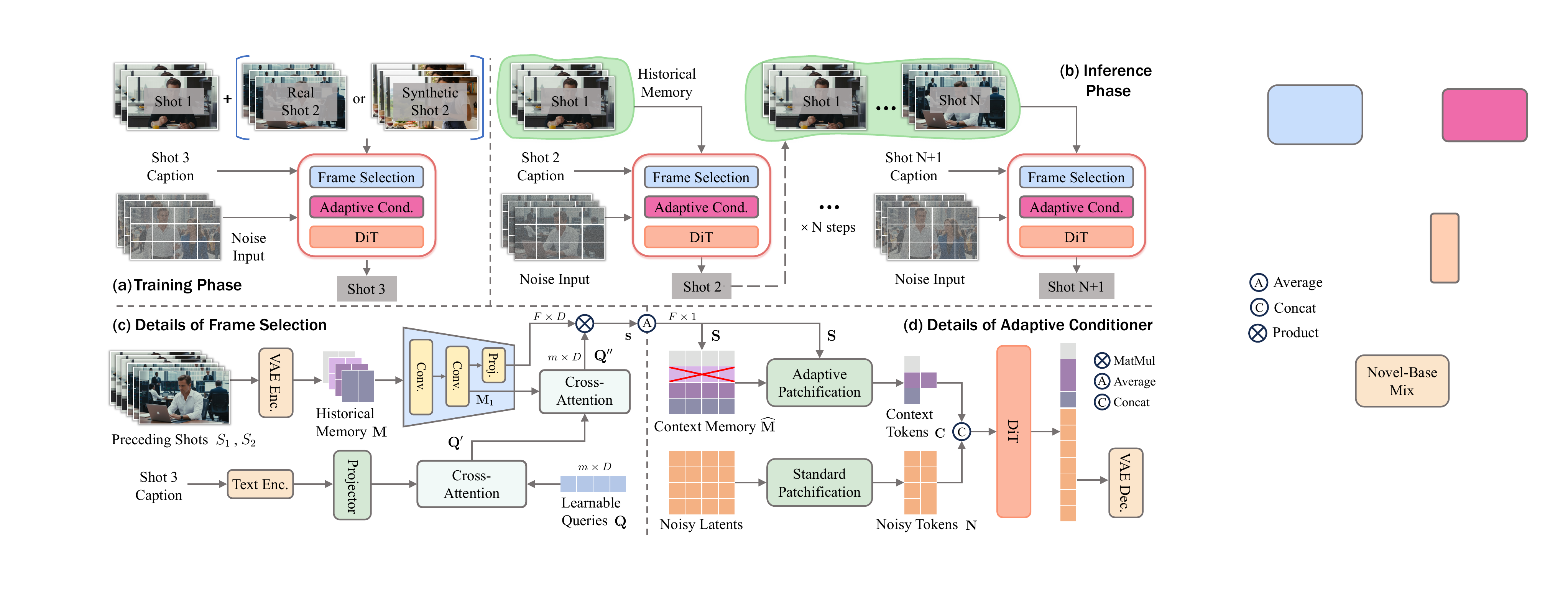

作者采用统一的自回归框架进行多镜头视频生成,将任务重新定义为基于先前视觉上下文和叙事字幕的“下一镜头”预测问题。该模型名为 OneStory,从预训练的图像到视频扩散模型初始化,并在精选的 60K 数据集上进行微调。如图所示,核心架构包含三个关键组件:帧选择模块、自适应调节器和基于 DiT 的扩散主干网络,这些组件在训练和推理过程中协同工作。

在生成过程中,对于第 i 个镜头,模型输入包括字幕 Ci、所有先前镜头的潜在表示 {Sj}j=1i−1 以及一个噪声张量。3D VAE 编码器首先将每个先前镜头压缩为潜在序列,并拼接成全局历史记忆 M∈RF×Ns×Dv,其中 F 是先前镜头中总帧数,Ns 是每帧的空间标记数量。帧选择模块随后从该记忆中识别出语义最相关的帧。该模块使用 m 个可学习查询标记,首先关注 Ci 的投影文本特征以捕捉当前镜头的意图,然后关注投影后的视觉记忆 M1 以提取视觉线索。通过查询-记忆交互的投影和均值聚合计算逐帧相关性得分 S∈RF。根据这些得分选择得分最高的 Ksel 帧,形成紧凑的上下文记忆 M。

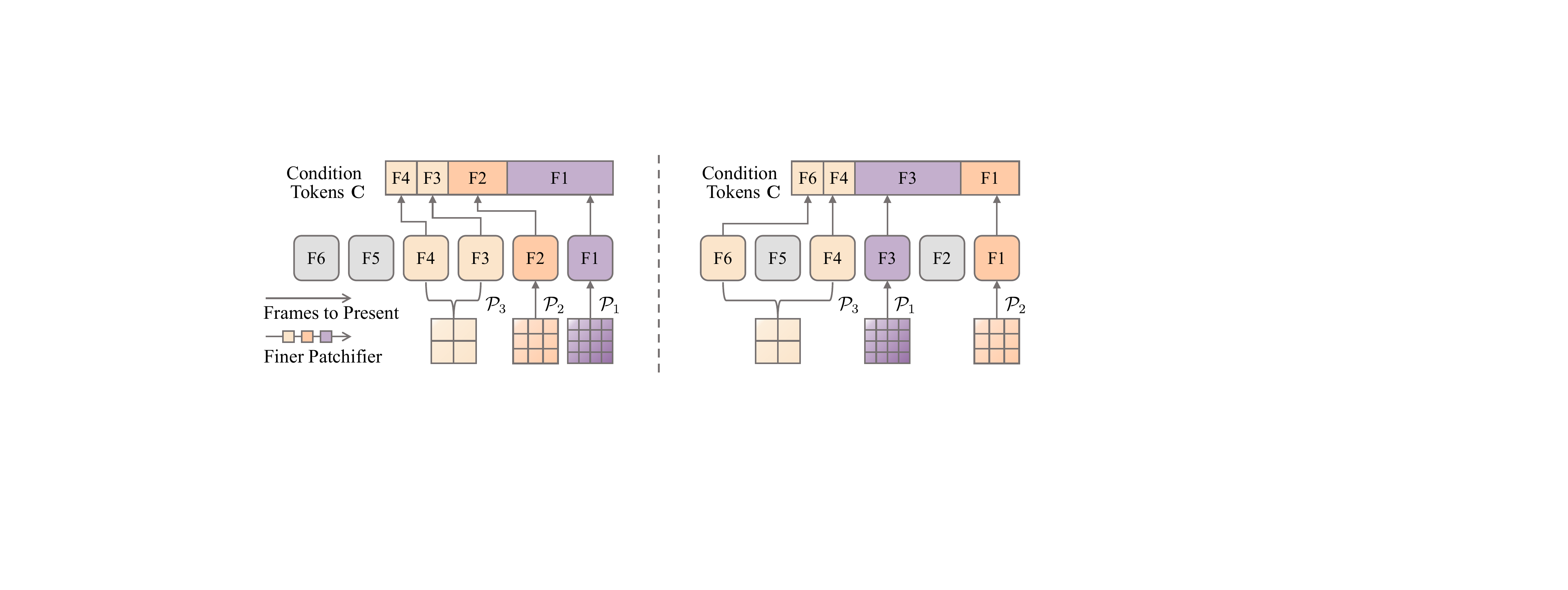

自适应调节器处理所选记忆,生成一组上下文标记 C,并高效注入扩散过程。该模块采用一组具有不同核大小的分块器 {Pℓ}ℓ=1Lp。根据相关性得分 S,M 中的帧被自适应地分配给不同的分块器:高度相关的帧使用更精细、压缩更少的分块器处理,而相关性较低的帧则使用更粗糙的分块器。这种基于内容的分配方式(如下图所示)与固定的时间划分形成对比,确保关键视觉信息以最小计算开销得以保留。

生成的上下文标记 C 与当前镜头的噪声潜在标记 N 拼接,形成 DiT 主干网络的输入 X。这种拼接使得噪声标记与上下文标记之间能够进行联合注意力计算,促进丰富的交叉注意力交互,从而引导去噪过程。模型采用联合目标函数进行训练,结合标准镜头生成损失 Lshot 和帧相关性得分的监督损失 Lsel。后者使用基于 DINOv2 和 CLIP 嵌入的真实帧伪标签,以及合成帧的启发式标签计算,确保帧选择模块学会优先选择语义对齐的上下文。

实验

- 镜头膨胀(Shot inflation)和解耦条件控制(Decoupled Conditioning)显著提升了叙事一致性,而两个基线方法均失败,突显了我们自适应记忆在维持稳定长程身份线索方面的有效性。

- 镜头膨胀和解耦条件控制显著提升了叙事一致性,而两个基线方法均失败,突显了我们自适应记忆在维持稳定长程身份线索方面的有效性。

- 镜头膨胀和解耦条件控制显著提升了叙事一致性,而两个基线方法均失败,证实了它们在跨镜头上下文建模中的互补作用。

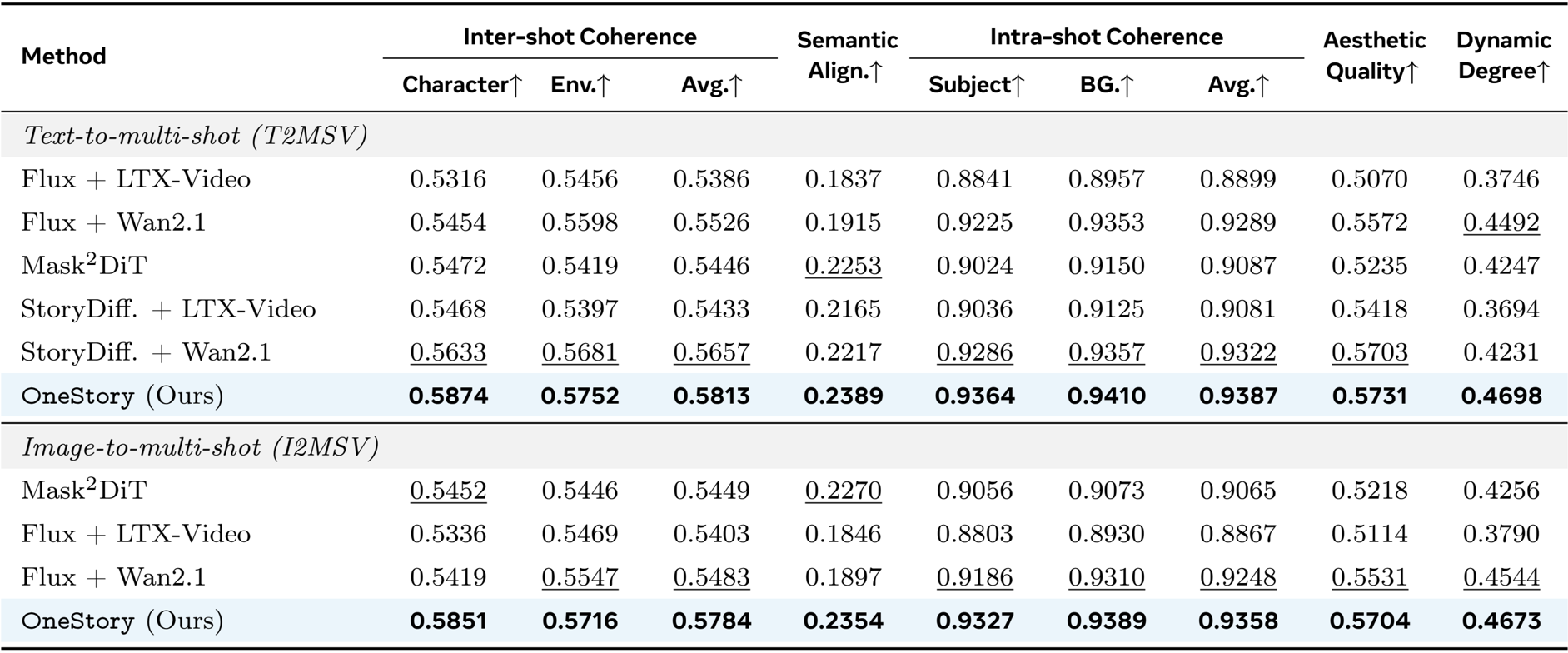

作者使用 OneStory 在文本和图像条件设置下生成多镜头视频,评估其在镜头间连贯性、语义对齐、镜头内连贯性、美学质量和动态程度方面的表现。结果表明,OneStory 在两种设置下均持续优于所有基线方法,在几乎所有指标上得分最高,尤其在角色和环境一致性、语义对齐以及主体-背景保真度方面表现突出。这证明了其在多个镜头中保持叙事连续性和视觉质量的卓越能力。

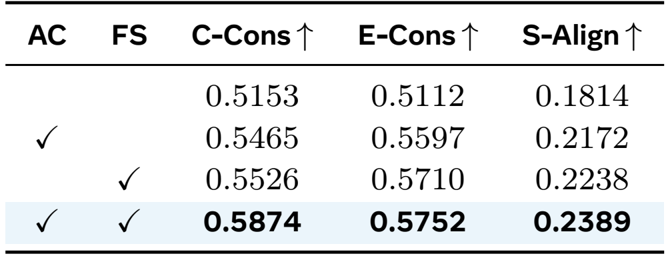

作者通过消融实验评估了自适应调节器(AC)和帧选择(FS)模块的影响,结果显示两者结合时在角色一致性、环境一致性和语义对齐方面达到最高水平。结果证实每个组件独立贡献,联合使用时实现最强的叙事连贯性。

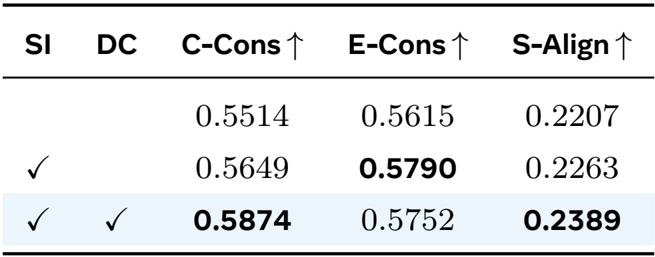

作者评估了其训练策略的影响,结果显示仅使用镜头膨胀即可提升环境一致性和语义对齐,而将其与解耦条件控制结合后在所有指标上均取得最高分,证实了其两阶段课程学习在稳定优化和叙事连贯性方面的有效性。

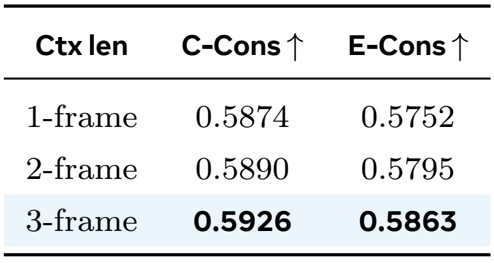

作者评估了上下文标记长度对跨镜头一致性的影响,发现从一个潜在帧当量增加到三个时,角色和环境一致性均得到提升。结果表明,随着上下文标记增多,性能稳步提高,证实了其自适应记忆在建模时间动态方面的高效性。