Command Palette

Search for a command to run...

Ovis-Image 技术报告

Ovis-Image 技术报告

摘要

我们提出 Ovis-Image,这是一个参数量为70亿(7B)的文本到图像生成模型,专为高质量文本渲染而优化,能够在严苛的计算资源约束下高效运行。Ovis-Image 基于我们此前的 Ovis-U1 框架,融合了基于扩散机制的视觉解码器与更强大的 Ovis 2.5 多模态主干网络,并采用以文本为中心的训练流程,结合大规模预训练与精心设计的后训练微调阶段。尽管模型架构紧凑,Ovis-Image 在文本渲染性能上已达到与显著更大规模的开源模型(如 Qwen-Image)相当的水平,且接近闭源系统(如 Seedream 和 GPT-4o)的表现。尤为重要的是,该模型可在单张高端 GPU 上部署,仅需中等显存,大幅缩小了前沿文本渲染能力与实际可部署性之间的差距。实验结果表明,仅通过强健的多模态主干网络与精心设计的文本导向训练策略相结合,即可实现可靠且高效的双语文本渲染,而无需依赖过大的模型或专有模型。

一句话总结

阿里巴巴集团 Ovis 团队提出 Ovis-Image,这是一个 70 亿参数的文本到图像模型,通过将基于扩散的视觉解码器与 Ovis 2.5 多模态主干网络及以文本为中心的训练流程相结合,实现了最先进的双语文本渲染能力,在单张高端 GPU 上即可实现高质量生成,性能可媲美更大规模的开源与闭源模型。

主要贡献

-

Ovis-Image 是一个专为高质量文本渲染优化的 70 亿参数文本到图像模型,其性能可与更大规模的 200 亿级开源模型(如 Qwen-Image)比肩,并接近 GPT4o 等最先进的闭源系统,同时保持紧凑且可部署的架构。

-

该模型利用强大的 Ovis 2.5 多模态主干网络和基于扩散的视觉解码器,结合以文本为中心的训练流程,能够在海报、UI 原型和信息图等复杂、布局敏感的场景中实现准确、清晰且语义一致的双语文本渲染。

-

为提升效率,Ovis-Image 可在单张高端 GPU 上运行,内存占用适中,支持低延迟交互式使用和批量服务,从而弥合前沿文本渲染能力与真实应用场景中实际部署之间的差距。

引言

作者利用近期在文本到图像生成方面的进展,解决合成图像中高质量、低成本文本渲染这一长期挑战。尽管当前最先进模型在文本保真度方面表现强劲,但往往依赖庞大的参数量或闭源架构,限制了其可部署性和可复现性。此前的开源模型(包括作者自研的 30 亿参数 Ovis-U1)虽设计高效,但在文本伪影和幻觉方面仍存在困难。为填补这一空白,作者提出 Ovis-Image,一个 70 亿参数模型,结合强大的多模态主干(Ovis 2.5)与基于扩散的视觉解码器。通过聚焦文本渲染并保持强大的通用图像生成能力,Ovis-Image 的性能可与 200 亿级开源模型比肩,接近最先进的闭源系统,在 UI 原型、标识牌等实际应用中实现清晰、语义准确的文本输出,同时计算成本可接受。

数据集

-

Ovis-Image 的数据集由大规模网络、授权及合成的图像-文本对构成,数据来源包括公开网络爬取、精心筛选的集合以及合成生成。涵盖日常照片、插图、设计素材、UI 原型,以及文本作为显著视觉元素的场景,如海报、横幅、标志和 UI 布局。

-

预训练阶段的语料库规模大且异构,包含中英文的广泛重描述,以提升图文对齐效果。采用多阶段过滤流程,剔除损坏图像、不匹配或无信息量的描述以及不安全内容。粗粒度去重减少近似重复项。通过渲染引擎添加合成数据,生成不同字体、大小和位置的清晰排版文本,增强文本渲染场景的覆盖范围。

-

监督微调使用高质量子集,重点关注清晰视觉和结构良好提示。图像以高分辨率为主(通常为 1024 像素),涵盖广泛长宽比,反映真实使用场景。数据中包含适量合成内容,以提升细节、布局控制及罕见概念的覆盖。在内容类型、分辨率和长宽比上进行简单平衡,防止过拟合。

-

对于 DPO(直接偏好优化),在监督微调分布基础上构建偏好数据集。约 90% 的数据来自常见物体类别和日常场景的高质量、美观图像,经 HPSv3、CLIP 和 PickScore 等自动化评分器预筛选。其余 10% 来自内部设计与创意内容集合,包括海报和风格化构图。对每个提示,从池中选取一张高质量图像,并使用 SFT 模型生成第二候选图像。由多个模型对两者评分,得分更高的图像被标记为偏好(胜出)选项,形成偏好对。

-

所有数据均经过一致处理,包括元数据构建以追踪来源和过滤,训练过程中选择性裁剪以确保视觉内容居中,尤其在合成和布局密集数据中尤为重要。

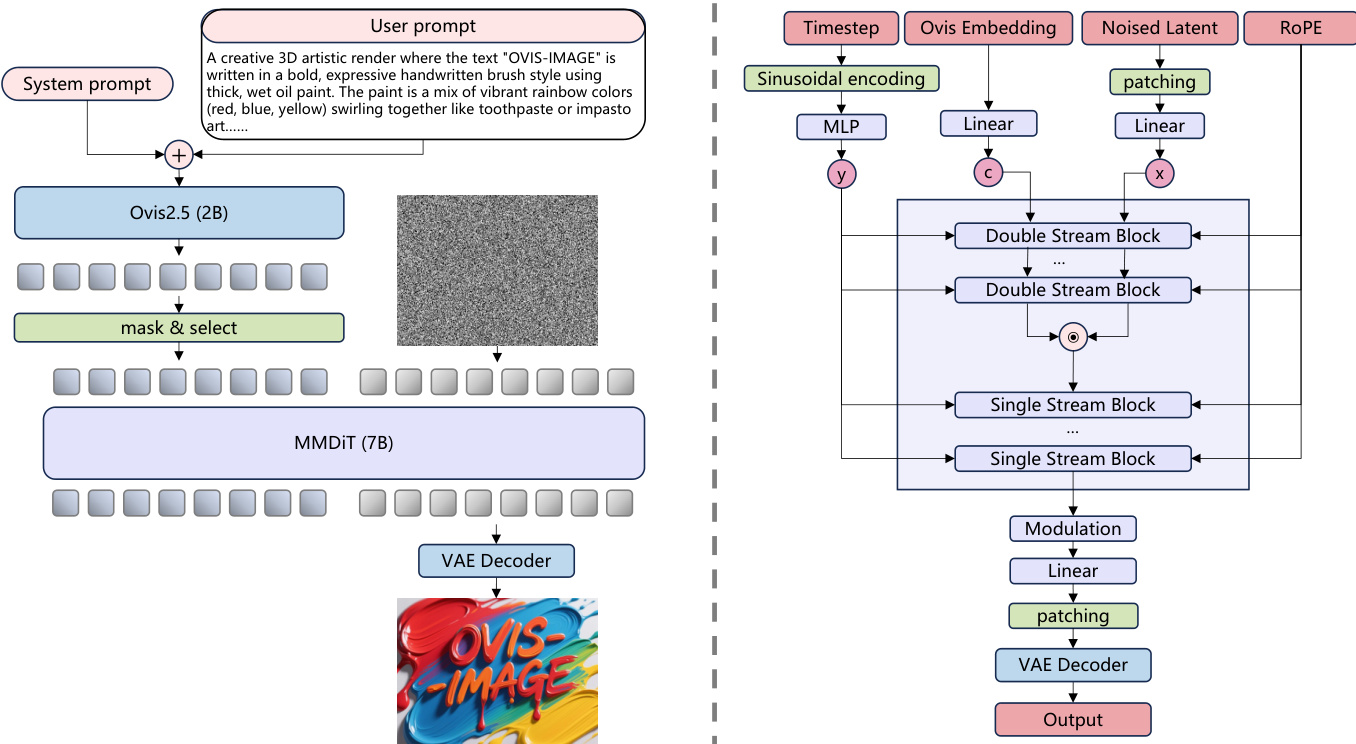

方法

作者采用模块化、基于扩散的架构,在 70 亿参数的紧凑规模内实现高质量文本渲染。整体框架如图所示,建立在 Ovis-U1 基础之上,同时增强视觉解码器并简化设计,以提升效率和文本中心性能。

该架构包含文本编码器、视觉解码器和用于潜在空间操作的变分自编码器(VAE)。文本编码器基于 Ovis 2.5-2B 模型,该模型专门在多模态数据上训练,确保文本与视觉表征之间的强对齐。该编码器处理用户提示并生成条件图像生成过程的嵌入。与 Ovis-U1 框架不同,Ovis-Image 简化了架构,移除了精炼器结构,直接将 Ovis 编码器的最终隐藏状态作为图像解码器的条件输入。

视觉解码器实现为参数量为 70 亿的修改版 MMDiT(多模态扩散 Transformer),作为核心生成组件。该解码器基于 MMDiT 框架,引入 RoPE(旋转位置编码)以增强位置编码能力。架构采用混合块结构,包含六个双流块和 27 个单流块,旨在高效处理文本与视觉信息。为提升模型容量,注意力头数量设为 24,采用 SwiGLU 激活函数。MMDiT 处理文本嵌入和图像的噪声潜在表示,通过一系列注意力与前馈层迭代优化潜在空间。

VAE 模型来自 FLUX.1-schnell,用于将图像编码和解码至低维潜在空间。该组件在训练过程中保持冻结,使模型可专注于学习潜在域内的生成过程。VAE 解码器从 MMDiT 生成的优化潜在表示中重建最终图像。

训练过程遵循四阶段流程,逐步提升模型能力。第一阶段为预训练,MMDiT 随机初始化,并在多样化图像数据集上使用标准噪声预测损失进行训练,建立通用图像生成的坚实基础。第二阶段为监督微调,模型在指令式数据上进一步训练,以提升其理解与遵循用户提示的能力,尤其针对文本渲染任务。第三阶段采用直接偏好优化(DPO),通过人类与模型生成的偏好数据混合,对齐模型与人类偏好。该阶段增强模型的有用性、无害性以及对提示细节(包括文本布局与渲染)的遵循能力。最终阶段使用组相对策略优化(GRPO),通过在线策略采样与奖励建模进一步优化模型,以实现高质量文本渲染,同时保持整体视觉一致性。

实验

- 使用 PyTorch 进行训练,结合混合分片数据并行(HSDP)、梯度检查点、激活卸载、Flash Attention 和区域编译,实现大模型在 bfloat16 混合精度和 FP32 主权重下的高效训练。

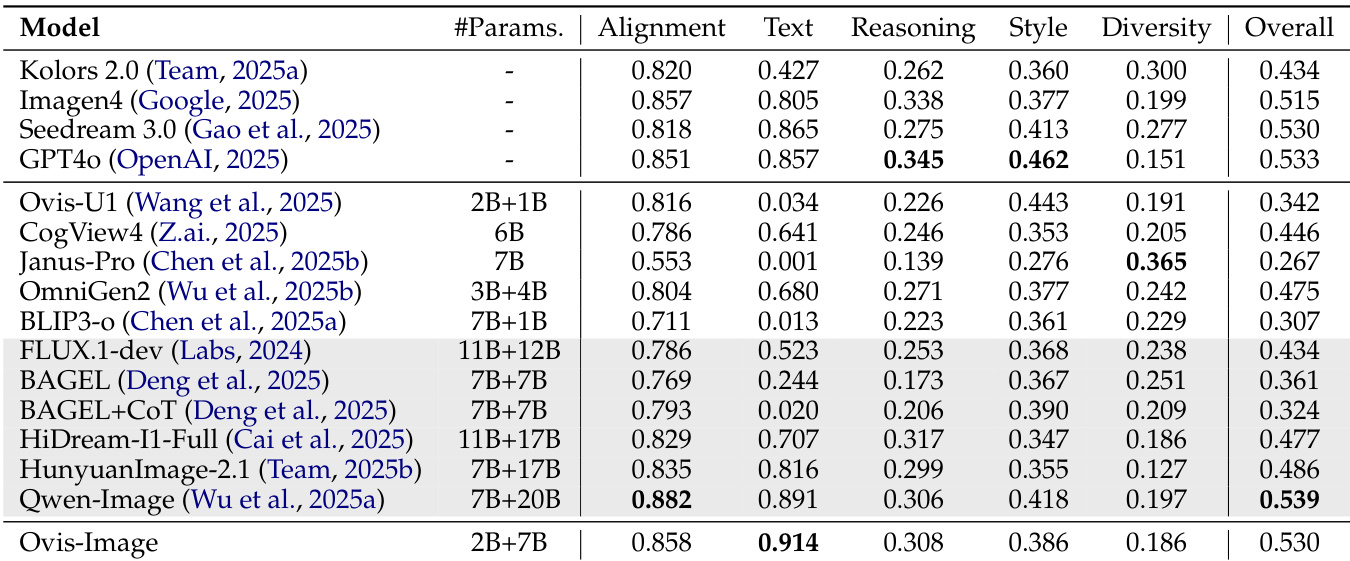

- 在多个基准上评估 Ovis-Image 的文本渲染与通用文本到图像生成能力:CVTG-2K、LongText-Bench、DPG-Bench、GenEval 和 OneIG-Bench。

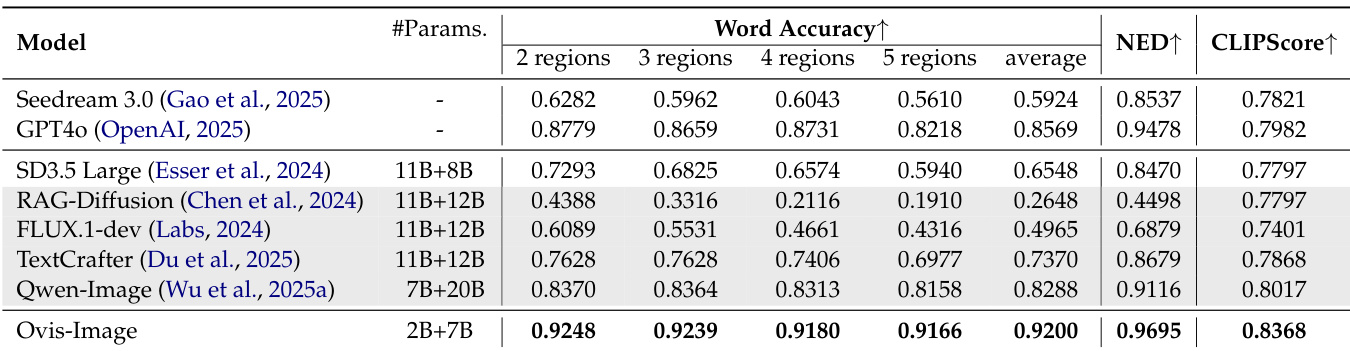

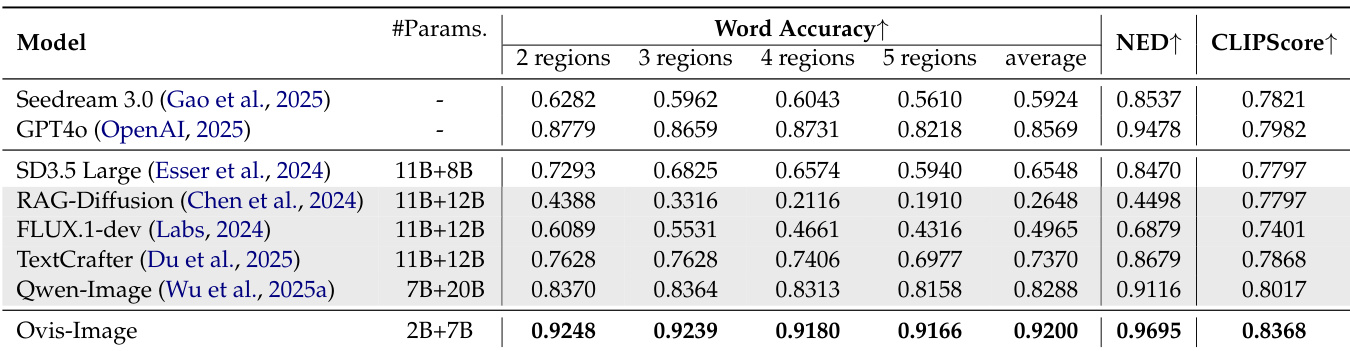

- 在 CVTG-2K 上,达到最高的单词准确率、NED 和 CLIPScore,证明其在英文文本渲染方面的卓越能力。

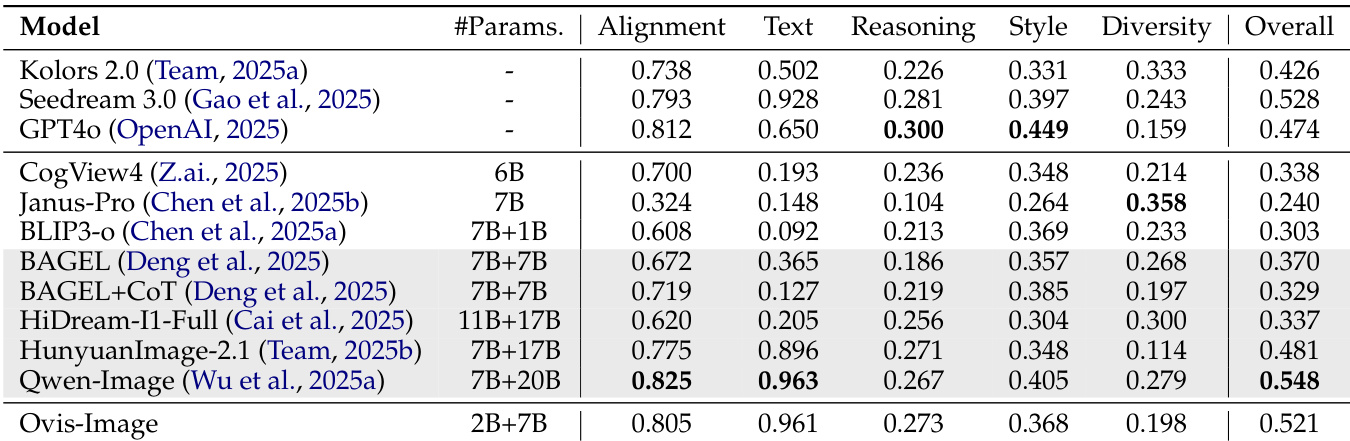

- 在 LongText-Bench 上,中文文本渲染表现优于更大模型,长英文文本生成与闭源模型持平,凸显其强大的长文本生成能力。

- 在 DPG-Bench 上,对密集提示具有稳健的遵循能力,表现与更大规模的开源及闭源模型相当或更优。

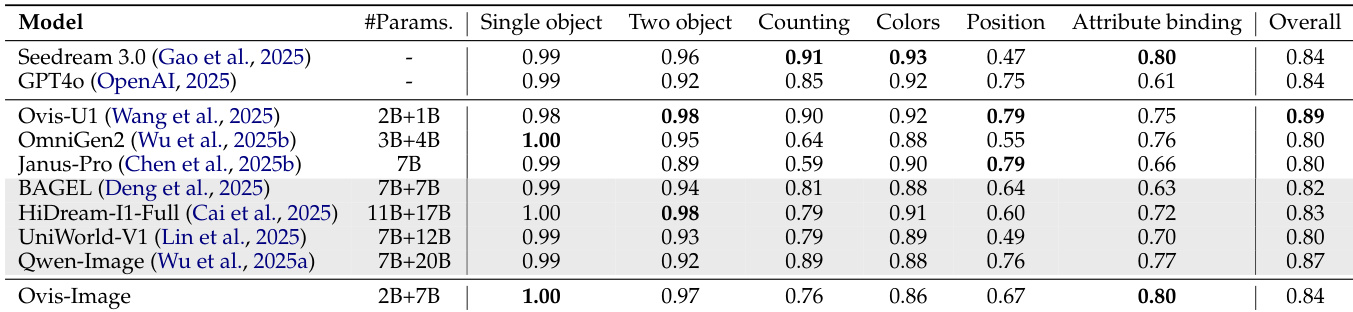

- 在 GenEval 上,对象中心生成任务中表现具有竞争力,尤其在组合提示下,表明其具备强大的可控生成能力。

- 在 OneIG-Bench 上,实现卓越的双语性能,尤其在英文与中文基准的文本相关维度上表现突出。

- 在计算效率方面,Ovis-Image 相较于更大基线模型,显著降低 GPU 内存占用并加快推理速度,展现出优异的资源效率。

结果表明,Ovis-Image 在所有评估维度上取得最高综合得分 0.521,全面超越其他模型,涵盖对齐、文本渲染与多样性。尽管参数量小于多个基线模型,Ovis-Image 在文本相关任务中表现更优,尤其在文本渲染与双语生成方面,同时保持更高效的计算开销。

作者为 Ovis-Image 采用模块化架构,总模型参数量为 100.2 亿,由 MMDiT 的 73.7 亿、文本编码器的 25.7 亿和 VAE 的 0.8 亿组成。文本编码器在 AIDC-AI/Ovis2.5-2B 上预训练,VAE 在 black-forest-labs/FLUX.1-schnell 上预训练,体现了对参数效率与模块化预训练的重视。

结果显示,Ovis-Image 在 CVTG-2K 基准的所有区域均取得最高单词准确率,平均得分为 0.9200,全面超越所有对比模型。其 NED 和 CLIPScore 也达到最佳,证实其卓越的文本渲染能力。

结果显示,Ovis-Image 在多个文本到图像基准上表现具有竞争力,尤其在单对象生成任务中得分高达 1.00,尽管参数量较小,仍保持强劲的整体性能。该模型在推理时间和 GPU 内存使用方面显著优于更大规模基线,凸显其在资源受限环境中的高效性。

结果显示,Ovis-Image 在文本渲染维度上取得最高得分 0.914,全面超越其他模型,同时保持强大的整体生成质量。该模型在 GPU 内存占用和推理时间方面也表现出显著优势,相较更大基线模型大幅降低,使其成为资源受限环境下的实用解决方案。