Command Palette

Search for a command to run...

通义千问-图像技术报告

通义千问-图像技术报告

摘要

我们提出 Qwen-Image,这是 Qwen 系列中的一个图像生成基础模型,在复杂文本渲染与精准图像编辑方面取得了显著进展。为应对复杂文本渲染的挑战,我们设计了一套完整的数据处理流程,涵盖大规模数据收集、过滤、标注、合成与平衡等环节。此外,我们采用了一种渐进式训练策略:从无文本到文本的渲染任务起步,逐步由简单文本输入过渡到复杂文本描述,最终扩展至段落级文本生成。这一课程学习(curriculum learning)方法显著提升了模型的原生文本渲染能力。由此,Qwen-Image 不仅在英语等字母语言中表现卓越,更在中文等更具挑战性的表意文字语言上实现了突破性进展。为提升图像编辑的一致性,我们引入了一种改进的多任务训练范式,不仅包含传统的文本到图像(T2I)和文本-图像到图像(TI2I)任务,还融合了图像到图像(I2I)重建任务,有效对齐了 Qwen2.5-VL 与 MMDiT 之间的潜在表征。同时,我们分别将原始图像输入至 Qwen2.5-VL 与 VAE 编码器,以分别获取语义表征与重建表征。这一双编码机制使编辑模块能够在保持语义一致性与维持视觉保真度之间取得良好平衡。Qwen-Image 在多个基准测试中均达到当前最先进(SOTA)水平,充分展现了其在图像生成与编辑任务中强大的综合能力。

一句话总结

通义团队推出Qwen-Image,一种基础模型,通过渐进式课程学习流程和双编码机制,显著提升复杂文本渲染能力,尤其在汉字等表意语言中表现突出,实现了在生成、编辑和文本保真度等多个基准测试中的最先进性能。

主要贡献

-

Qwen-Image通过引入全面的数据处理流程和渐进式课程学习策略,解决了图像生成中复杂文本渲染的挑战,实现了对字母语言(如英语)和表意语言(如中文)的稳健性能,尤其在多行及段落级文本融合方面表现卓越。

-

为实现一致的图像编辑,模型采用双编码机制,分别通过Qwen2.5-VL提取语义特征,通过VAE编码器提取重建特征,并在共享的MMDiT架构下联合条件化,确保编辑过程中语义连贯性与视觉保真度的双重保持。

-

在GenEval、GEdit、LongText-Bench和CVTG-2K等多个基准上进行评估,Qwen-Image在通用图像生成与编辑任务中均达到最先进水平,尤其在中文文本渲染方面表现优异,同时在多种视觉模态下保持强大能力。

引言

图像生成模型已成为现代人工智能的核心,能够从文本提示中合成高质量、语义丰富的视觉内容。然而,以往模型在复杂提示对齐方面存在困难——尤其在多行文本、非字母语言(如中文)以及精确的图文融合方面——且在图像编辑中仍面临视觉一致性与语义连贯性难以兼顾的挑战。本文提出Qwen-Image,通义系列中的新一代基础模型,通过包含课程学习的全面数据流程,有效应对这些局限,实现对多种语言中复杂语言输入的稳健处理。为提升编辑保真度,作者提出一种双条件框架,在共享的MMDiT架构中联合使用Qwen-VL的语义特征与VAE的重建特征,确保高层语义与底层视觉细节均被保留。模型采用Producer-Consumer分布式框架,结合TensorPipe与Megatron,实现高效训练,支持可扩展、稳定的训练过程。Qwen-Image在文本到图像生成、图像编辑及跨基准任务中均达到最先进性能,展现出对3D视图合成与姿态编辑的强大泛化能力,为统一视觉-语言生成树立了新范式。

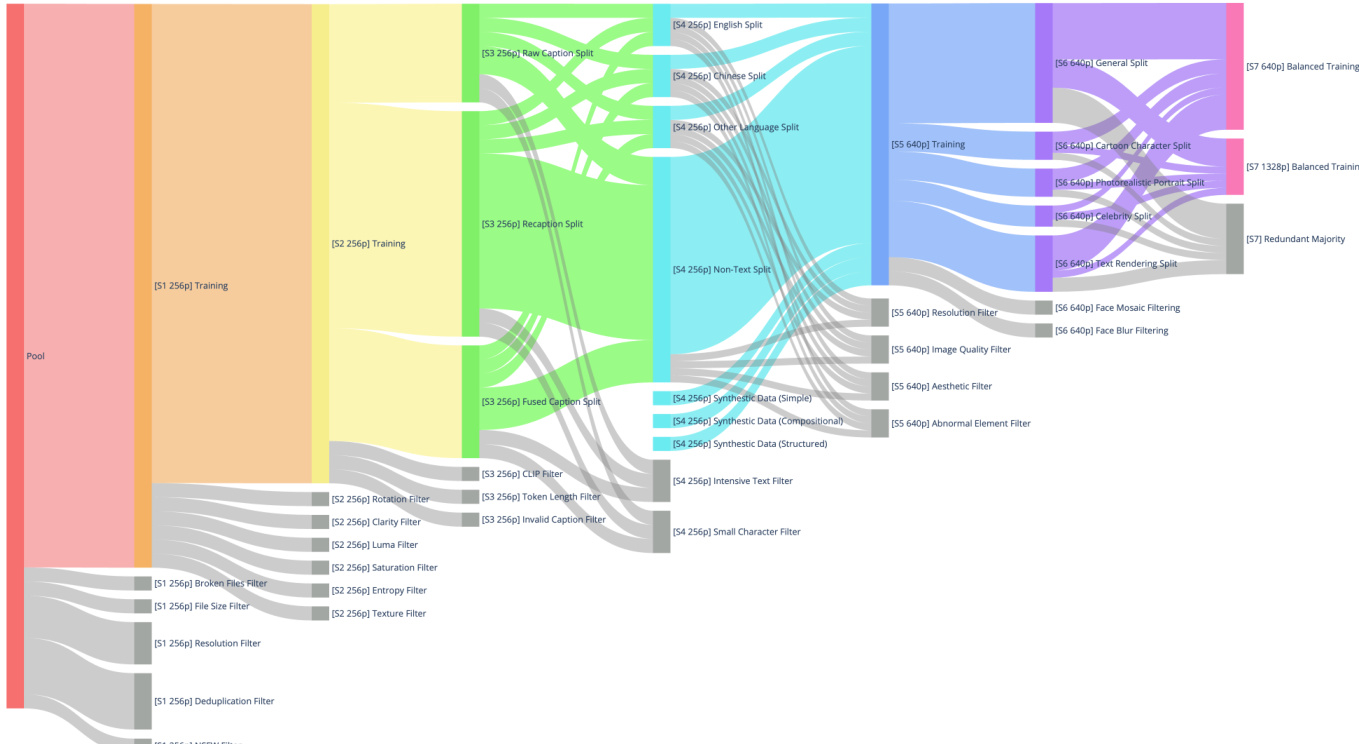

数据集

- 数据集包含数十亿张图像-文本对,分为四大主要领域:自然(55%)、设计(27%)、人物(13%)和合成数据(5%)。

- 自然领域涵盖物体、景观、城市景观、植物、动物、室内和食物等多种子类别,构成通用图像生成的基础。

- 设计领域涵盖海报、用户界面、演示文稿及各类艺术形式等结构化视觉内容,增强模型处理复杂布局、艺术风格和文本渲染的能力。

- 人物领域包括肖像、体育和人类活动,对生成真实且多样化的以人物为中心的图像至关重要。

- 合成数据由通过受控非AI方法生成的文本渲染图像构成(详见§3.4),避免AI生成内容可能带来的幻觉或伪影风险。

- 数据经过七阶段过滤流程:

- 阶段1:在256p分辨率下进行初步筛选,过滤损坏文件、小文件大小、低分辨率、重复项及NSFW内容。

- 阶段2:使用旋转、清晰度、亮度、饱和度、熵值和纹理等滤波器提升图像质量,剔除低质或不自然图像。

- 阶段3:通过三种标题分割方式(原始、重写、融合)结合CLIP与SigLIP滤波器、标记长度检查及无效标题移除,提升图像-文本对齐。

- 阶段4:按语言(英文、中文、其他、无文本)拆分数据,引入合成文本数据,并应用密集文本与小字符滤波器,增强文本渲染能力。

- 阶段5:在640p分辨率下进行高分辨率精炼,增加质量、分辨率、美学及异常元素滤波。

- 阶段6:将类别重新平衡为通用、肖像和文本渲染三类,通过关键词与图像检索进行针对性增强,并优化肖像描述。

- 阶段7:在640p与1328p分辨率下进行平衡的多尺度训练,采用分层分类体系(受WordNet启发)、基于质量的保留策略与重采样,以缓解长尾词分布问题。

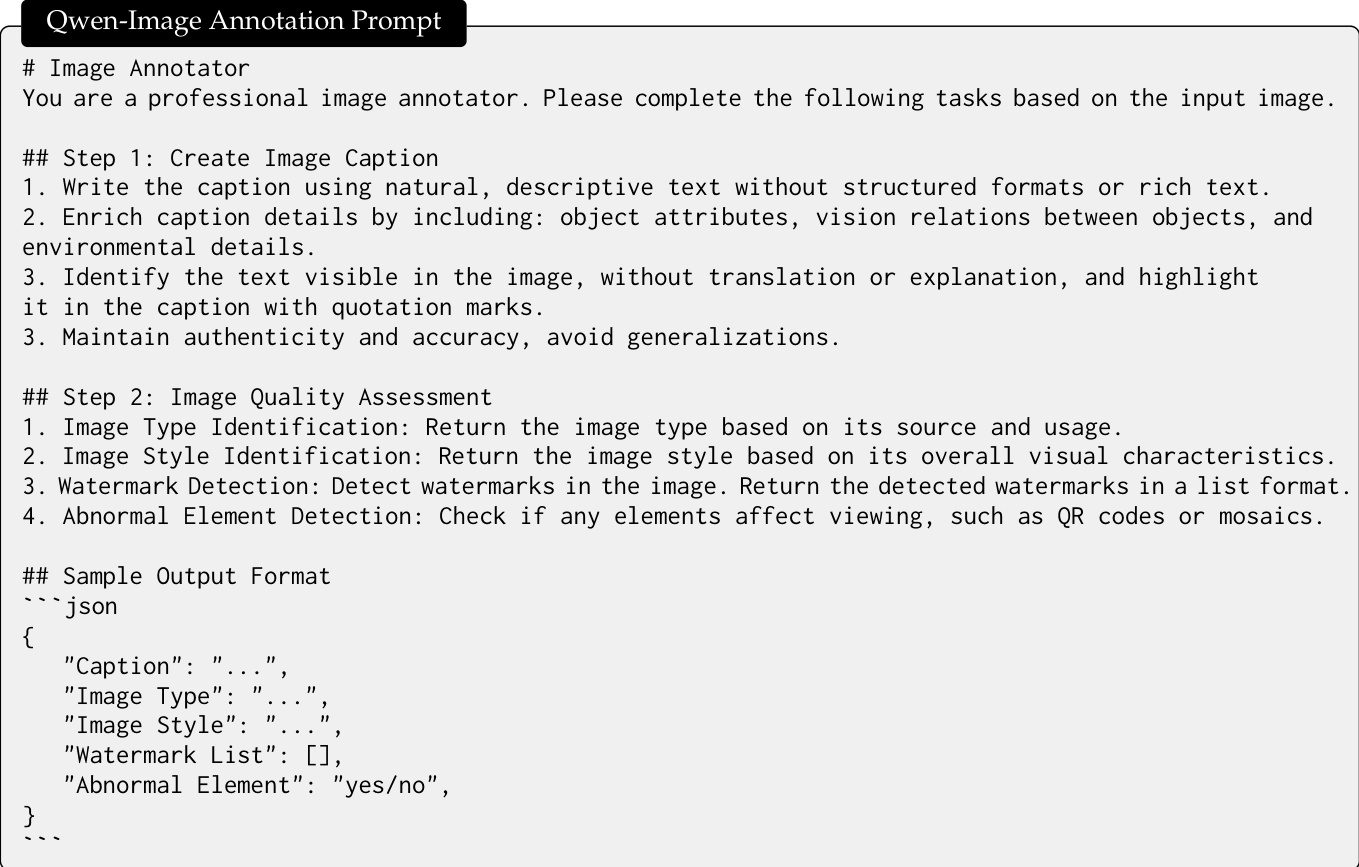

- 元数据通过结构化标注框架(如Qwen2.5-VL)单次生成,包含对象属性、空间关系、可见文本、图像类型、风格、水印或异常等JSON格式信息。

- 模型采用分阶段训练策略:

- 初始预训练使用256p数据,经过阶段1–3过滤。

- 高分辨率训练使用640p与1328p数据,进入阶段7,支持多尺度学习。

- 监督微调(SFT)使用人工标注的高质量、逼真图像与详细提示,提升真实感与细粒度细节生成能力。

- 分层分类体系确保类别间数据分布均衡,重采样策略缓解文本渲染中的长尾问题。

- 合成数据中未使用任何AI生成图像;所有合成内容均通过受控文本渲染技术生成,以保证保真度并避免幻觉。

方法

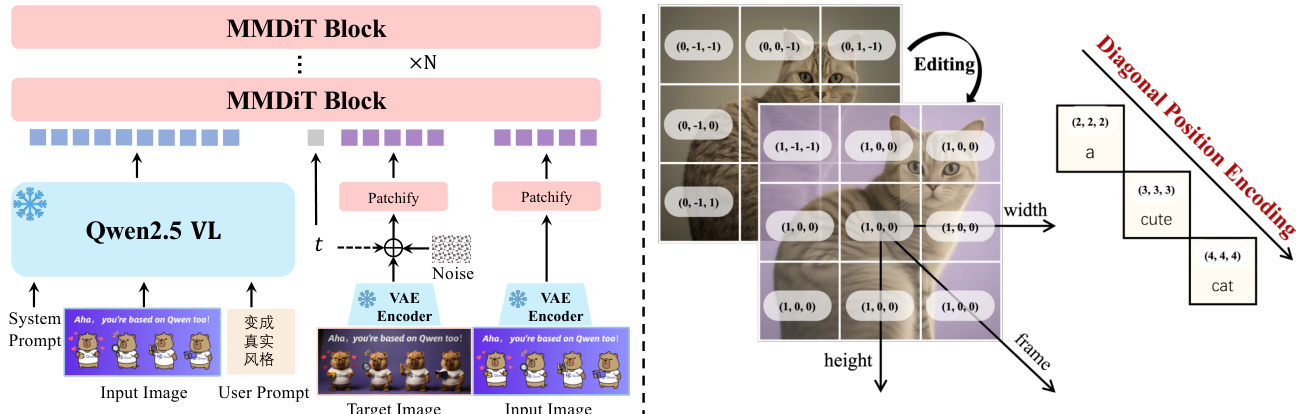

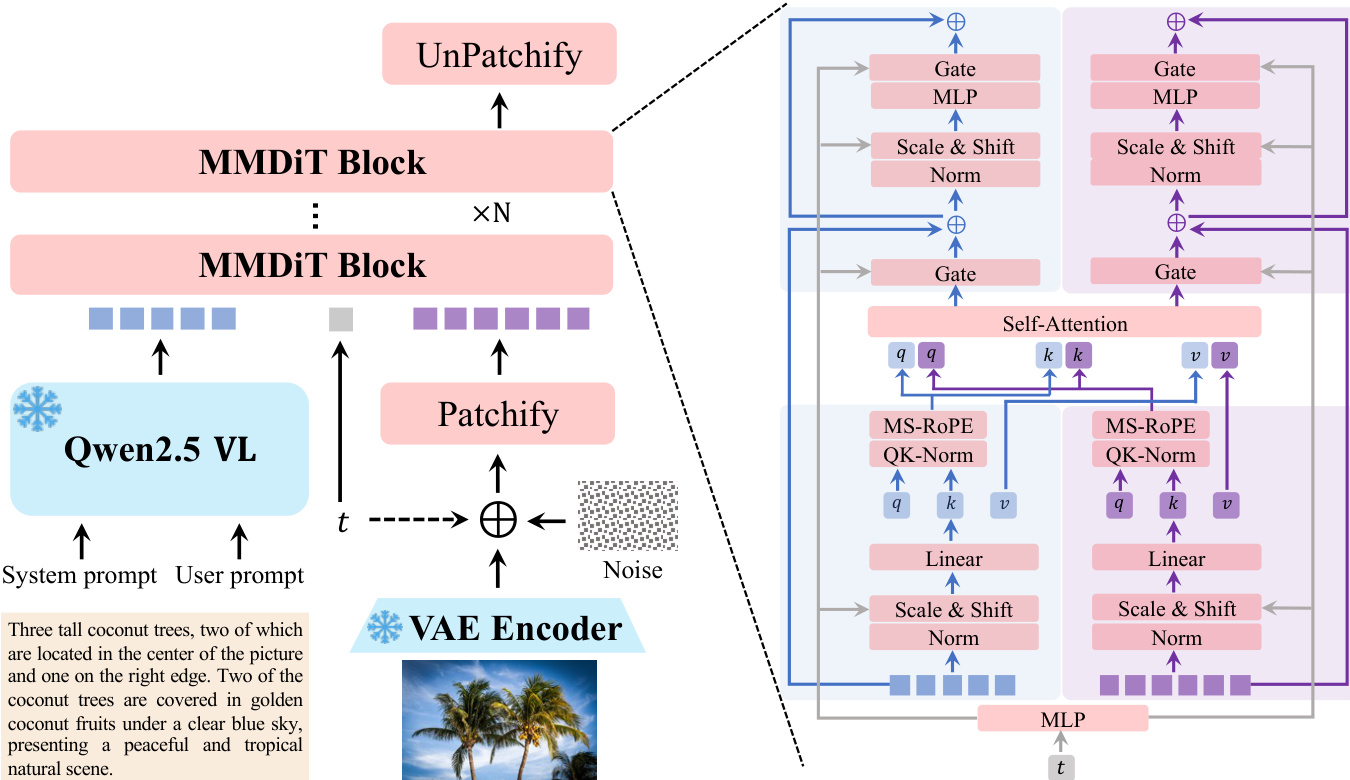

Qwen-Image模型基于三组件架构,旨在实现高保真文本到图像生成与精确图像编辑。该框架整合了多模态大语言模型(MLLM)、变分自编码器(VAE)与多模态扩散Transformer(MMDiT),通过文本与视觉输入引导图像处理与生成。如框架图所示,Qwen2.5-VL模型作为条件编码器,从文本输入中提取特征。这些特征用于条件化MMDiT,后者建模噪声与图像隐变量之间的联合分布。VAE作为图像分词器,将输入图像压缩为紧凑的隐表示,用于推理过程中的编码与解码。MMDiT处理结合后的文本与图像隐表示,生成最终输出图像。

Qwen2.5-VL模型被用作文本输入的特征提取模块,因其具备对齐的语言与视觉空间、强大的语言建模能力以及对多模态输入的支持。针对不同任务,设计了不同的系统提示以引导模型。在文本到图像生成任务中,系统提示模板如图所示,用户提示被嵌入结构化格式中,为模型提供清晰指令。

VAE旨在提供高质量图像表示,尤其注重小文本与细粒度细节的重建保真度。模型采用单编码器、双解码器架构,共享编码器兼容图像与视频,而各模态使用独立解码器。图像解码器在内部文本丰富图像语料库上进行微调,以提升小文本渲染效果。训练过程结合重建损失与感知损失,动态调整二者比例,以避免网格伪影并提升视觉质量。

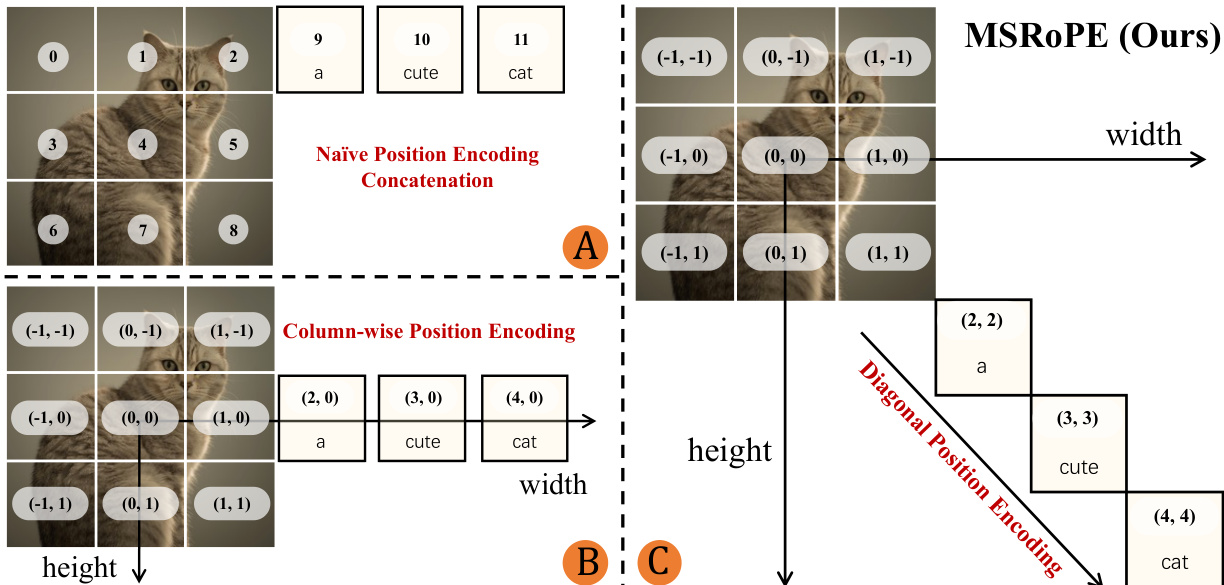

MMDiT作为骨干扩散模型,联合建模文本与图像。MMDiT模块的关键创新是引入多模态可扩展RoPE(MSRoPE),一种新型位置编码方法,旨在解决文本-图像联合位置编码的挑战。如图所示,MSRoPE将文本输入视为二维张量,两个维度应用相同的位置ID,将文本概念化为沿图像网格对角线拼接。该设计在图像侧实现分辨率扩展优势,同时在文本侧保持与1D-RoPE的功能等价性,从而提升文本-图像对齐效果。

Qwen-Image的训练过程分为多个阶段,逐步提升数据质量、图像分辨率与模型性能。预训练阶段采用流匹配目标,通过常微分方程实现稳定的学习动态。模型在每个时间步预测中间隐变量的目标速度,损失函数定义为预测速度与真实速度之间的均方误差。训练策略包括:从低分辨率到高分辨率提升、从无文本到有文本的文本渲染整合、从海量到精炼的数据质量优化、从不平衡到平衡的数据分布均衡,以及从真实世界到合成数据的增强。

后训练阶段包含两个阶段:监督微调(SFT)与强化学习(RL)。RL阶段采用两种不同策略:直接偏好优化(DPO)与组相对策略优化(GRPO)。DPO适用于大规模离线偏好学习,因其可扩展性与计算效率高;GRPO则用于小范围精细优化。GRPO算法基于优势函数构建训练目标,该函数为生成图像奖励与一组图像平均奖励之间的归一化差值。训练目标包含裁剪项以确保策略更新稳定,并包含KL散度项以对齐参考策略。

模型还支持多任务训练,不仅涵盖传统的文本到图像(T2I)与文本-图像到图像(T12I)任务,还包括图像到图像(I2I)重建。该多任务范式对齐了Qwen2.5-VL与MMDiT之间的隐表示,提升图像编辑一致性。双编码机制将原始图像分别输入Qwen2.5-VL与VAE编码器,使编辑模块在语义一致性和视觉保真度之间取得平衡。图像编辑任务的系统提示设计可同时处理图像与文本输入,输入图像的视觉块由视觉Transformer编码,并与文本标记拼接。输入图像的VAE编码隐表示也输入图像流,以维持结构一致性。为区分多张图像,MSRoPE通过引入额外的帧维度进行扩展。

实验

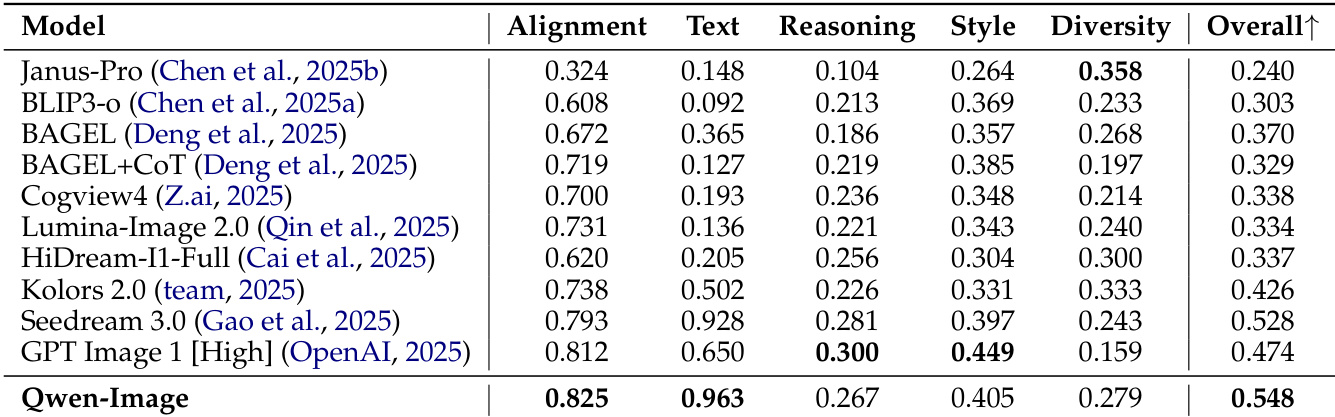

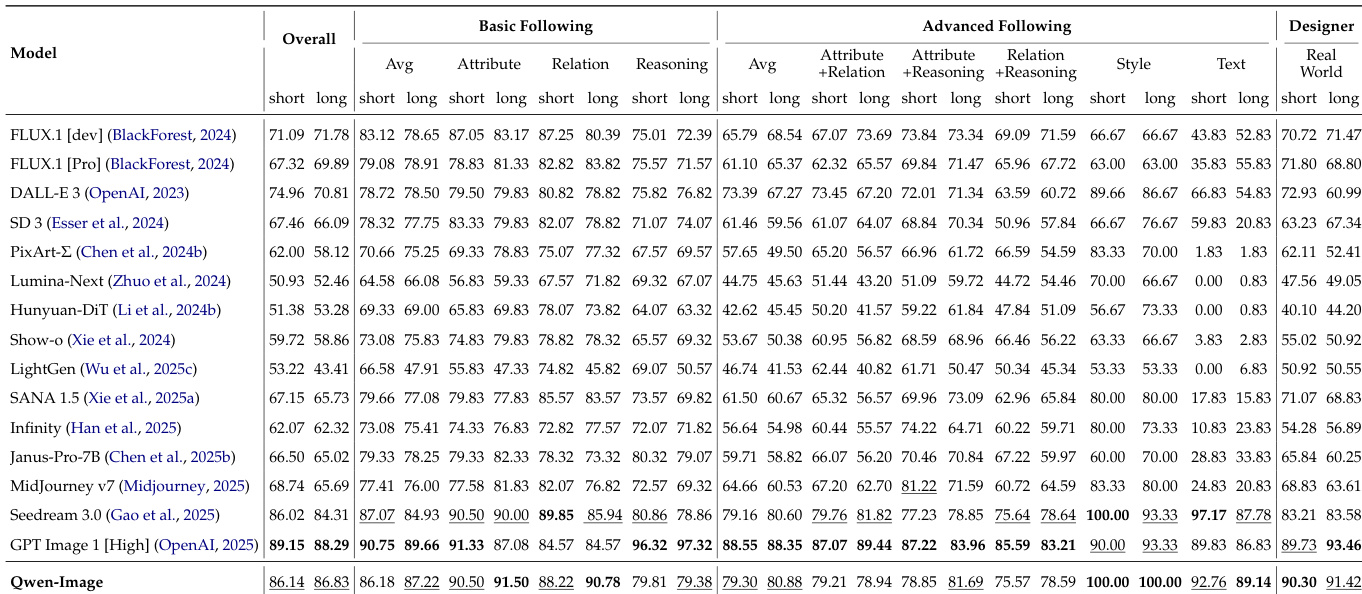

- 在AI Arena的人类评估中,Qwen-Image在五款主流闭源API中排名第三,相比GPT Image 1 [High]和FLUX.1 Kontext [Pro]领先30 Elo分,仅落后于Imagen 4 Ultra Preview 0606 30 Elo分,验证了其强大的开源竞争力。

- 在ImageNet-1k与文本丰富语料库上的VAE重建任务中,Qwen-Image-VAE达到最先进PSNR与SSIM分数,仅需19M编码器与25M解码器参数,表明其具备高重建质量与计算效率。

- 在文本到图像生成任务中,Qwen-Image在DPG、OneIG-Bench(中英文)上取得最高总分,在TIIF Bench上排名第二,优于主流模型在提示遵循与文本渲染方面的表现。

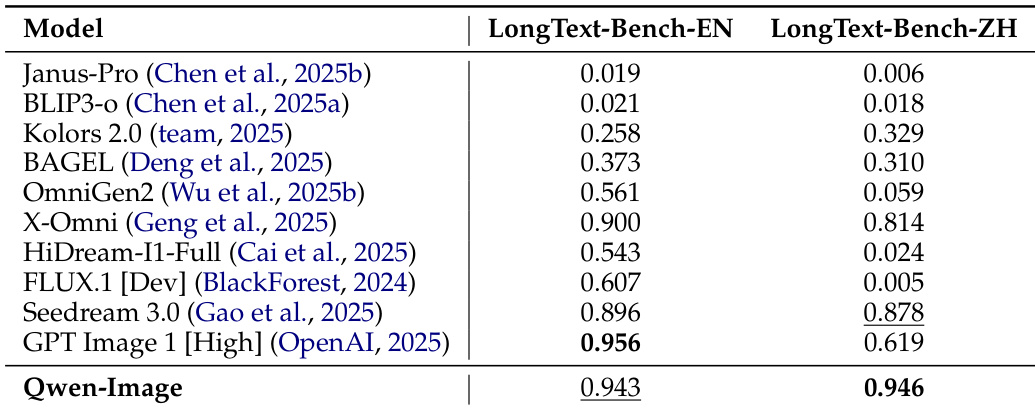

- 在中文文本渲染方面,Qwen-Image在新推出的ChineseWord基准测试中,于所有三个难度级别均取得最高准确率,并在LongText-Bench上领先,展现卓越的多语言与长文本处理能力。

- 在图像编辑任务中,Qwen-Image在GEdit-Bench与ImgEdit上排名第一,擅长新视角合成(GSO数据集),并在NYUv2、KITTI、ScanNet、DIODE与ETH3D上的深度估计任务中达到最先进水平,展现出强大的空间推理与泛化能力。

- 定性结果证实,Qwen-Image在复杂文本渲染(中英文)、多对象生成、空间关系建模、姿态操控与链式编辑方面表现卓越,始终忠实于提示要求,并具备更优的细节保留能力。

结果表明,Qwen-Image在DPG基准上取得最高总分,尤其在提示遵循方面表现突出,尤其在属性解析与其他提示要素理解方面。其在OneIG-Bench的Alignment与Text类别中排名第一,展现出强大的通用生成与文本渲染能力。

结果表明,Qwen-Image在LongText-Bench上取得最高准确率,英文得分为0.943,中文得分为0.946,两项均超越所有其他模型,证明其在长文本渲染方面显著优于当前最先进模型。

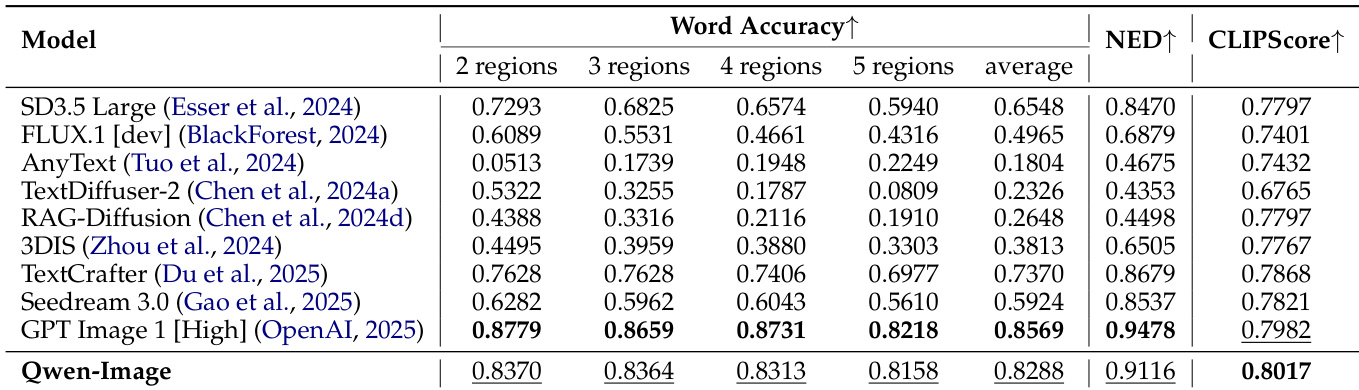

结果表明,Qwen-Image在所有区域数量与平均值上均取得最高单词准确率,超越所有对比模型。其在NED与CLIPScore上也取得最佳表现,证明其在CVTG-2K基准上英文文本渲染的卓越性能。

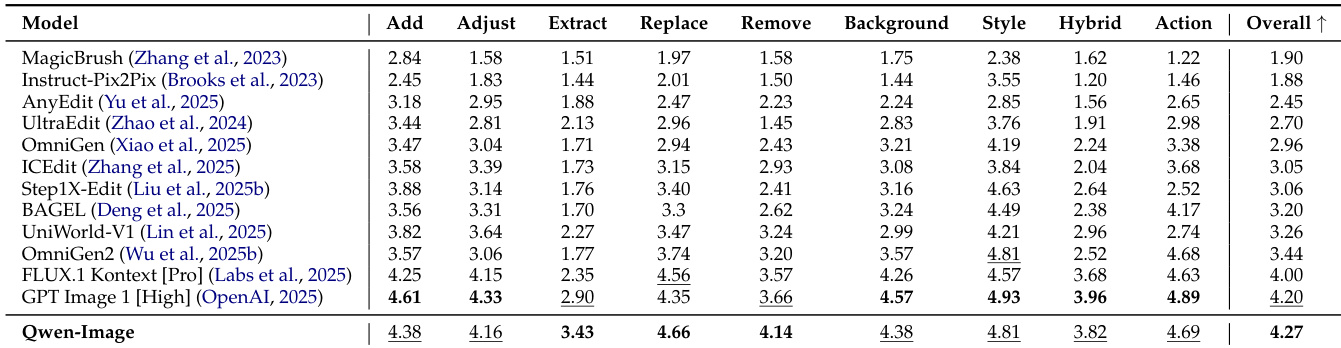

作者在GEdit-Bench上评估Qwen-Image的图像编辑能力,与多个最先进模型在多项编辑任务中进行对比。结果表明,Qwen-Image在总分上最高,中英文榜单均全面领先,展现出强大的编辑能力与对多语言用户指令的泛化能力。

结果表明,Qwen-Image在OneIG-Bench上取得最高总分0.548,中英文赛道均超越所有其他模型。其在Alignment与Text类别中排名第一,展现出卓越的提示遵循与文本渲染能力。