Command Palette

Search for a command to run...

Hunyuan-GameCraft:基于混合历史条件的高动态交互式游戏视频生成

Hunyuan-GameCraft:基于混合历史条件的高动态交互式游戏视频生成

摘要

基于扩散模型的可控视频生成技术近年来取得显著进展,实现了高质量且时间上连贯的视频合成,为沉浸式交互式游戏体验奠定了基础。然而,现有方法在动态表现、泛化能力、长期一致性以及生成效率方面仍存在局限,制约了多样化游戏内容视频的生成能力。为解决上述问题,我们提出 Hunyuan-GameCraft——一种面向游戏环境的高动态交互式视频生成新框架。为实现细粒度的动作控制,我们创新性地将标准键盘与鼠标输入统一映射至共享的相机表征空间,从而支持不同相机视角与运动操作之间的平滑插值。在此基础上,我们设计了一种混合历史条件化训练策略,能够在自回归生成过程中有效延长视频序列,同时完整保留游戏场景的上下文信息。为进一步提升推理效率与可玩性,我们引入模型蒸馏技术,在显著降低计算开销的同时,保障长时序视频生成的一致性,使其适用于复杂交互环境下的实时部署。该模型在包含超过一百万条来自100余款AAA级游戏的 gameplay 录制数据的大规模数据集上进行预训练,确保了广泛的覆盖范围与多样性;随后在精心标注的合成数据集上进行微调,进一步提升了生成精度与动作可控性。经过筛选与优化的游戏场景数据显著增强了生成视频的视觉保真度、真实感以及动作响应的准确性。大量实验结果表明,Hunyuan-GameCraft 在多项指标上显著优于现有模型,大幅提升了交互式游戏视频生成的逼真度与可玩性,为下一代沉浸式游戏内容生成技术提供了有力支撑。

一句话摘要

腾讯混元与华中科技大学的研究者提出 Hunyuan-GameCraft,一种基于扩散模型的框架,将键盘/鼠标输入统一映射到共享的相机空间以实现细粒度动作控制,采用混合历史条件训练策略保障长期时空一致性,并通过模型蒸馏实现高效实时部署,从而在多样化的AAA游戏环境中,仅凭单张图像和提示即可生成高动态、逼真的交互式游戏视频。

主要贡献

- Hunyuan-GameCraft 通过将离散的键盘与鼠标输入统一到共享的连续相机表示空间,解决了生成高动态、时序连贯且可控制的游戏视频的挑战,实现了细粒度插值与物理上合理的运动及相机控制。

- 该框架提出一种混合历史条件训练策略,在去噪框架中融合单帧、先前片段与更长段落等多种历史上下文类型,实现自回归式视频序列扩展,同时利用掩码指示器缓解长期生成中的误差累积,保持场景一致性。

- 在超过一百万条来自100+款AAA游戏的 gameplay 录制数据上训练,并在合成标注数据集上微调,Hunyuan-GameCraft 实现了卓越的视觉保真度与动作可控性,结合模型蒸馏技术,支持高效实时推理,适用于交互式游戏环境。

引言

研究者利用基于扩散模型的视频生成最新进展,应对日益增长的高动态、交互式游戏内容需求,其中实时响应性、长期一致性与物理合理性对沉浸式体验至关重要。以往工作在长时间序列中难以维持时序连贯性,自回归生成过程易导致误差累积引发质量下降,且常缺乏对多样化用户输入的高效整合。为克服这些挑战,研究者提出 Hunyuan-GameCraft,一种新颖框架,将离散的键盘与鼠标操作统一映射至连续动作空间,实现细粒度、物理合理的控制。他们提出一种混合历史条件训练策略,在去噪框架中结合单帧、前序片段与长段落等多种历史上下文类型,实现稳定、长时视频生成并具备强时空一致性。此外,通过模型蒸馏加速推理,使系统适用于实时交互部署。该方法在动作可控性与长期视频保真度方面均达到当前最优水平。

数据集

- 数据集构建于100+款AAA游戏之上,涵盖《刺客信条》《荒野大镖客:救赎》《赛博朋克2077》等知名作品,确保高视觉保真度与复杂的游戏内交互。

- 每段 gameplay 录制时长为2–3小时,被处理为6秒连贯视频片段,分辨率为1080p,总计超过100万条片段。

- 采用两级划分策略:使用 PySceneDetect 进行场景级分割,利用 RAFT 推导的光流梯度检测动作级边界,以识别瞄准等快速动作。

- 数据过滤通过多种方法剔除低质量内容:质量评估、基于 OpenCV 的亮度过滤(排除暗场景),以及基于视觉语言模型(VLM)的梯度分析,实现多视角鲁棒过滤。

- 交互标注通过 Monst3R 重建6自由度相机轨迹,捕捉每帧的详细平移与旋转运动,支持视频生成中的精确视角控制。

- 结构化标注采用游戏特定的视觉-语言模型,为每段视频生成两类描述:短摘要(≤30字符)与详细描述(>100字符),训练时随机采样。

- 数据集在训练中以视频片段与文本描述混合使用,处理后的片段及其对应标注被组合,支持端到端的相机控制视频生成。

方法

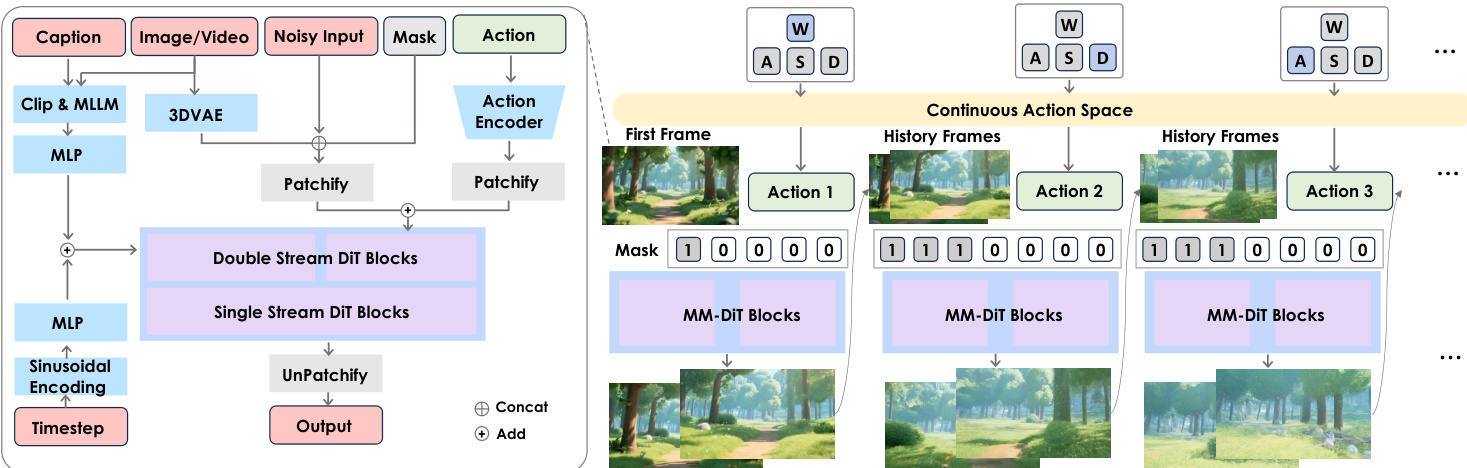

研究者基于开源的 MM-DiT 架构的 HunyuanVideo 模型,构建 Hunyuan-GameCraft,一个专为游戏环境中高动态交互视频生成设计的系统。整体架构集成多个模块,以实现细粒度控制、长期时序连贯性与高效推理。框架从原始 gameplay 视频数据开始,经过场景与动作划分,提取相关视觉与控制信号。这些信号经质量过滤去除低质片段,并标注结构化文本与交互信息。处理后的数据用于训练一个融合图像、视频与动作输入的模型。

参考框架图以理解整体数据流与模块交互。模型核心基于双流 DiT 架构,分别处理图像/视频与动作输入,再进行融合。图像与视频数据首先通过 3DVAE 编码,而由键盘与鼠标输入生成的动作信号则由轻量级动作编码器处理。两个编码流随后被分块处理,并通过可学习缩放系数融合,确保特征融合稳定。融合特征输入双流 DiT 块与单流 DiT 块,执行去噪过程。模型还引入时间步的正弦编码,以及多层感知机(MLP)处理文本与片段信息。最终输出通过 UnPatchify 层生成。

为实现细粒度动作控制,研究者将标准键盘与鼠标输入统一映射至共享的连续相机表示空间。该空间记为 A,定义为相机参数子集 C⊆Rn,设计为直观且连续。动作空间由平移方向 dtrans∈S2、旋转方向 drot∈S2、平移速度 α∈[0,vmax] 与旋转速度 β∈[0,ωmax] 参数化。该表示支持对相机运动与朝向的精确控制,符合常见游戏操作习惯。动作编码器为轻量级网络,由卷积与池化层构成,将离散的键盘/鼠标信号转换为该连续空间。生成的相机姿态信息通过令牌添加策略注入模型,双轻量级可学习令牌化器实现视频与动作令牌间的高效融合。

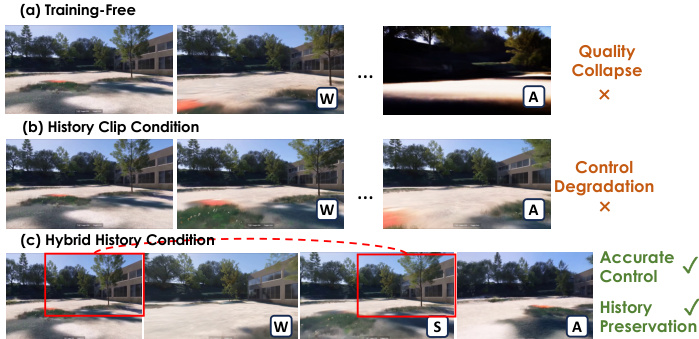

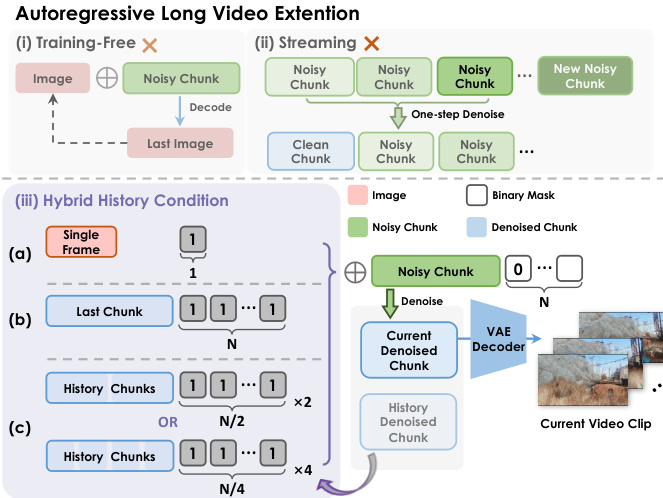

为支持长视频生成,模型采用混合历史条件训练策略。该方法通过自回归方式扩展视频序列,基于先前去噪的历史片段去噪新的噪声潜在块。该方法使用可变掩码指示器,其中1表示历史帧,0表示预测帧,引导去噪过程。该混合条件确保模型在生成新内容时保留历史场景信息,维持时序连贯性与动作可控性。研究者将该方法与无训练推理和流式生成进行对比,证明混合历史条件能有效防止质量退化与控制性能下降。

为提升推理效率与可玩性,研究者基于相位一致性模型(PCM)实现模型蒸馏。该技术将原始扩散过程与无分类器引导压缩为紧凑的八步一致性模型,实现推理速度10–20倍加速。蒸馏过程进一步通过无分类器引导蒸馏(Classifier-Free Guidance Distillation)优化,训练学生模型直接生成引导输出,无需依赖外部引导机制。该蒸馏的目标函数旨在最小化学生模型与教师模型输出之间的差异,实现6.6帧/秒的实时渲染速率。该加速对实现低延迟的交互式游戏体验至关重要。

实验

- Hunyuan-GameCraft 通过在192块 H20 GPU 上进行全参数训练,验证其在图像到视频生成与长视频扩展中的有效性,采用两阶段策略,结合混合历史条件(0.7单片段、0.05多片段、0.25单帧)与数据增强,以平衡动作分布。

- 在包含150张图像与12种动作信号的多样化测试集上,Hunyuan-GameCraft 在多项指标上达到最先进水平:动态性能(Dynamic Average)显著优于 Matrix-Game,跨域测试中交互错误降低55%,并提升时序一致性和视觉质量。

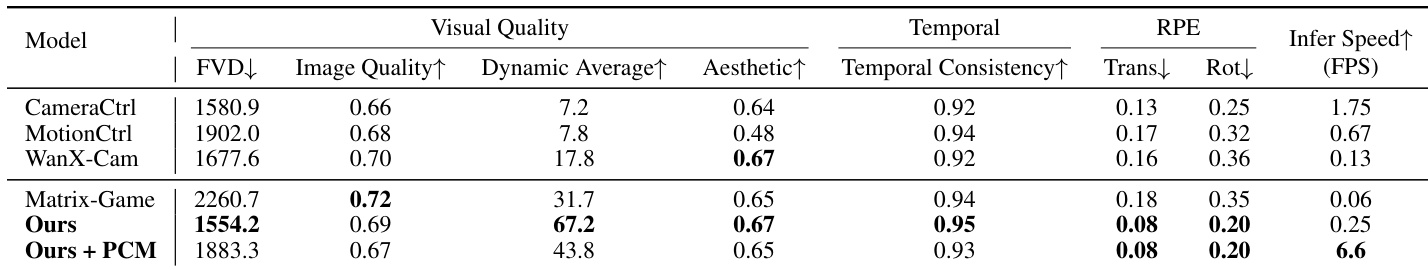

- 定量结果(表2)显示,Hunyuan-GameCraft 在 FVD、RPE trans/rot、图像质量、美学评分与时序一致性等指标上均超越基线模型 CameraCtrl、MotionCtrl、WanX-Cam 与 Matrix-Game。

- 用户研究(表3)证实其用户偏好显著更优,视觉质量与交互准确性两项指标均获得最高平均评分(5/5)。

- 消融研究(表4)表明,混合历史条件在交互准确率与长期一致性间取得良好平衡,令牌添加策略在低开销下实现最优控制注入性能,游戏与合成数据的均衡训练确保了鲁棒的动态与交互能力。

- 模型可泛化至真实场景,从真实图像生成高保真、高动态视频并实现精准相机控制(见图10),支持长达数分钟的视频扩展且保持一致质量(见图8)。

结果表明,Hunyuan-GameCraft 在动态能力与时序一致性方面表现最佳,动态平均得分为67.2,时序一致性得分为0.95,同时将 Fréchet Video Distance 降低至1554.2。该方法在交互控制准确率与视觉质量上全面超越所有基线,结合 PCM 后推理速度进一步提升至6.6 FPS。

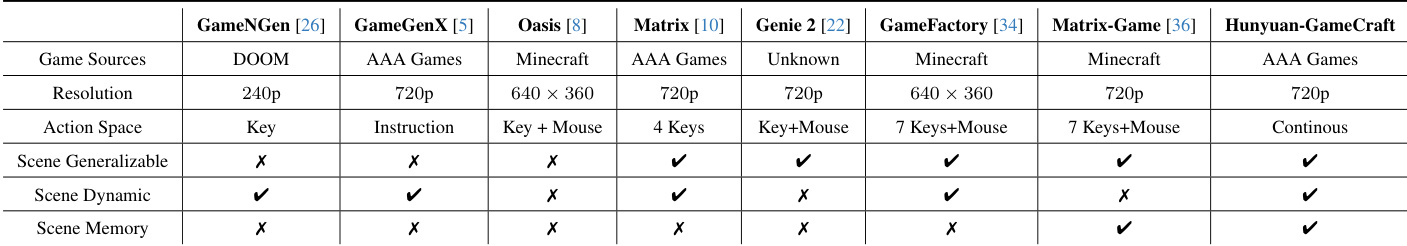

研究者将 Hunyuan-GameCraft 与多个基线在多个维度进行对比,包括游戏来源、分辨率、动作空间与场景泛化能力。结果表明,Hunyuan-GameCraft 在场景泛化能力、场景动态性与场景记忆方面表现最优,支持连续动作空间,并在720p分辨率下运行。

结果表明,Hunyuan-GameCraft 在多项指标上全面超越所有基线,各项得分最高,涵盖视频质量、时序一致性、运动平滑性、动作准确率与动态能力。研究者采用混合历史条件与优化训练策略,显著提升交互控制与长期视频生成性能,优于现有方法。

研究者开展消融实验,评估不同数据分布与条件策略对模型性能的影响。结果表明,仅在合成数据上训练虽能获得高美学质量与交互准确率,但显著降低动态能力;而仅使用真实 gameplay 数据虽提升动态性能,却牺牲交互准确率。所提出的混合方法结合两类数据,并融合图像与片段条件,实现最佳整体平衡,获得最高美学评分与各项指标的竞争力表现。