Command Palette

Search for a command to run...

自强制:弥合自回归视频扩散模型在训练与测试之间的差距

自强制:弥合自回归视频扩散模型在训练与测试之间的差距

Huang Xun Li Zhengqi He Guande Zhou Mingyuan Shechtman Eli

摘要

我们提出了一种名为自强制(Self Forcing)的新型训练范式,用于自回归视频扩散模型。该方法有效解决了长期存在的暴露偏差(exposure bias)问题:在训练阶段,模型依赖真实上下文帧进行学习,但在推理阶段却需基于自身生成的不完美输出来逐帧生成序列。与以往方法——即基于真实上下文帧对后续帧进行去噪——不同,Self Forcing在训练过程中通过键值(Key-Value, KV)缓存机制实现自回归滚动生成,使每一帧的生成均依赖于先前由模型自身生成的输出。这一策略使得模型能够通过视频级整体损失函数获得监督信号,从而直接评估整个生成序列的质量,而非仅依赖传统的逐帧损失目标。为保障训练效率,我们采用短步数扩散模型,并结合随机梯度截断策略,在计算成本与生成性能之间实现了有效平衡。此外,我们进一步引入滚动KV缓存机制,显著提升了自回归视频外推的效率。大量实验表明,该方法可在单张GPU上实现实时流式视频生成,延迟低于一秒钟,同时生成质量与显著更慢、且非因果(non-causal)的扩散模型相当,甚至更优。项目主页:http://self-forcing.github.io/

一句话总结

Adobe Research 与德克萨斯大学奥斯汀分校的作者提出 Self Forcing,这是一种自回归视频扩散模型的训练范式,通过使用带有 KV 缓存的自回归滚动生成,使帧生成基于自生成输出进行条件化,从而通过实现全局视频级监督克服暴露偏差;该方法在单张 GPU 上实现了亚秒级延迟的实时流式视频生成,生成质量与更慢的非因果模型相当或更优。

主要贡献

- Self Forcing 提出了一种新颖的自回归视频扩散模型训练范式,通过在训练期间执行自回归自滚动,直接解决暴露偏差问题,其中每一帧都基于先前生成的帧进行条件化,而非真实上下文,从而对齐训练与推理分布。

- 该方法利用全局分布匹配损失(如 SiD、DMD、GAN)作用于完整生成的视频序列,使模型能够从自身预测误差中学习并纠正,有效缓解误差累积,提升长期时间连贯性。

- 通过采用几步扩散主干网络和随机梯度截断,Self Forcing 在单张 H100 GPU 上实现了 17 FPS 的实时视频生成,亚秒级延迟,生成质量与更慢的非因果扩散模型相当或更优,同时通过滚动 KV 缓存实现高效的自回归外推。

引言

自回归(AR)视频扩散模型通过逐帧生成,实现了实时、交互式视频生成,这对直播、游戏和机器人等应用至关重要。然而,这些模型通常存在暴露偏差问题——训练时使用真实上下文帧,而推理时依赖自身噪声预测,导致误差累积和质量下降。先前方法如教师强制(Teacher Forcing)和扩散强制(Diffusion Forcing)试图对齐训练与推理,但仍无法弥合训练-测试分布差距,因为它们要么使用完美上下文,要么以不反映实际自回归滚动的方式使用噪声上下文。作者提出 Self Forcing,一种新颖的训练范式,在训练期间执行自回归自滚动,其中每帧基于先前生成的帧进行去噪,而非真实数据。这迫使模型从自身错误中学习,并支持在完整生成视频上使用全局分布匹配损失(如 SiD、DMD),对齐训练与推理分布。尽管自滚动具有顺序性,该方法通过梯度截断和滚动 KV 缓存,在后训练阶段高效实现,单张 H100 GPU 上达到 17 FPS 的实时生成,且生成质量优于先前模型。

方法

作者采用基于 Transformer 的自回归视频扩散模型架构,将自回归模型的链式分解与去噪扩散过程相结合,以生成视频序列。视频序列 x1:N 的联合分布被分解为 p(x1:N)=∏i=1Np(xi∣x<i),其中每个条件分布 p(xi∣x<i) 均通过扩散过程建模。该过程通过逐步去噪初始高斯噪声来生成帧,条件为先前生成的帧。模型在由因果 3D 变分自编码器(VAE)编码的压缩潜在空间中运行,并通过因果注意力机制实现自回归分解。所提方法的核心创新——Self Forcing——在于其训练范式,直接解决了标准训练方法固有的暴露偏差问题。

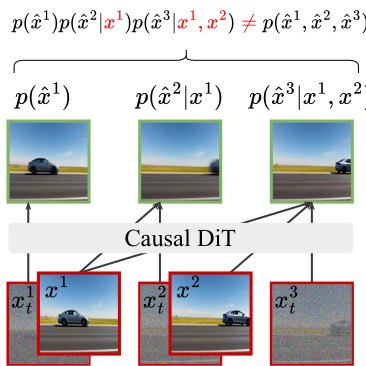

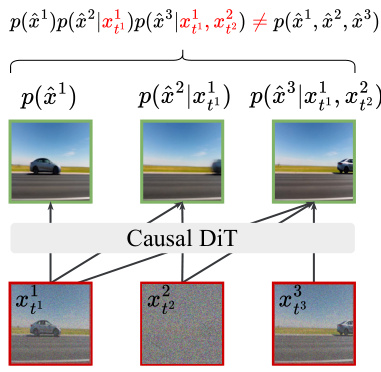

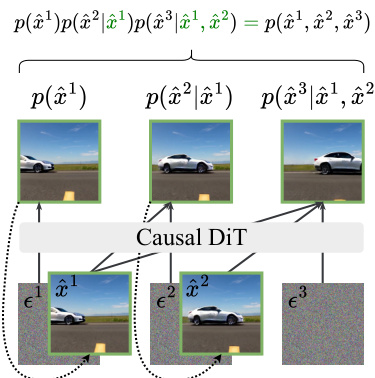

标准训练范式,即教师强制(TF)和扩散强制(DF),在并行模式下训练整个视频,使用自定义注意力掩码强制因果依赖。在 TF 中,模型被训练为在干净的真实上下文帧 x<i 条件下对每帧进行去噪。在 DF 中,上下文由噪声帧 xtjj<i 构成,模型被训练为预测每帧添加的噪声。两种方法均使用帧级均方误差(MSE)损失,以最小化预测噪声与真实噪声之间的差异。相比之下,Self Forcing 训练方法在训练中创新性地使用键值(KV)缓存,以模拟自回归推理过程。如图所示,该方法使每帧的生成基于先前自生成的输出进行条件化,从而在视频层面实现全局损失。

为使该方法在计算上可行,作者采用几步扩散模型来近似每个条件分布 ptheta(xi∣x<i)。这涉及一个截断的去噪过程,模型从噪声输入开始执行有限次数的去噪步骤。模型的分布被隐式定义为这些少数去噪步骤的组合。为进一步降低计算成本和内存消耗,采用随机梯度截断策略。该策略仅将反向传播限制在每帧的最终去噪步骤,并为每个训练样本随机采样一个去噪步骤 s 从 [1,T],确保所有中间步骤均获得监督。此外,限制梯度流入 KV 缓存嵌入,防止当前帧的梯度影响先前帧。

训练过程通过使用全局视频级分布匹配损失进一步增强,以对齐生成视频序列 ptheta(x1:N) 与数据分布 ptextdata(x1:N)。这通过向两个分布注入噪声并匹配其噪声版本来实现。作者考虑三种方法:分布匹配蒸馏(DMD)、得分恒等蒸馏(SiD)和生成对抗网络(GAN)。这些方法最小化分布之间的不同散度度量,如反向 Kullback-Leibler 散度、Fisher 散度或 Jensen-Shannon 散度。这种全局方法从根本上改变了训练动态,通过从模型自身分布 ptheta 中采样上下文帧,有效解决暴露偏差问题,并迫使模型从自身缺陷中学习。

自回归模型的一个关键优势是能够生成任意长度的视频。为实现高效长视频生成,作者提出滚动 KV 缓存机制。该机制维护一个固定大小的 KV 缓存,存储最近 L 帧的 KV 嵌入。在生成新帧时,最旧的 KV 缓存条目被移除,再添加新条目,从而实现无限帧生成,时间复杂度为 O(TL)。该方法避免了先前方法中需要重新计算 KV 缓存的开销,支持更高效的外推。为缓解因分布不匹配引起的闪烁伪影,作者在训练中限制注意力窗口,使模型在去噪最后一块时无法关注第一块,模拟长视频生成条件。整体训练与推理过程分别在算法 1 和算法 2 中详细说明。

实验

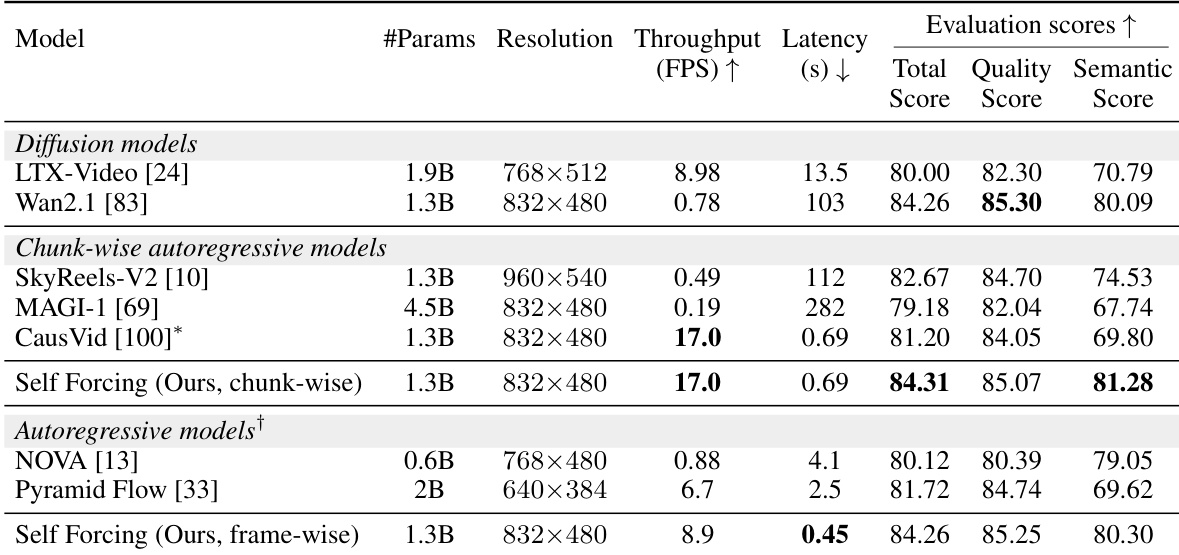

- 在视频生成质量、实时性能和效率方面,对 Self Forcing 的分块和帧级自回归变体进行了评估。分块变体实现 17.0 FPS 吞吐量,亚秒级延迟,速度和质量均超越扩散基线。

- 在 VBench 基准测试中,Self Forcing 在所有维度上均取得最高分,尤其在语义对齐(场景、物体类别、人类动作)和帧级质量(美学与成像质量)方面表现优异,帧级变体展现出更动态的运动,但时间一致性略低。

- 用户偏好研究表明,Self Forcing 持续优于所有基线,包括初始化模型 Wan2.1-1.3B,展现出更优的视觉质量和提示对齐能力。

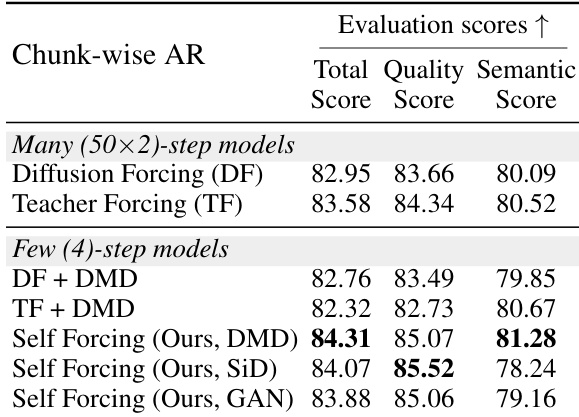

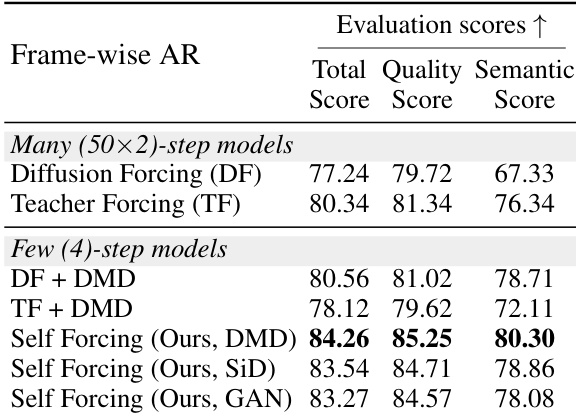

- 消融研究证实,Self Forcing 在不同分布匹配目标(DMD、SiD、GAN)下均优于教师强制、扩散强制和 CausVid 类方法,在分块和帧级设置中均保持稳定性能,尽管面临误差累积挑战。

- 滚动 KV 缓存结合局部注意力训练有效缓解了视频外推过程中的视觉伪影,同时保持高吞吐量(16.1 FPS)。

- Self Forcing 训练计算高效,在 64 张 H100 GPU 上约 1.5 小时收敛,由于优化的注意力核和高 GPU 利用率,在相同墙钟时间预算下,其每迭代速度和质量均优于其他方法。

- 该方法在 DMD/SiD 实现中无需额外视频数据,即可实现自回归视频生成,并支持直播等实时应用。

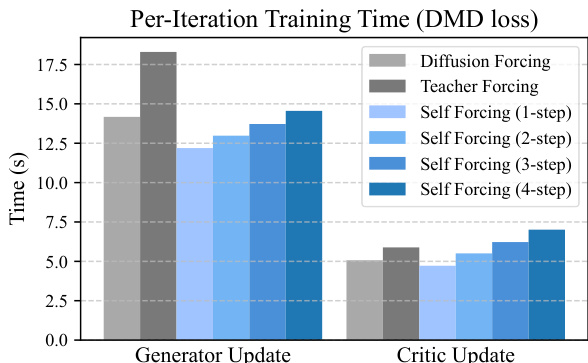

结果表明,Self Forcing 在生成器更新方面与教师强制和扩散强制具有相当的每迭代训练时间,同时在所有变体中保持更低的判别器更新训练时间。Self Forcing 的训练效率归因于其使用全注意力机制和优化核,尽管具有顺序性,仍能实现高 GPU 利用率。

结果表明,采用 DMD 目标的 Self Forcing 模型在所有对比方法中取得最高总分和语义得分,优于所有基于扩散和自回归的基线。Self Forcing 的帧级变体进一步提升了质量指标,尤其在语义对齐方面表现突出,同时在所有评估维度上保持强劲性能。

结果表明,采用 DMD 目标的 Self Forcing 在所有对比模型中取得最高总分、质量分和语义分,优于基于扩散和自回归的基线。Self Forcing 的帧级自回归变体在所有指标上保持强劲表现,同时提供最低延迟,适用于实时应用。

作者使用 Self Forcing 训练自回归视频模型,在所有对比模型中取得最高 VBench 分数和实时吞吐量。结果表明,分块变体实现 17.0 FPS,总分为 84.31,而帧级变体将延迟降低至 0.45 秒,同时保持高质量,支持低延迟应用。

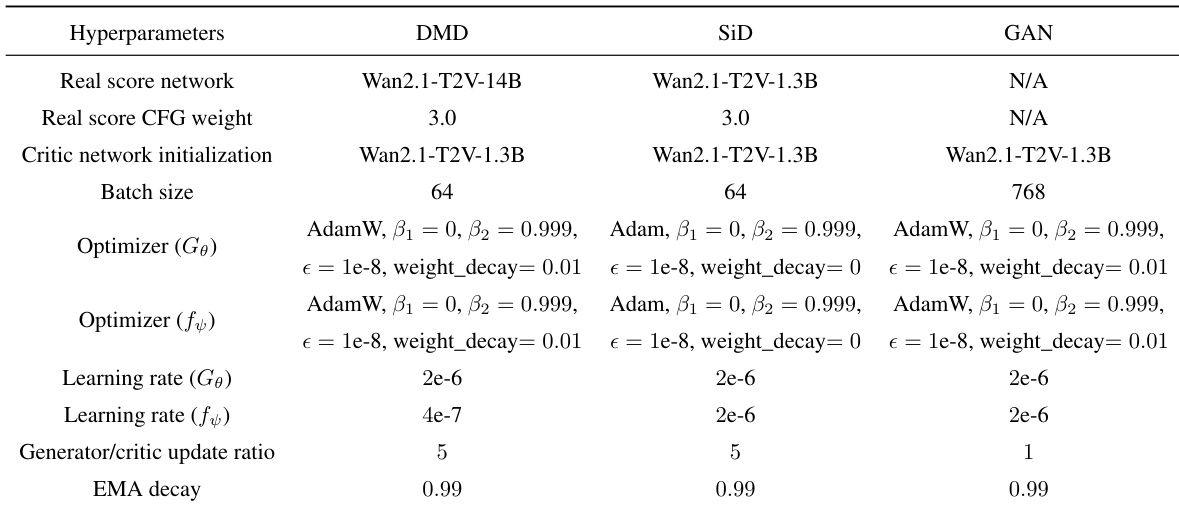

作者在 DMD、SiD 和 GAN 目标之间采用一致的优化设置,使用 AdamW 作为优化器,生成器和判别器网络采用相似的学习率。唯一显著差异是批量大小,GAN 设置为 768,生成器/判别器更新比例在 GAN 中降低至 1,其余超参数保持一致。