Command Palette

Search for a command to run...

EmergentTTS-Eval:基于模型作为裁判的TTS模型复杂韵律、表现力与语言挑战评估

EmergentTTS-Eval:基于模型作为裁判的TTS模型复杂韵律、表现力与语言挑战评估

Manku Ruskin Raj Tang Yuzhi Shi Xingjian Li Mu Smola Alex

摘要

文本到语音(Text-to-Speech, TTS)基准测试通常难以准确反映模型在处理语义复杂、细微差异文本时的实际表现。基于 EmergentTTS,我们提出了 EmergentTTS-Eval——一个全面的TTS评估基准,涵盖六类具有挑战性的语音合成场景:情感表达、副语言特征、外来词、句法复杂性、复杂发音(如URL、公式等)以及疑问句。至关重要的是,我们的评估框架实现了测试用例生成与评估过程的自动化,使基准具备良好的可扩展性。从少量人工编写的种子提示(seed prompts)出发,我们利用大语言模型(LLM)进行迭代扩展,有针对性地生成在结构、语音和语调上具有挑战性的测试样本,最终构建出包含1,645个多样化测试用例的语料库。此外,我们采用“模型作为评判者”(model-as-a-judge)的方法,借助大音频语言模型(Large Audio Language Model, LALM)从多个维度对语音输出进行评估,包括情感表达、语调、语调模式及发音准确性等。我们在 EmergentTTS-Eval 上对当前最先进的开源与商业TTS系统(如11 Labs、Deepgram以及OpenAI的4o-mini-TTS)进行了评估,结果表明该基准能够有效揭示模型之间细微的性能差异。实验表明,“模型作为评判者”的评估方式具有良好的鲁棒性,并与人类偏好呈现高度相关性。我们已将评估代码开源至:https://github.com/boson-ai/EmergentTTS-Eval-public,数据集发布于:https://huggingface.co/datasets/bosonai/EmergentTTS-Eval。

一句话总结

Boson AI 的研究者提出了 EmergentTTS-Eval,一个可扩展的、由大语言模型(LLM)自动构建的基准测试框架,用于在六种细致的场景下评估文本转语音(TTS)系统。该框架采用“模型即裁判”机制,利用大音频语言模型(LALM)对韵律、情感和发音进行评估,与人类偏好高度一致,从而实现对 11Labs 和 OpenAI 的 4o-mini-TTS 等系统进行细粒度比较。

主要贡献

-

EmergentTTS-Eval 引入了一个全面的基准测试,涵盖六种具有挑战性的 TTS 场景——情感、副语言特征、外语词汇、句法复杂性、复杂发音(如 URL、公式)和问题——共包含 1,645 个测试用例,弥补了现有基准在覆盖细微、真实世界语言现象方面的不足。

-

该框架通过基于 LLM 的迭代式优化过程自动化生成测试用例,从种子提示出发,系统性地生成越来越复杂的语音输出,实现了对新兴 TTS 能力的可扩展、可控制评估。

-

它首次将大音频语言模型(LALM)作为“模型即裁判”来评估语音质量,涵盖韵律、情感和发音准确率等主观维度,与人类偏好高度相关,为昂贵的人工评估提供了可复现、可扩展的替代方案。

引言

作者针对现实世界文本转语音(TTS)应用复杂性与现有评估方法局限性之间的日益扩大的差距提出解决方案。现代 TTS 系统被部署于多种高风险场景——如有声书、导航和无障碍工具——要求其能够处理富有情感的语音、句法复杂的句子、语言切换、外语词汇以及副语言线索。然而,以往的评估框架严重依赖小规模、狭窄的人工判断或简单的指标(如 WER 和 SIM),无法捕捉细微的韵律、表现力和语言多样性。这些方法成本高昂、不可复现,且难以应对多语言或情感丰富的文本。

为克服这些挑战,作者提出了 EmergentTTS-Eval,一个可扩展的自动化基准测试,用于在六个关键维度上评估 TTS 系统:情感、副语言特征、句法复杂性、问题、外语词汇和复杂发音。他们利用大音频语言模型(LALM)作为“模型即裁判”,提供一致、可复现且与人类偏好高度相关的主观质量评估(如韵律和表现力)。通过 LLM 驱动的迭代优化,生成日益复杂的语音输入,大规模压力测试 TTS 系统。该方法实现了细粒度、系统化的故障分析,并揭示了开源与闭源模型在处理新兴语言现象时存在显著性能差距。

数据集

-

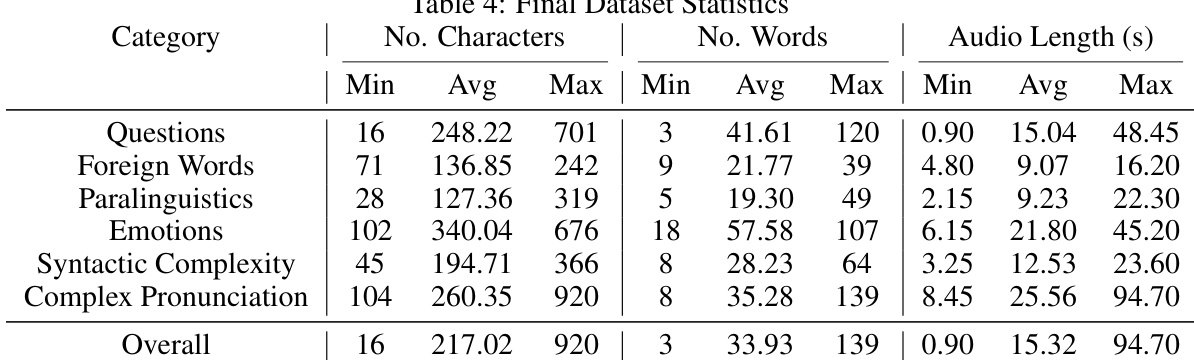

EmergentTTS-Eval 基准测试包含六个具有挑战性的 TTS 类别:问题、情感、副语言特征、外语词汇、句法复杂性和复杂发音。该数据集基于 BASE-TTS 的 140 个由人工精心挑选的种子提示构建,保留了其中五个类别,并新增了“情感”和“复杂发音”两个类别,而“复合名词”和“标点符号”因范围有限或冗余被剔除。

-

对于五个源自 BASE-TTS 的类别,作者从 70 个种子语音(20 个由人工构建 + 50 个由 LLM 扩展以增加广度)出发,通过三次迭代式深度优化步骤(使用 LLM)生成越来越复杂的变体,每个类别最终产出 280 个样本。 “复杂发音”类别则从零开始构建,使用 60 个广度扩展样本,同样经过三步优化,生成 240 个样本。此外,还重复多次使用五个简短的绕口令,以测试重复发音能力。

-

最终数据集包含 1,645 个样本:问题、情感、副语言特征、外语词汇和句法复杂性各 280 个(共 1,400 个),复杂发音 240 个,绕口令 5 个。作者使用该数据集训练和评估 TTS 模型,训练集通过在不同类别间以可变比例混合样本构建,以模拟真实世界的多样性和复杂性。

-

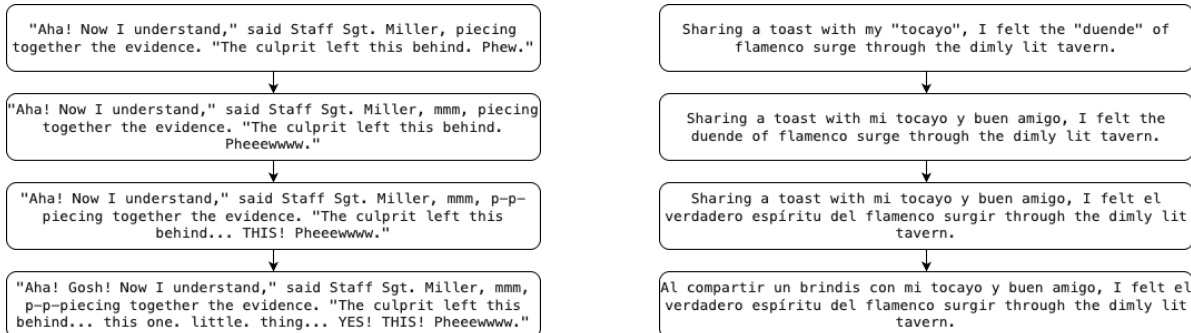

处理流程包括 LLM 驱动的广度扩展和深度优化,每一步优化都系统性地提升复杂度——例如在“外语词汇”中加入语言切换,在“副语言特征”中叠加多层副语言线索,或在“情感”中引入情感弧线。对于“外语词汇”,输出通过 Gemini-2.5-Pro 进行后处理以修正语法和句法。所有文本均保持标准拉丁字符,以测试新兴发音能力,而不依赖多语言字符支持。不使用任何元文本格式(如 斜体、括号),确保提示直接嵌入文本中,实现真实 TTS 渲染。

方法

作者采用多阶段框架,提升文本转语音(TTS)评估数据集的复杂性和真实性,重点关注广度扩展与深度优化。整体架构包含两个主要阶段:广度扩展和深度优化,每个阶段均采用不同的大语言模型(LLM)和精心设计的提示策略,生成对 TTS 系统具有挑战性的文本输入。

在广度扩展阶段,框架使用具备长思考能力的 LLM,如 Gemini 2.5 Pro、GPT-o3 和 Claude 3.7 Sonnet。这些模型接收标准化的广度扩展提示,通过人工分析选择每个类别中表现最佳的模型,以确保扩展后的文本语料库涵盖与 TTS 评估相关的广泛语言和上下文变体。所选模型的输出成为后续深度优化的基础。

深度优化仅使用 Gemini-2.5-Pro 执行,其任务是将原始文本转化为更复杂、更具挑战性的版本。该过程遵循结构化模板,包含原始文本(text_to_synthesize)和类别特定的优化方法(complex_prompt_method)。LLM 被指示重写文本以增加对 TTS 系统的难度,同时保留原始情感和叙事意图。优化提示中的关键组件是 tts_synthesis_diversity 字段,要求 LLM 提供详细的复杂性引入理由,确保生成的文本包含多样且具有挑战性的语言特征。

优化过程遵循一系列严格约束和指南,以确保输出具备高评估清晰度和自然口语风格。这些包括明确的情感识别要求、自然的文本线索以及对结构规则的遵守。框架还强制要求保留原始情感和语气,对引述对话和叙述文本提供具体修改指导,以增强情感表现力。对于方法 B,系统评估四种可能的情感弧线,剔除导致连续引述对话的无效顺序,基于综合分析选择最合适的方案。

为支持生成高质量音频输出,框架采用类别特定描述,以强提示方式引导具备音频能力的 LLM(如 Hume AI 和 gpt-4o-mini-tts)。这些描述涵盖多种语言维度,包括情感表现力、副语言线索、句法复杂性、外语词汇、问题和复杂发音。描述用于指导 TTS 系统生成真实且符合语境的语音。

TTS 性能评估通过针对每个语言类别的详细推理指南进行。在情感表现力方面,分析重点在于引述对话与叙述文本之间情感转换的清晰度和区分度。在副语言特征方面,评估关注感叹词、拟声词以及韵律特征(如结巴、语速)的自然性。句法复杂性通过分析用于澄清复杂句结构和处理同音词的韵律进行评估。发音则通过识别需要精确发音的关键文本部分,并提供其正确合成的精确时间戳进行评估。

最后,框架包含一个文本归一化模块,使用 GPT-4.1-mini 将原始文本转换为适合 TTS 处理的口语形式。该模块可处理多种内容类型,包括数字、符号、缩写以及特殊格式(如 URL 和电子邮件地址)。归一化过程确保所有文本元素以自然且可理解的方式呈现,保持口语输出的流畅性和清晰度。

实验

- 提出了 EmergentTTS-Eval,一个包含 1,645 个测试用例的基准测试,覆盖六种具有挑战性的 TTS 场景:情感、副语言特征、外语词汇、句法复杂性、复杂发音和问题,通过 LLM 驱动的迭代优化生成。

- 验证了使用 Gemini 2.5 Pro(大音频语言模型,LALM)作为“模型即裁判”的方法,评估语音在韵律、情感、语调和发音方面的表现,与人类偏好高度相关(Spearman 相关系数 > 0.90)。

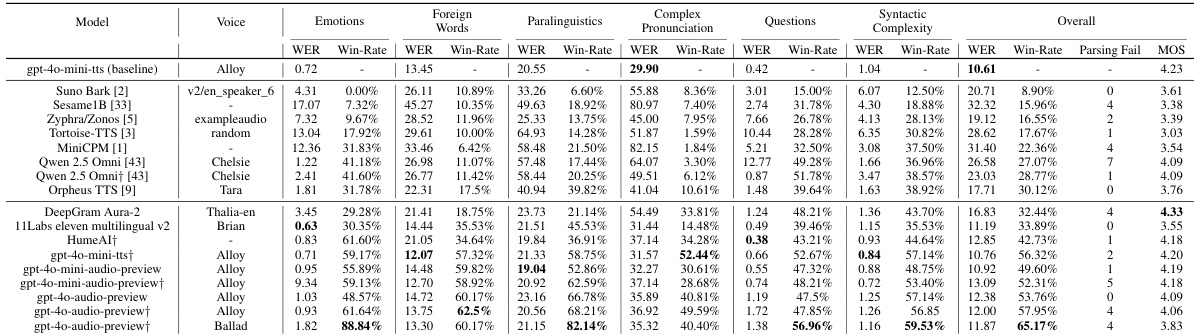

- 评估了 11 个 TTS 系统(7 个开源,4 个专有),其中 GPT-4o-mini-tts(Alloy 音色)整体胜率最高(65.17%),GPT-4o-Audio(Ballad 音色)在情感(88.84%)和副语言特征(82.14%)方面表现突出。

- 证明了强提示显著提升性能,GPT-4o-mini-tts 的胜率从 50% 提升至 56%。

- 发现开源模型在复杂发音和情感方面普遍表现较差,而商业模型(如 HumeAI 和 ElevenLabs)表现出音色依赖性差异,其中情感和副语言特征对音色身份最为敏感。

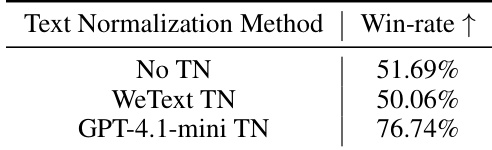

- 发现使用 LLM 进行文本归一化可提升复杂发音性能,而基础归一化技术因不当的词汇替换反而会降低结果。

- 确认 LALM 之间具有高评委一致性(Kendall’s W = 0.97),验证了自动化评估框架的稳健性。

- 揭示系统性失败模式:开源模型在发音准确性和韵律过渡方面表现不佳;商业模型在高复杂度下出现细微发音错误和合成崩溃。

作者使用一个全面的基准测试,在六种具有挑战性的场景(包括情感、副语言特征、外语词汇、句法复杂性、复杂发音和问题)下评估文本转语音系统。该基准测试通过大音频语言模型作为裁判,自动化生成测试用例和评估,实现可扩展、可复现的评估。结果表明,“模型即裁判”方法与人类偏好高度相关,并揭示了先进 TTS 系统之间的细粒度性能差异。

作者评估了文本归一化(TN)技术对复杂发音类别中 TTS 性能的影响,以 GPT-4o-mini-tts 为基线。结果表明,使用基于 LLM 的 TN 方法(GPT-4.1-mini)将胜率显著提升至 76.74%,优于无归一化(51.69%)和标准 TN 方法(WeText TN,50.06%)。

作者使用 Gemini 2.5 Pro 作为“模型即裁判”评估 TTS 系统在六种挑战性类别(包括情感、副语言特征和复杂发音)中的表现。结果表明,GPT-4o-Audio(Ballad 音色)整体胜率最高,尤其在表现力强的类别中表现优异,而开源模型整体表现较差,尤其是在复杂发音方面。

作者使用大音频语言模型(LALM)作为裁判评估 TTS 系统,Gemini 2.5 Pro 在 Test-mini 基准测试中取得最高分 68.60。这表明 Gemini 2.5 Pro 在评估语音合成质量方面优于其他 LALM,证明其作为自动化评估工具的有效性。

作者使用大音频语言模型作为“模型即裁判”在六种挑战性场景下评估文本转语音系统。结果表明,模型裁判与人类偏好高度相关,大多数裁判的 Spearman 系数超过 90%,且评委间一致性极强(Kendall’s W = 0.97),验证了评估框架的稳健性。