Command Palette

Search for a command to run...

VITA-1.5:迈向GPT-4o级别的实时视觉与语音交互

VITA-1.5:迈向GPT-4o级别的实时视觉与语音交互

摘要

近年来,多模态大语言模型(MLLMs)主要聚焦于视觉与文本模态的融合,对语音在增强交互体验中的作用关注较少。然而,语音在多模态对话系统中扮演着至关重要的角色,由于视觉与语音在本质模态上的显著差异,实现两者在高性能水平上的协同仍是一项重大挑战。本文提出了一种精心设计的多阶段训练方法,通过逐步训练大语言模型,使其具备对视觉与语音信息的联合理解能力,最终实现流畅的视觉-语音交互。该方法不仅有效保留了强大的视觉-语言建模能力,还无需依赖独立的自动语音识别(ASR)与文本转语音(TTS)模块,即可实现高效的语音到语音对话,显著提升了多模态端到端响应速度。在图像、视频及语音任务的多个基准测试中,与当前最先进的方法相比,我们的模型展现出卓越的视觉与语音综合能力,支持接近实时的视觉-语音交互。相关代码已开源,地址为:https://github.com/VITA-MLLM/VITA。

一句话总结

南京大学、腾讯优图实验室、厦门大学与中科院自动化所的作者提出VITA,一种通过多阶段训练框架融合视觉与语音理解的多模态大语言模型,能够在无需独立ASR/TTS模块的情况下实现端到端的语音到语音对话,同时保持强大的视觉-语言性能,显著加速了实时应用中的多模态交互。

主要贡献

- 大多数多模态大语言模型(MLLMs)聚焦于视觉与文本,忽视了语音在自然人机交互中的重要性;本文解决了在统一框架中整合语音与视觉的挑战,克服了现有模型中因模态冲突导致的性能下降问题。

- 作者提出一种三阶段训练方法,逐步引入视觉、语音及语音生成能力,实现无需依赖独立ASR或TTS模块的端到端视觉与语音交互,从而降低延迟并提升连贯性。

- VITA-1.5在图像、视频和语音基准测试中均表现出色,性能媲美最先进视觉-语言模型,同时显著推进了开源语音能力的发展,展示了有效的全模态理解与实时对话交互能力。

引言

作者利用多模态大语言模型(MLLMs)的最新进展,应对日益增长的自然、实时人机交互需求,该交互需融合视觉与语音。尽管先前的MLLMs在视觉-语言任务中表现优异,但常忽视语音或依赖独立的ASR与TTS模块,导致高延迟、副语言线索丢失以及模态冲突,进而降低性能。核心挑战在于如何联合训练视觉与语音模型——这两种具有不同时间与空间特性的模态——而不损害任一能力。为克服此问题,作者提出VITA-1.5,一种三阶段训练框架,逐步整合视觉、音频与语言模态。该方法首先建立强大的视觉-语言理解能力,随后通过音频编码器引入语音输入,最终通过训练好的音频解码器实现端到端语音输出。结果是一个统一、低延迟的模型,支持流畅、实时的视觉与语音交互,无需外部模块,其在图像、视频与语音基准测试中的表现与领先专有模型相当。

数据集

- 多模态指令微调的训练数据集包含多种数据类型,包括图像描述、图像问答(QA)、OCR与图表理解、视频处理以及纯文本数据,涵盖中英文内容。

- 图像描述数据包括ShareGPT4V、ALLaVA-Caption、SharedGPT4o-Image²和合成数据,用于训练模型生成图像的描述性语言。

- 图像QA数据包含LLaVA-150K、LLaVA-Mixture-sample、LVIS-Instruct、ScienceQA、ChatQA以及从LLaVA-OV精选的子集,聚焦于通用图像问答与数学推理任务。

- OCR与图表数据来自Anyword-3M、ICDAR2019-LSVT、UReader、SynDOG、ICDAR2019-LSVT-QA以及LLaVA-OV的额外样本,使模型能够解析图像中的文本与图表。

- 视频数据包括ShareGemini和合成数据,支持视频描述与基于视频的问答能力。

- 纯文本数据增强模型的语言理解与生成能力,尤其在基于文本的问答任务中。

- 数据集在不同训练阶段中选择性采样子集,以满足特定目标,如视觉描述、推理或多模态对齐。

- 图像与视频任务中使用的合成数据来自开源来源,如Wukong、LAION和CC12M。

- 额外包含11万小时内部语音-转录配对的ASR数据(中英文),用于训练音频编码器并将其与LLM对齐。

- 使用来自TTS系统的3,000小时文本-语音配对数据训练语音解码器。

- 未提及显式的裁剪策略,但元数据构建可能涉及任务特定的标注与模态对齐处理。

方法

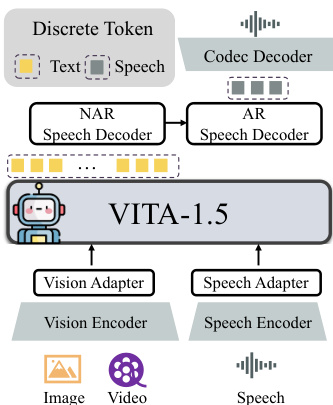

作者采用多模态架构构建VITA-1.5,以大语言模型(LLM)为核心,通过专用编码器与适配器整合视觉与音频模态。整体框架如图所示,采用“多模态编码器-适配器-LLM”配置。输入端,视觉与音频数据分别由其编码器处理——视觉使用InternViT-300M,音频使用包含24个Transformer块的自定义语音编码器——随后通过模态特定适配器投影至LLM的token空间。视觉适配器采用两层MLP将视觉特征映射为token,而语音适配器使用带2倍下采样的卷积层。输出端配备端到端语音生成模块,取代先前版本中使用的外部TTS系统。该模块由非自回归(NAR)语音解码器与自回归(AR)语音解码器组成:NAR解码器从文本嵌入生成语音token的初始分布,AR解码器则逐步优化这些token。最终的语音token通过TiCodec模型解码为连续波形,该模型采用单个大小为1024的codebook与40Hz的token频率。

模型的训练过程通过三阶段策略缓解模态冲突,如图所示。第一阶段聚焦于视觉-语言训练。首先进行视觉对齐,仅使用20%的描述数据训练视觉适配器,以弥合视觉与语言特征之间的差距。随后进行视觉理解,使用100%的描述数据训练视觉编码器、适配器与LLM,使模型能够生成图像的自然语言描述。该阶段的最后一步为视觉SFT,使用描述与QA数据的组合训练模型,以增强其对视觉输入的指令遵循与问答能力。第二阶段引入音频输入调优。第二阶段1(音频对齐)首先使用连接时序分类(CTC)损失在语音-转录对上训练语音编码器,将音频特征映射为文本表示,随后训练语音适配器将这些特征整合进LLM。第二阶段2(音频SFT)进一步在语音-文本QA对上训练模型,其中部分文本问题被替换为语音版本,并在LLM中添加分类头以区分语音与文本输入。第三阶段聚焦于音频输出调优。第三阶段1训练codec模型,实现语音到离散token及反向映射;第三阶段2使用文本-语音配对数据训练NAR与AR语音解码器。在此阶段,LLM被冻结以保留其多模态理解能力,同时支持语音生成。

实验

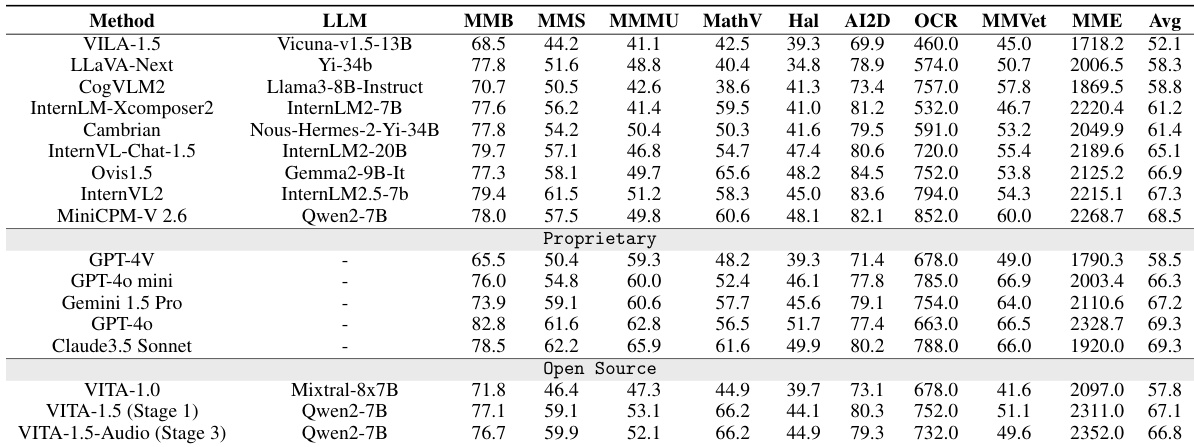

- 在图像理解基准测试(MME、MMBasech、MMStar、MathVista、HallusionBench、AI2D、OCRBench、MMVet)上,VITA-1.5的表现与最先进开源模型相当,并超越了GPT-4V与GPT-4o-mini等闭源模型,展现出强大的视觉-语言能力。

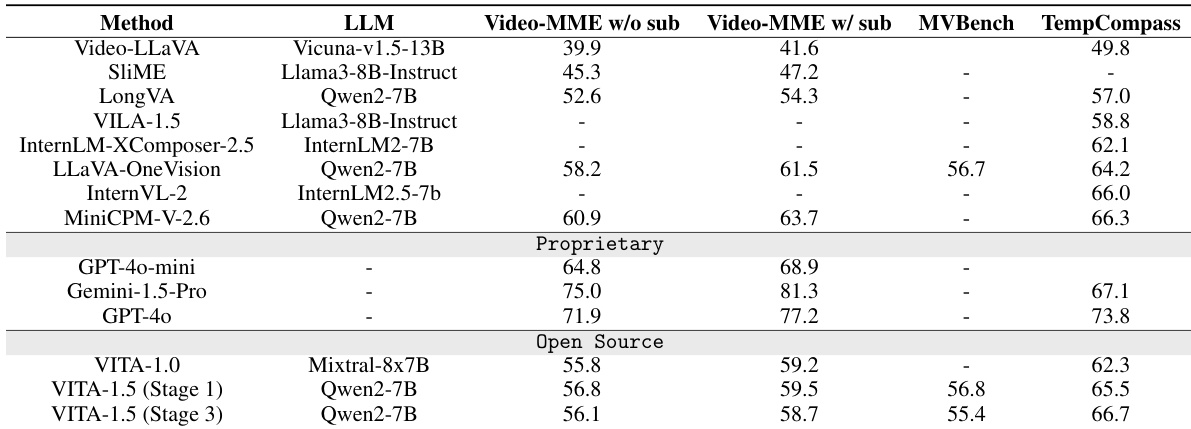

- 在视频理解基准测试(Video-MME、MVBasech、TempCompass)上,VITA-1.5的表现与顶级开源模型相当,但仍落后于GPT-4o与Gemini 1.5 Pro等专有模型,表明在视频理解方面仍有提升空间。

- 经过音频输入与输出阶段的训练后,VITA-1.5几乎完全保留了原有的视觉-语言能力,证实了多模态集成的有效性且未造成性能退化。

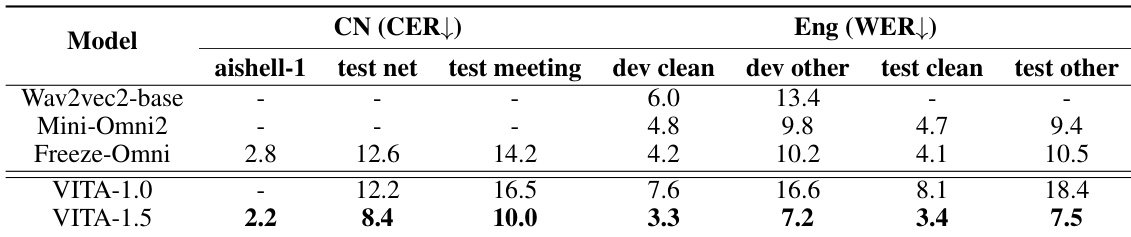

- 在ASR基准测试中,VITA-1.5在普通话(CER)与英语(WER)上均达到领先水平,超越专用语音模型,展现出跨语言的稳健语音识别能力。

作者使用表4评估VITA-1.5在普通话与英语基准上的语音识别性能,并与基线模型进行对比。结果显示,VITA-1.5在普通话上达到最低的字符错误率(CER),在英语上达到最低的词错误率(WER),优于专用语音模型。

作者使用表2评估VITA-1.5在多个基准上的图像理解性能,结果显示其表现与领先开源模型相当,并超越部分闭源模型如GPT-4V与GPT-4o-mini。结果表明,经过多阶段训练后,VITA-1.5仍保持强大的视觉-语言能力,在通用多模态理解、数学推理与OCR等任务中均取得具有竞争力的分数。

结果显示,VITA-1.5在视频理解基准测试中表现具有竞争力,优于多个开源模型,并接近GPT-4o与Gemini-1.5-Pro等专有模型的能力,尽管仍略逊一筹。模型在经过语音专项训练阶段后,仍保持强大的视觉-语言能力,这在各基准测试中的一致表现中得到验证。