Command Palette

Search for a command to run...

一键体验 GLM-4-9B-Chat

近日,智谱 AI 发布了基座大模型 GLM-4 的最新开源成果——GLM-4-9B,首次拥有了多模态能力。官方给出的数据显示,对比训练量更多的 Llama-3-8B 模型,GLM-4-9B 在中文学科方面的提升高达 50%,在多模态方面可以比肩 GPT-4V 。

在上下文长度上,GLM-4-9B 实现了从 128K 到 1M 的升级跨越,相当于能够一口气消化 125 篇论文!此外,其模型词表从 6 万升级到了 15 万,在中英文之外的语言编码效率平均提升了 30%,可以更快处理小语种的任务。

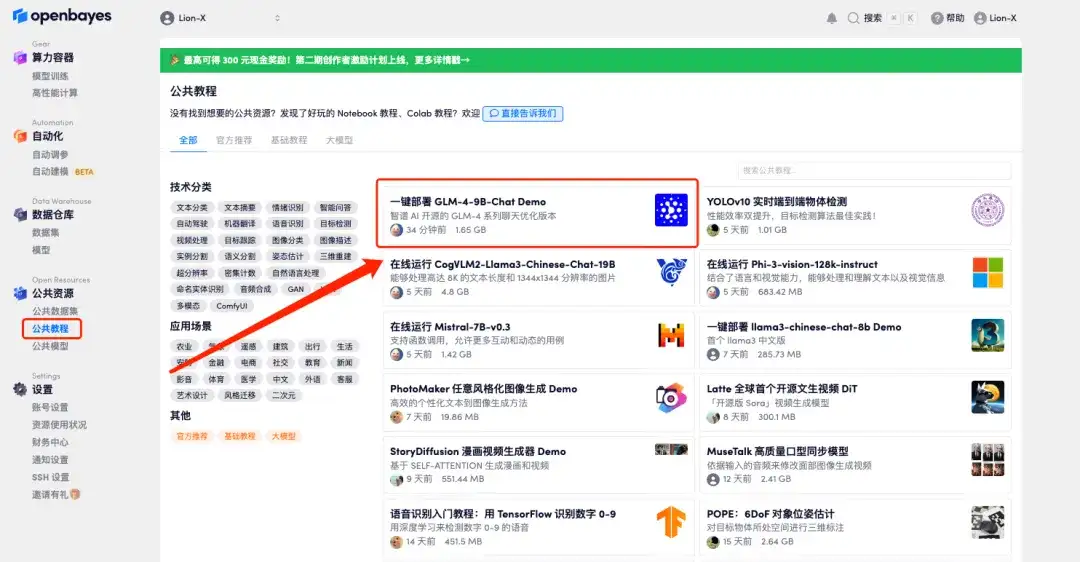

为了让大家第一时间体验到这个自称「超越 Llama3-8B」的开源模型,OpenBayes 平台公共模型板块现已上线了「GLM-4-9B-Chat」模型,支持一键 input,跳过漫长的下载、上传时间,直接开启快乐部署。

公共模型地址:

https://go.openbayes.com/F7pbS

不仅如此,「一键部署 GLM-4-9B-Chat Demo」也已经同步上线至 OpenBayes 平台公共教程板块,无需输入任何命令、点击克隆即可立即开始体验 GLM-4-9B-Chat 的卓越性能。

公共教程地址:

https://go.openbayes.com/ulmZe

操作步骤

PART 1 Demo 运行阶段

1. 登录 http://OpenBayes.com,在「公共教程」页面,选择「一键部署 GLM-4-9B-Chat Demo」。

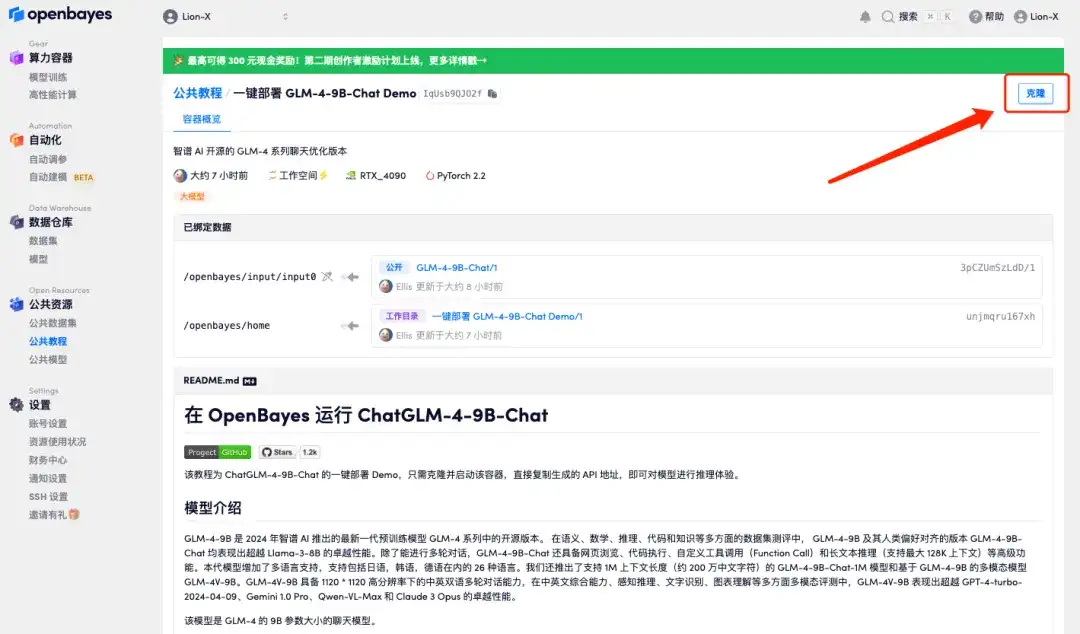

2. 页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

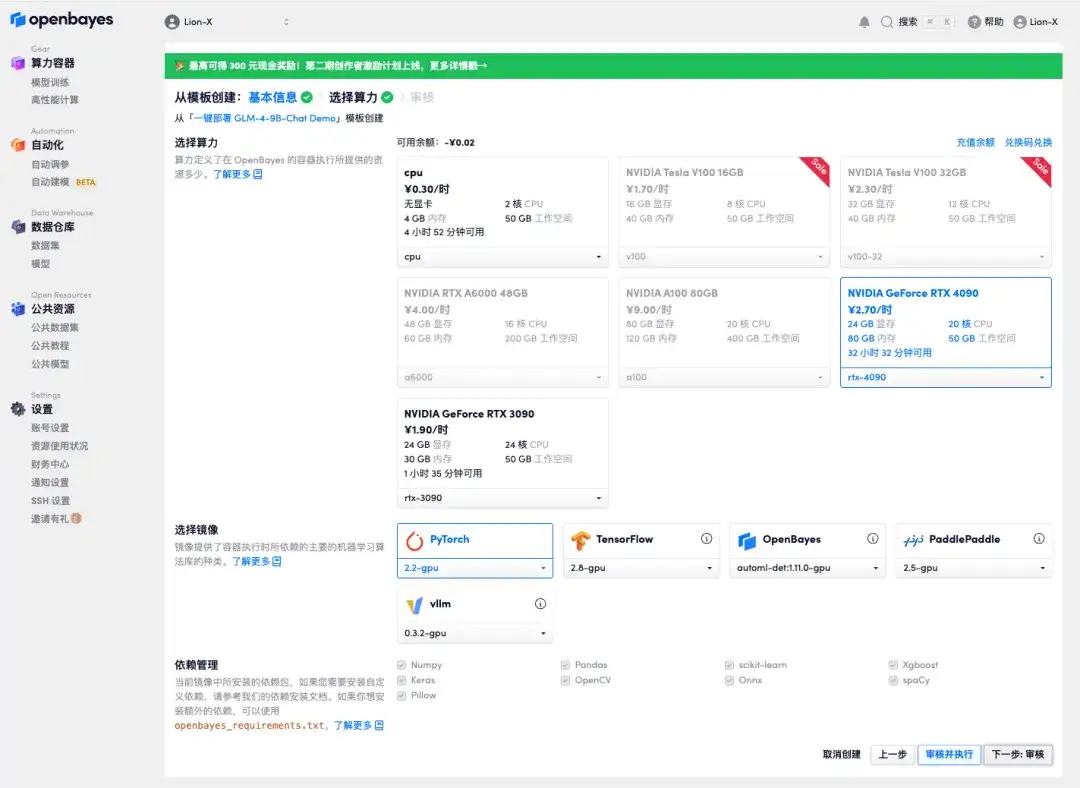

3. 点击右下角「下一步:选择算力」。

4. 跳转后,选择「NVIDIA GeForce RTX 4090」,点击「下一步:审核」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

小贝总专属邀请链接(直接复制到浏览器打开):https://go.openbayes.com/9S6Dr

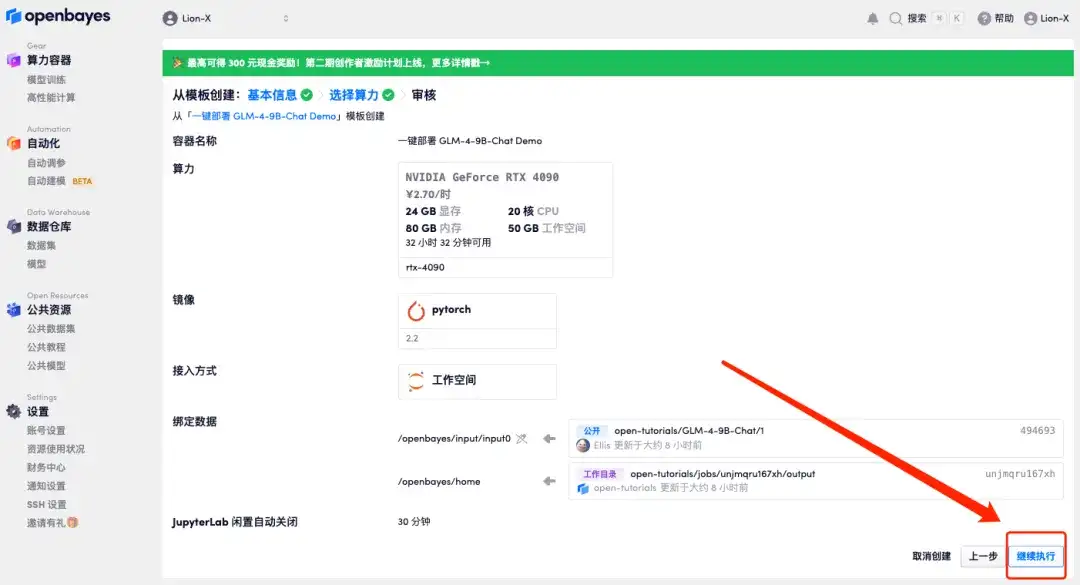

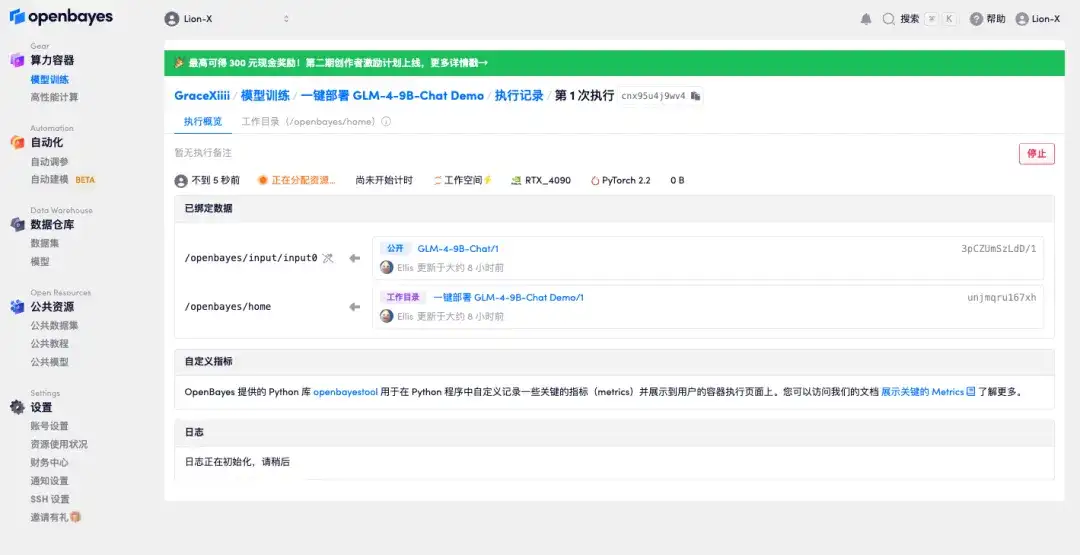

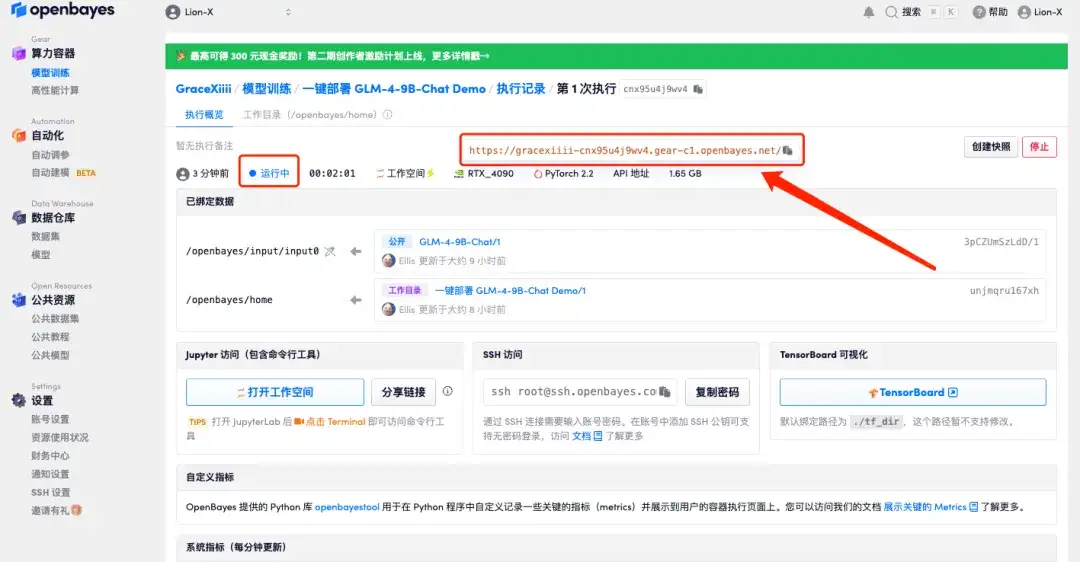

5. 点击「继续执行」,等待分配资源,首次克隆需等待 3 分钟左右的时间。当状态变为「运行中」后,将鼠标移动至「API 地址」后,复制该地址并在新标签页打开,即可跳转至 GLM-4-9B-Chat Demo 页面。请注意,用户需在实名认证后才能使用 API 地址访问功能。

若超过 10 分钟仍处于「正在分配资源」状态,可尝试停止并重启容器;若重启仍无法解决,请在官网联系平台客服。

PART 2 Demo 运行阶段

1. 打开 GLM-4-9B-Chat Demo 页面,在对话框内容输入文本,点击「Submit」后,即可开始对话。

2. 右侧的超参数面板分别表示:

* Maximum length:模型最大输出文字的数量;

* Top P:控制从模型输出的概率分布中选择候选词的范围,值增大,意味着在文本生成过程中考虑的单词集合会更大;

* Temperature:控制随机性的超参数,值越大,生成文本的随机性越大。

新用户福利

注册福利:点击下方邀请链接注册,即可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长,永久有效!

小贝总专属邀请链接(直接复制到浏览器打开):