Command Palette

Search for a command to run...

MiniCPM-V 4.5: أقوى نموذج متعدد الوسائط من الحافة إلى الحافة

التاريخ

الحجم

343.55 MB

الوسوم

الترخيص

Apache 2.0

GitHub

رابط الورقة البحثية

1. مقدمة البرنامج التعليمي

يُعدّ MiniCPM-V 4.5 نموذج ذكاء اصطناعي فائق الكفاءة يعمل على الحافة، وقد تمّ طرحه كمصدر مفتوح في أغسطس 2025 من قِبل مختبر معالجة اللغات الطبيعية بجامعة تسينغهوا بالتعاون مع شركة Wallfacer AI. يحتوي MiniCPM-V 4.5 على 8 بايتات من المعاملات. يتفوّق النموذج في مجالات متعدّدة تشمل الصور والفيديو والتعرّف الضوئي على الأحرف (OCR)، محققًا إنجازات بارزة، لا سيّما في فهم الفيديوهات ذات معدل التحديث العالي، حيث يتميّز بقدرته على معالجة الفيديوهات ذات معدل التحديث العالي والتعرّف على المحتوى بدقة. يدعم النموذج نمط استدلال هجين، يوازن بين الأداء وسرعة الاستجابة. يتميّز MiniCPM-V 4.5 بسهولة نشره على الحافة، مع استهلاك منخفض للذاكرة وسرعة استدلال عالية، مما يجعله مناسبًا للتطبيقات في أنظمة السيارات والروبوتات والأجهزة الأخرى، واضعًا معيارًا جديدًا لتطوير الذكاء الاصطناعي على الحافة. تتوفر أوراق بحثية ذات صلة. MiniCPM-V: برنامج MLLM بمستوى GPT-4V على هاتفك .

موارد الحوسبة المستخدمة في هذا البرنامج التعليمي هي بطاقة RTX 4090 واحدة.

2. عرض التأثير

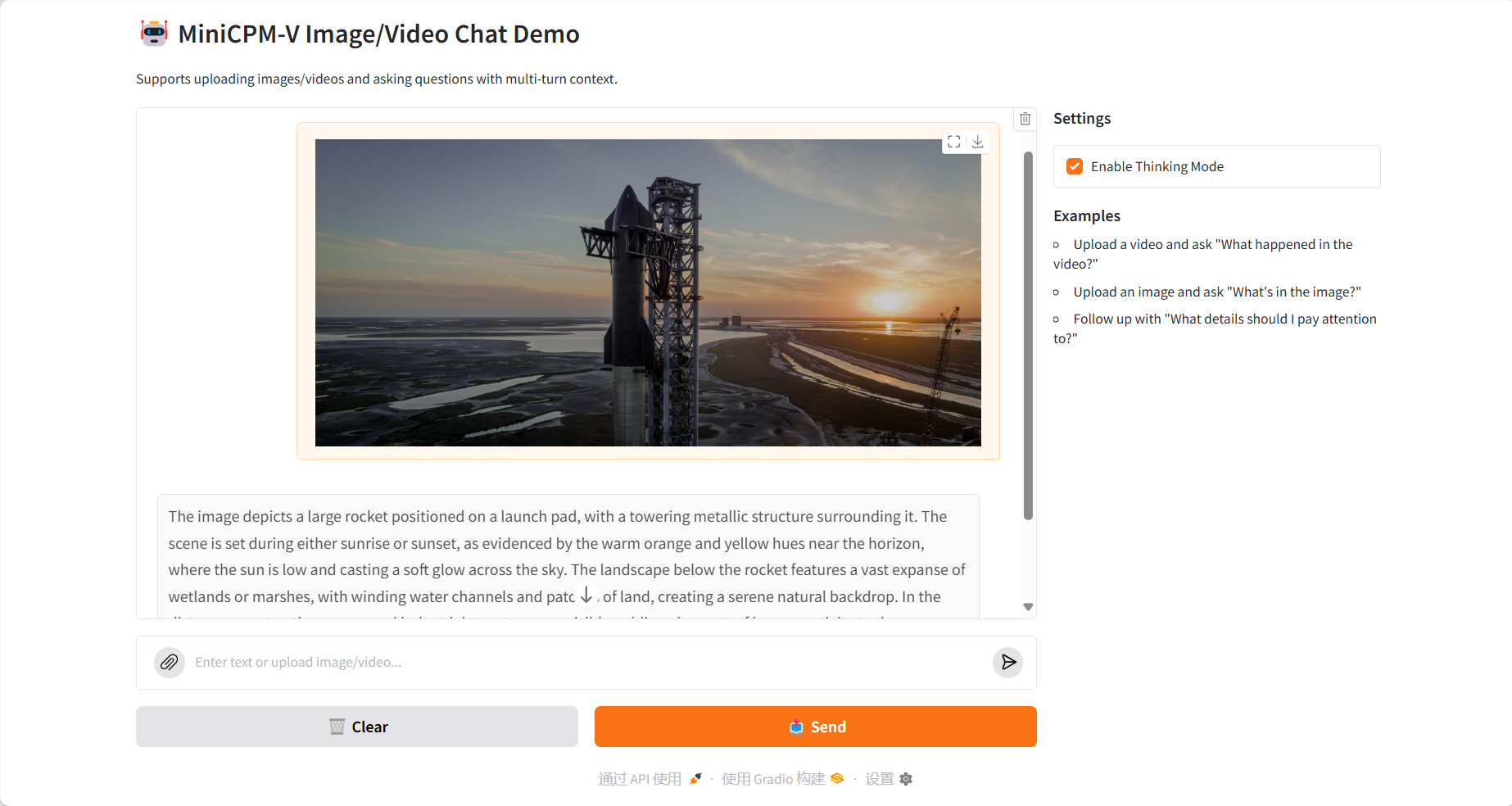

فهم الصورة

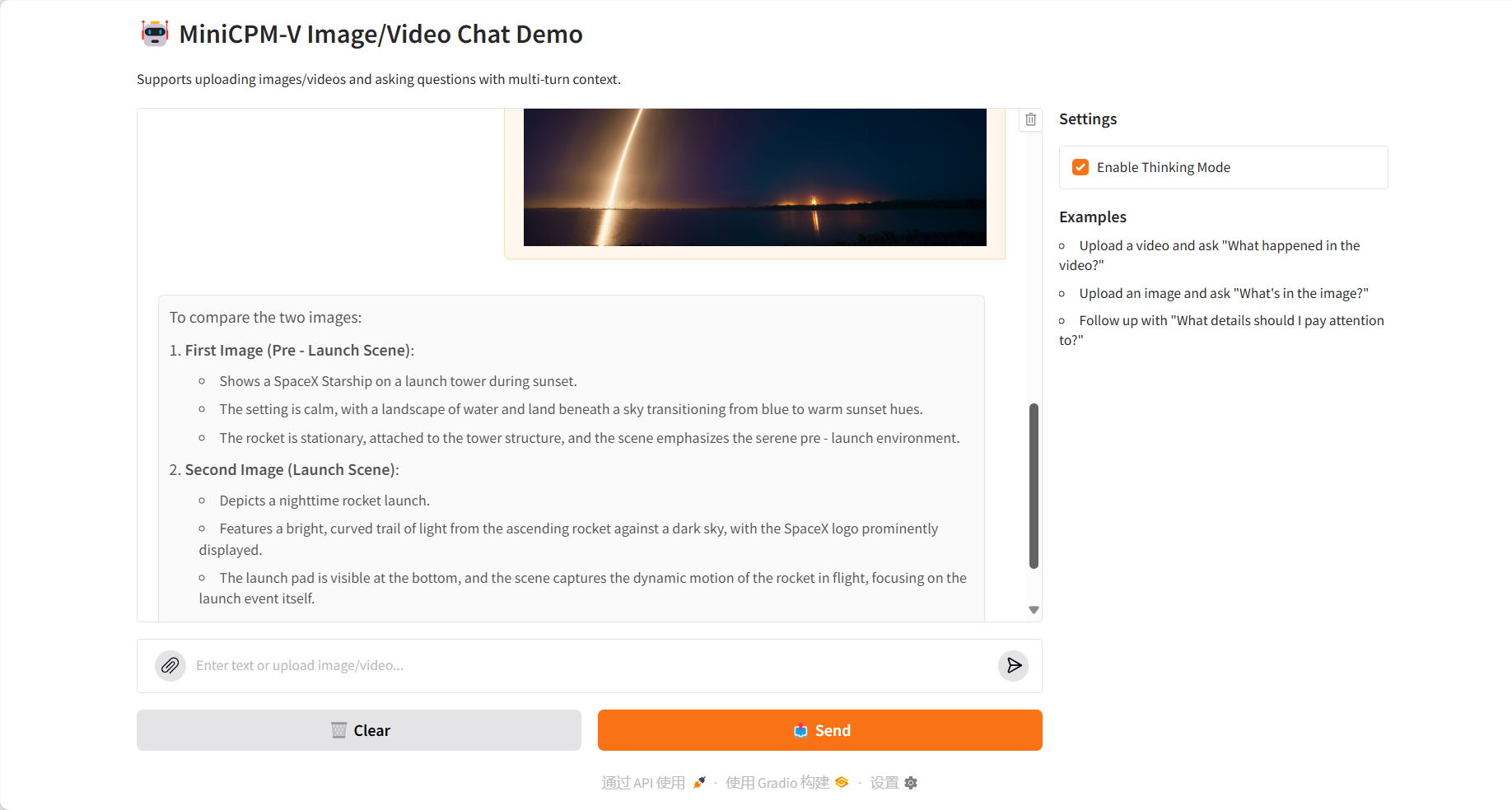

مقارنة الصور المتعددة

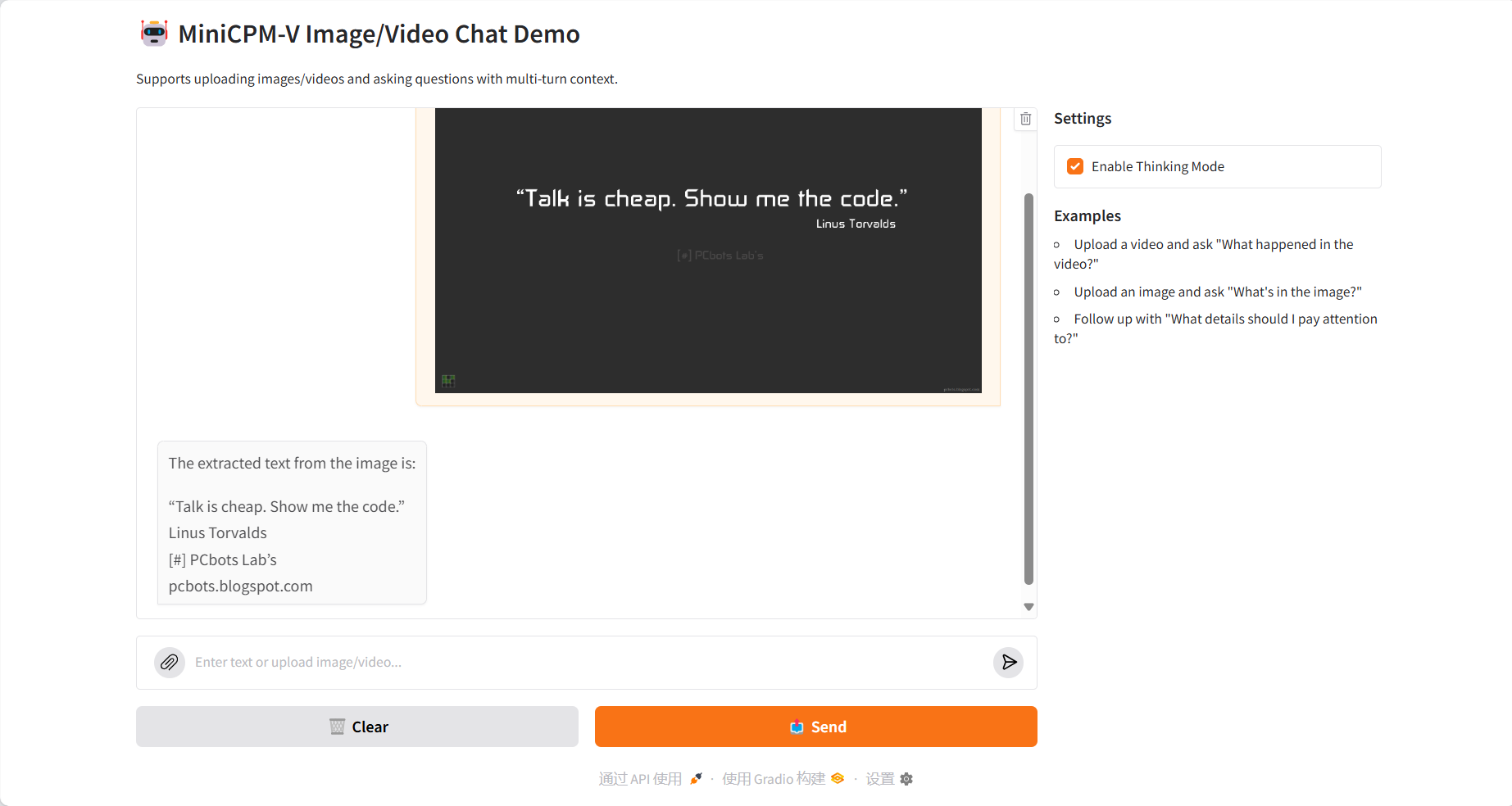

استخراج النص OCR

فهم الفيديو

3. خطوات التشغيل

1. ابدأ تشغيل الحاوية

2. خطوات الاستخدام

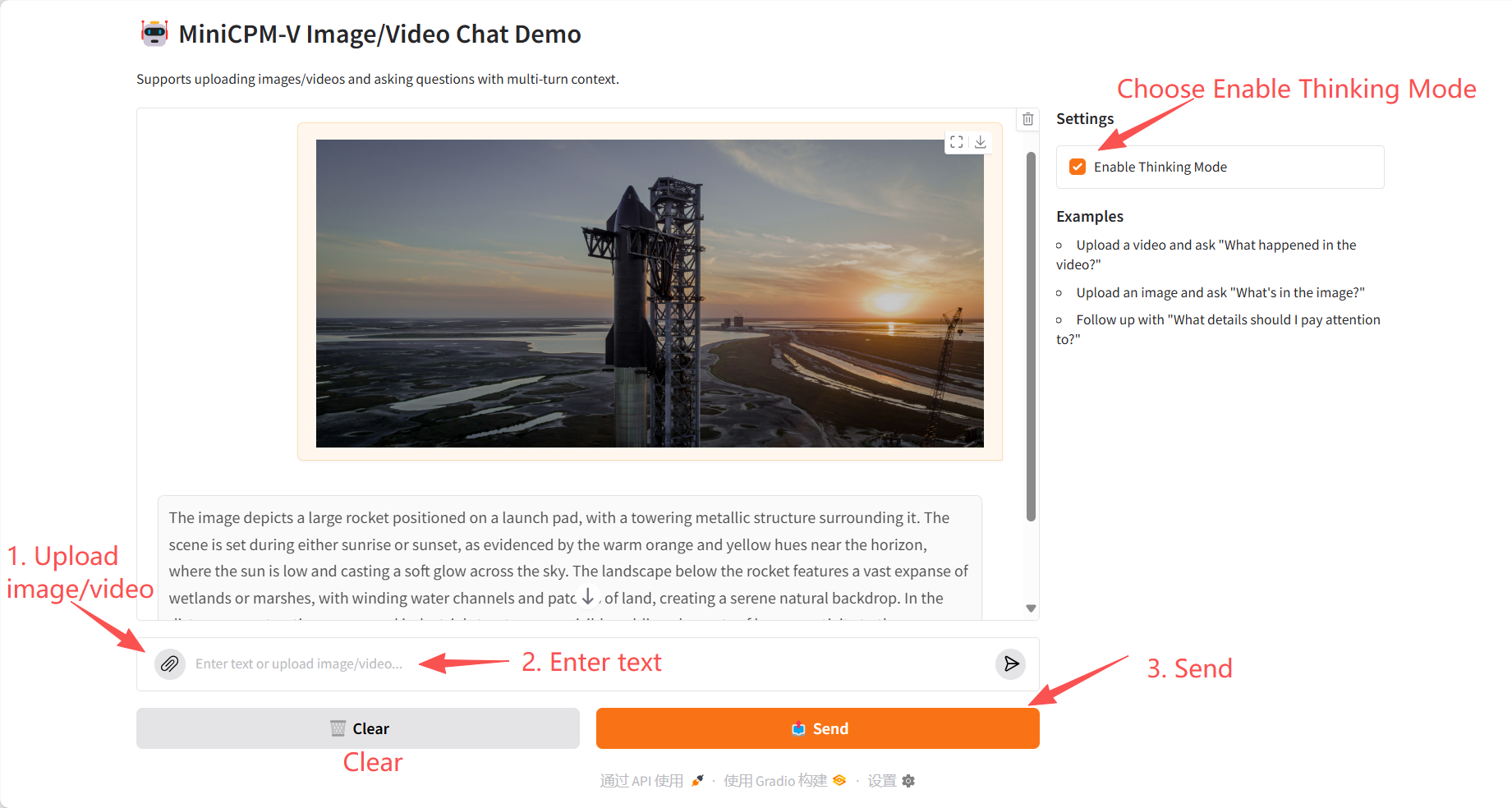

إذا تم عرض "بوابة سيئة"، فهذا يعني أن النموذج قيد التهيئة. نظرًا لأن النموذج كبير الحجم، يرجى الانتظار لمدة 2-3 دقائق وتحديث الصفحة.

4. المناقشة

🖌️ إذا رأيت مشروعًا عالي الجودة، فيرجى ترك رسالة في الخلفية للتوصية به! بالإضافة إلى ذلك، قمنا أيضًا بتأسيس مجموعة لتبادل الدروس التعليمية. مرحبًا بالأصدقاء لمسح رمز الاستجابة السريعة وإضافة [برنامج تعليمي SD] للانضمام إلى المجموعة لمناقشة المشكلات الفنية المختلفة ومشاركة نتائج التطبيق↓

معلومات الاستشهاد

معلومات الاستشهاد لهذا المشروع هي كما يلي:

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.