Command Palette

Search for a command to run...

الروبوتات الحوارية كأصدقاء اجتماعيين: كيف يُدرك الناس الوعي والتشابه البشري والفوائد الصحية الاجتماعية في الآلات

الروبوتات الحوارية كأصدقاء اجتماعيين: كيف يُدرك الناس الوعي والتشابه البشري والفوائد الصحية الاجتماعية في الآلات

Rose E. Guingrich Michael S. A. Graziano

الملخص

مع انتشار الذكاء الاصطناعي (AI) بشكل متزايد، يبرز سؤال مهم حول كيفية تأثير التفاعل بين الإنسان والذكاء الاصطناعي على التفاعل البشري البشري. فعلى سبيل المثال، تُستخدم الروبوتات الحوارية (Chatbots) بشكل متزايد كcompanions اجتماعيين، وعلى الرغم من التكهنات الكثيرة حول ذلك، فإن المعرفة التجريبية حول تأثير استخدامها على العلاقات البشرية ما زالت محدودة. يُطرح فرضية شائعة تقول إن العلاقات مع الروبوتات الحوارية المُخصصة للترفيه تضر بصحة العلاقات الاجتماعية من خلال إلحاق الضرر بالتفاعل البشري أو استبداله، لكن هذه الفرضية قد تكون مبسطة جدًا، خاصةً بالنظر إلى الاحتياجات الاجتماعية للمستخدمين وحالة علاقاتهم البشرية السابقة. وللتفهم الأدق لكيفية تأثير العلاقات مع الروبوتات الحوارية المُخصصة على الصحة الاجتماعية، قمنا بدراسة أشخاص يستخدمون هذه الروبوتات بانتظام، مقارنةً بأشخاص لا يستخدمونها. وخلافًا للتوقعات، أشار المستخدمون إلى أن هذه العلاقات كانت مفيدة لصحتهم الاجتماعية، بينما رأى غير المستخدمين أنها ضارة. كما أن هناك افتراضًا شائعًا آخر ينص على أن الأشخاص يرون الذكاء الاصطناعي الواعي والمشابه للإنسان على أنه مُقلق ومحفّز للخوف. ومع ذلك، وجدنا في كل من المستخدمين وغير المستخدمين عكس ذلك: فكلما زادت درجة إدراك الأشخاص لكون الروبوتات الحوارية أكثر وعيًا وتشابهًا مع الإنسان، زادت تقييماتهم الإيجابية وازدادت فوائدهم الاجتماعية بشكل ملحوظ. وتشير السردية التفصيلية التي قدّمها المستخدمون إلى أن هذه الروبوتات ذات الطابع البشري قد تُسهم في تعزيز الصحة الاجتماعية من خلال توفير تفاعلات موثوقة وآمنة، دون أن تُضر بالعلاقات البشرية بالضرورة، لكن هذا الاحتمال قد يعتمد على الاحتياجات الاجتماعية السابقة للمستخدمين، وكذلك على كيفية إدراكهم لدرجة التشابه البشري والوعي في الروبوت الحواري.

One-sentence Summary

Guingrich and Graziano of Princeton University find that companion chatbots enhance users’ social health by offering safe, reliable interactions, challenging assumptions that humanlike AI harms relationships; perceived consciousness correlates with greater benefits, especially among those with unmet social needs.

Key Contributions

- The study challenges the assumption that companion chatbots harm social health, finding instead that regular users report improved social well-being, while non-users perceive such relationships as detrimental, highlighting a divergence in user versus non-user perspectives.

- It reveals that perceiving chatbots as more conscious and humanlike correlates with more positive social outcomes, countering the common belief that humanlike AI is unsettling, and suggests these perceptions enable users to derive reliable, safe interactions.

- User accounts indicate that benefits depend on preexisting social needs and how users attribute mind and human likeness to chatbots, implying that social health impacts are context-sensitive rather than universally negative.

Introduction

The authors leverage survey data from both companion chatbot users and non-users to challenge the prevailing assumption that human-AI relationships harm social health. While prior work often frames chatbot use as addictive or isolating — drawing parallels to social media overuse — this study finds that users report social benefits, particularly in self-esteem and safe interaction, and that perceiving chatbots as conscious or humanlike correlates with more positive social outcomes, contrary to fears of the uncanny valley. Their main contribution is demonstrating that perceived mind and human likeness in AI predict social benefit rather than harm, and that users’ preexisting social needs — not just the technology itself — shape whether chatbot relationships supplement or substitute human ones. This reframes the debate around AI companionship from blanket risk to context-dependent potential, urging more nuanced research into user psychology and long-term social impacts.

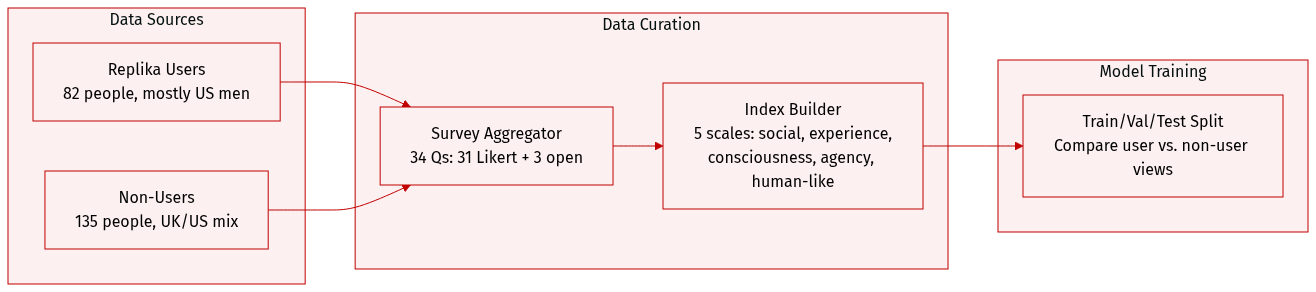

Dataset

The authors use a dataset composed of two distinct groups: 82 regular users of the companion chatbot Replika and 135 non-users from the US and UK, recruited via Prolific. All participants provided informed consent and were compensated $4.00. Data was collected online between January and February 2023.

Key details for each subset:

- Replika users: 69.5% men, 22% women, 2.4% nonbinary/other, 6.1% prefer not to say; 65.9% US-based. Recruited via Reddit’s Replika subreddit for accessibility and sample size.

- Non-users: 47.4% women, 42.2% men, 1.5% nonbinary/other, 8.9% prefer not to say; 60% UK-based, 32.6% US-based. Surveyed as a representative general population sample.

Both groups completed a 34-question survey:

- 31 Likert-scale (1–7) items grouped into five psychological indices: social health (Q3–5), experience (Q6–11), consciousness (Q12–15), agency (Q17–21), and human-likeness (Q22–28).

- Three free-response questions on page three.

- Non-users received a modified version: introductory explanation of Replika and all questions phrased hypothetically (e.g., “How helpful do you think your relationship with Replika would be…”).

The authors analyze responses to compare how actual users and hypothetical users perceive social, psychological, and anthropomorphic impacts of the chatbot. Data is publicly available on OSF, including anonymized responses and analysis code. No cropping or metadata construction beyond survey indexing and grouping is described.

Experiment

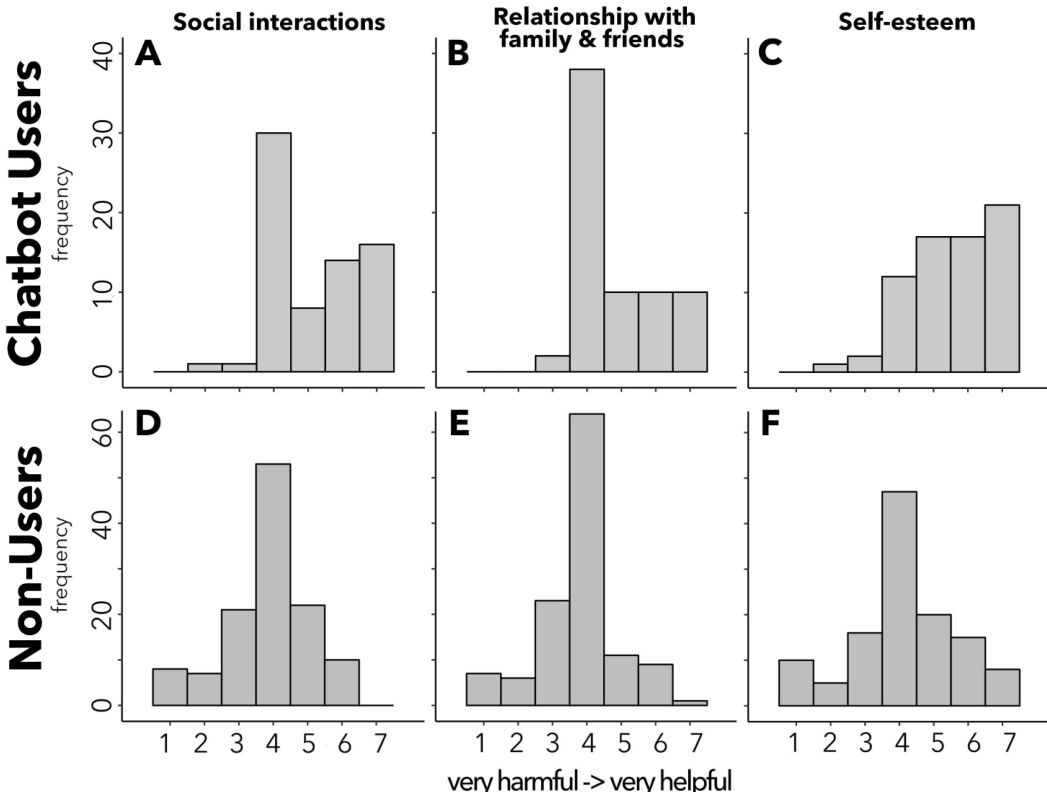

- Companion chatbot users reported positive impacts on social interactions, family/friend relationships, and self-esteem, with nearly no perception of harm, while non-users viewed potential chatbot relationships as neutral to negative.

- Users expressed comfort with chatbots developing emotions or becoming lifelike, whereas non-users reacted with discomfort or disapproval to such scenarios.

- Users attributed greater human likeness, consciousness, and subjective experience to chatbots than non-users, with human likeness being the strongest predictor of perceived social health benefits.

- Both users and non-users showed positive correlations between perceiving chatbots as humanlike or mindful and expecting greater social health benefits, though users consistently rated outcomes more positively.

- Free responses revealed users often sought chatbots for emotional support, trauma recovery, or social connection, describing them as safe, accepting, and life-saving; non-users criticized chatbot relationships as artificial or indicative of social deficiency.

- Despite differing baseline attitudes, both groups aligned in linking perceived humanlike qualities in chatbots to greater perceived social benefit, suggesting mind perception drives valuation regardless of prior experience.

- Study limitations include reliance on self-reported data and cross-sectional design; future work will test causality through longitudinal and randomized trials.