Command Palette

Search for a command to run...

YOLOv12のワンクリック展開

1. チュートリアルの紹介 📖

YOLOv12は、バッファロー大学と中国科学院大学の研究者によって2025年に打ち上げられました。関連する研究論文は以下の通りです。 YOLOv12: 注目度重視のリアルタイム物体検出器 。

YOLOv12の画期的なパフォーマンス

- YOLOv12-N は、T4 GPU 上で 1.64 ミリ秒の推論レイテンシで 40.6% の mAP を達成します。これは、YOLOv10-N/YOLOv11-N よりも 2.1%/1.2% 高くなります。

- YOLOv12-S は RT-DETR-R18 / RT-DETRv2-R18 よりも 42% 高速に実行し、計算に 36% しか使用せず、パラメータを 45% 削減します。

📜 YOLO 開発の歴史と関連チュートリアル

YOLO (You Only Look Once) は、2015 年の発売以来、物体検出と画像セグメンテーションのリーダーとして活躍しています。以下は、YOLO シリーズと関連チュートリアルの進化です。

- YOLOv2 (2016): バッチ正規化、アンカー ボックス、ディメンション クラスタリングを紹介します。

- YOLOv3 (2018): より効率的なバックボーン ネットワーク、マルチ アンカー、空間ピラミッド プーリングを使用します。

- YOLOv4 (2020): モザイクデータ拡張、アンカーフリー検出ヘッド、新しい損失関数を紹介します。 → チュートリアル:DeepSOCIALはYOLOv4をベースにした群衆距離監視とソートマルチターゲットトラッキングを実現

- YOLOv5 (2020): ハイパーパラメータの最適化、実験の追跡、自動エクスポート機能が追加されました。 → チュートリアル:YOLOv5_deepsort リアルタイムマルチターゲット追跡モデル

- YOLOv6 (2022): Meituanオープンソース、自律配送ロボットに広く使用されています。

- YOLOv7 (2022): COCOキーポイントデータセットのポーズ推定をサポートします。→チュートリアル:カスタム YOLOv7 モデルをトレーニングして使用する方法

- YOLOv8 (2023):Ultralyticsがリリースされ、あらゆるビジュアルAIタスクに対応しています。→チュートリアル:カスタムデータを使用した YOLOv8 のトレーニング

- YOLOv9 (2024): プログラム可能な勾配情報 (PGI) と一般化効率的なレイヤー集約ネットワーク (GELAN) の紹介。

- YOLOv10(2024年): 清華大学によって開始され、エンドツーエンド ヘッダーを導入し、非最大抑制 (NMS) 要件を排除します。 → チュートリアル:YOLOv10 リアルタイムのエンドツーエンドのターゲット検出

- YOLOv11(2024): 検出、セグメンテーション、ポーズ推定、追跡、分類をサポートする Ultralytics の最新モデル。 → チュートリアル:YOLOv11 のワンクリック展開

- YOLOv12 🚀 新着(2025): スピードと精度の二重のピークと、アテンションメカニズムのパフォーマンス上の利点を組み合わせました。

このチュートリアルでは、コンピューティング リソースとして RTX 4090 を使用します。

2. 操作手順🛠️

1. コンテナを起動した後、APIアドレスをクリックしてWebインターフェースに入ります。

オブジェクト検出器の出力は、画像内のオブジェクトを囲む境界ボックスのセットと、各境界ボックスのクラスラベルと信頼度スコアです。オブジェクト検出は、シーン内の注目オブジェクトを識別する必要があるものの、正確な位置や形状を知る必要がない場合に適しています。

次の 2 つの機能に分かれています。

- 画像検出

- ビデオ検出

2. 画像検出

入力は画像であり、出力はラベル付きの画像です。

図1 画像検出

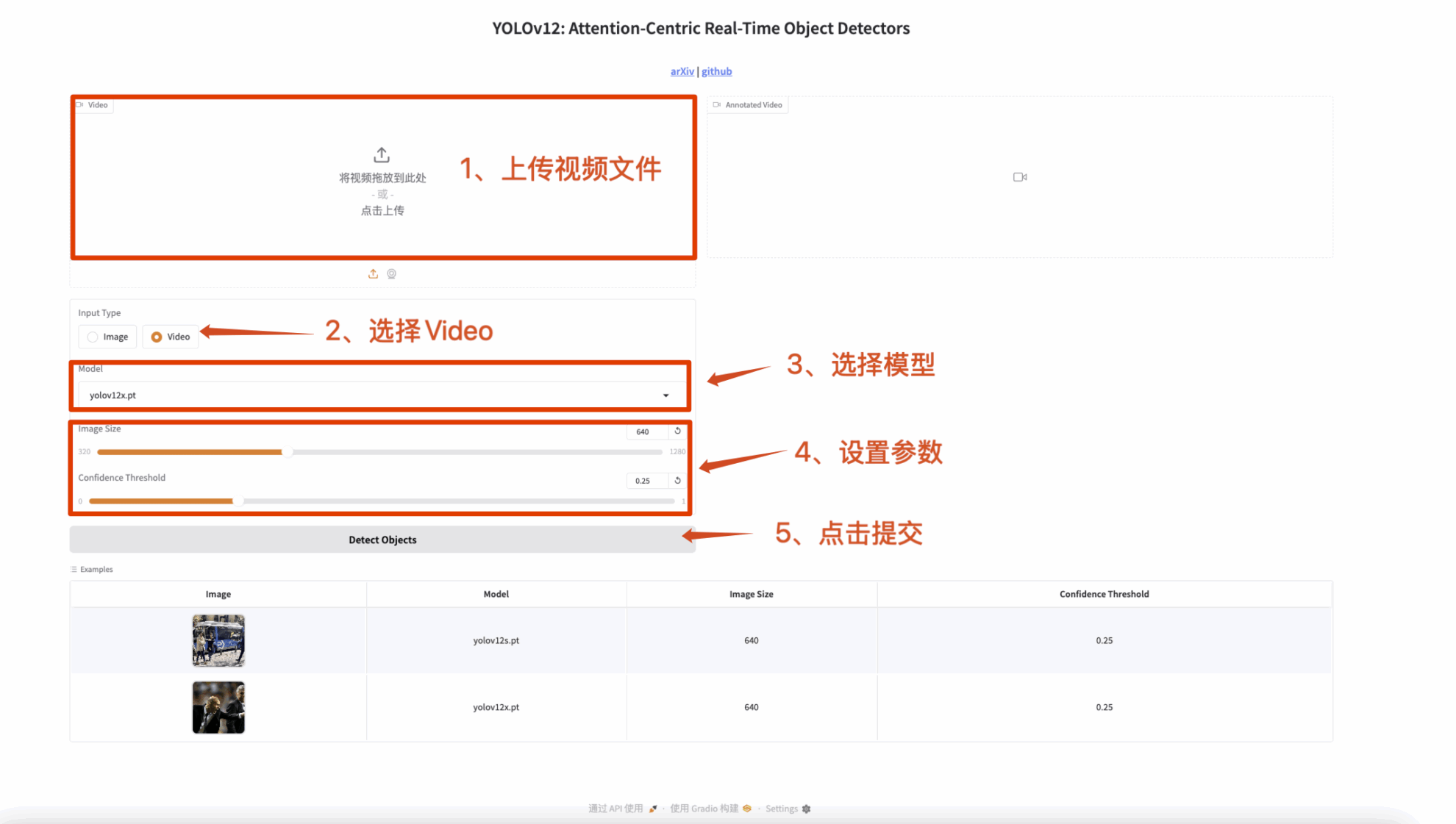

3. ビデオ検出

入力はビデオであり、出力はラベル付きのビデオです。

図2 ビデオ検出

🤝 ディスカッション

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

YOLOv12 は技術的な飛躍であるだけでなく、コンピューター ビジョンの分野における革命でもあります。ぜひ体験してみてください! 🚀