Command Palette

Search for a command to run...

vLLM+Open WebUI の導入 Phi-4-mini-flash-reasoning

1. チュートリアルの概要

Phi-4-mini-flash-reasoningは、Microsoftチームがリリースした軽量なオープンソースモデルです。合成データに基づいて構築され、高品質で集中的な推論データに焦点を当て、さらに微調整することで、より高度な数学的推論機能を実現しています。このモデルはPhi-4モデルファミリーに属し、64Kのトークンコンテキスト長をサポートし、デコーダー・ハイブリッド・デコーダーアーキテクチャを採用し、アテンションメカニズムと状態空間モデル(SSM)を組み合わせることで、優れた推論効率を発揮します。関連研究論文もご覧いただけます。 長い世代を持つ効率的な推論のためのデコーダーハイブリッドデコーダーアーキテクチャ 。

このチュートリアルでは、RTX 4090カードを1枚使用します。プロジェクトプロンプトは中国語と英語に対応しています。

2. プロジェクト例

3. 操作手順

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

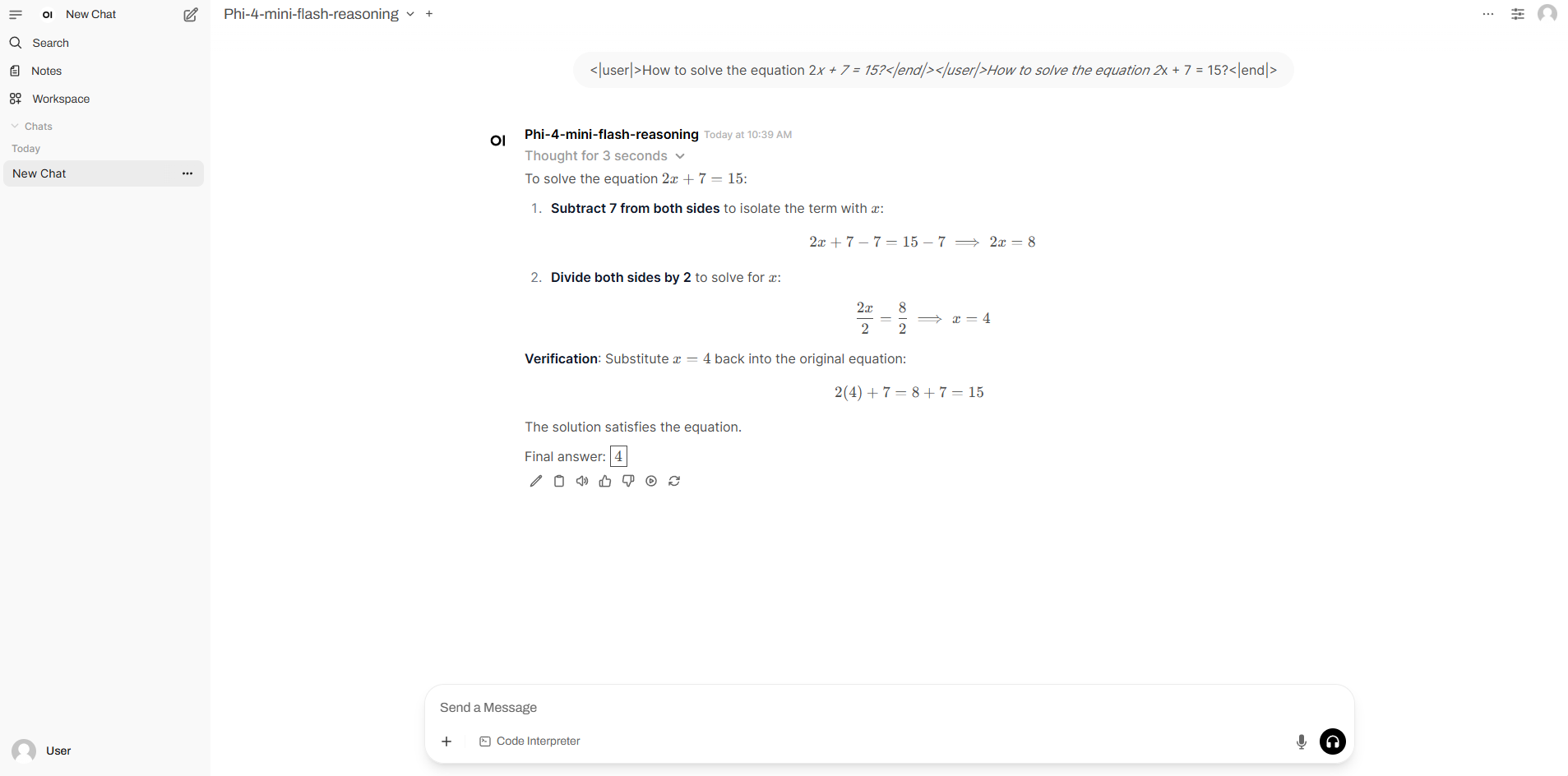

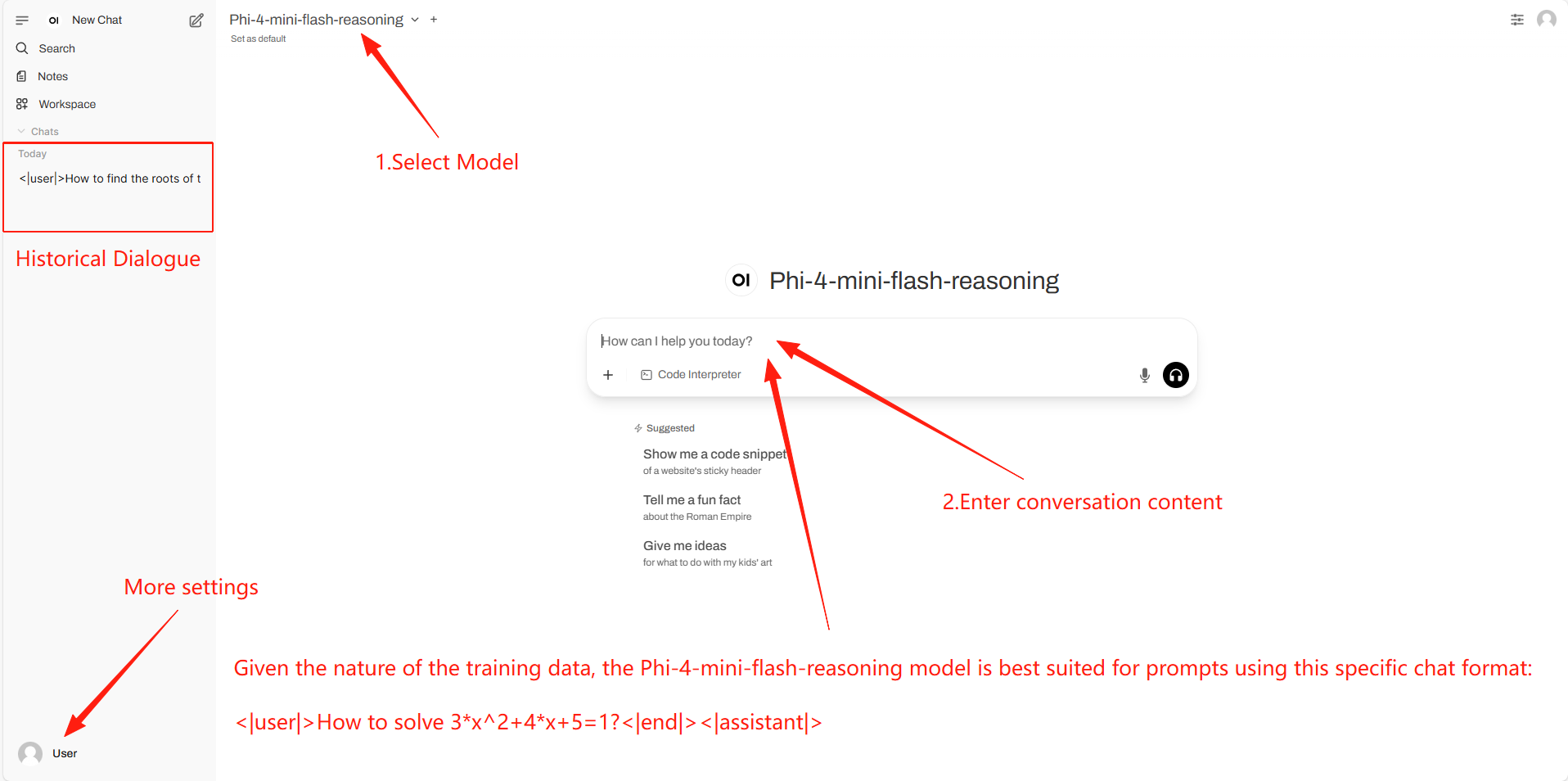

2. 使用手順

「モデル」が表示されない場合は、モデルが初期化中です。モデルのサイズが大きいため、1~3分ほどお待ちいただき、ページを更新してください。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

このプロジェクトの引用情報は次のとおりです。

@software{archscale2025, title={ArchScale: Simple and Scalable Pretraining for Neural Architecture Research}, author={Liliang Ren and Zichong Li and Yelong Shen}, year={2025}, url={https://github.com/microsoft/ArchScale} }@article{ren2025decoder,

title={Decoder-Hybrid-Decoder Architecture for Efficient Reasoning with Long Generation},

author={Liliang Ren and Congcong Chen and Haoran Xu and Young Jin Kim and Adam Atkinson and Zheng Zhan and Jiankai Sun and Baolin Peng and Liyuan Liu and Shuohang Wang and Hao Cheng and Jianfeng Gao and Weizhu Chen and Yelong Shen},

journal={arXiv preprint arXiv:2507.06607},

year={2025}

}