Command Palette

Search for a command to run...

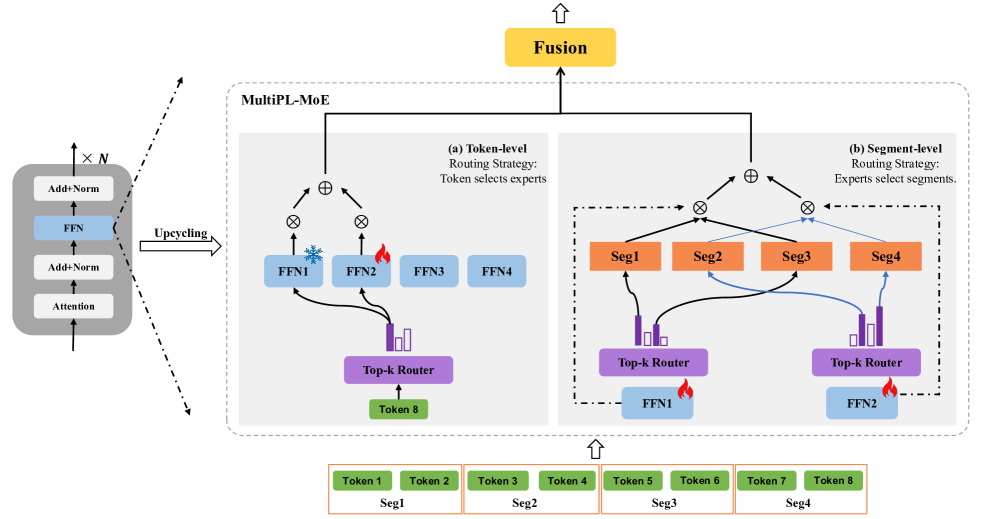

Architecture MultiPL-MoE

MultiPL-MoE a été proposé par l'Institut de recherche China Mobile en août 2025, et les résultats de recherche correspondants ont été publiés dans l'article «MultiPL-MoE : Extension multilingue et multiprogrammation de grands modèles de langage par un mélange hybride d’expertsL'étude a été acceptée par EMNLP 2025.

MultiPL-MoE est une extension multilangage de programmation (MultiPL) des modèles de langages naturels (LLM) implémentée via une approche hybride expert-hybride (MoE). Contrairement aux méthodes MoE précédentes pour les extensions multilangages naturels, qui privilégient la cohérence interne du langage en prédisant les balises suivantes mais négligent la structure syntaxique interne des langages de programmation, MultiPL-MoE emploie une architecture MoE hybride novatrice pour un apprentissage fin des caractéristiques sémantiques au niveau des balises et des caractéristiques syntaxiques au niveau des fragments. Ceci permet au modèle d'inférer la structure du code en reconnaissant et en classant différents éléments syntaxiques.

Créer de l'IA avec l'IA

De l'idée au lancement — accélérez votre développement IA avec le co-codage IA gratuit, un environnement prêt à l'emploi et le meilleur prix pour les GPU.