Command Palette

Search for a command to run...

ScaleNet

ScaleNet wurde im Oktober 2025 von einem Forschungsteam des Beijing Institute of Technology, des Huawei Noah’s Ark Lab und der City University of Hong Kong sowie weiterer Institutionen gemeinsam vorgeschlagen. Die zugehörigen Forschungsergebnisse wurden in einer wissenschaftlichen Arbeit veröffentlicht. ScaleNet: Skalierung vortrainierter neuronaler Netze mit inkrementellen Parametern .

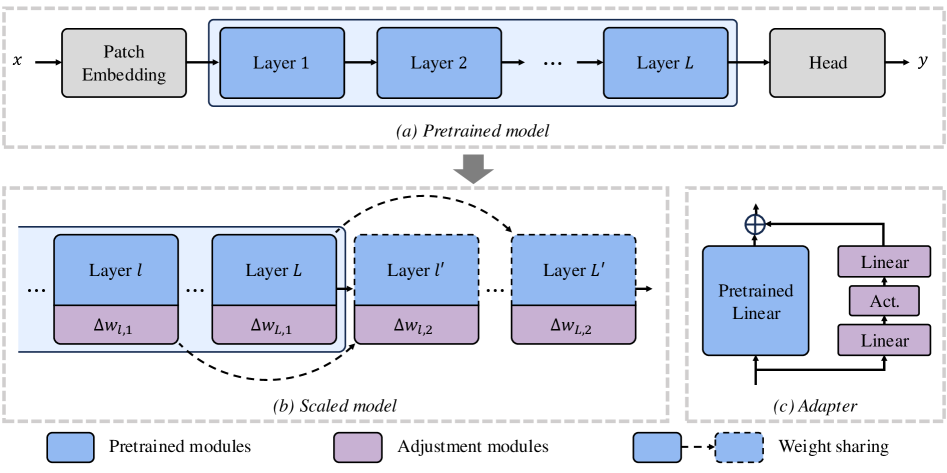

ScaleNet ist eine effiziente Methode zur Skalierung von ViT-Modellen. Im Gegensatz zum traditionellen Training von Grund auf ermöglicht dieses Paradigma eine schnelle Modellskalierung bestehender, vortrainierter Modelle mit minimalem Parameterzuwachs und bietet somit eine kostengünstige Lösung für die ViT-Skalierung. ScaleNet skaliert Modelle, indem es zusätzliche Schichten in vortrainierte ViTs einfügt und dabei die Gewichte schichtweise teilt, um die Parametereffizienz zu erhalten. Umfangreiche Experimente mit dem ImageNet-1K-Datensatz zeigen, dass ScaleNet das Training skalierter Modelle von Grund auf deutlich übertrifft und eine TP3T-Genauigkeitsverbesserung von 7,421 auf einem 2-fach tiefenskalierten DeiT-Base-Modell in nur einem Drittel der Trainingsepochen erzielt.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.