Command Palette

Search for a command to run...

PaddleOCR-VL: Multimodale Dokumentenanalyse

Datum

Größe

21.34 MB

Tags

Lizenz

Apache 2.0

GitHub

Paper-URL

1. Einführung in das Tutorial

PaddleOCR-VL ist ein hochmodernes und ressourcenschonendes Modell, das speziell für die Dokumentenanalyse entwickelt wurde. Kernkomponente ist PaddleOCR-VL-0.9B, ein kompaktes und leistungsstarkes visuelles Sprachmodell (VLM), das einen dynamischen visuellen Encoder im NaViT-Stil mit dem Sprachmodell ERNIE-4.5-0.3B kombiniert und so eine präzise Elementerkennung ermöglicht. Dieses innovative Modell unterstützt 109 Sprachen und zeichnet sich durch die Erkennung komplexer Elemente wie Text, Tabellen, Formeln und Diagramme bei extrem niedrigem Ressourcenverbrauch aus. Umfassende Evaluierungen anhand gängiger öffentlicher und interner Benchmarks belegen die Spitzenleistung von PaddleOCR-VL sowohl bei der seitenweisen Dokumentenanalyse als auch bei der Elementerkennung. Das Modell übertrifft bestehende Lösungen deutlich, ist anderen führenden visuellen Sprachmodellen ebenbürtig und bietet hohe Inferenzgeschwindigkeiten. Diese Vorteile machen es ideal für den praktischen Einsatz. Entsprechende Forschungsarbeiten sind verfügbar. PaddleOCR-VL: Steigerung der mehrsprachigen Dokumentenanalyse durch ein 0,9-B-Ultrakompaktes Bildverarbeitungs- und Sprachmodell .

Dieses Tutorial verwendet eine einzelne RTX 5090-Grafikkarte als Rechenressource.

2. Effektbeispiele

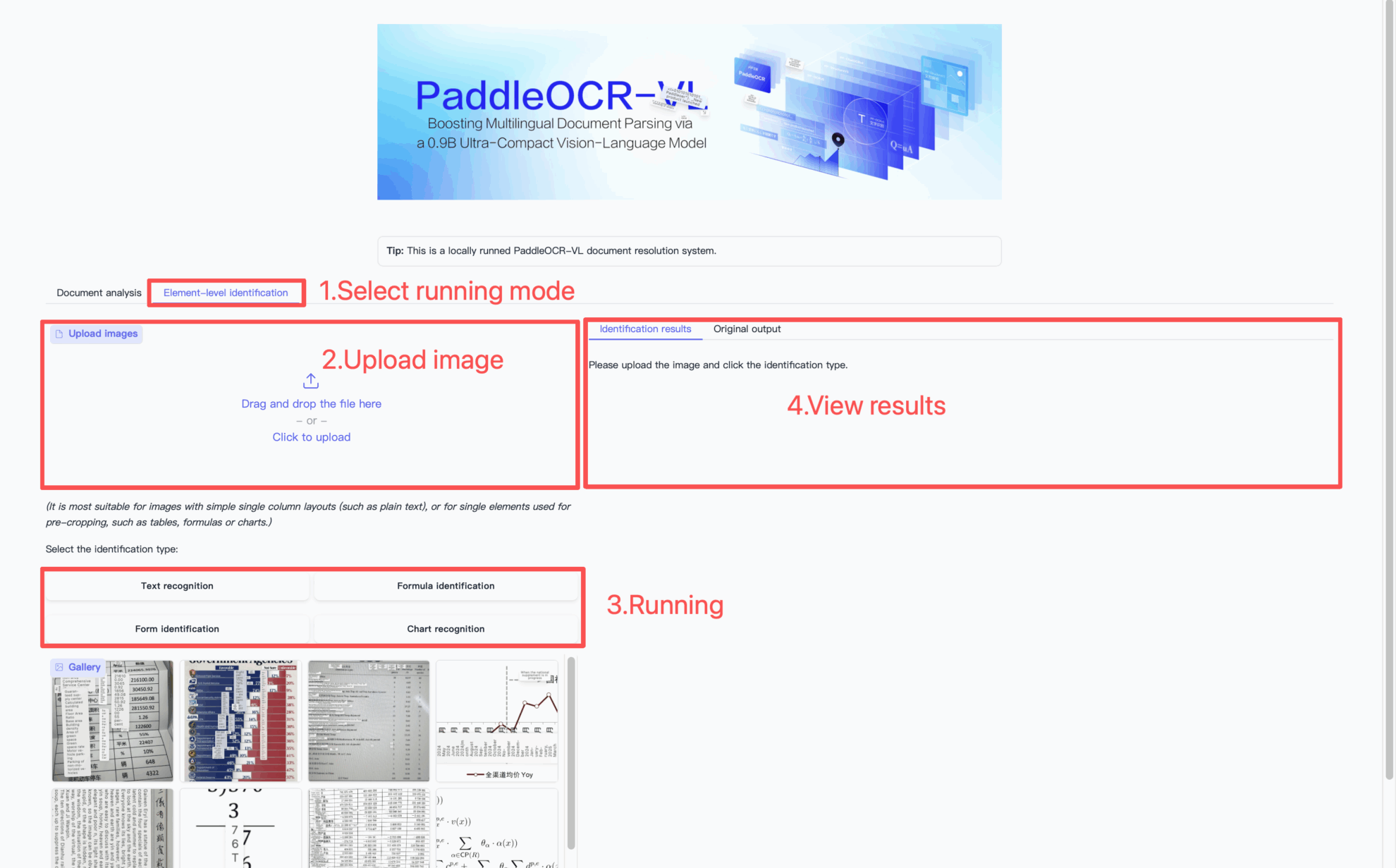

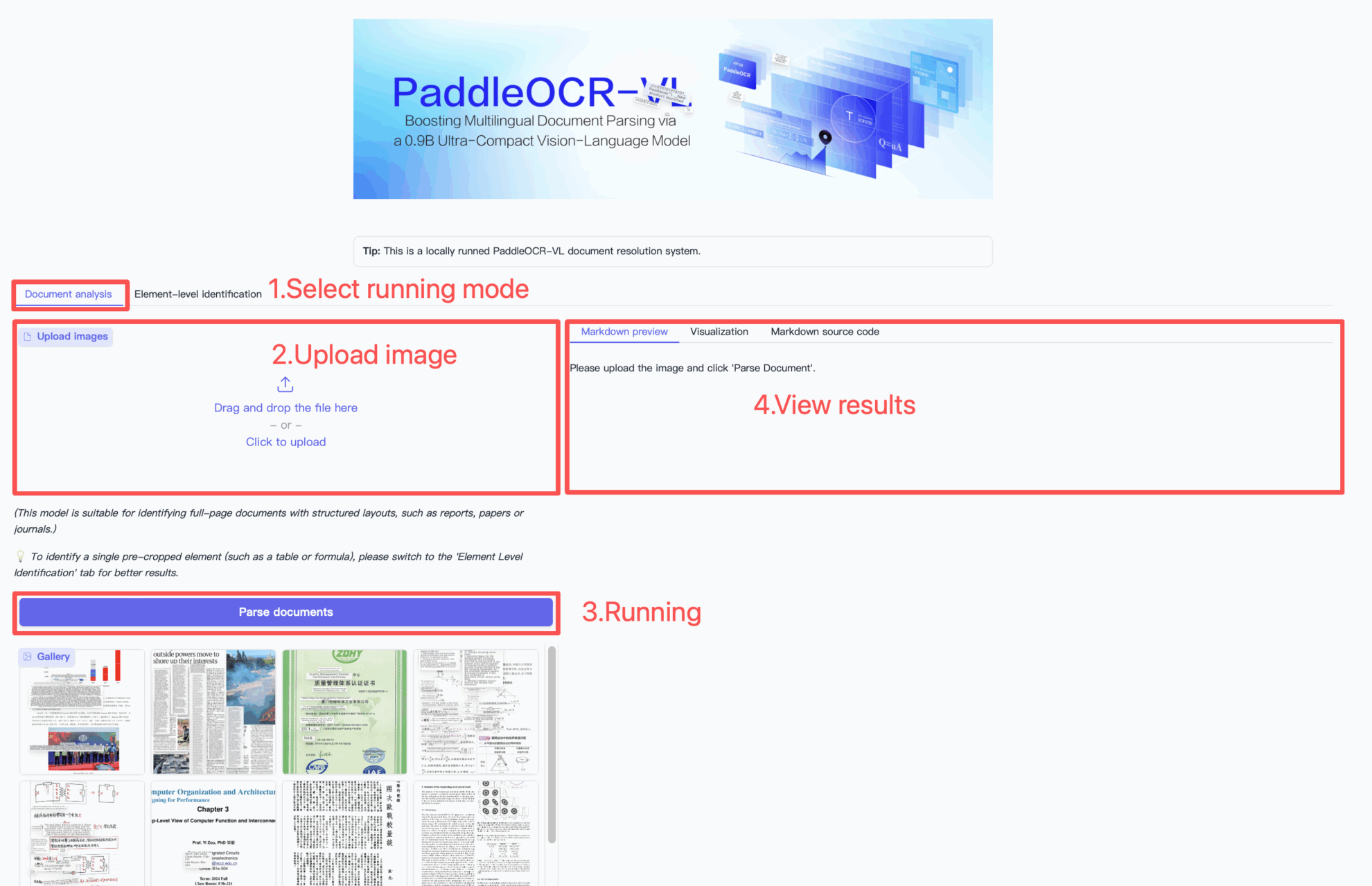

3. Bedienungsschritte

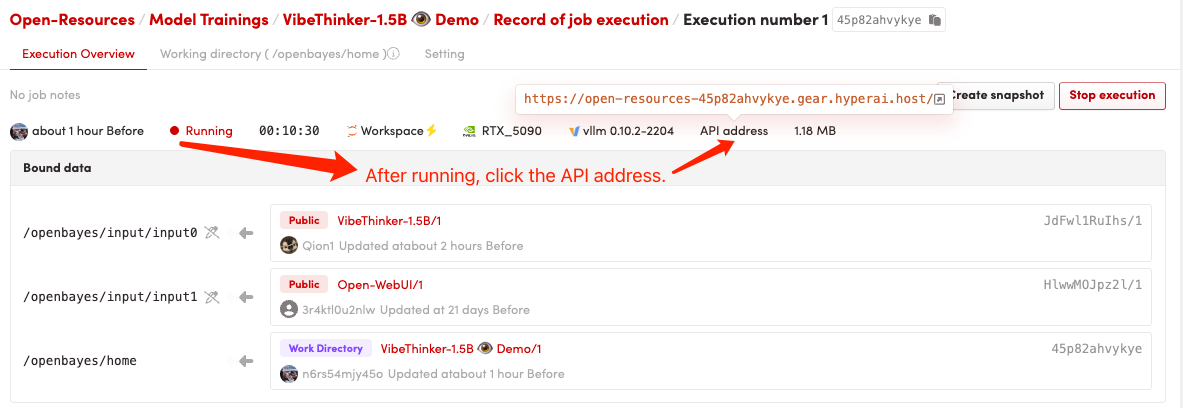

1. Starten Sie den Container

2. Nachdem Sie die Webseite aufgerufen haben, können Sie ein Gespräch mit dem Modell beginnen

Wenn „Bad Gateway“ angezeigt wird, bedeutet dies, dass das Modell initialisiert wird. Da das Modell groß ist, warten Sie bitte etwa 2–3 Minuten und aktualisieren Sie die Seite.

Anwendung

Zitationsinformationen

@misc{cui2025paddleocrvlboostingmultilingualdocument,

title={PaddleOCR-VL: Boosting Multilingual Document Parsing via a 0.9B Ultra-Compact Vision-Language Model},

author={Cheng Cui and Ting Sun and Suyin Liang and Tingquan Gao and Zelun Zhang and Jiaxuan Liu and Xueqing Wang and Changda Zhou and Hongen Liu and Manhui Lin and Yue Zhang and Yubo Zhang and Handong Zheng and Jing Zhang and Jun Zhang and Yi Liu and Dianhai Yu and Yanjun Ma},

year={2025},

eprint={2510.14528},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2510.14528},

}KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.