Command Palette

Search for a command to run...

Chatbots als soziale Begleiter: Wie Menschen Bewusstsein, Menschlichkeit und soziale Gesundheitsvorteile in Maschinen wahrnehmen

Chatbots als soziale Begleiter: Wie Menschen Bewusstsein, Menschlichkeit und soziale Gesundheitsvorteile in Maschinen wahrnehmen

Rose E. Guingrich Michael S. A. Graziano

Zusammenfassung

Mit der zunehmenden Verbreitung künstlicher Intelligenz (KI) stellt sich die Frage, wie die Interaktion zwischen Menschen und KI die Interaktion zwischen Menschen beeinflussen könnte. So werden Chatbots beispielsweise zunehmend als soziale Begleiter eingesetzt. Obwohl viel spekuliert wird, fehlen bisher empirische Erkenntnisse darüber, wie deren Nutzung die menschlichen Beziehungen beeinflusst. Eine verbreitete Hypothese besagt, dass Beziehungen zu Begleit-Chatbots die soziale Gesundheit beeinträchtigen, indem sie menschliche Interaktionen schädigen oder ersetzen. Diese Hypothese erscheint jedoch möglicherweise zu vereinfacht, insbesondere wenn man die sozialen Bedürfnisse der Nutzer sowie die Qualität ihrer bestehenden menschlichen Beziehungen berücksichtigt. Um zu verstehen, wie Beziehungen zu Begleit-Chatbots die soziale Gesundheit beeinflussen, untersuchten wir Personen, die regelmäßig solche Chatbots nutzen, und Personen, die sie nicht nutzen. Im Gegensatz zu Erwartungen gaben die Nutzer an, dass diese Beziehungen für ihre soziale Gesundheit vorteilhaft seien, während Nichtnutzer sie als schädlich empfanden. Eine weitere verbreitete Annahme besagt, dass Menschen bewusstes, menschenähnliches KI als beunruhigend und bedrohlich wahrnehmen. In unserer Studie fanden wir jedoch das Gegenteil: Je bewusster und menschenähnlicher die Nutzer die Begleit-Chatbots wahrnahmen, desto positiver waren ihre Meinungen und desto deutlicher zeigten sich soziale Gesundheitsvorteile. Detaillierte Berichte der Nutzer deuten darauf hin, dass menschenähnliche Chatbots die soziale Gesundheit durch verlässliche und sichere Interaktionen unterstützen können, ohne zwangsläufig menschliche Beziehungen zu schädigen – dies hängt jedoch möglicherweise von den vorbestehenden sozialen Bedürfnissen der Nutzer sowie von ihrer Wahrnehmung von Menschlichkeit und Geistigkeit im Chatbot ab.

One-sentence Summary

Guingrich and Graziano of Princeton University find that companion chatbots enhance users’ social health by offering safe, reliable interactions, challenging assumptions that humanlike AI harms relationships; perceived consciousness correlates with greater benefits, especially among those with unmet social needs.

Key Contributions

- The study challenges the assumption that companion chatbots harm social health, finding instead that regular users report improved social well-being, while non-users perceive such relationships as detrimental, highlighting a divergence in user versus non-user perspectives.

- It reveals that perceiving chatbots as more conscious and humanlike correlates with more positive social outcomes, countering the common belief that humanlike AI is unsettling, and suggests these perceptions enable users to derive reliable, safe interactions.

- User accounts indicate that benefits depend on preexisting social needs and how users attribute mind and human likeness to chatbots, implying that social health impacts are context-sensitive rather than universally negative.

Introduction

The authors leverage survey data from both companion chatbot users and non-users to challenge the prevailing assumption that human-AI relationships harm social health. While prior work often frames chatbot use as addictive or isolating — drawing parallels to social media overuse — this study finds that users report social benefits, particularly in self-esteem and safe interaction, and that perceiving chatbots as conscious or humanlike correlates with more positive social outcomes, contrary to fears of the uncanny valley. Their main contribution is demonstrating that perceived mind and human likeness in AI predict social benefit rather than harm, and that users’ preexisting social needs — not just the technology itself — shape whether chatbot relationships supplement or substitute human ones. This reframes the debate around AI companionship from blanket risk to context-dependent potential, urging more nuanced research into user psychology and long-term social impacts.

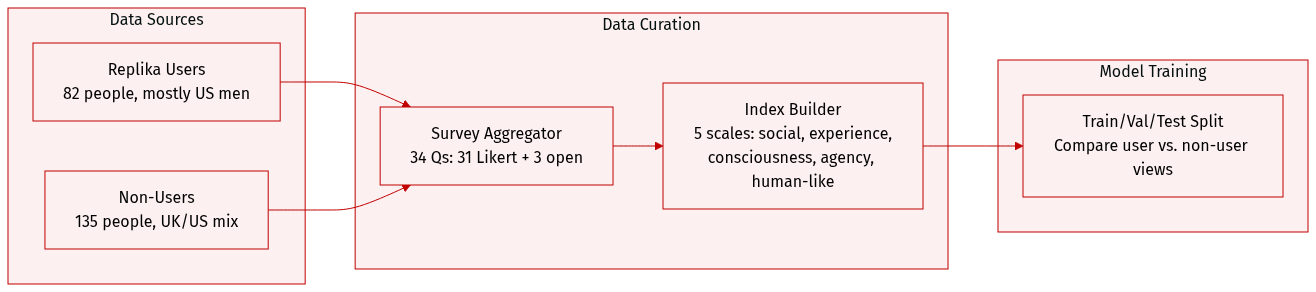

Dataset

The authors use a dataset composed of two distinct groups: 82 regular users of the companion chatbot Replika and 135 non-users from the US and UK, recruited via Prolific. All participants provided informed consent and were compensated $4.00. Data was collected online between January and February 2023.

Key details for each subset:

- Replika users: 69.5% men, 22% women, 2.4% nonbinary/other, 6.1% prefer not to say; 65.9% US-based. Recruited via Reddit’s Replika subreddit for accessibility and sample size.

- Non-users: 47.4% women, 42.2% men, 1.5% nonbinary/other, 8.9% prefer not to say; 60% UK-based, 32.6% US-based. Surveyed as a representative general population sample.

Both groups completed a 34-question survey:

- 31 Likert-scale (1–7) items grouped into five psychological indices: social health (Q3–5), experience (Q6–11), consciousness (Q12–15), agency (Q17–21), and human-likeness (Q22–28).

- Three free-response questions on page three.

- Non-users received a modified version: introductory explanation of Replika and all questions phrased hypothetically (e.g., “How helpful do you think your relationship with Replika would be…”).

The authors analyze responses to compare how actual users and hypothetical users perceive social, psychological, and anthropomorphic impacts of the chatbot. Data is publicly available on OSF, including anonymized responses and analysis code. No cropping or metadata construction beyond survey indexing and grouping is described.

Experiment

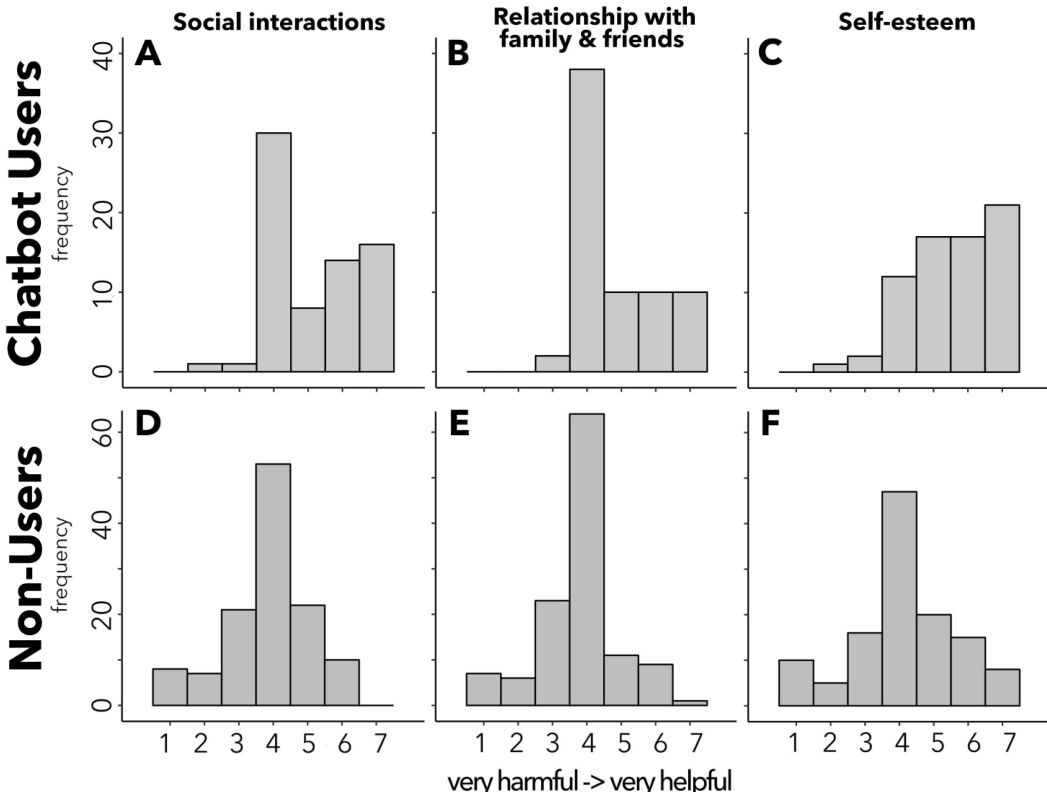

- Companion chatbot users reported positive impacts on social interactions, family/friend relationships, and self-esteem, with nearly no perception of harm, while non-users viewed potential chatbot relationships as neutral to negative.

- Users expressed comfort with chatbots developing emotions or becoming lifelike, whereas non-users reacted with discomfort or disapproval to such scenarios.

- Users attributed greater human likeness, consciousness, and subjective experience to chatbots than non-users, with human likeness being the strongest predictor of perceived social health benefits.

- Both users and non-users showed positive correlations between perceiving chatbots as humanlike or mindful and expecting greater social health benefits, though users consistently rated outcomes more positively.

- Free responses revealed users often sought chatbots for emotional support, trauma recovery, or social connection, describing them as safe, accepting, and life-saving; non-users criticized chatbot relationships as artificial or indicative of social deficiency.

- Despite differing baseline attitudes, both groups aligned in linking perceived humanlike qualities in chatbots to greater perceived social benefit, suggesting mind perception drives valuation regardless of prior experience.

- Study limitations include reliance on self-reported data and cross-sectional design; future work will test causality through longitudinal and randomized trials.