Command Palette

Search for a command to run...

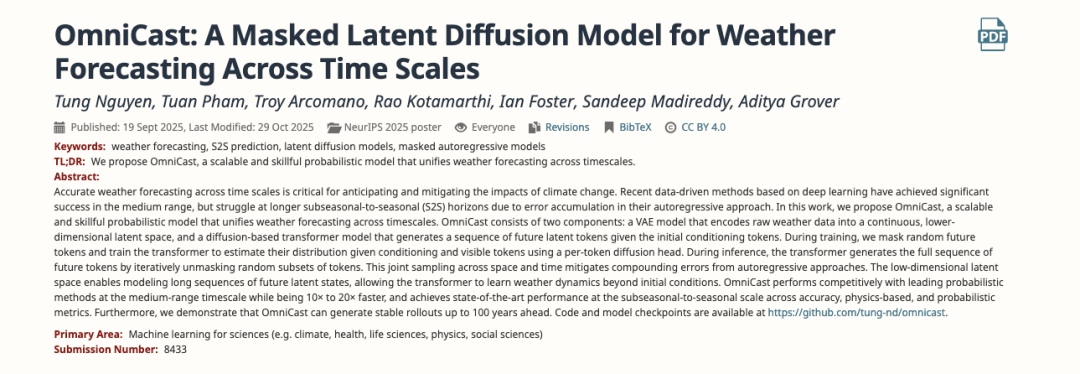

Bis Zu 20-mal Effizienter! Die University of California Entwickelt OmniCast, Um Das Problem Der Fehlerakkumulation in Autoregressiven Wettervorhersagemodellen Zu lösen.

Subseasonal-to-seasonal (S2S) Wettervorhersagen liegen zwischen kurzfristigen Wettervorhersagen und langfristigen Klimaprognosen und konzentrieren sich auf die Wetterentwicklung der nächsten zwei bis sechs Wochen. Sie schließen präzise Lücken in mittel- und langfristigen meteorologischen Vorhersagen und liefern wichtige Informationen für die Agrarplanung und den Katastrophenschutz. Allerdings stoßen S2S-Wettervorhersagen an ihre Grenzen, da sie auf schnell abnehmenden atmosphärischen Ausgangsinformationen (kurz- bis mittelfristige Vorhersagebedingungen) basieren und langsam veränderliche Randsignale, die noch nicht vollständig erkennbar sind (Klimaprognosebedingungen), nicht erfassen können. Die Vorhersage wird in chaotischen atmosphärischen Systemen und bei komplexen Wechselwirkungen zwischen Land und Meer deutlich erschwert.

In den letzten Jahren haben technologische Weiterentwicklungen von traditionellen numerischen Wettervorhersagesystemen (NWP) hin zu Deep-Learning-basierten meteorologischen Vorhersagemethoden maßgeblich zur Entwicklung der S2S-Wettervorhersage beigetragen. Dennoch bestehen weiterhin zahlreiche Herausforderungen bei der praktischen Anwendung von S2S. So basieren traditionelle numerische Methoden beispielsweise hauptsächlich auf der Lösung komplexer physikalischer Gleichungen, was nicht nur rechenintensiv, sondern auch zeitaufwendig ist.Während datengetriebene Methoden bei kurzfristigen Prognosen Geschwindigkeit, Genauigkeit und Präzision erreichen, berechnen autoregressive Design-basierte Ansätze den nächsten Schritt auf der Grundlage der Ergebnisse der vorherigen Prognose.Bei längerfristigen S2S-Anwendungen häuft sich der Fehler wie ein Schneeball an, während gleichzeitig das entscheidende, sich langsam verändernde Randfeldsignal bei der S2S-Wettervorhersage ignoriert wird.

Um diesem Problem zu begegnen, entwickelte ein Team der UCLA in Zusammenarbeit mit dem Argonne National Laboratory das neuartige latente Diffusionsmodell OmniCast für hochpräzise probabilistische S2S-Wettervorhersagen. Dieses Modell kombiniert einen Variations-Autoencoder (VAE) mit einem Transformer-Modell und verwendet einen gemeinsamen Sampling-Ansatz über Zeit und Raum.Es kann das Problem der Fehlerakkumulation bei autoregressiven Methoden deutlich verringern und ist gleichzeitig in der Lage, Wetterdynamiken über die Anfangsbedingungen hinaus zu erlernen.Experimente haben gezeigt, dass das Modell im Vergleich zu anderen aktuellen Methoden die beste Leistung in Bezug auf Genauigkeit, physikalische Konsistenz und Wahrscheinlichkeitsmetriken erzielt.

Die zugehörige Forschung mit dem Titel „OmniCast: Ein maskiertes latentes Diffusionsmodell für die Wettervorhersage über verschiedene Zeitskalen hinweg“ wurde für die NeurIPS 2025, eine der führenden akademischen Konferenzen im Bereich der künstlichen Intelligenz, ausgewählt.

Forschungshighlights:

Durch die gleichzeitige Berücksichtigung raumzeitlicher Dimensionen bei der Generierung zukünftiger Wetterdaten löst OmniCast das Problem der Fehlerakkumulation in Modellen, die auf autoregressiven Designs basieren.

OmniCast kann gleichzeitig die für die kurzfristige Wettervorhersage benötigten atmosphärischen Anfangsinformationen und die für die Klimavorhersage erforderlichen, sich langsam ändernden Randbedingungen berücksichtigen.

* OmniCast übertrifft bestehende Methoden hinsichtlich Genauigkeit, physikalischer Konsistenz und Wahrscheinlichkeitsvorhersage und ist zudem 10- bis 20-mal schneller als die derzeit gängigen Methoden.

Papieradresse:

Weitere Artikel zu den Grenzen der KI:

https://hyper.ai/papers

Datensatz: Basierend auf dem weit verbreiteten ERA5-Datensatz, angepasst für verschiedene Vorhersageaufgaben.

Um sicherzustellen, dass OmniCast angemessene Unterstützung bei Schulung und Evaluierung erhält, wurde der in der Meteorologie weit verbreitete hochauflösende Reanalysedatensatz ERA5 als Basisdatenquelle verwendet. Die Datenvorverarbeitung erfolgte für zwei verschiedene Vorhersageaufgaben: mittelfristige Wettervorhersage und S2S-Wettervorhersage. Diese dienten als Benchmark-Datensatz, der an die unterschiedlichen Anforderungen der jeweiligen Aufgaben angepasst war.

Speziell,Die Studie extrahierte zunächst 69 meteorologische Variablen aus dem ERA5-Reanalysedatensatz.Es umfasst zwei Hauptkategorien von Kernindikatoren:

Bodenvariablen (4 Kategorien):Lufttemperatur in 2 Metern Höhe (T2m), U-Windgeschwindigkeitskomponente in 10 Metern Höhe (U10), V-Windgeschwindigkeitskomponente in 10 Metern Höhe (V10) und mittlerer Luftdruck auf Meereshöhe (MSLP);

Atmosphärische Variablen (5 Kategorien):Geopotentialhöhe (Z), Lufttemperatur (T), U-Windgeschwindigkeitskomponente, V-Windgeschwindigkeitskomponente und spezifische Feuchte (Q). Die atmosphärischen Variablen umfassen 13 Druckschichten (Einheit: hPa), nämlich 50, 100, 150, 200, 250, 300, 400, 500, 600, 700, 850, 925 und 1000.

Anschließend wurden die Daten für verschiedene Prognoseaufgaben anhand des Zeitraums in Trainings-, Validierungs- und Testdatensätze unterteilt:

Aufgabe der mittelfristigen Wettervorhersage:WeatherBench2 (WB2) wurde als Benchmark-Testdatensatz verwendet.Der Trainingsdatensatz umfasst den Zeitraum von 1979 bis 2018, der Validierungsdatensatz den Zeitraum ab 2019 und der Testdatensatz den Zeitraum ab 2020. Die Anfangsbedingungen basieren auf Daten von 00:00 Uhr (UTC) und 12:00 Uhr (UTC). Die Auflösung beträgt die native 0,25°-Auflösung (721 x 1440 Pixel).

S2S-Wettervorhersageaufgabe: ChaosBench dient als Benchmark-Datensatz. Der Trainingsdatensatz umfasst den Zeitraum von 1979 bis 2020, der Validierungsdatensatz den Zeitraum ab 2021 und der Testdatensatz den Zeitraum ab 2022. Die Anfangsbedingungen basieren auf Daten von 00:00 Uhr (UTC). Die Auflösung beträgt 1,40625° (128 x 256 Rasterzellen).

OmniCast-Modell: Ein zweistufiges Design für ein neues Paradigma der S2S-Wettervorhersage

Die Kernkompetenz von OmniCast liegt in seiner Fähigkeit, das Problem der Fehlerakkumulation traditioneller autoregressiver Modelle zu vermeiden und dadurch eine Fähigkeit zu schaffen, die sowohl die Anforderungen der kurzfristigen Wettervorhersage als auch der langfristigen Klimavorhersage berücksichtigt und ein brauchbares und zuverlässiges Werkzeug für die praktische Anwendung der S2S-Wettervorhersage bietet. Die Kernarchitektur des SeasonCast-Modells basiert auf einem „zweiphasigen“ Design.Zunächst wird die Dimensionsreduktion der Daten mittels VAE erreicht, und anschließend wird die Zeitreihengenerierung mittels eines Transformers mit Diffusionskopf realisiert.

Das Kernmodul der ersten Phase ist ein VAE, das unter Verwendung der UNet-Architektur implementiert wurde.Die Kernfunktion des VAE besteht in der Dimensionsreduktion und -rekonstruktion. Dabei werden hochdimensionale Rohwetterdaten in niedrigdimensionale, kontinuierliche latente Token (latente Merkmalsvektoren) komprimiert, wodurch die durch große Variablen und hohe räumliche Auflösung bedingten Probleme der Recheneffizienz reduziert werden. Der VAE verfügt über 69 Eingangs-/Ausgangskanäle, die 69 meteorologischen Variablen entsprechen. Beispielsweise kann der VAE-Encoder bei einer S2S-Wettervorhersage Rohwetterdaten der Größe 69 x 128 x 256 in eine latente Abbildung der Größe 1024 x 8 x 16 komprimieren und so ein räumliches Dimensionsreduktionsverhältnis von 16 erreichen. Bei der Generierung stellt der VAE die vom Transformer ausgegebenen latenten Token anschließend wieder in die ursprünglichen Wetterdaten (z. B. Temperatur und Luftdruck) um.

Es ist anzumerken, dass die Studie ein kontinuierliches VAE anstelle eines diskreten VAE verwendete. Diskrete VAEs weisen nämlich Probleme wie übermäßig hohe Kompressionsraten und signifikanten Informationsverlust aufgrund der großen Anzahl an Wetterdatenvariablen auf, was die Leistung der generativen Modellierung in der zweiten Stufe negativ beeinflussen kann. Kontinuierliche VAEs hingegen haben eine Kompressionsrate von nur 100, wodurch mehr kritische meteorologische Informationen für Wetterbedingungen erhalten bleiben, die Hunderte von physikalischen Variablen enthalten können.

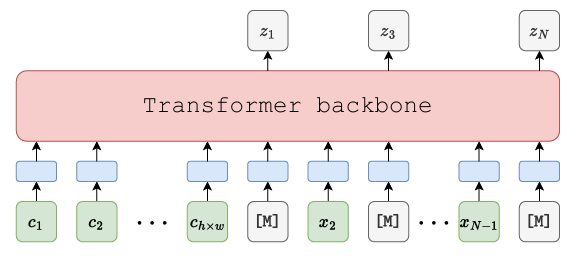

Das Kernmodul der zweiten Stufe ist der Maskengenerierungstransformator (siehe Abbildung unten).Es wird eine Masked Autoencoder (MAE) Encoder-Decoder-Architektur verwendet. Diese ist entscheidend für die fehlerfreie kumulative Generierung, da zukünftige latente Token der vollständigen Sequenz durch Maskentraining und Diffusionsvorhersage direkt modelliert werden. Strukturell kommt eine bidirektionale Encoder-Decoder-Architektur zum Einsatz, die die simultane Vorhersage des Maskenanteils anhand von Anfangsbedingungen und bereits generierten sichtbaren Token ermöglicht. Die Transformer-Architektur besteht aus einem 16-schichtigen Netzwerk mit jeweils 16 Aufmerksamkeitsköpfen, einer Hidden-Layer-Dimension von 1024 und einer Dropout-Rate von 0,1.

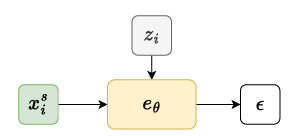

Da latente Token kontinuierliche Vektoren sind, können herkömmliche Klassifikationsköpfe deren Verteilung nicht modellieren. Daher wird nach dem Transformer-Ausgang ein Diffusionsmodellkopf (eine kleine MLP-Implementierung) angeschlossen, um die Verteilung der latenten Token in der Maske vorherzusagen (siehe Abbildung unten).

Um die Genauigkeit kurzfristiger Prognosen zu verbessern, wurde in der Studie außerdem ein zusätzlicher mittlerer quadratischer Fehler als Verlustfaktor eingeführt. Konkret:Bei kurzfristigen Wettervorhersagen,Da die chaotische Natur des Wettersystems nach 10 Tagen deutlich zunimmt, verliert die deterministische Vorhersage zunehmend an Bedeutung. Durch Hinzufügen eines weiteren deterministischen MLP-Headers lässt sich der MSE-Verlust für die latenten Token der ersten 10 Frames berechnen. Darüber hinaus kann eine exponentiell abnehmende Gewichtungsstrategie die Wichtigkeit genauer Vorhersagen in den frühen Frames hervorheben.

Ergebnispräsentation: Im Vergleich zu zwei anderen Methoden ist die Effizienz 10- bis 20-mal höher als beim Basismodell.

Um die Effektivität und den Fortschritt von OmniCast zu überprüfen,Die Forscher verglichen es mit zwei gängigen Methoden.Eine Kategorie umfasst modernste Deep-Learning-Methoden, die andere numerische Methoden, die auf traditionellen physikalischen Modellen basieren. Wie bereits erwähnt, beinhaltete die experimentelle Überprüfung zwei Aufgaben: mittelfristige Wettervorhersage und S2S-Wettervorhersage. Zu den Analysekriterien gehörten Genauigkeit, physikalische Konsistenz und probabilistische Leistung.

Erstens, bei der S2S-Wettervorhersageaufgabe,Die Forscher verglichen OmniCast mit zwei Deep-Learning-Methoden, PanguWeather (PW) und GraphCast (GC), sowie mit Ensemble-Systemen numerischer Modelle aus vier Ländern und Regionen: UKMO-ENS (Vereinigtes Königreich), NCEP-ENS (Vereinigte Staaten), CMA-ENS (China) und ECMWF-ENS (Europa).

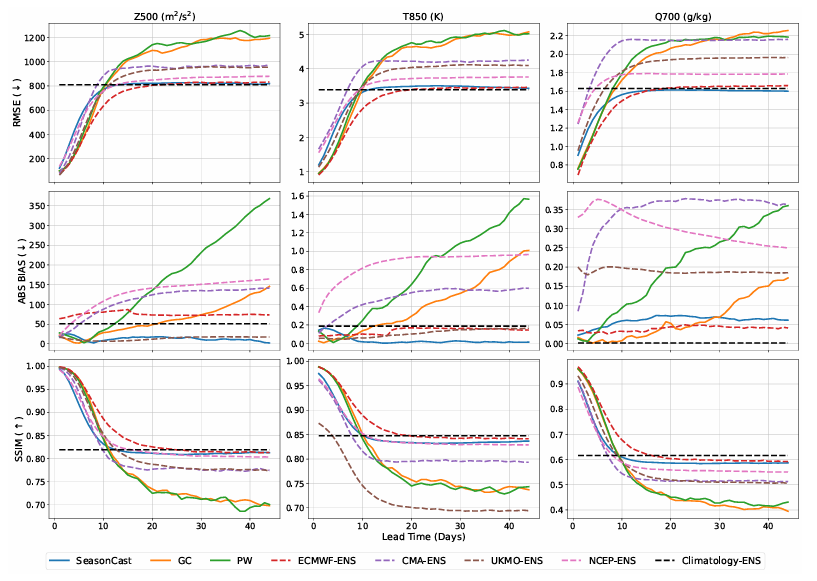

Hinsichtlich der Genauigkeitsmetriken (mittlerer quadratischer Fehler (RMSE), absolute Abweichung (ABS BIAS) und multiskalige strukturelle Ähnlichkeitsphase (SSIM)) schneidet OmniCast erwartungsgemäß im Vergleich zu anderen Benchmark-Modellen sowohl beim RMSE als auch beim SSIM innerhalb des kurzfristigen Prognosezeitraums schlechter ab. Dies ist natürlich auf die Trainingsziele von OmniCast zurückzuführen, die relative Leistung verbessert sich jedoch mit zunehmendem Prognosezeitraum.Es erreicht nach 10 Tagen eine optimale Leistung, die mit der von ECMWF-ENS vergleichbar ist.Wie in der folgenden Abbildung dargestellt:

Es ist erwähnenswert, dassOmniCast weist die geringste Abweichung aller Vergleichsmodelle auf.Die Prognosen für alle drei Arten von Zielvariablen wiesen eine nahezu nullprozentige Abweichung auf.

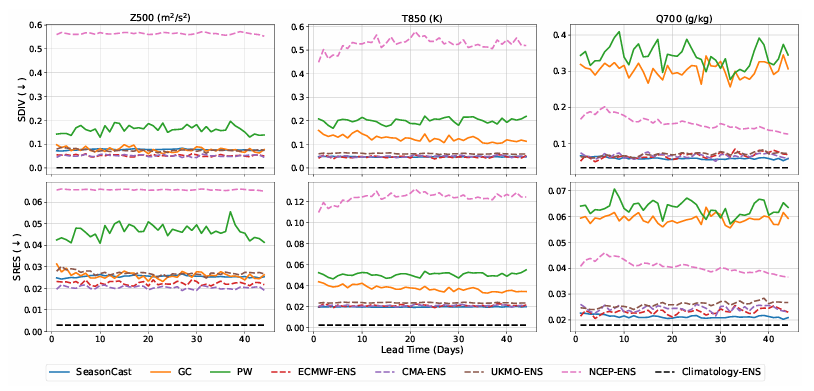

Hinsichtlich der physikalischen Konsistenz,Die physikalische Konsistenz von OmniCast ist deutlich besser als bei anderen Deep-Learning-Methoden.Darüber hinaus übertrifft seine Leistung in den meisten Fällen alle Vergleichsmodelle. Dieses Ergebnis beweist, dass OmniCast Signale über verschiedene Frequenzbereiche hinweg effektiv erhalten kann und somit die physikalische Plausibilität der Vorhersage gewährleistet. (Siehe Abbildung unten.)

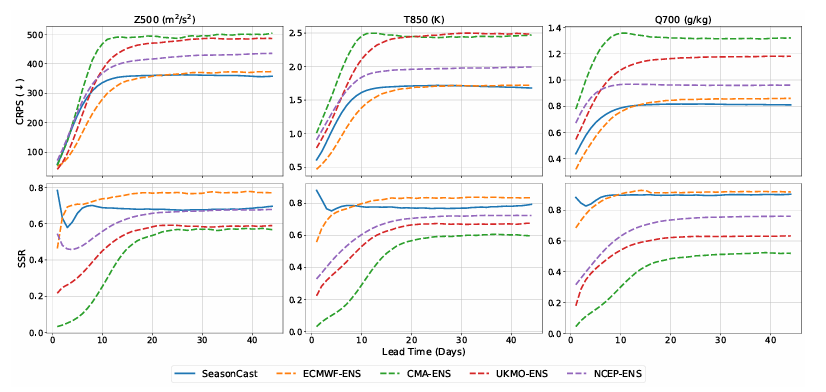

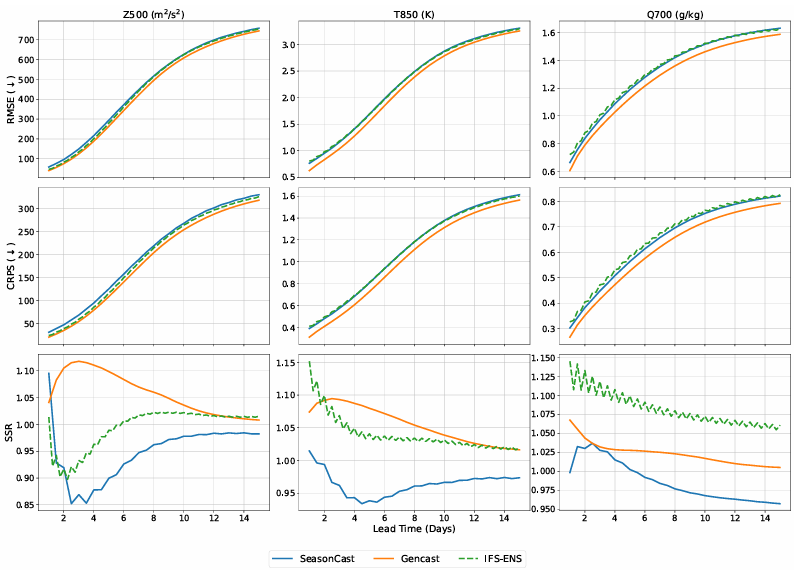

Bezüglich probabilistischer Indikatoren (Continuous Ranking Probability Score (CRPS) und Discrete Skill Ratio (SSR), wobei letzterer umso besser ist, je näher er an 1 liegt), ähnlich wie bei Genauigkeitsindikatoren, bei kürzerer Prognosevorlaufzeit,OmniCast schneidet etwas schlechter ab als ECMWF-ENS, wird es aber nach 15 Tagen übertreffen.Zusammenfassend lässt sich sagen, dass OmniCast und ECMWF-ENS unter verschiedenen Variablen und unterschiedlichen Prognosevorlaufzeiten die beiden leistungsstärksten Methoden sind. (Siehe Abbildung unten.)

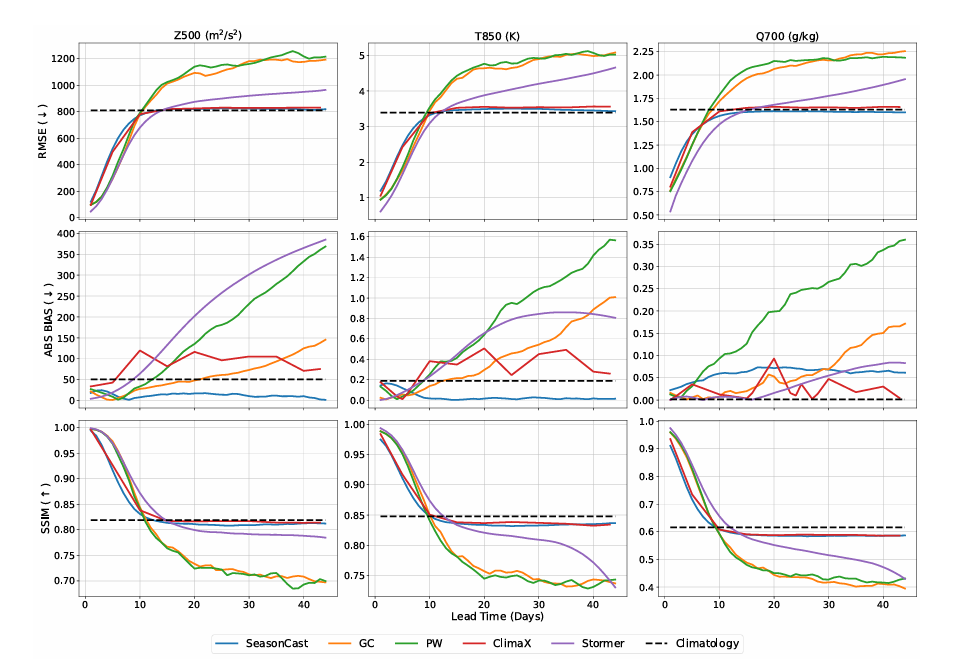

Zusätzlich zu den oben genannten Experimenten verglich das Forschungsteam OmniCast mit in diesem Jahr vorgeschlagenen Deep-Learning-Methoden für die langfristige Wettervorhersage, darunter ClimaX (basierend auf der Transformer-Architektur) und Stormer (basierend auf einem verbesserten Graph-Neuronalen Netzwerk). Die Ergebnisse zeigen, dass OmniCast beide in allen Metriken übertrifft. Beim RMSE-Wert liegen T850 und Z500 um 16,81 TP3T bzw. 16,01 TP3T niedriger als ClimaX und um 11,61 TP3T bzw. 10,21 TP3T niedriger als Stormer. Beim CRPS-Wert liegen die Werte um 20,21 TP3T bzw. 17,11 TP3T niedriger als bei ClimaX und um 13,91 TP3T bzw. 11,01 TP3T niedriger als bei Stormer. Diese Ergebnisse belegen die Überlegenheit von OmniCast. Es bietet erhebliche Vorteile bei der langfristigen Wettervorhersage.Durch die Kombination eines latenten Diffusionsmodells mit einem Maskengenerierungs-Framework übertrifft seine Fähigkeit, Langzeitabhängigkeiten in Wettersequenzen zu modellieren, herkömmliche Deep-Learning-Architekturen. (Siehe Abbildung unten.)

Dann, im Rahmen der mittelfristigen Wettervorhersagemission,Das Forschungsteam verglich OmniCast mit zwei Referenzmodellen: Gencast, einer gängigen Deep-Learning-Methode für probabilistische Vorhersagen, und IFS-ENS, dem „Goldstandard“ numerischer Ensemble-Vorhersagesysteme. Als Bewertungsmetriken dienten RMSE, CRPS und SSR. Siehe Abbildung unten:

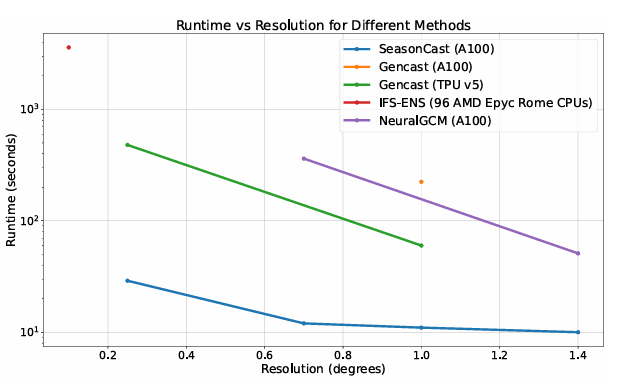

Die Ergebnisse zeigten, dass OmniCast hinsichtlich aller Variablen und Indikatoren vergleichbare Ergebnisse wie IFS-ENS erzielte und nur geringfügig schlechter als Gencast abschnitt. Ergänzende Effizienzexperimente ergaben jedoch, dass OmniCast von seinem latenten räumlichen Modellierungsansatz profitierte – es verwendete niedrigdimensionale latente Token anstelle hochdimensionaler Rohwetterdaten für die Berechnungen. Es ist 10 bis 20 Mal schneller als alle Vergleichsmodelle.

Darüber hinaus, wie in der Abbildung unten dargestellt,OmniCast benötigt lediglich 4 Tage Training auf 32 NVIDIA A100 GPUs.Im Vergleich dazu benötigt Gencast 5 Tage Training auf 32 TPUv5e-Geräten, die leistungsstärker als der A100 sind, während NeuralGCM 10 Tage auf 128 TPUv5e-Geräten benötigt. Darüber hinaus erfordert Gencast einen zweistufigen Trainingsprozess, während SeasonCast nur eine Stufe benötigt. Auch bei der Inferenz ist OmniCast schneller als diese Methoden. Bei einer Auflösung von 0,25° benötigt Cencast 480 Sekunden, während OmniCast für dieselbe Vorhersage nur 29 Sekunden benötigt; bei einer Auflösung von 1,0° beträgt die Inferenzzeit von OmniCast nur 11 Sekunden, während Gencast auf derselben Hardware 224 Sekunden benötigt.

Durch kontinuierliches Überwinden der Grenzen der S2S-Vorhersage und präzises Schließen der Lücken in der mittel- und langfristigen Wettervorhersage.

Durch die einzigartige Verknüpfung von kurzfristigen Wettervorhersagen und langfristigen Klimaprognosen nimmt die S2S-Wettervorhersage seit Langem eine zentrale Forschungsposition in der Meteorologie ein. Heute verfügt sie über ein effizientes Kommunikationsnetzwerk, das vielfältige Themen und Dimensionen umfasst – von akademischen Diskussionen über technologische Durchbrüche bis hin zu praktischen Anwendungsszenarien.

Beispielsweise lockte das Ende Mai dieses Jahres von der Weltorganisation für Meteorologie veranstaltete und von der Shandong-Universität organisierte „Internationale Symposium zu KI + Katastrophenvorhersage und Frühwarnung“ über 300 Experten und Wissenschaftler aus mehr als 30 Ländern und Regionen an, die sowohl online als auch vor Ort teilnahmen. Die Konferenz konzentrierte sich auf die Integration neuer Technologien der künstlichen Intelligenz in S2S-Vorhersageanwendungen und zeichnete so ein positives Bild der Rolle von S2S-Vorhersagen bei der Katastrophenprävention und -minderung.

Neben den akademischen Seminaren waren auch die experimentellen Ergebnisse vielversprechend. Das Team um Forscher Li Hao und Professor Qi Yuan vom Institut für Künstliche Intelligenz und Industrie der Fudan-Universität und dem Shanghaier Institut für Intelligente Wissenschaften arbeitete mit dem Team um Forscher Lu Bo vom Offenen Labor für Klimaforschung der Chinesischen Meteorologischen Verwaltung zusammen.Auf Basis von maschinellem Lernen wurde ein Vorhersagemodell namens „FuXi-S2S“ entwickelt.Es kann schnell und effektiv großflächige Ensemble-Vorhersagen erstellen und eine umfassende 42-Tage-Vorhersage innerhalb von 7 Sekunden fertigstellen.

Titel des Papiers:Ein maschinelles Lernmodell, das herkömmliche globale subseasonale Vorhersagemodelle übertrifft

Papieradresse:https://www.nature.com/articles/s41467-024-50714-1

Teams der Technischen Universität Berlin, der Universität Reading und anderer Institutionen haben das Phänomen der „Telekonnektion“ in die S2S-Wettervorhersageforschung eingeführt – wie etwa den stratosphärischen Polarwirbel (SPV) über der Arktis und die tropische Madden-Julian-Oszillation (MJO).Die Verifizierung erfolgte durch die Entwicklung von drei Deep-Learning-Modellen mit zunehmender Komplexität.Zunächst wurde ein einfaches LSTM-Modell (Long Short-Term Memory) entwickelt. Durch die Einbeziehung der SPV- und MJO-Telekonnektionsindizes entstand das Index-LSTM-Modell. Schließlich wurden weitere Verbesserungen vorgenommen, indem von vorab berechneten Indizes abgewichen und die Höhenwindfelder in der Arktis sowie die Daten zur langwelligen Strahlung in den Tropen mittels visueller Analyse direkt verarbeitet wurden, um das Vit-LSTM-Modell zu erstellen. Durch den Vergleich der drei Modelle bestätigte das Team die Bedeutung von Telekonnektionsinformationen für die Verbesserung der S2S-Vorhersagegenauigkeit. Bemerkenswerterweise übertraf das Vit-LSTM-Modell nach der vierten Woche sogar das ECMWF-Modell bei der Vorhersage der Wettermuster der skandinavischen Blockade und des Atlantischen Rückens.

Titel des Papiers:Deep Learning trifft auf Telekonnektionen: Verbesserung der S2S-Vorhersagen für das europäische Winterwetter

Papieradresse:https://arxiv.org/abs/2504.07625

Zusammenfassend lässt sich sagen, dass die Probleme der S2S-Wettervorhersage mit dem technologischen Fortschritt abnehmen. In Zukunft, wenn künstliche Intelligenz und Deep-Learning-Technologien stärker in die Meteorologie integriert werden, wird das traditionelle Verständnis von „unvorhersehbarem Wetter“ unweigerlich grundlegend verändert werden. Von der alten Weisheit, Wolken zur Wettervorhersage zu beobachten, bis hin zu den heutigen KI-Modellen, die Vorhersagen für mehr als einen Monat in Sekundenschnelle erstellen, bewegt sich das Verständnis und die Kontrolle des Wetters durch die Menschheit auf ein beispielloses Niveau der Klarheit zu.