Command Palette

Search for a command to run...

Omni-MATH Benchmark-Datensatz Für Mathematisches Denken

Datum

Größe

Veröffentlichungs-URL

Paper-URL

* Dieser Datensatz unterstützt die Online-Nutzung.Klicken Sie hier, um zu springen.

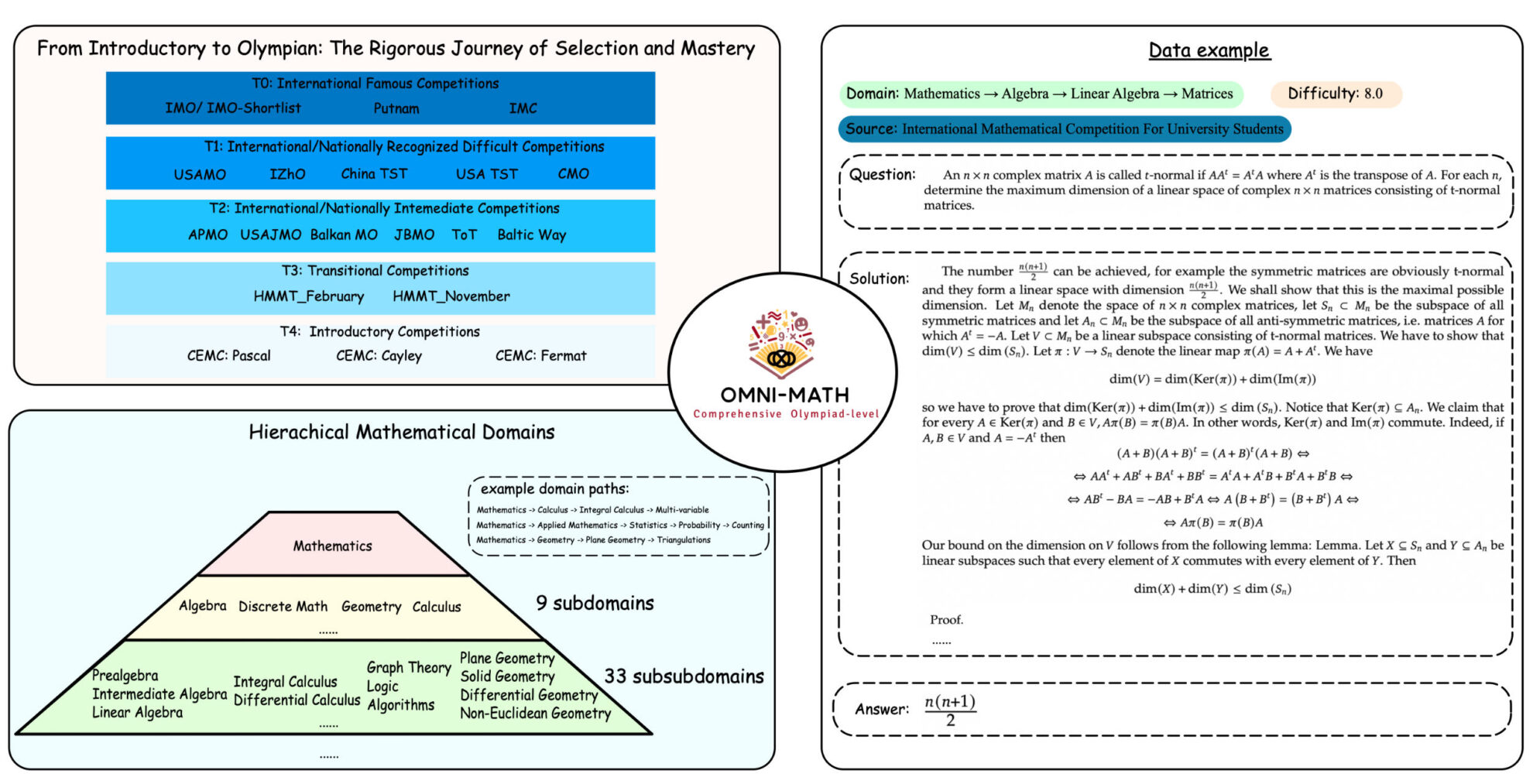

Omni-MATH ist ein von der Peking-Universität und Alibaba entwickelter Benchmark-Datensatz für mathematisches Denken auf Olympiaden-Niveau, der die Leistung großer Sprachmodelle (LLMs) bei mathematischen Problemen auf Olympiaden-Niveau bewerten soll. Die relevanten Papierergebnisse sindOmni-MATH: Ein universeller mathematischer Benchmark auf Olympiadenniveau für große Sprachmodelle".

Dieser Datensatz enthält 4.428 sorgfältig manuell annotierte Mathematikaufgaben auf Wettbewerbsniveau, die 33 Unterbereiche und mehr als 10 verschiedene Schwierigkeitsgrade abdecken, vom Vorbereitungsniveau für die Olympiade bis hin zu den wichtigsten Mathematikwettbewerben der Olympiade wie der IMO (International Mathematical Olympiad), der IMC (International Mathematical Contest) und der Putnam Mathematics Competition.

Der Erstellungsprozess von Omni-MATH umfasst das Sammeln von Daten aus globalen Mathematikwettbewerben und deren Überprüfung durch menschliche Anmerkungen, um die hohe Qualität und Vielfalt der Daten sicherzustellen. Während der Erstellung des Datensatzes verwendete das Forschungsteam GPT-4o, um die Fragen zu klassifizieren und in verschiedene mathematische Felder zu unterteilen, um die Leistung des Modells in verschiedenen mathematischen Feldern zu bewerten.

KI mit KI entwickeln

Von der Idee bis zum Launch – beschleunigen Sie Ihre KI-Entwicklung mit kostenlosem KI-Co-Coding, sofort einsatzbereiter Umgebung und bestem GPU-Preis.