Command Palette

Search for a command to run...

vLLM+Open WebUI 部署 MiniCPM4-8B

一、教程简介

MiniCPM 4.0 是由面壁智能(OpenBMB)于 2025 年 6 月 6 日推出的高效端侧大语言模型(LLM)。通过稀疏架构、量化压缩、高效推理框架等技术,实现了低计算成本下的高性能推理,特别适合长文本处理、隐私敏感场景和边缘计算设备部署。 MiniCPM4-8B 在处理长序列时,相较于 Qwen3-8B 显示出明显更快的处理速度。相关论文成果为 MiniCPM4: Ultra-Efficient LLMs on End Devices 。

本教程采用资源为单卡 RTX 4090 。

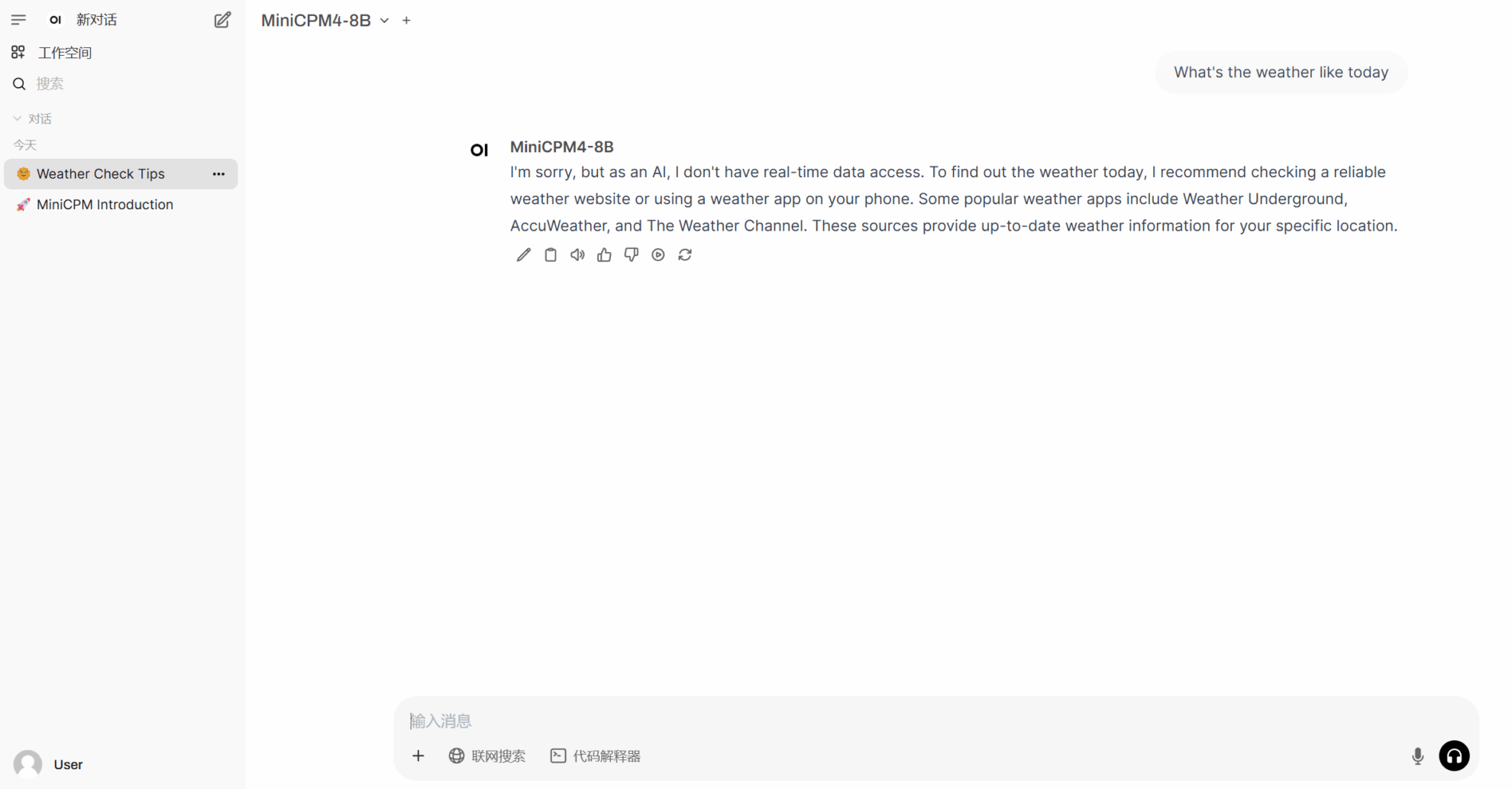

二、项目示例

三、运行步骤

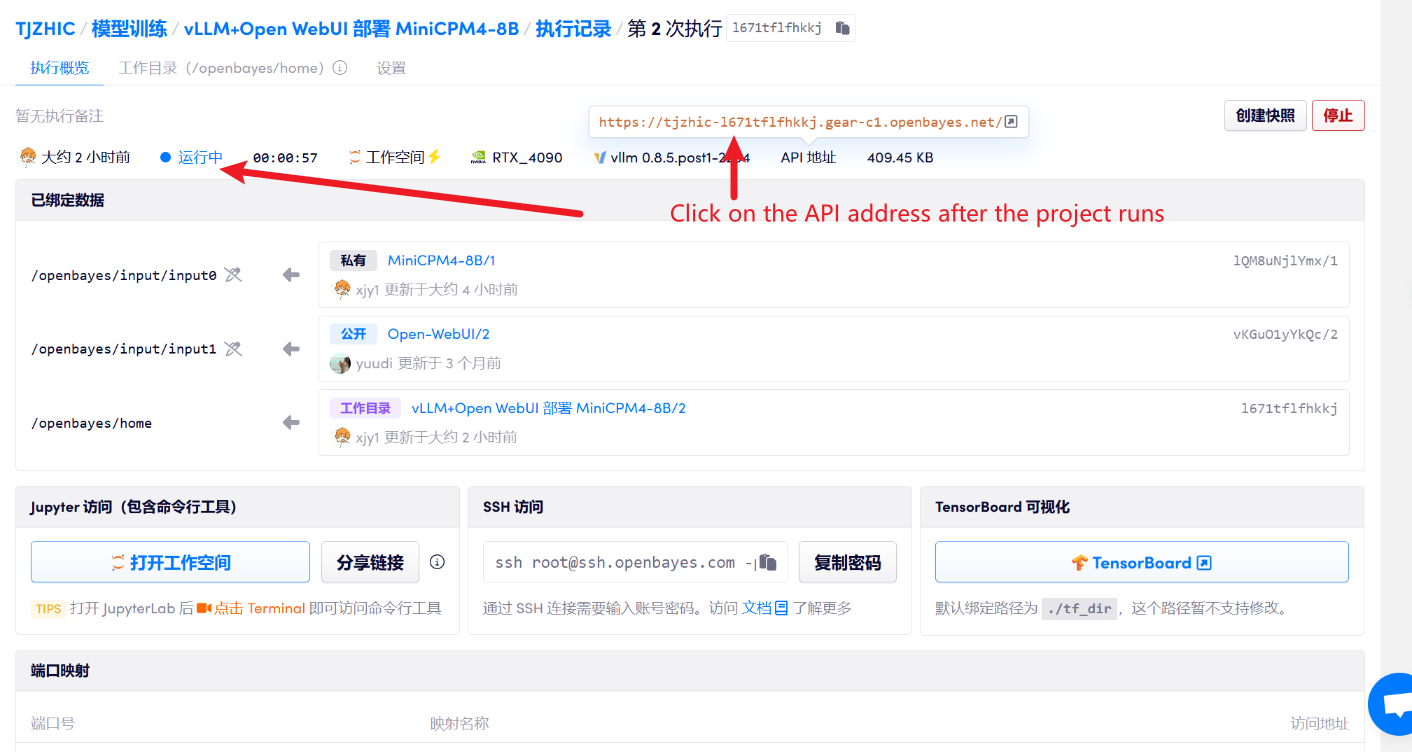

1. 启动容器后点击 API 地址即可进入 Web 界面

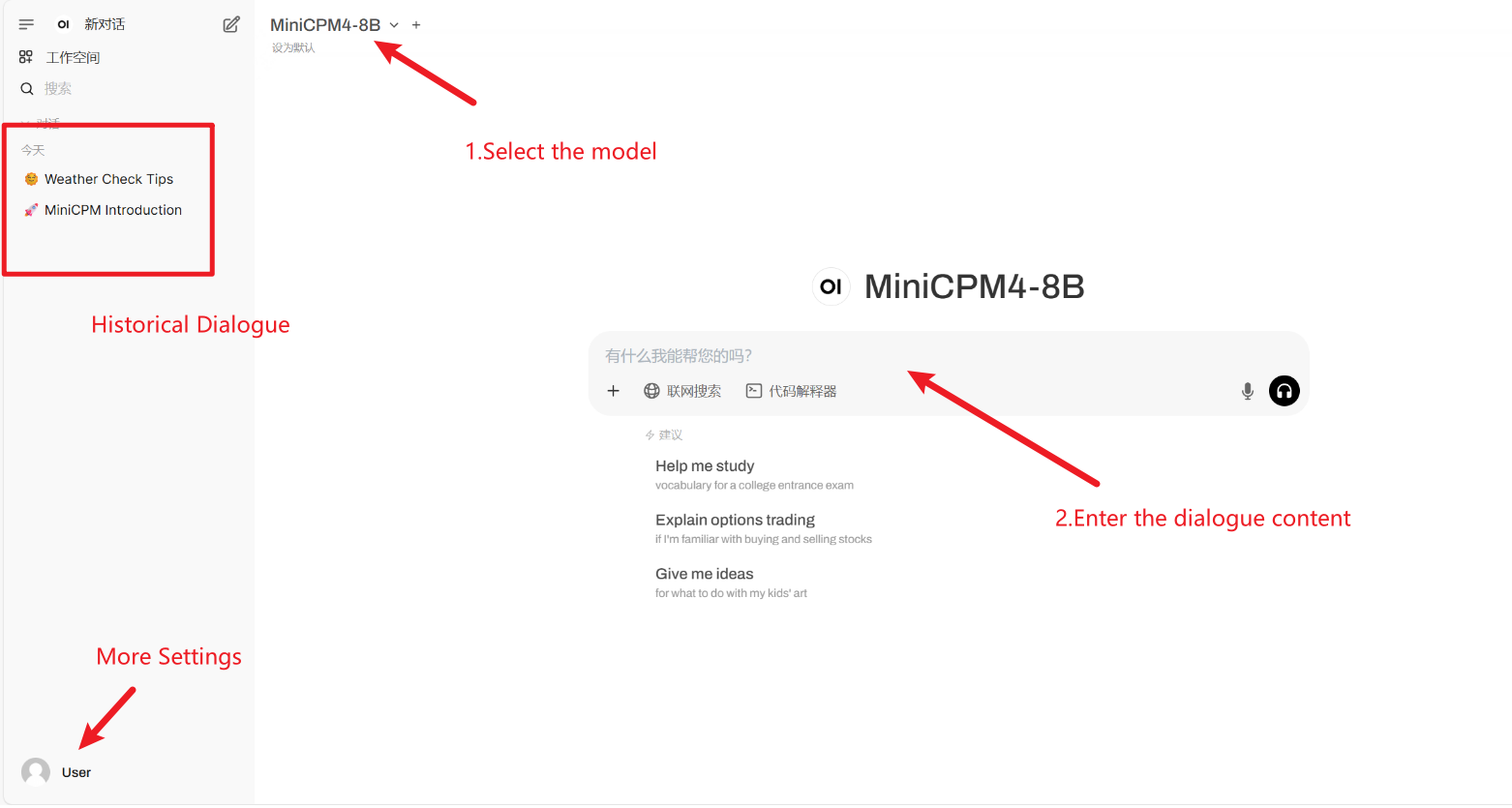

2. 进入网页后,即可与模型展开对话

若不显示「Model」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

使用步骤

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓

引用信息

感谢 Github 用户 xxxjjjyyy1 对本教程的部署。本项目引用信息如下:

@article{minicpm4,

title={MiniCPM4: Ultra-Efficient LLMs on End Devices},

author={MiniCPM Team},

year={2025}

}

@inproceedings{huminicpm,

title={MiniCPM: Unveiling the Potential of Small Language Models with Scalable Training Strategies},

author={Hu, Shengding and Tu, Yuge and Han, Xu and Cui, Ganqu and He, Chaoqun and Zhao, Weilin and Long, Xiang and Zheng, Zhi and Fang, Yewei and Huang, Yuxiang and others},

booktitle={First Conference on Language Modeling},

year={2024}

}