Command Palette

Search for a command to run...

vLLM+Open WebUI 部署 FairyR1-14B-Preview

一、教程简介

FairyR1-14B-Preview 是由北京大学计算机学院杨仝教授团队于 2025 年 5 月发布的轻量高性能模型,专注于数学与代码任务。该模型基于 DeepSeek-R1-Distill-Qwen-32B 基座,通过结合微调与模型合并技术构建。研究探索了在参数量大幅减少的情况下,模型在特定任务上实现与更大模型相当甚至更优性能的可能性。该研究得到了国家自然科学基金委项目(62372009)的资助。

本教程采用资源为单卡 RTX A6000 。

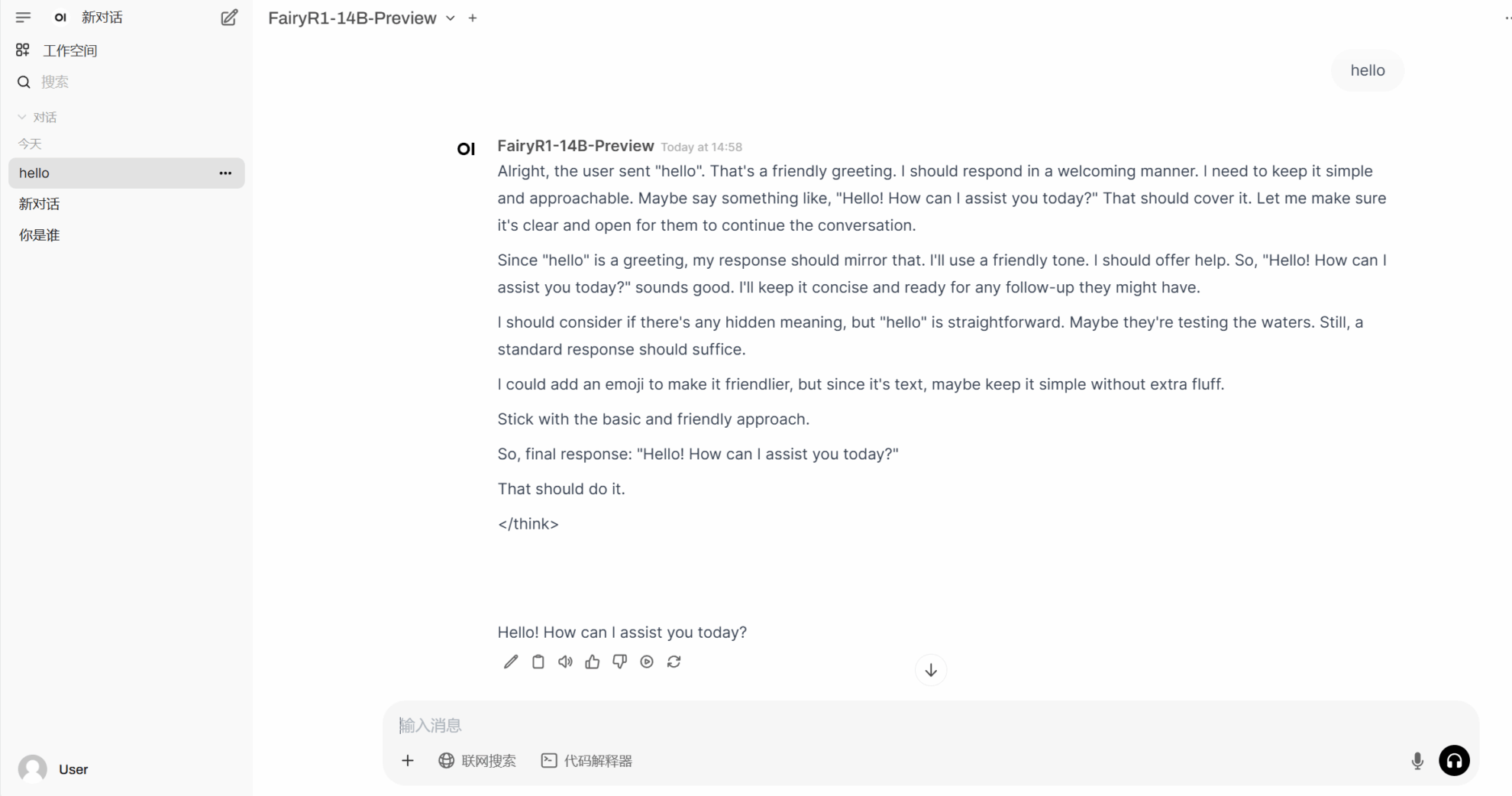

二、项目示例

三、运行步骤

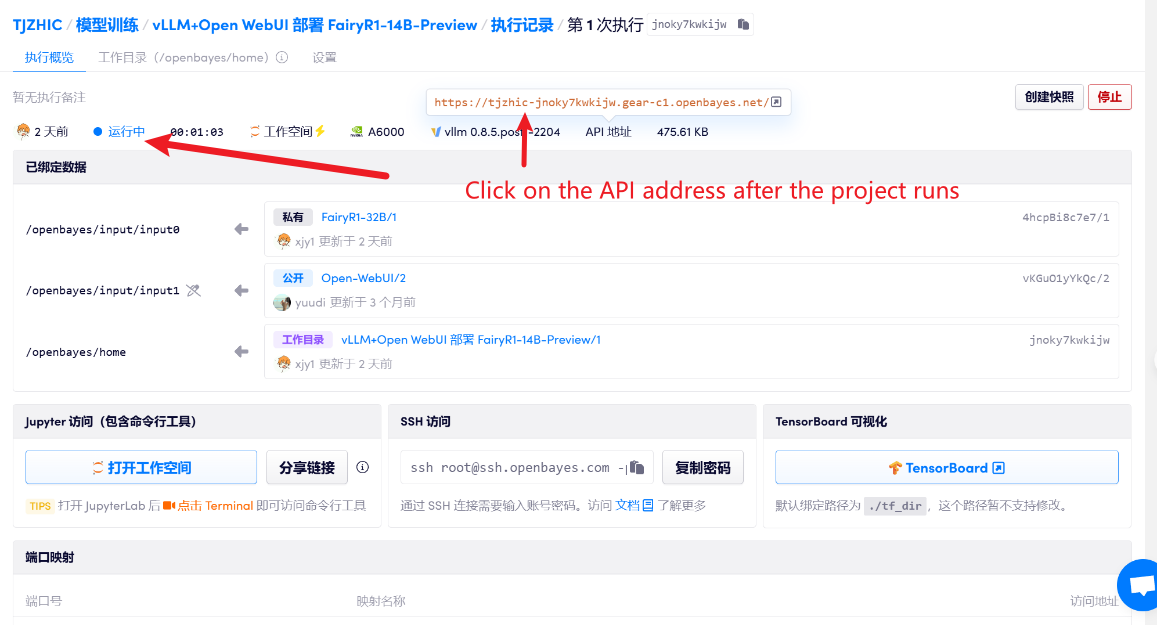

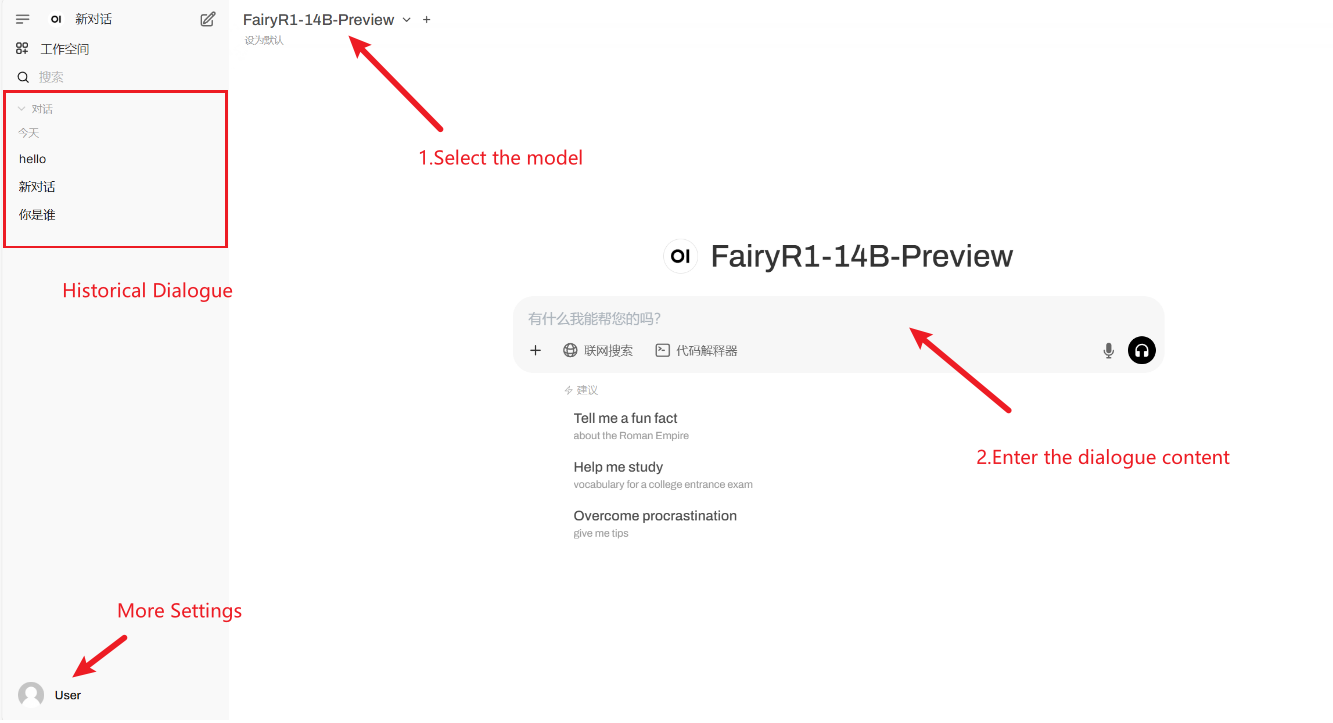

1. 启动容器后点击 API 地址即可进入 Web 界面

2. 进入网页后,即可与模型展开对话

若不显示「Model」,这表示模型正在初始化,由于模型较大,请等待约 2-3 分钟后刷新页面。

使用步骤

四、交流探讨

🖌️ 如果大家看到优质项目,欢迎后台留言推荐!另外,我们还建立了教程交流群,欢迎小伙伴们扫码备注【SD 教程】入群探讨各类技术问题、分享应用效果↓