Command Palette

Search for a command to run...

تراكم التدرج

التاريخ

الوسوم

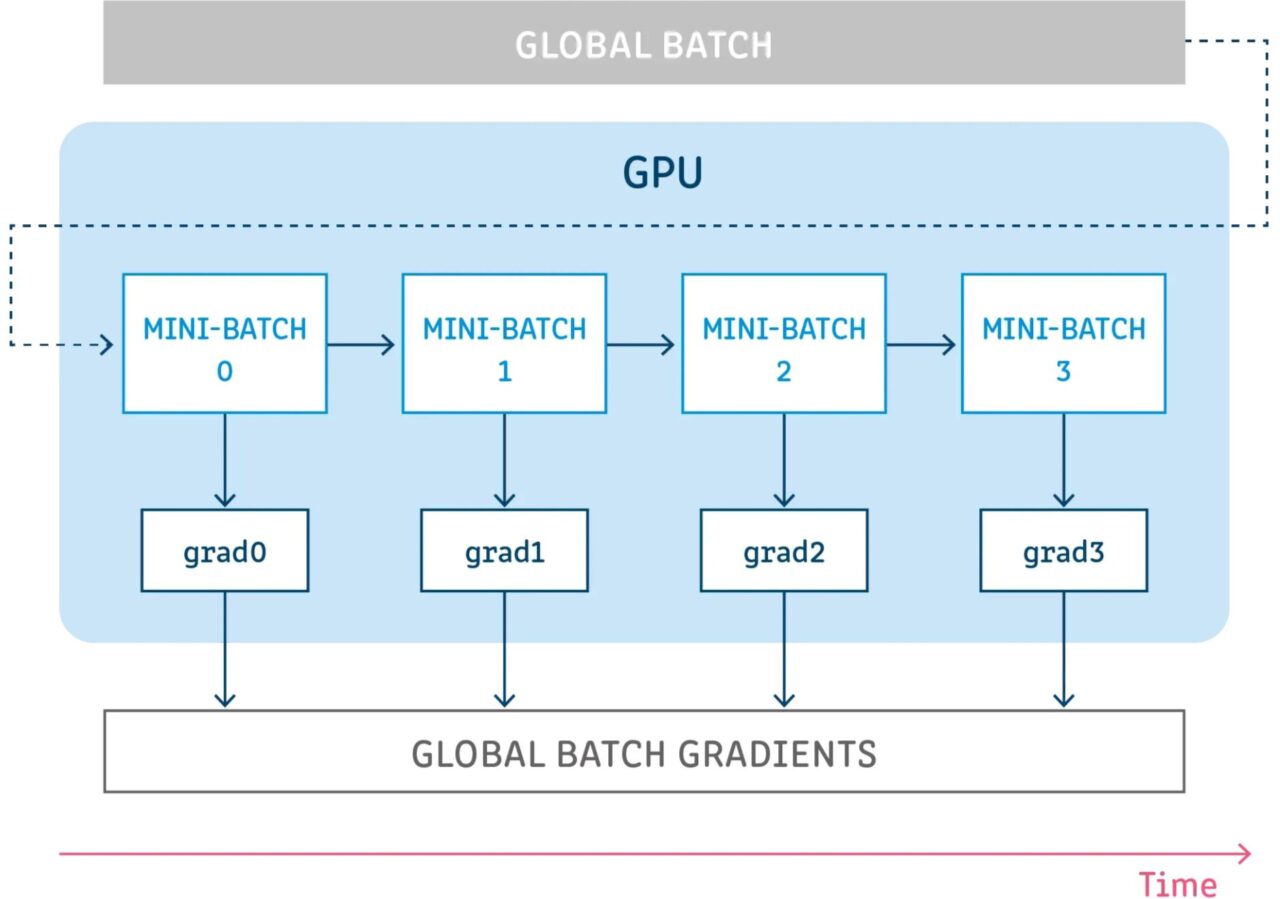

التراكم المتدرج هو آلية لتقسيم دفعة من العينات المستخدمة لتدريب الشبكة العصبية إلى عدة دفعات صغيرة من العينات التي يتم تشغيلها بشكل متسلسل.

قبل مناقشة تراكم التدرج بشكل أكبر، من الجيد مراجعة عملية الانتشار الخلفي للشبكة العصبية.

الانتشار الخلفي للشبكات العصبية

تتكون نماذج التعلم العميق من العديد من الطبقات المترابطة حيث يتم نشر العينات من خلال الانتشار الأمامي في كل خطوة. بعد الانتشار عبر جميع الطبقات، تقوم الشبكة بإنشاء تنبؤات للعينات ثم تحسب قيمة الخسارة لكل عينة، والتي تحدد "مدى خطأ الشبكة فيما يتعلق بهذه العينة". ثم تقوم الشبكة العصبية بحساب تدرجات قيم الخسارة هذه فيما يتعلق بمعلمات النموذج. يتم استخدام هذه التدرجات لحساب التحديثات للمتغيرات المختلفة.

عند بناء نموذج، عليك اختيار مُحسِّن، وهو المسؤول عن الخوارزمية المستخدمة لتقليل الخسارة. يمكن أن يكون المُحسِّن أحد المُحسِّنات الشائعة المُنفَّذة في الإطار (SGD، Adam، وما إلى ذلك) أو مُحسِّنًا مخصصًا ينفذ الخوارزمية المطلوبة. بالإضافة إلى التدرجات، قد يتمكن المحسِّن أيضًا من إدارة واستخدام العديد من المعلمات الأخرى لحساب التحديثات، مثل معدل التعلم، ومؤشر الخطوة الحالية (لمعدل التعلم التكيفي)، والزخم، وما إلى ذلك...

التراكم التدريجي للتكنولوجيا

تعني عملية تراكم التدرج تشغيل تكوين لعدد معين من الخطوات دون تحديث متغيرات النموذج أثناء تجميع التدرجات في تلك الخطوات، ثم استخدام التدرجات المتراكمة لحساب تحديثات المتغيرات.

إن تنفيذ بعض الخطوات دون تحديث أي متغيرات النموذج هي طريقة لتقسيم مجموعة العينات منطقيًا إلى عدة دفعات أصغر. إن دفعة العينات المستخدمة في كل خطوة هي في الواقع دفعة صغيرة، في حين أن العينات من كل هذه الخطوات مجتمعة هي في الواقع الدفعة العالمية.

من خلال عدم تحديث المتغيرات في كل هذه الخطوات، تستخدم جميع الدفعات الصغيرة نفس متغيرات النموذج لحساب التدرجات. يعد هذا سلوكًا إلزاميًا لضمان حساب نفس التدرجات والتحديثات كما لو تم استخدام حجم الدفعة العالمي.

يؤدي تجميع التدرجات في كل هذه الخطوات إلى نفس مجموع التدرجات.

مراجع

【1】https://towardsdatascience.com/ما هو تراكم التدرج في التعلم العميق-ec034122cfa

بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.