Command Palette

Search for a command to run...

Wan2.2-Animate-14B: نموذج مفتوح ومتقدم لتوليد الفيديو واسع النطاق

1. مقدمة البرنامج التعليمي

Wan2.2-Animate-14B هو نموذج مفتوح المصدر لتوليد الحركة، تم تطويره بواسطة فريق تونغي وانشيانغ التابع لشركة علي بابا في سبتمبر 2025. يدعم النموذج نمطي محاكاة الحركة ولعب الأدوار، حيث يُعيد إنتاج تعابير الوجه وحركات الشخصيات من مقاطع الفيديو بدقة عالية، مما يُنتج فيديوهات رسوم متحركة واقعية للغاية. يُمكن للنموذج استبدال الشخصيات المتحركة بسلاسة في الفيديو الأصلي، مع مطابقة مثالية لإضاءة المشهد ودرجات ألوانه. بالاعتماد على نموذج Wan، يتحكم النموذج في حركات الأطراف من خلال إشارات هيكلية مُحاذية مكانيًا، ويُعيد إنشاء التعابير باستخدام ملامح الوجه الضمنية المُستخرجة من الصورة الأصلية، مما يُتيح توليد فيديوهات شخصيات عالية الدقة والتعبير. تتضمن الأبحاث ذات الصلة... وان-أنيميت: رسوم متحركة موحدة للشخصيات واستبدالها بالتكرار الشامل .

يستخدم هذا البرنامج التعليمي بطاقة رسوميات RTX PRO 6000 واحدة كمورد حوسبة.

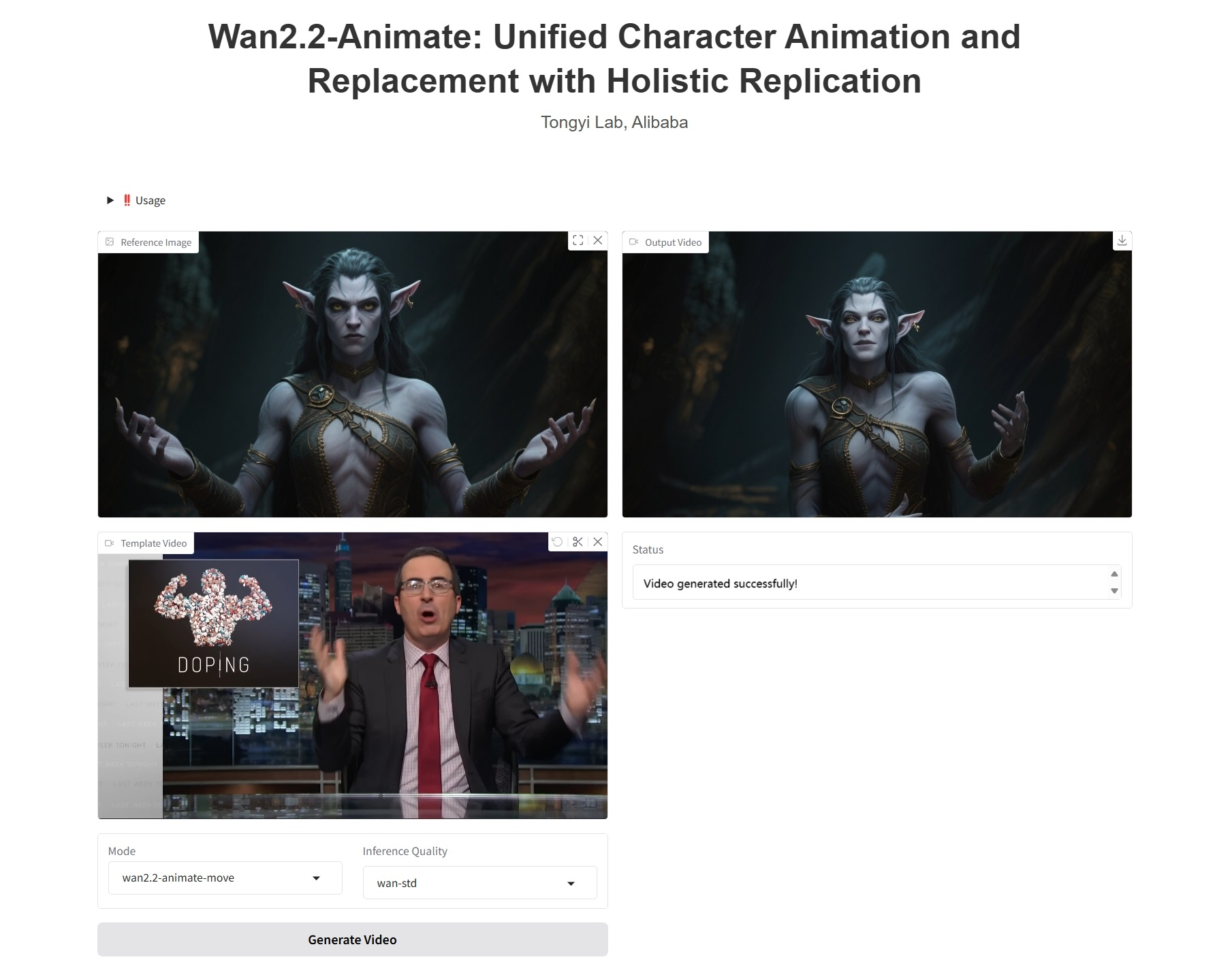

2. عرض التأثير

3. خطوات التشغيل

1. ابدأ تشغيل الحاوية

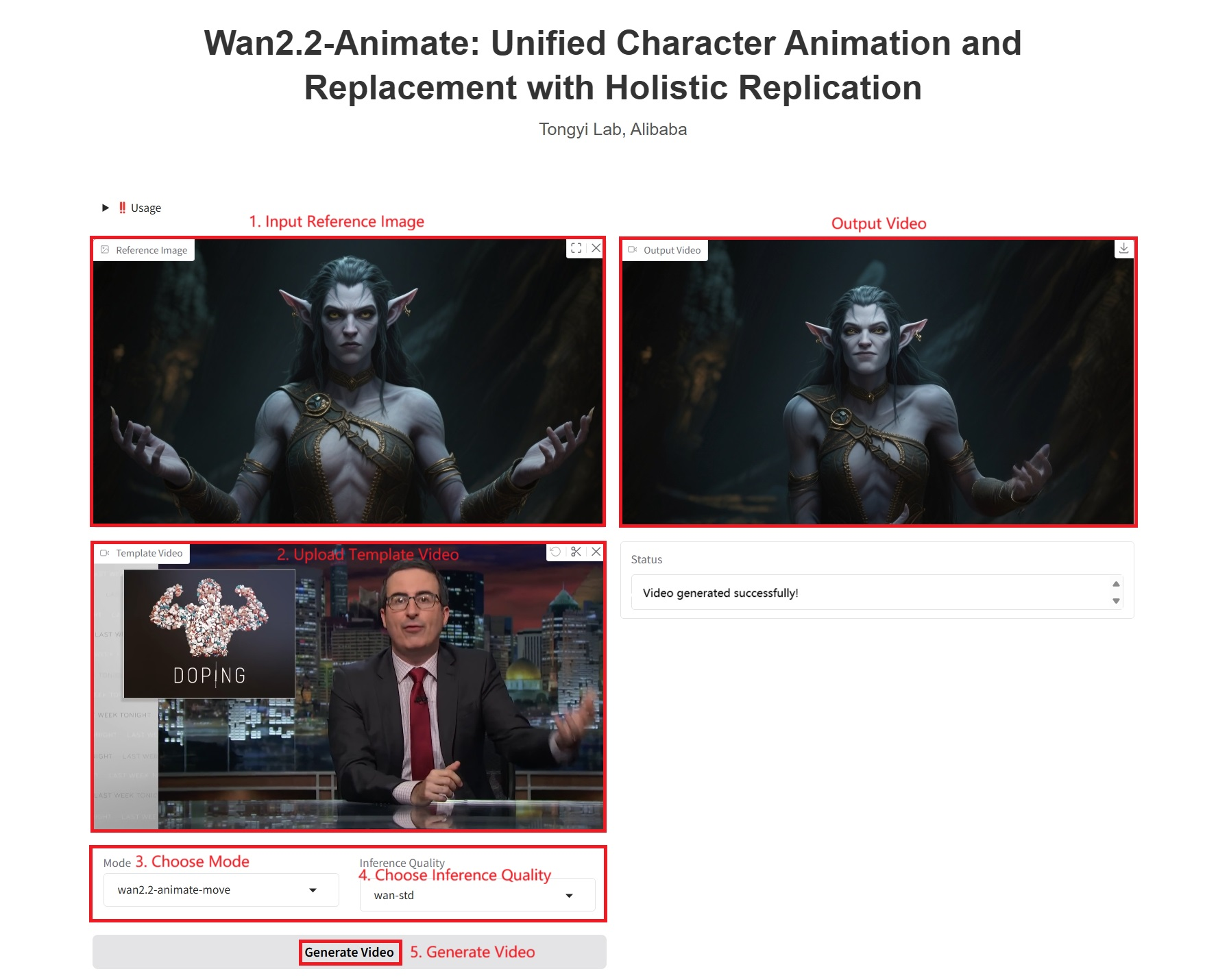

2. خطوات الاستخدام

إذا تم عرض "بوابة سيئة"، فهذا يعني أن النموذج قيد التهيئة. نظرًا لأن النموذج كبير الحجم، يرجى الانتظار لمدة 1-2 دقيقة وتحديث الصفحة.

ملاحظة: عند اختيار جودة الاستدلال، كلما كانت جودة الفيديو المُولّد بواسطة Wan-Pro أفضل، استغرق إنتاجه وقتًا أطول. يستغرق المثال 1 حوالي 1200 ثانية.

المعلمات المحددة:

- وضع:

- wan2.2-animate-move: محاكاة الحركة. يأخذ صورة شخصية وفيديو مرجعيًا كمدخل. ينقل النموذج حركات الشخصية وتعبيراتها من الفيديو المرجعي إلى صورة الشخصية المدخلة، مما يجعل الشخصية الساكنة ديناميكية ومعبرة.

- wan2.2-animate-mix: استبدال الشخصيات، والذي يستبدل الشخصيات في مقطع فيديو بشخصيات في صورة إدخال مع الحفاظ على حركات الفيديو الأصلية وتعبيراته وبيئته، مما يحقق تكاملاً سلسًا.

- جودة الاستدلال:

- wan-pro: جيل عالي الجودة.

- wan-std: الإصدار القياسي، الذي يوازن بين الأداء والكفاءة.

4. المناقشة

🖌️ إذا رأيت مشروعًا عالي الجودة، فيرجى ترك رسالة في الخلفية للتوصية به! بالإضافة إلى ذلك، قمنا أيضًا بتأسيس مجموعة لتبادل الدروس التعليمية. مرحبًا بالأصدقاء لمسح رمز الاستجابة السريعة وإضافة [برنامج تعليمي SD] للانضمام إلى المجموعة لمناقشة المشكلات الفنية المختلفة ومشاركة نتائج التطبيق↓

معلومات الاستشهاد

معلومات الاستشهاد لهذا المشروع هي كما يلي:

@article{wan2025,

title={Wan: Open and Advanced Large-Scale Video Generative Models},

author={Team Wan and Ang Wang and Baole Ai and Bin Wen and Chaojie Mao and Chen-Wei Xie and Di Chen and Feiwu Yu and Haiming Zhao and Jianxiao Yang and Jianyuan Zeng and Jiayu Wang and Jingfeng Zhang and Jingren Zhou and Jinkai Wang and Jixuan Chen and Kai Zhu and Kang Zhao and Keyu Yan and Lianghua Huang and Mengyang Feng and Ningyi Zhang and Pandeng Li and Pingyu Wu and Ruihang Chu and Ruili Feng and Shiwei Zhang and Siyang Sun and Tao Fang and Tianxing Wang and Tianyi Gui and Tingyu Weng and Tong Shen and Wei Lin and Wei Wang and Wei Wang and Wenmeng Zhou and Wente Wang and Wenting Shen and Wenyuan Yu and Xianzhong Shi and Xiaoming Huang and Xin Xu and Yan Kou and Yangyu Lv and Yifei Li and Yijing Liu and Yiming Wang and Yingya Zhang and Yitong Huang and Yong Li and You Wu and Yu Liu and Yulin Pan and Yun Zheng and Yuntao Hong and Yupeng Shi and Yutong Feng and Zeyinzi Jiang and Zhen Han and Zhi-Fan Wu and Ziyu Liu},

journal = {arXiv preprint arXiv:2503.20314},

year={2025}

}بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.