Command Palette

Search for a command to run...

SpikingBrain-1.0 نموذج أشواك كبير يشبه الدماغ يعتمد على التعقيد الجوهري

التاريخ

الحجم

12.45 MB

الوسوم

الترخيص

Apache 2.0

GitHub

رابط الورقة البحثية

1. مقدمة البرنامج التعليمي

"SpikingBrain-1.0" هو نموذج نبضي مستوحى من الدماغ، تم تطويره محليًا والتحكم فيه، وقد أُطلق في سبتمبر 2025 من قِبل معهد الأتمتة التابع للأكاديمية الصينية للعلوم، بالتعاون مع المختبر الوطني الرئيسي لإدراك الدماغ والذكاء المستوحى منه، وشركة Muxi Integrated Circuit Co., Ltd. يستوحي SpikingBrain تصميمه من آليات الدماغ، حيث يدمج آلية انتباه فعّالة هجينة، ووحدات MoE، وتشفيرًا نبضيًا في بنيته، مدعومًا بخط أنابيب تحويل شامل متوافق مع بيئة نماذج المصادر المفتوحة. يُمكّن هذا من التدريب المسبق المستمر باستخدام أقل من 21 TP3T من البيانات، مع تحقيق أداء يُضاهي نماذج المصادر المفتوحة الشائعة. يحقق SpikingBrain تسريعًا يزيد عن 100 ضعف في زمن الاستجابة الكلي (TTFT) لتسلسلات مكونة من 4 ملايين رمز، بينما يوفر التشفير النبضي أكثر من 691 TP3T من التباعد على المستوى المجهري. بالإضافة إلى ندرة معامل التباين الكلي، توفر هذه التطورات إرشادات قيّمة لتصميم رقائق عصبية الشكل من الجيل التالي. تتوفر أوراق بحثية ذات صلة. تقرير فني من SpikingBrain: نماذج كبيرة مستوحاة من Spiking Brain .

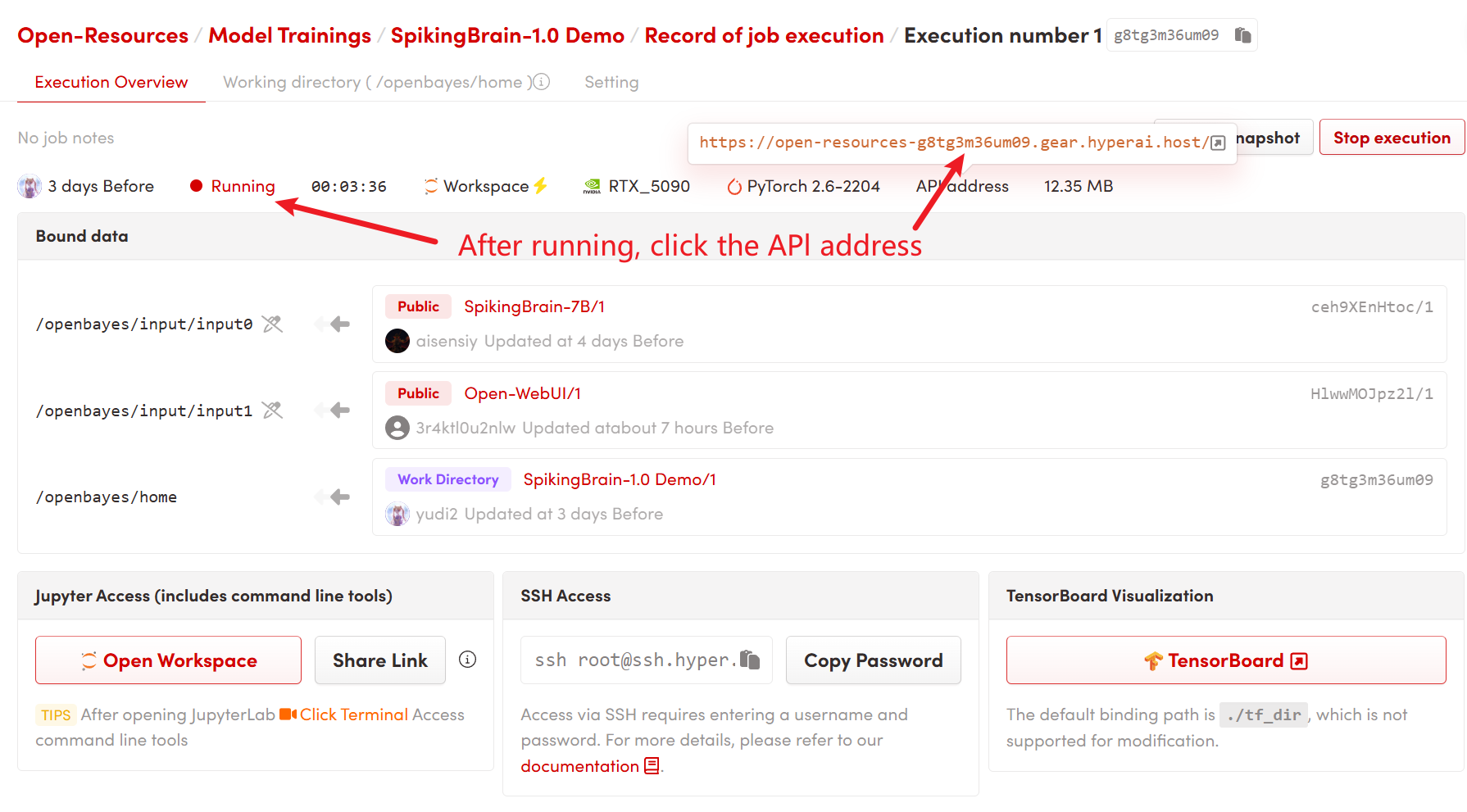

يستخدم هذا البرنامج التعليمي وحدة معالجة رسومية واحدة RTX 5090 لقوة الحوسبة، والنموذج المستخدم في هذا البرنامج التعليمي هو SpikingBrain's V1-7B-sft-s3-reasoning.

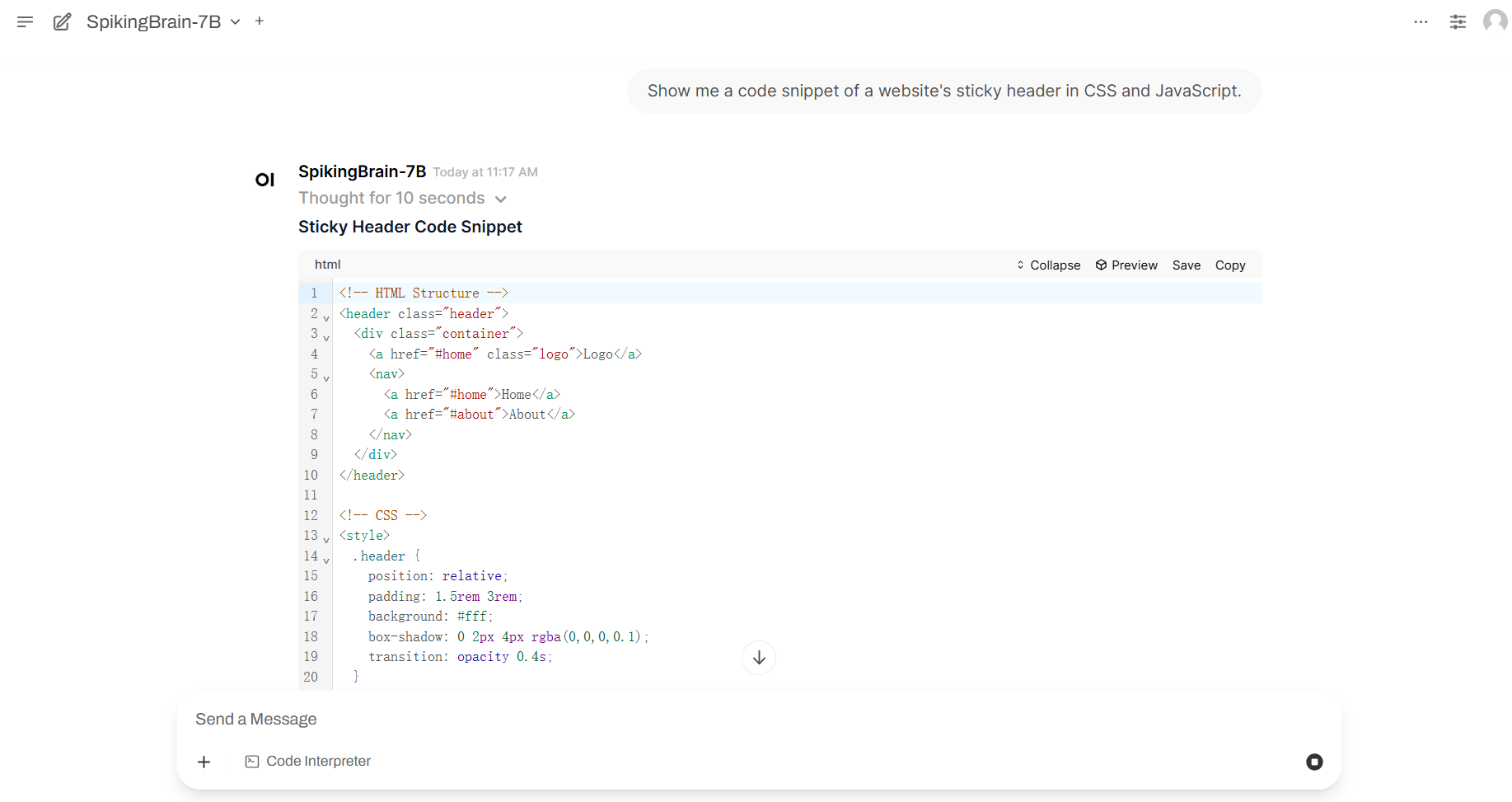

2. عرض التأثير

3. خطوات التشغيل

1. ابدأ تشغيل الحاوية

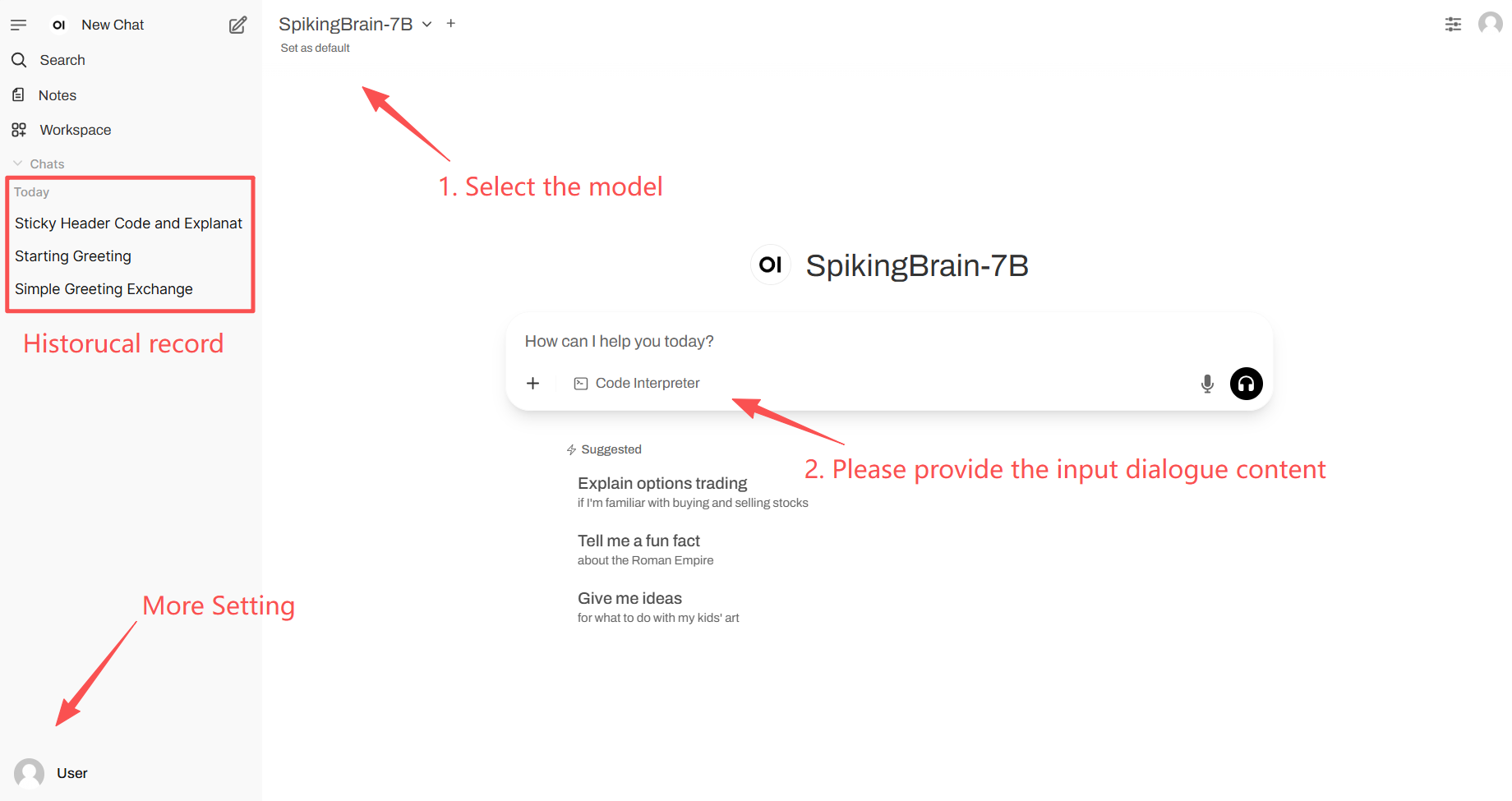

2. خطوات الاستخدام

إذا لم يتم عرض "النموذج"، فهذا يعني أنه يتم تهيئة النموذج. نظرًا لأن النموذج كبير الحجم، يرجى الانتظار لمدة 2-3 دقائق وتحديث الصفحة.

4. المناقشة

🖌️ إذا رأيت مشروعًا جيدًا، يُرجى ترك تعليق في الخلفية للتوصية به! بالإضافة إلى ذلك، أنشأنا أيضًا مجموعة لتبادل الدروس التعليمية. نرحب بالأصدقاء لمسح رمز الاستجابة السريعة وإضافة [دروس AI4S] للانضمام إلى المجموعة لمناقشة مختلف المشاكل التقنية ومشاركة نتائج التطبيق.↓

معلومات الاستشهاد

شكرًا لمستخدم Github سوبر يانغ نشر هذا البرنامج التعليمي. معلومات الاستشهاد لهذا المشروع هي كما يلي:

@article{pan2025spikingbrain,

title={SpikingBrain Technical Report: Spiking Brain-inspired Large Models},

author={Pan, Yuqi and Feng, Yupeng and Zhuang, Jinghao and Ding, Siyu and Liu, Zehao and Sun, Bohan and Chou, Yuhong and Xu, Han and Qiu, Xuerui and Deng, Anlin and others},

journal={arXiv preprint arXiv:2509.05276},

year={2025}

}بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.