Command Palette

Search for a command to run...

DiffuCode-7B-cpGRPO: نموذج توليد الكود يعتمد على تقنية انتشار القناع

التاريخ

الحجم

12.8 MB

الوسوم

الترخيص

Other

GitHub

رابط الورقة البحثية

1. مقدمة البرنامج التعليمي

يُعدّ DiffuCoder-7B-cpGRPO، الذي اقترحه فريق Apple لأول مرة في ورقة بحثية نُشرت في 25 يونيو 2025، نموذجًا لتوليد الشفرة البرمجية قائمًا على الانتشار المقنّع (dLLM). وقد تم تدريبه على أكثر من 20,000 مثال برمجي مُختار بعناية. يهدف هذا النموذج إلى توليد الشفرة وتعديلها من خلال تقليل الضوضاء بشكل تكراري، بدلاً من التوليد التراجعي التلقائي التقليدي من اليسار إلى اليمين. من أبرز ميزات DiffuCoder-7B-cpGRPO عدم اعتماده بشكل صارم على التوليد من اليسار إلى اليمين، مما أدى إلى تحسين النتائج بمقدار 4.41 نقطة في مقياس TP3T على معايير البرمجة الشائعة مقارنةً بنماذج البرمجة الأخرى القائمة على الانتشار. هذه القدرة على توليد الشفرة بشكل غير متسلسل تجعله أكثر مرونة وكفاءة في مهام تحرير الشفرة وتوليدها. وفيما يلي نتائج الورقة البحثية ذات الصلة: DiffuCoder: فهم نماذج الانتشار المقنعة وتحسينها لتوليد التعليمات البرمجية .

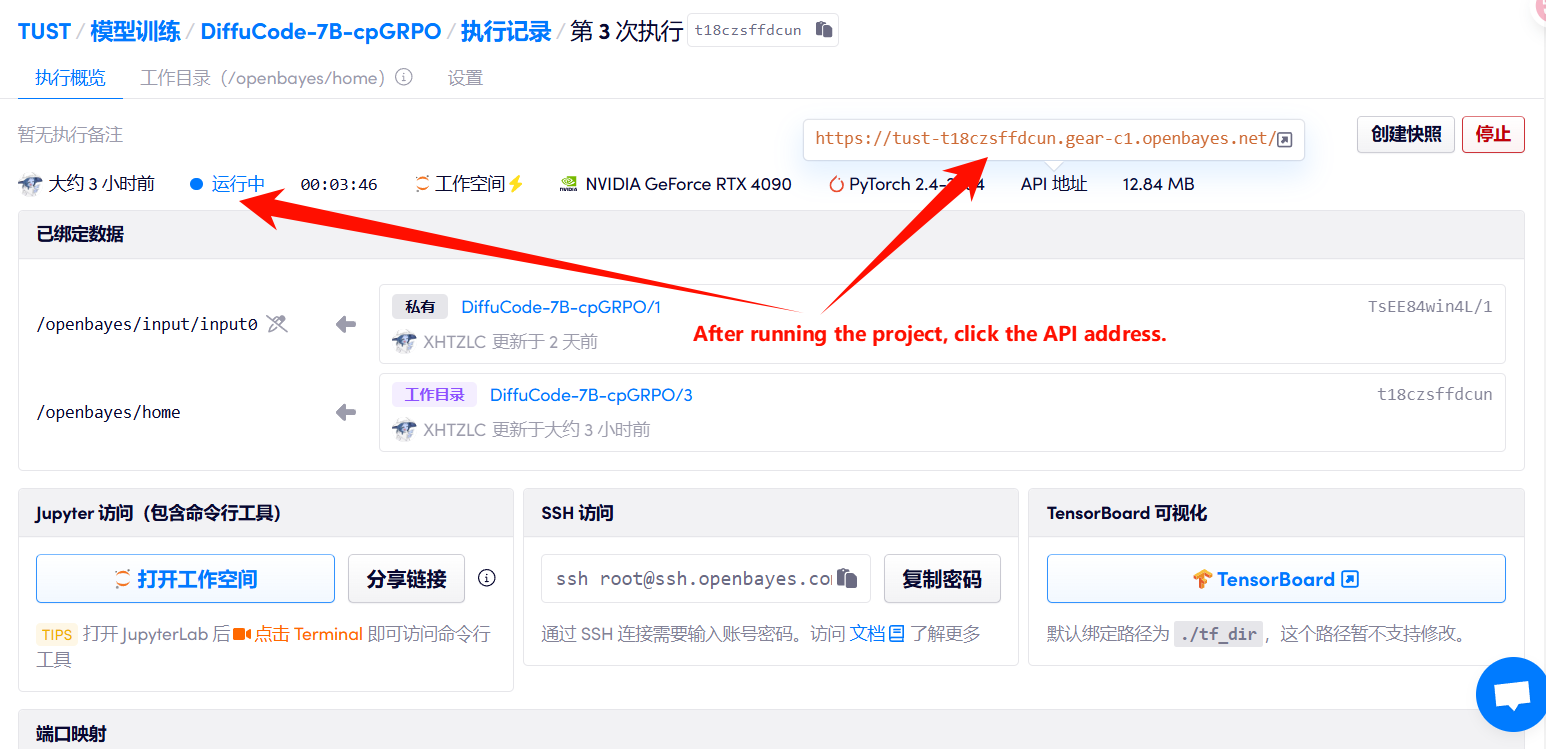

يستخدم هذا البرنامج التعليمي الموارد لبطاقة RTX 4090 واحدة.

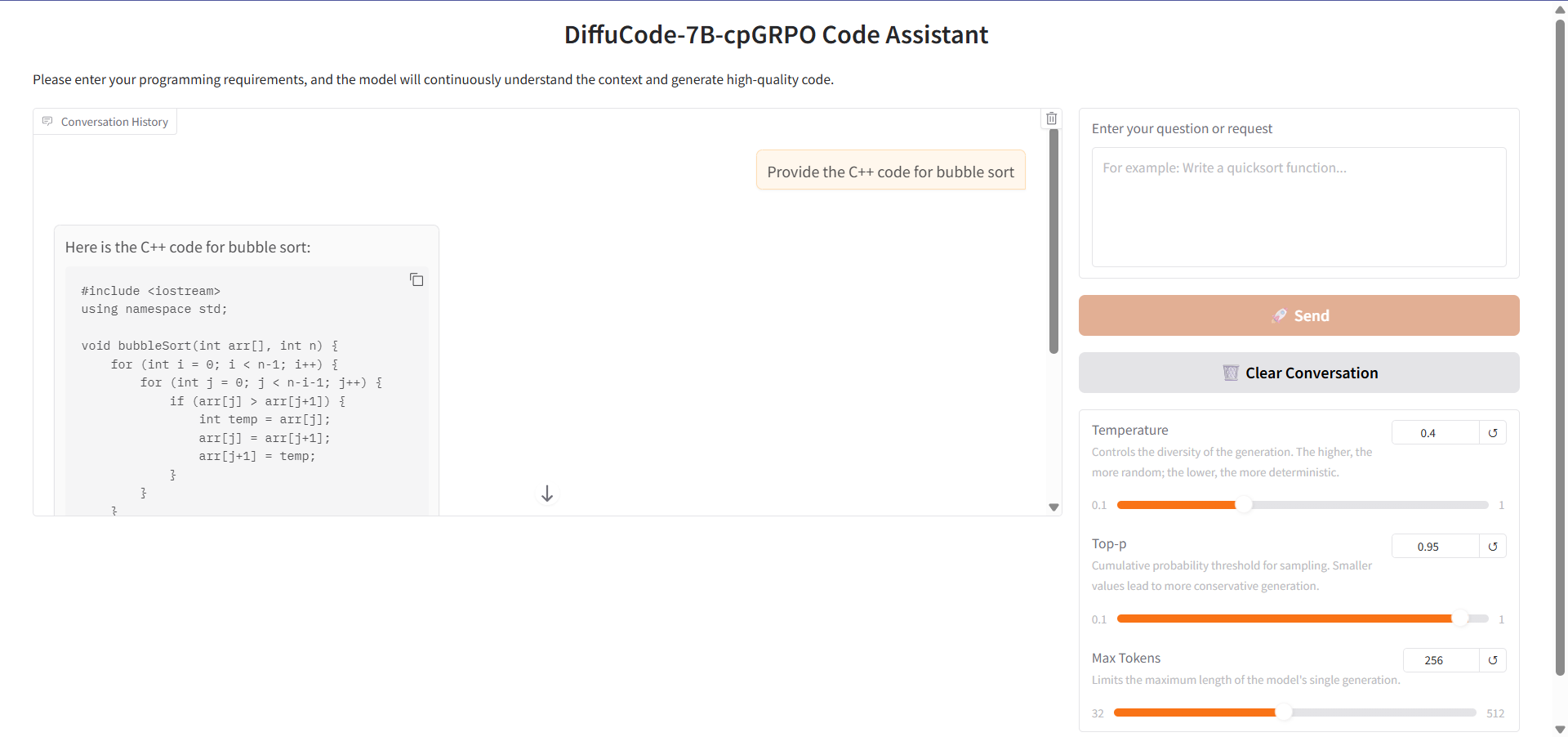

2. أمثلة المشاريع

3. خطوات التشغيل

1. بعد بدء تشغيل الحاوية، انقر فوق عنوان API للدخول إلى واجهة الويب

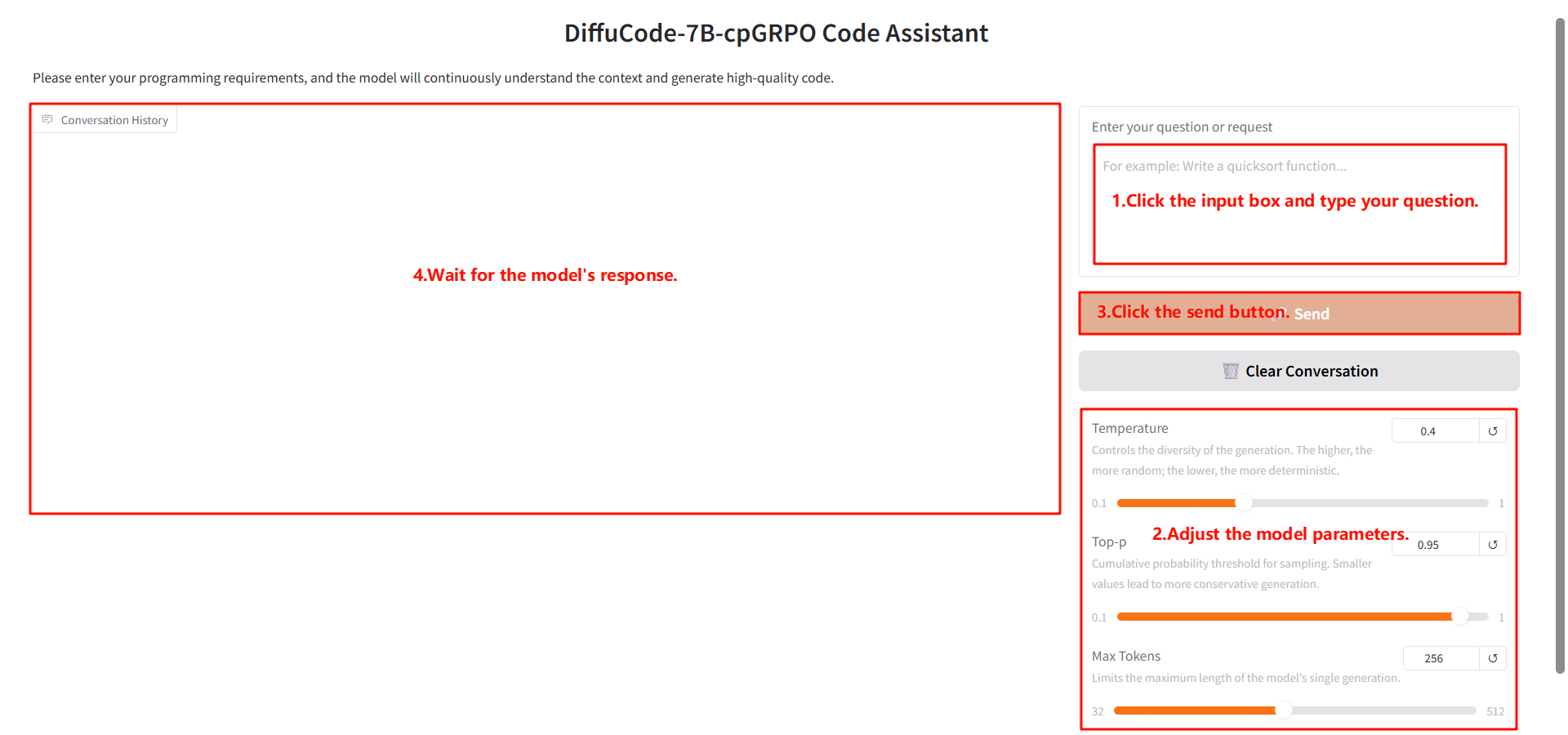

2. خطوات الاستخدام

إذا تم عرض "بوابة سيئة"، فهذا يعني أن النموذج قيد التهيئة. نظرًا لأن النموذج كبير الحجم، يرجى الانتظار لمدة 2-3 دقائق وتحديث الصفحة.

وصف المعلمة

- الإعدادات المتقدمة:

- درجة الحرارة: تتحكم في تنوع الجيل، فكلما ارتفعت كانت أكثر عشوائية، وكلما انخفضت كانت أكثر حتمية.

- أعلى قيمة p: الحد التراكمي لعينة الاحتمال. كلما كانت القيمة أصغر، كان الجيل أكثر تحفظًا.

- Max-tokens: يحدد الحد الأقصى لطول جيل واحد من النموذج.

4. المناقشة

🖌️ إذا رأيت مشروعًا عالي الجودة، فيرجى ترك رسالة في الخلفية للتوصية به! بالإضافة إلى ذلك، قمنا أيضًا بتأسيس مجموعة لتبادل الدروس التعليمية. مرحبًا بالأصدقاء لمسح رمز الاستجابة السريعة وإضافة [برنامج تعليمي SD] للانضمام إلى المجموعة لمناقشة المشكلات الفنية المختلفة ومشاركة نتائج التطبيق↓

معلومات الاستشهاد

معلومات الاستشهاد لهذا المشروع هي كما يلي:

@article{gong2025diffucoder,

title={DiffuCoder: Understanding and Improving Masked Diffusion Models for Code Generation},

author={Shansan Gong, Ruixiang Zhang, Huangjie Zheng, Jiatao Gu, Navdeep Jaitly, Lingpeng Kong, Yizhe Zhang},

year={2025},

eprint={2506.20639},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2506.20639},

}بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.