Command Palette

Search for a command to run...

ComfyUI Hunyuanدليل سير عمل إنشاء الفيديو المخصص

التاريخ

الحجم

3.28 GB

الوسوم

رابط الورقة البحثية

1. مقدمة البرنامج التعليمي

يستخدم هذا البرنامج التعليمي بطاقة RTX 4090 واحدة كمصدر، ويستغرق إنشاء الفيديو حوالي 10 دقائق. يُنصح باستخدام وحدة معالجة رسومية (GPU) بذاكرة 80 جيجابايت لتحسين جودة الإنتاج.

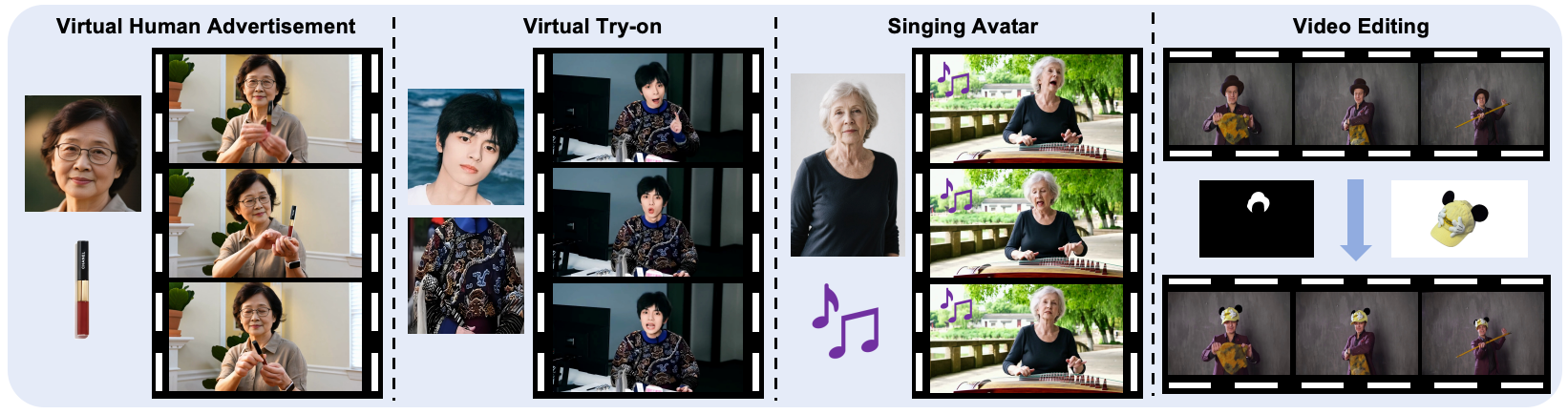

HunyuanCustom، الذي أطلقه فريق Hunyuan التابع لشركة Tencent في 9 مايو 2025، هو إطار عمل متعدد الوسائط لإنشاء فيديوهات مخصصة. وهو نموذج توليد متعدد الوسائط وقابل للتحكم المشروط، مبني على إطار عمل Hunyuan Video، ويركز على اتساق الموضوع. يدعم HunyuanCustom إنشاء فيديوهات متسقة الموضوع باستخدام مدخلات نصية وصورية وصوتية ومرئية. وبفضل إمكانياته متعددة الوسائط، يمكن إنجاز العديد من المهام اللاحقة. على سبيل المثال، من خلال الحصول على صور متعددة كمدخلات، يمكن لـ HunyuanCustom تسهيل الإعلانات باستخدام شخصيات افتراضية وتجربة المكياج افتراضيًا. تتوفر أوراق بحثية ذات صلة. HunyuanCustom: بنية متعددة الوسائط لتوليد مقاطع فيديو مخصصة .

يستخدم برنامج سير العمل التعليمي هذا ملفات النموذج التالية في المجموع:

- hunyuan_video_custom_720p_fp8_scaled.safetensors

- llava_llama3_fp16.safetensors

- hunyuan_video_vae_bf16.safetensors

- clip_l.safetensors

2. أمثلة المشاريع

تخصيص الفيديو متعدد الوسائط

تطبيقات مختلفة

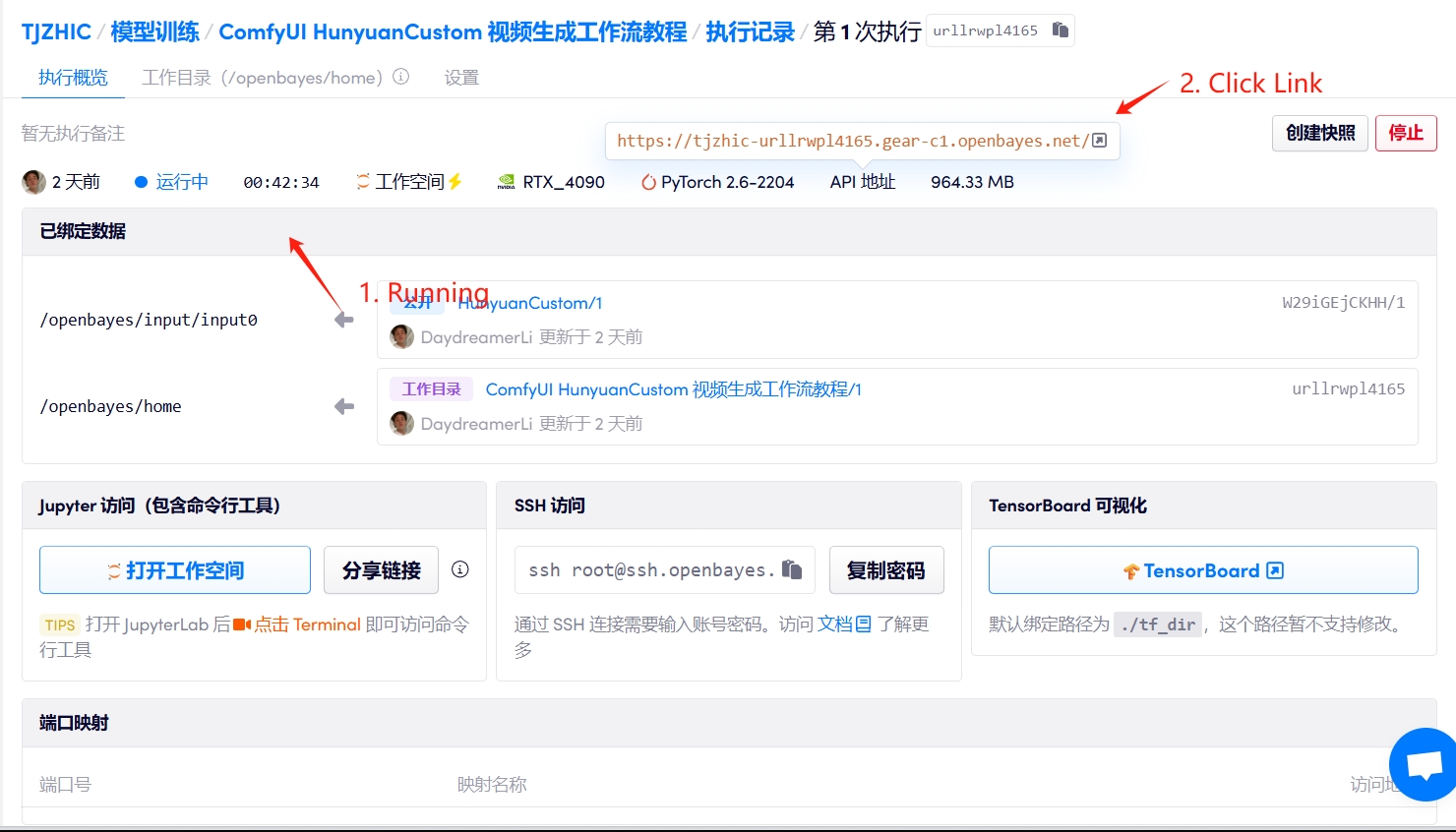

3. خطوات التشغيل

1. بعد بدء تشغيل الحاوية، انقر فوق عنوان API للدخول إلى واجهة الويب

إذا تم عرض "بوابة سيئة"، فهذا يعني أن النموذج قيد التهيئة. نظرًا لأن النموذج كبير الحجم، يرجى الانتظار لمدة 2-3 دقائق وتحديث الصفحة.

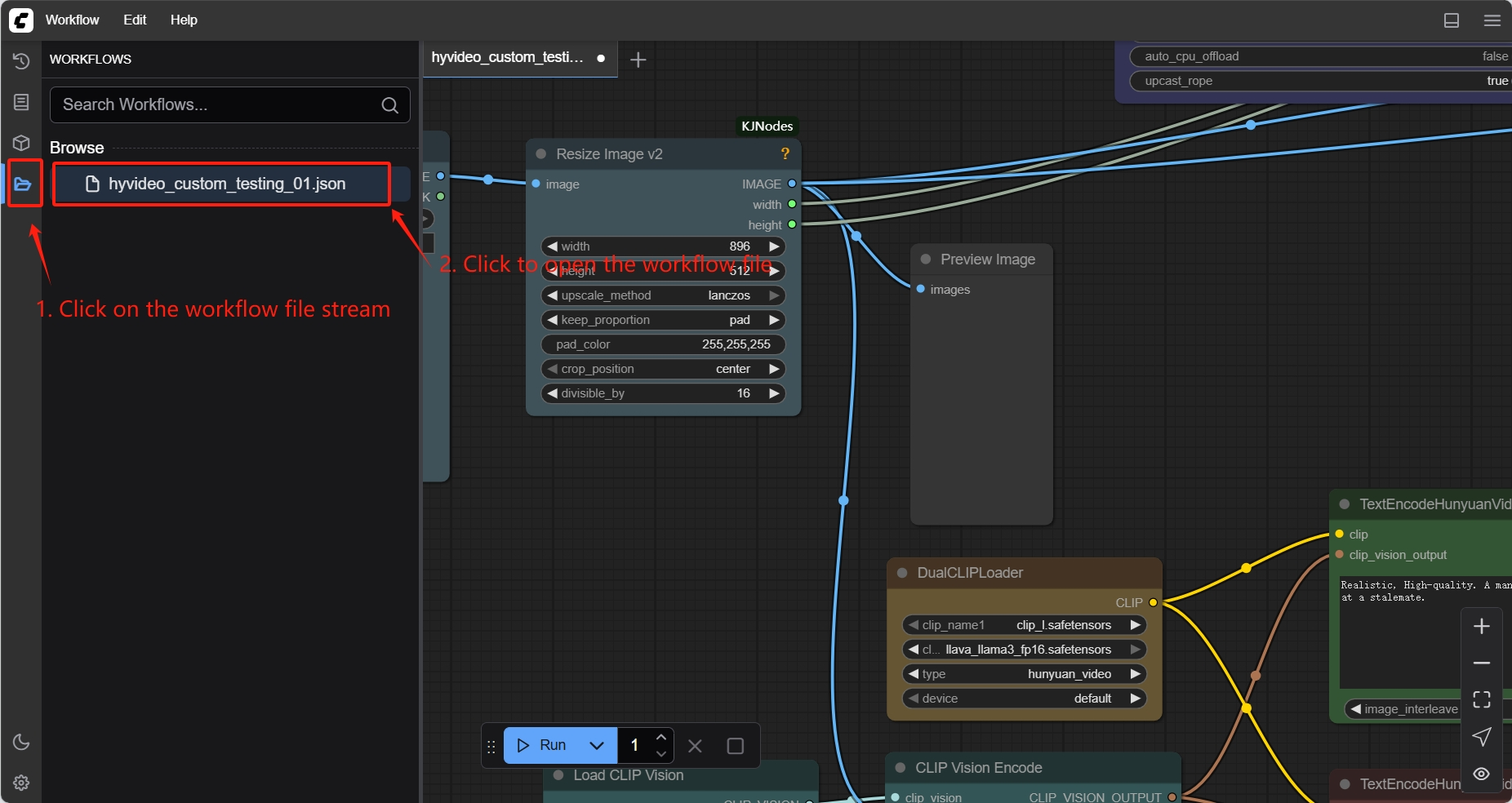

2. العرض التوضيحي الوظيفي

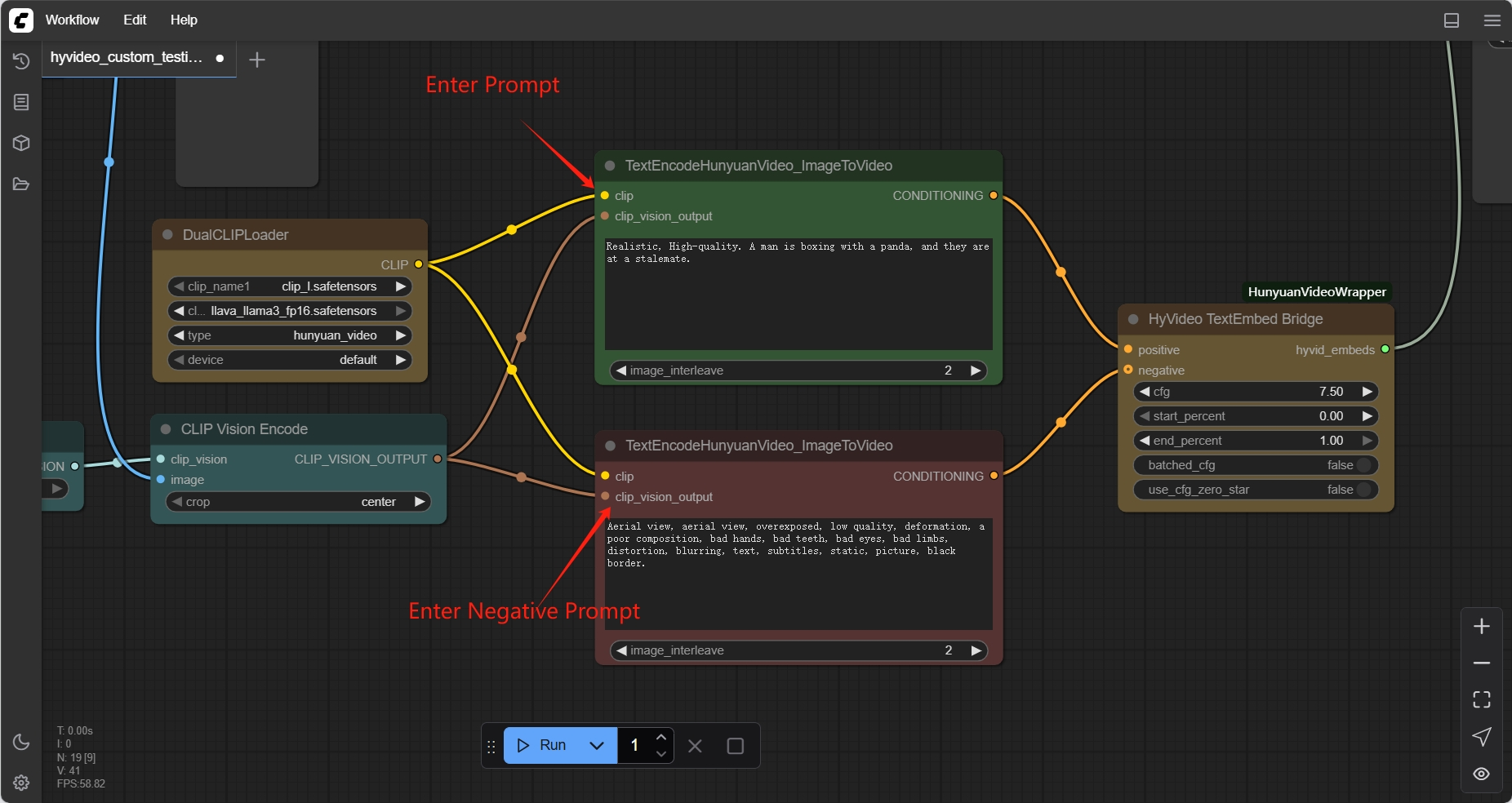

كيفية الاستخدام

- يتطلب الاستنساخ الأول الاستيراد اليدوي لملف سير العمل للتحميل

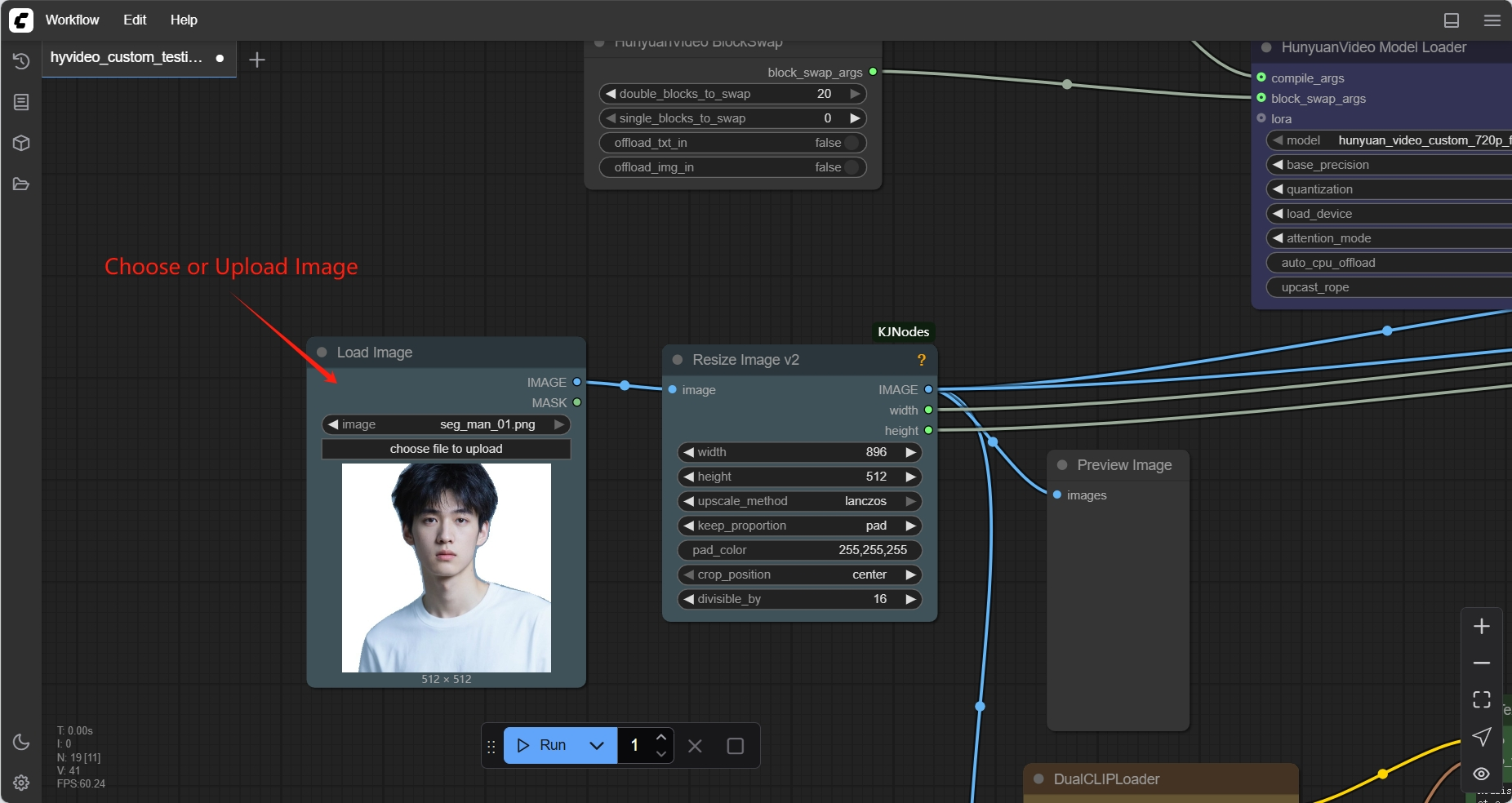

- فيديو توليد الصورة

حدد الصورة

موجه الإدخال

النتيجة الناتجة

4. المناقشة

🖌️ إذا رأيت مشروعًا عالي الجودة، فيرجى ترك رسالة في الخلفية للتوصية به! بالإضافة إلى ذلك، قمنا أيضًا بتأسيس مجموعة لتبادل الدروس التعليمية. مرحبًا بالأصدقاء لمسح رمز الاستجابة السريعة وإضافة [برنامج تعليمي SD] للانضمام إلى المجموعة لمناقشة المشكلات الفنية المختلفة ومشاركة نتائج التطبيق↓

معلومات الاستشهاد

معلومات الاستشهاد لهذا المشروع هي كما يلي:

@misc{hu2025hunyuancustom,

title={HunyuanCustom: A Multimodal-Driven Architecture for Customized Video Generation},

author={Teng Hu and Zhentao Yu and Zhengguang Zhou and Sen Liang and Yuan Zhou and Qin Lin and Qinglin Lu},

year={2025},

eprint={2505.04512},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2505.04512},

}بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.