Command Palette

Search for a command to run...

برنامج تعليمي عبر الإنترنت: إطار عمل HuMo-1.7B لإنشاء مقاطع فيديو تعاونية متعددة الوسائط: تحقيق تجربة إنشاء فيديو باستخدام الرسومات والنصوص والصوت المتكامل

في الوقت الحاضر، أصبحت مقاطع الفيديو المُولّدة بالذكاء الاصطناعي أكثر واقعية. غالبًا ما تبدو مُذهلة للوهلة الأولى، ولكن عند التدقيق، يبدو أن هناك شيئًا ما غير طبيعي. هذا التأثير "الغريب" بين الواقع والمُزيّف مُذهل ولا مفر منه.

تذكّر سيناريو شائعًا في العمل الإبداعي. إذا طرح العميل فكرةً مبهمةً فحسب، فغالبًا ما يفشل المنتج النهائي في تلبية التوقعات. فقط عندما تُحسّن المتطلبات بأبعادٍ مثل الأسلوب والشخصيات والنغمة والجو العام، ستكون النتيجة أقرب إلى المثالية. وينطبق الأمر نفسه على إنتاج الفيديو. فعلى عكس الصور والنصوص، يحمل الفيديو معلوماتٍ متعددةً مثل الصوت والشخصيات والأحداث.وهذا يعني أن النموذج لا ينبغي أن "يفهم" دلالات النص فحسب، بل ينبغي أن "ينسق" أيضًا التعبيرات البصرية والسمعية.

مع ذلك، تعتمد معظم النماذج الحالية على نمط إدخال واحد. وغالبًا ما تُواجه المحاولات الحديثة للتحكم متعدد الأنماط صعوبة في تحقيق تعاون فعال بين الصوت والتعبير والحركة. ولا يزال تمكين هذه الأنماط المختلفة من التعاون الحقيقي وإنتاج مقاطع فيديو طبيعية وواقعية تُشبه الواقع البشري تحديًا هائلًا.

وفي ضوء ذلك،أصدرت جامعة تسينغهوا ومختبر ByteDance Intelligent Creation بشكل مشترك إطار عمل HuMo. يقترح HuMo مفهوم "التوليد المشروط المتعدد الوسائط التعاوني"، من خلال دمج النصوص والصور المرجعية والصوت في نفس النموذج التوليدي، ومن خلال استراتيجية تدريب تقدمية وآلية توجيه تتكيف مع الوقت، يتم ضبط أوزان التوجيه بشكل ديناميكي في خطوة إزالة الضوضاء.فهو لا يحقق تقدمًا في الحفاظ على اتساق مظهر الشخصية والصوت والفيديو فحسب، بل إنه يطور أيضًا عملية إنشاء الفيديو من "الربط متعدد المراحل" إلى "التوليد في محطة واحدة".

عنوان الورقة:

https://arxiv.org/abs/2509.08519

المستودع الأصلي:

https://github.com/phantom-video/humo

بالإضافة إلى ذلك، وصل أداء HuMo في المهام الفرعية المتعددة مثل تتبع النص وتناسق الصور إلى مستوى SOTA.يقدم المشروع نموذجين، 1.7B و17B، يتميزان بخفة الوزن وسهولة اللعب والاحترافية والبحث، ويلبيان مختلف احتياجات المبدعين والمطورين. لنلقِ نظرة على التأثير الناتج عن نموذج 17B:

يتوفر الآن "HuMo-1.7B: إطار عمل توليد الفيديو متعدد الوسائط" و"HuMo-17B: إنشاء تعاوني ثلاثي الوسائط" في قسم "الدروس التعليمية" على الموقع الرسمي لشركة HyperAI (hyper.ai). لمَ لا تُجرّبه؟ عند تزويده بمزيد من المعلومات، هل يُمكن للنموذج إنتاج فيديو يُرضيك؟

رابط البرنامج التعليمي:

هيومو-1.7ب:https://go.hyper.ai/BGQT1

هيومو-17ب:https://go.hyper.ai/RSYA

تشغيل تجريبي

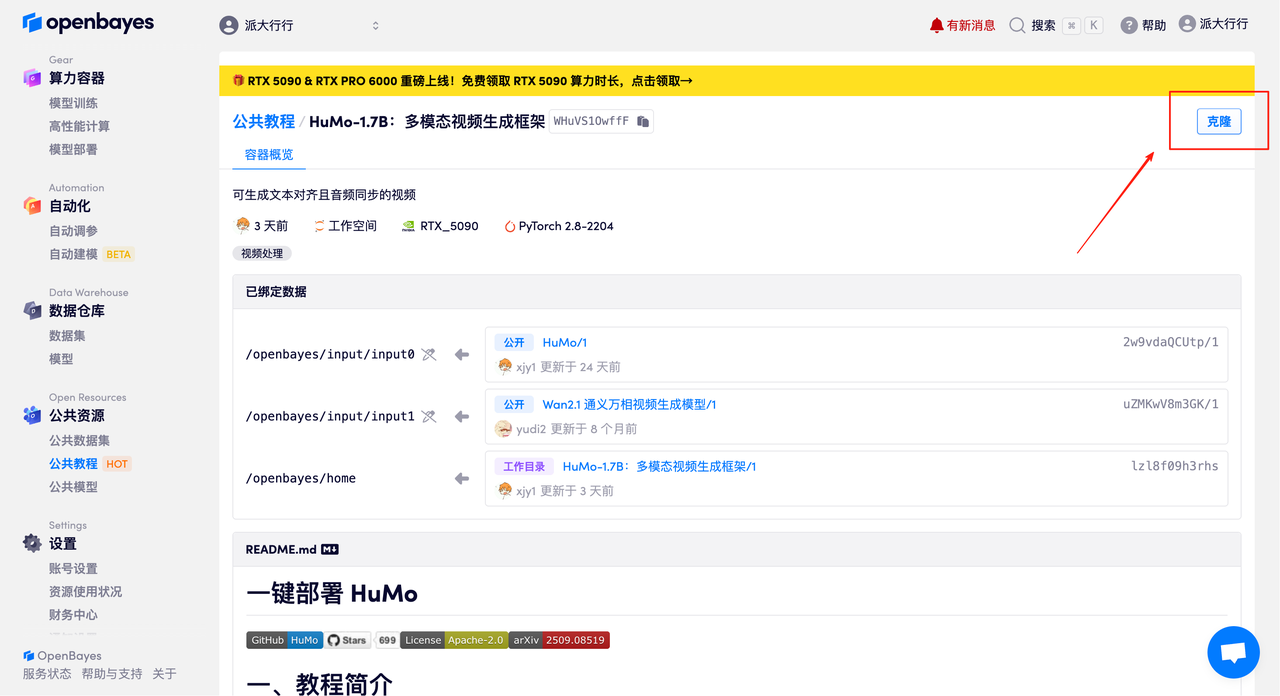

1. في الصفحة الرئيسية لـ hyper.ai، حدد صفحة البرامج التعليمية، واختر HuMo-1.7B: Multimodal Video Generation Framework، وانقر فوق تشغيل هذا البرنامج التعليمي عبر الإنترنت.

2. بعد الانتقال إلى الصفحة التالية، انقر فوق "استنساخ" في الزاوية اليمنى العليا لاستنساخ البرنامج التعليمي في الحاوية الخاصة بك.

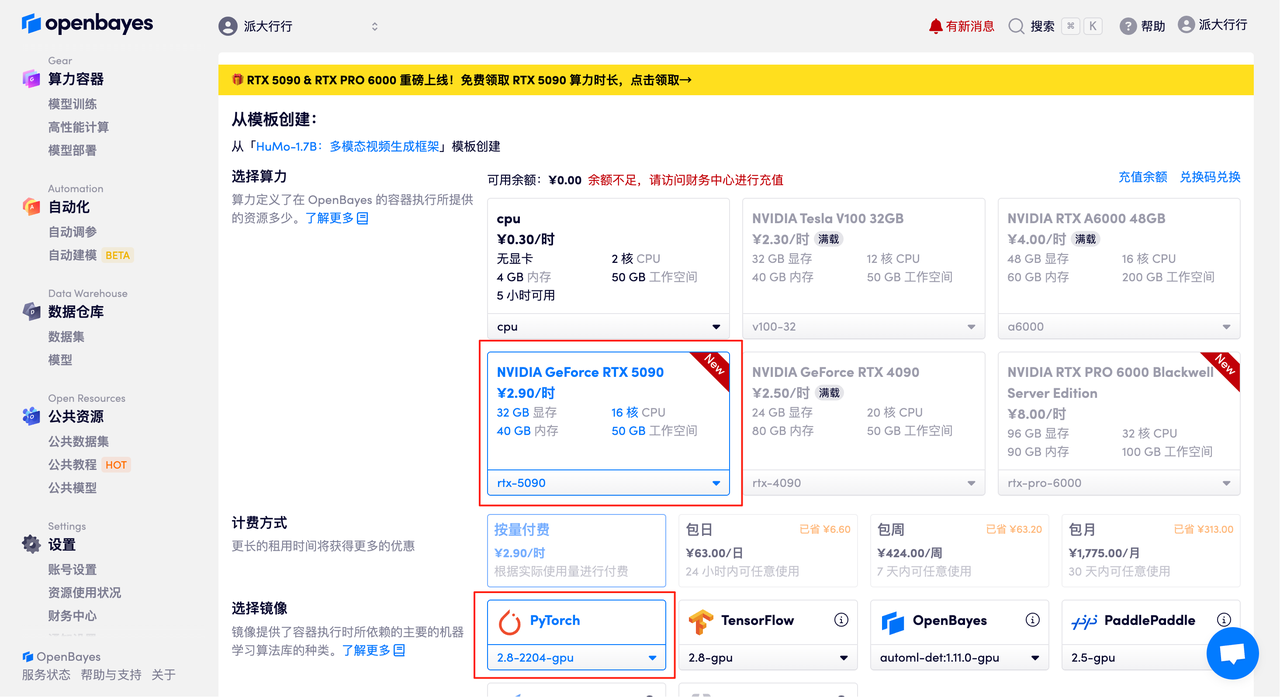

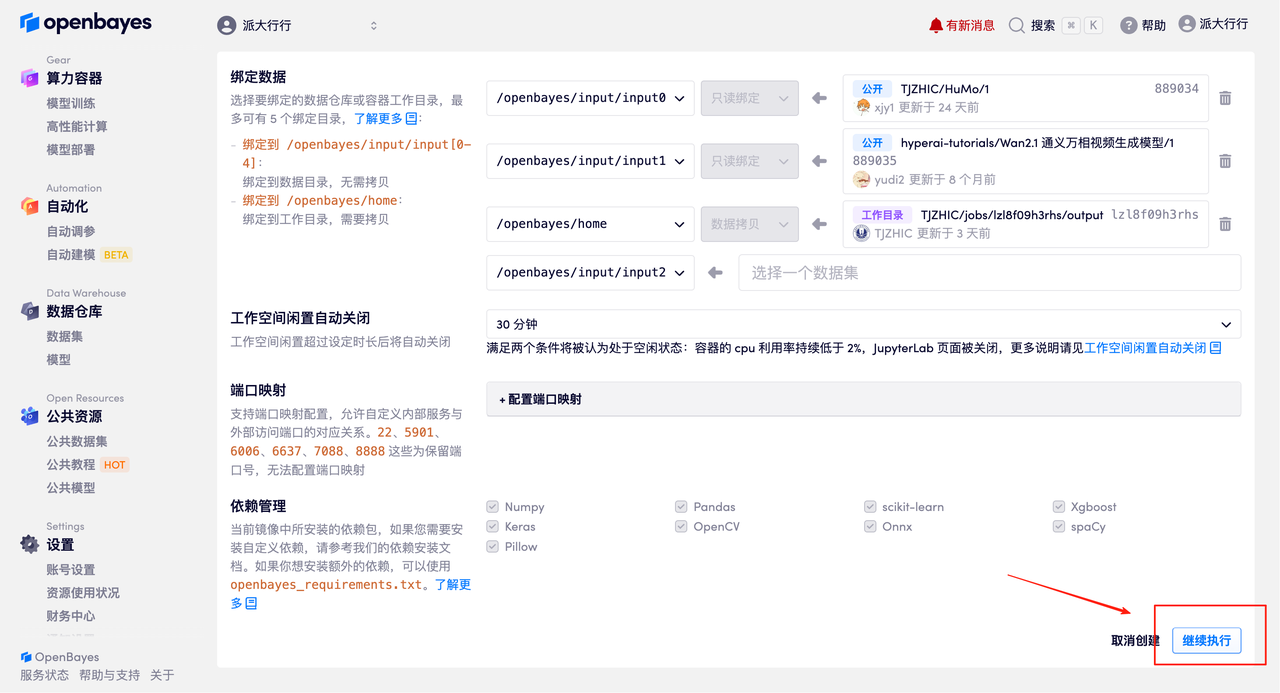

٣. اختر صورتي NVIDIA GeForce RTX 5090 وPyTorch وانقر على "متابعة". توفر منصة OpenBayes أربعة خيارات للدفع: الدفع حسب الاستخدام أو باقات يومية/أسبوعية/شهرية. يمكن للمستخدمين الجدد التسجيل باستخدام رابط الدعوة أدناه للحصول على ٤ ساعات مجانية من بطاقة RTX 5090 و٥ ساعات مجانية من استخدام المعالج!

رابط دعوة حصرية لـ HyperAI (انسخ وافتح في المتصفح):

https://openbayes.com/console/signup?r=Ada0322_NR0n

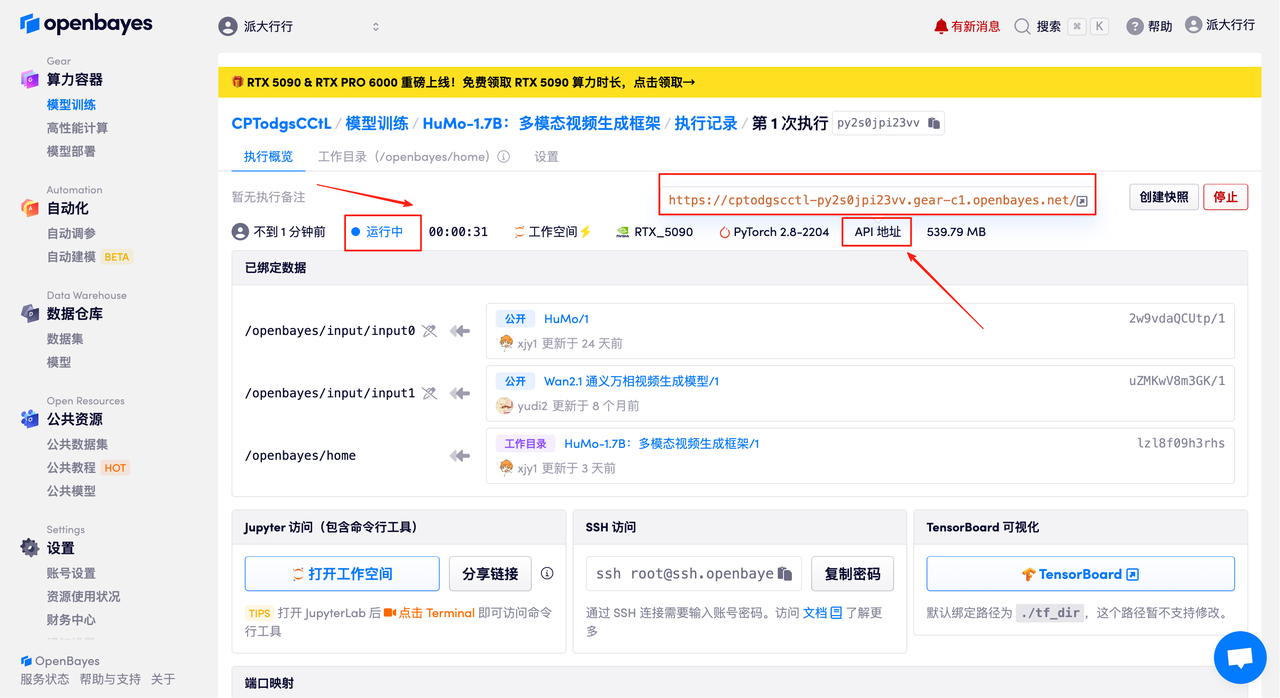

٤. انتظر حتى يتم تخصيص الموارد. سيستغرق الاستنساخ الأول دقيقتين تقريبًا. عندما تتغير الحالة إلى "قيد التشغيل"، انقر على "فتح مساحة العمل" للانتقال إلى صفحة العرض التوضيحي.

عرض التأثير

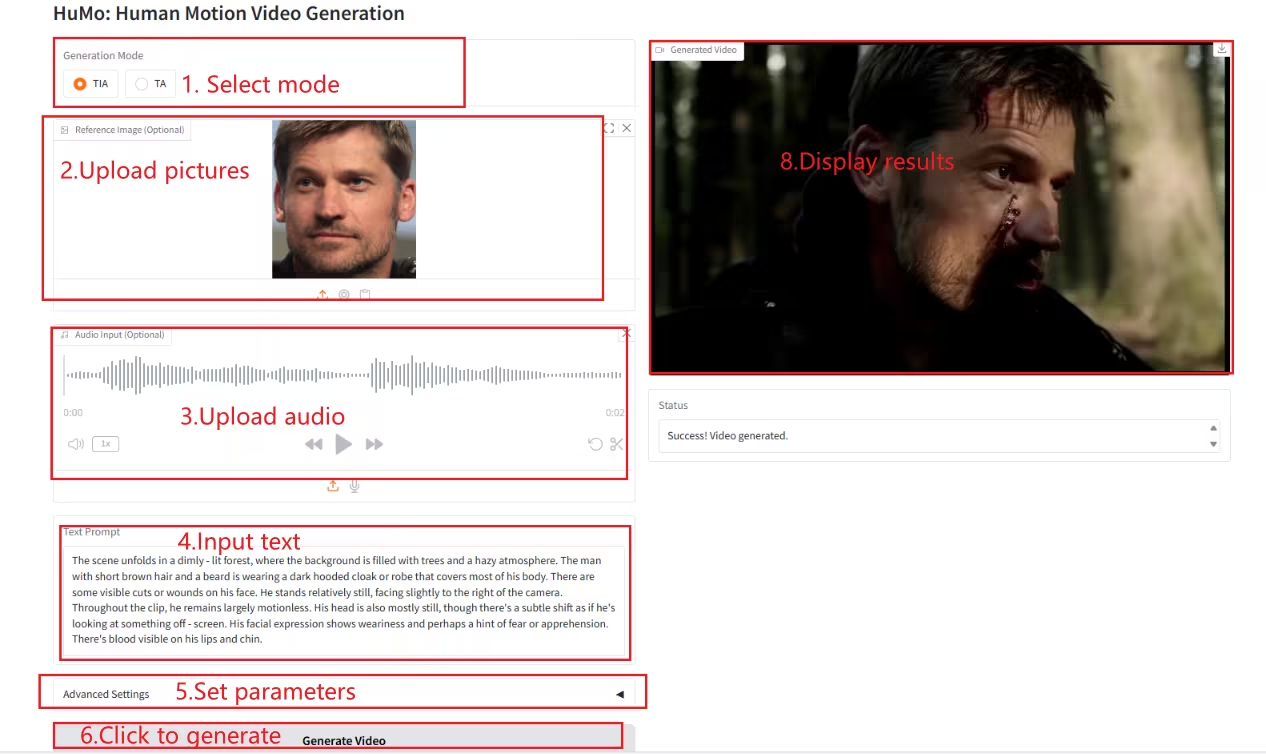

بمجرد وصولك إلى صفحة العرض التوضيحي، أدخل وصفًا في مربع النص، ثم حمّل الصور والصوت، واضبط الإعدادات حسب الحاجة، ثم انقر على "إنشاء فيديو" لإنشاء الفيديو. (ملاحظة: عند ضبط خطوات أخذ العينات على ١٠، يستغرق إنشاء الفيديو حوالي ٣-٥ دقائق).

إنشاء مثال

ما سبق هو البرنامج التعليمي الذي توصي به HyperAI هذه المرة. الجميع مدعوون للحضور وتجربته!

رابط البرنامج التعليمي:

هيومو-1.7ب:https://go.hyper.ai/BGQT1

هيومو-17ب:https://go.hyper.ai/RSYAأنا