Command Palette

Search for a command to run...

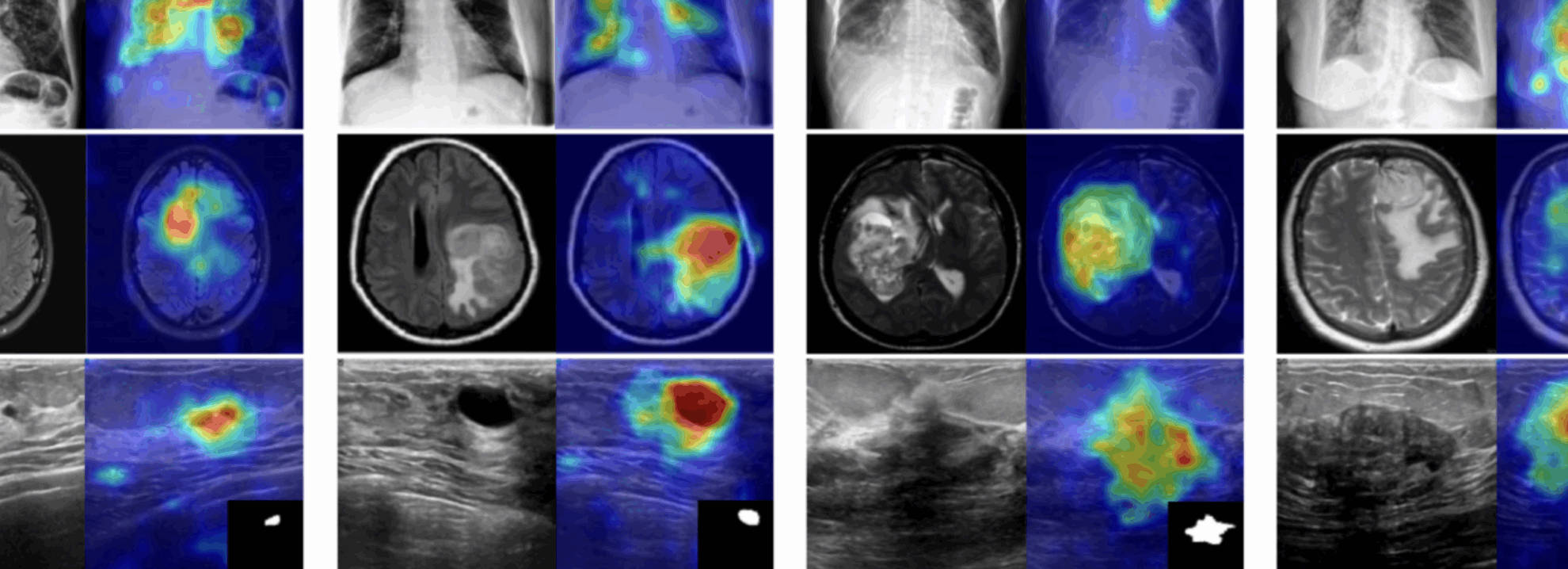

يحقق MediCLIP نتائج متطورة في اكتشاف الشذوذ وتحديد موقعه باستخدام الحد الأدنى من بيانات التصوير الطبي.

في التشخيص والعلاج السريري، تُعدّ تقنيات التصوير الطبي (مثل الأشعة السينية، والتصوير المقطعي المحوسب، والموجات فوق الصوتية) أساسيةً لتشخيص الأطباء. بعد إتمام المريض لفحص التصوير، يقوم أخصائي الأشعة أو الموجات فوق الصوتية عادةً بتفسير الصور. يُحدد هذا التفسير المهني التشوهات، ويحدد مواقع الآفات، ويُعدّ التقارير التشخيصية، مما يُوفر دعمًا بالغ الأهمية لاتخاذ القرارات السريرية.

مع تطور تكنولوجيا الذكاء الاصطناعي، أصبح تحليل الصور الطبية يمثل بداية لتغييرات جديدة.في الوقت الحالي، أصبح التعلم الآلي قادرًا على أداء مهمة اكتشاف التشوهات في الصور الطبية، أي التمييز بين الصور الطبيعية والصور غير الطبيعية التي تحتوي على آفات وتحديد مواقع مناطق هذه الآفات.يلعب هذا النوع من التكنولوجيا دورًا محوريًا في دعم اتخاذ القرارات الطبية. بعض نماذج الكشف المتقدمة قادرة على أداء مهام محددة بكفاءة الأطباء المتخصصين، مما يقلل من مخاطر اتخاذ القرارات ويعزز كفاءة عمل الطاقم الطبي.

مع ذلك، تعتمد أساليب الكشف عن شذوذ الصور الطبية الحالية عادةً على مجموعات بيانات ضخمة للتدريب. ورغم أن هذا قد يحقق أداءً أعلى، إلا أنه يزيد تكاليف التطوير بشكل كبير.

يُظهر نموذج CLIP متعدد الأغراض أداءً جيدًا في نقل البيانات من نقطة الصفر، إلا أن تطبيقه المباشر في الكشف عن شذوذ الصور الطبية محدود بسبب اختلافات النطاق وندرة التعليقات التوضيحية. في عام ٢٠٢٢، اقترح فريق بحثي من جامعة إلينوي في أوربانا-شامبين طريقة MedCLIP. مستوحاة من نماذج التعلم التبايني بين النص المرئي، مثل CLIP، يُوسّع هذا النهج نطاق هذا النموذج ليشمل تصنيف الصور الطبية والاسترجاع متعدد الوسائط من خلال فصل التعلم التبايني بين النص المرئي ودمج المعرفة الطبية لاستبعاد النتائج السلبية الخاطئة. تُحقق هذه الطريقة أداءً ممتازًا حتى مع انخفاض كبير في حجم البيانات.

على الرغم من أن MedCLIP حقق نتائج ملحوظة في تخفيف الاعتماد على البيانات، إلا أنه صُمم لمهام التصنيف والاسترجاع، وهو غير مناسب تمامًا للكشف عن الشذوذ، وخاصةً تحديد موقع الآفة. في الوقت نفسه، طبّقت أبحاث حديثة CLIP للكشف عن الشذوذ في اللقطات الصفرية/الصغيرة، محققةً نتائج مبهرة. مع ذلك، غالبًا ما تتطلب هذه الطرق صورًا حقيقية للشذوذ ومجموعات بيانات مساعدة مُعلّقة على مستوى البكسل لتدريب النماذج، وهو أمر يصعب الحصول عليه في المجال الطبي.

ولمعالجة هذه المشكلات، اقترح فريق بحثي من جامعة بكين MediCLIP، وهو حل فعال لكشف الشذوذ في الصور الطبية من خلال عينات صغيرة.تتطلب هذه الطريقة كمية صغيرة فقط من الصور الطبية الطبيعية لتحقيق الأداء الرائد في مهام اكتشاف الشذوذ وتحديد موقعه.يمكنه اكتشاف أمراض مختلفة بشكل فعال في أنواع مختلفة من الصور الطبية، مما يدل على قدرات تعميم العينة الصفرية المذهلة.

MediCLIP: الكشف عن الشذوذ في الصور الطبية ذات العينات الصغيرة باستخدام CLIPاستمتع بتجربة طريقة التشخيص بالتصوير الطبي الذكي عالية الفعالية في قسم البرامج التعليمية على الموقع الرسمي لشركة HyperAI (hyper.ai).

رابط البرنامج التعليمي:

تشغيل تجريبي

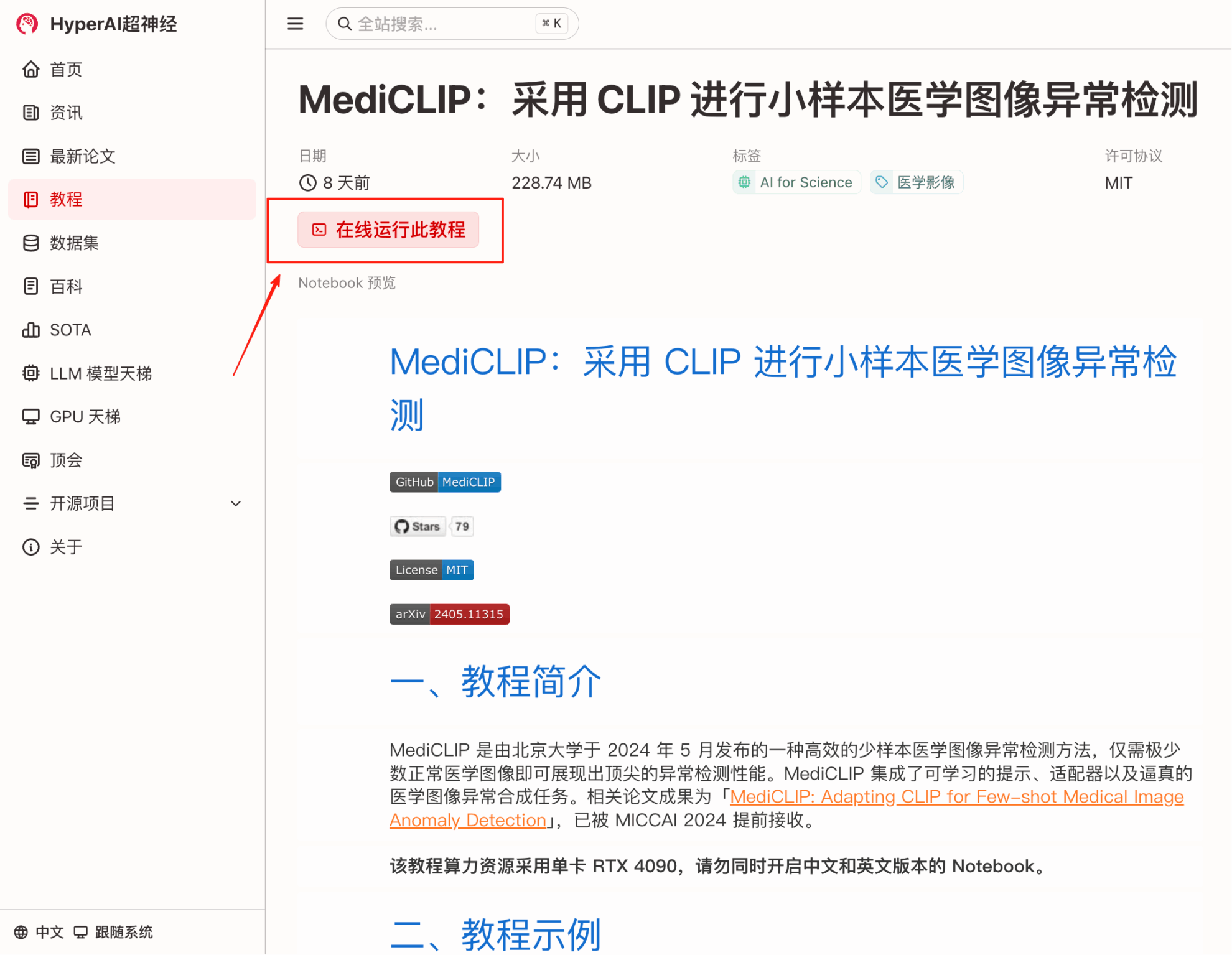

1. في الصفحة الرئيسية لـ hyper.ai، حدد صفحة البرامج التعليمية، واختر MediCLIP: اكتشاف الشذوذ في الصور الطبية ذات العينات الصغيرة باستخدام CLIP، وانقر فوق تشغيل هذا البرنامج التعليمي عبر الإنترنت.

2. بعد الانتقال إلى الصفحة التالية، انقر فوق "استنساخ" في الزاوية اليمنى العليا لاستنساخ البرنامج التعليمي في الحاوية الخاصة بك.

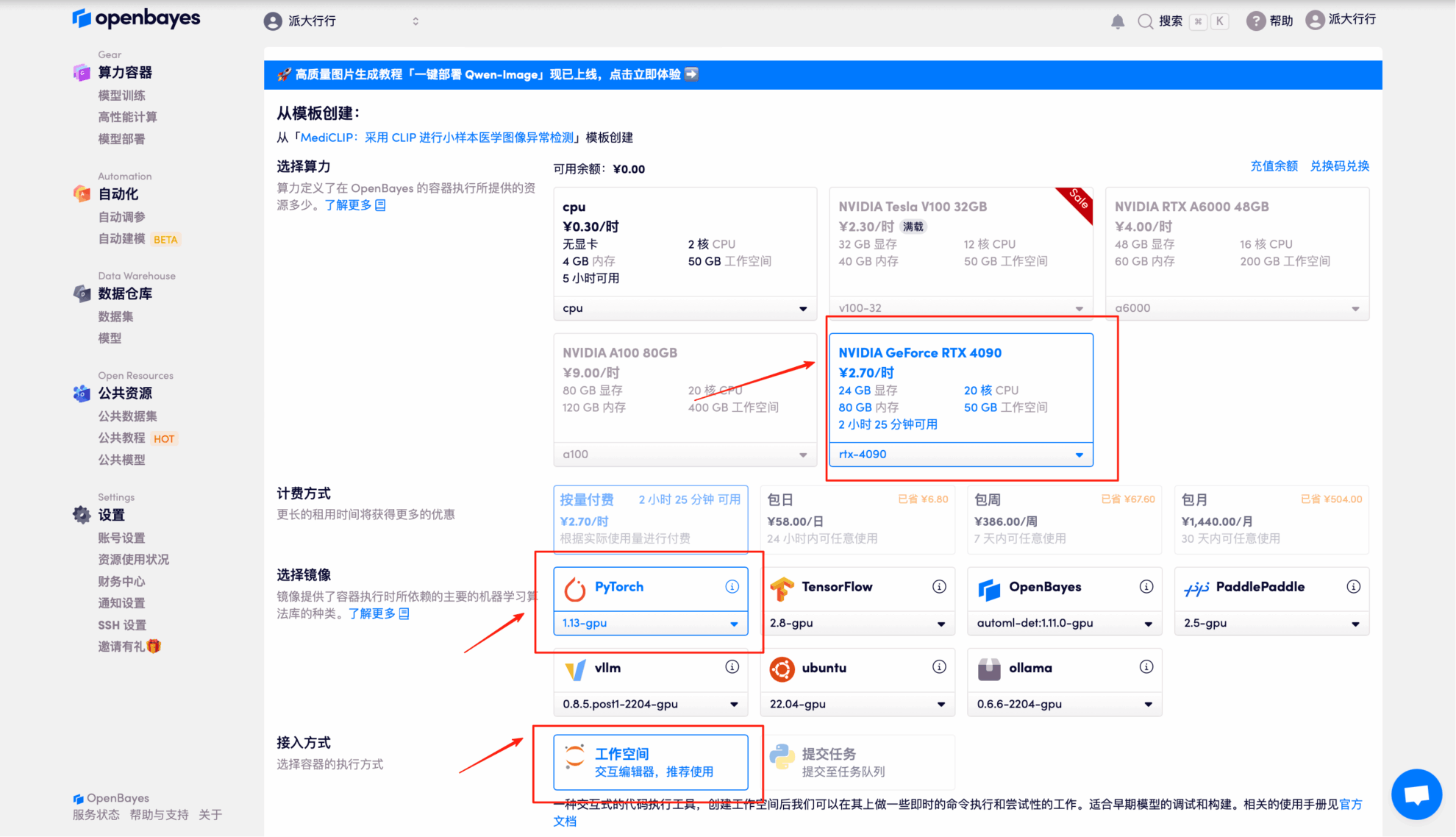

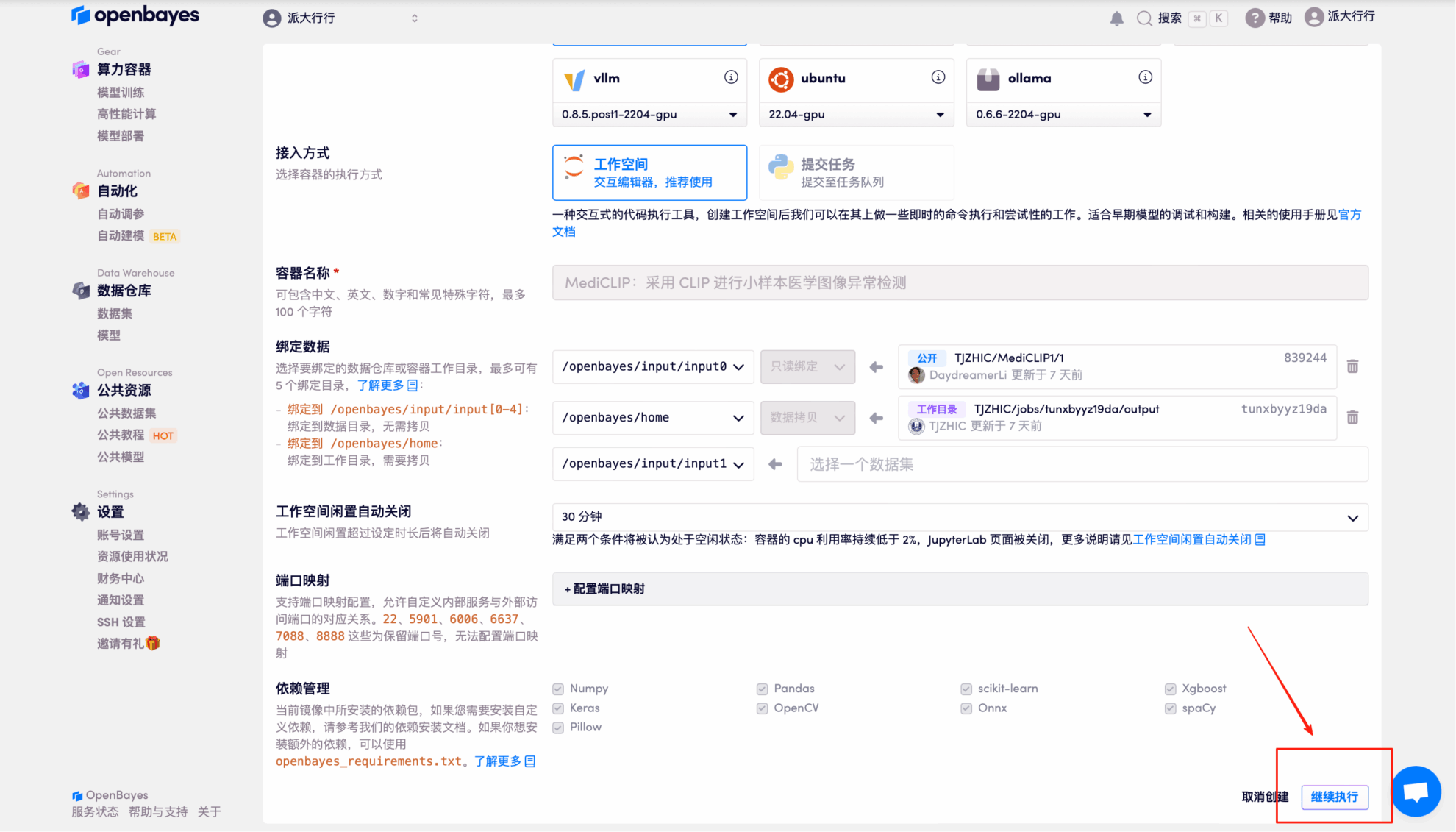

3. حدد صورة NVIDIA GeForce RTX 4090 وPyTorch، ثم انقر فوق متابعة. توفر منصة OpenBayes أربع طرق للدفع. يمكنك اختيار "الدفع حسب الاستخدام" أو "يوميًا/أسبوعيًا/شهريًا" وفقًا لاحتياجاتك. يمكن للمستخدمين الجدد التسجيل باستخدام رابط الدعوة أدناه للحصول على 4 ساعات من RTX 4090 + 5 ساعات من وقت فراغ وحدة المعالجة المركزية!

رابط دعوة حصرية لـ HyperAI (انسخ وافتح في المتصفح):

https://openbayes.com/console/signup?r=Ada0322_NR0n

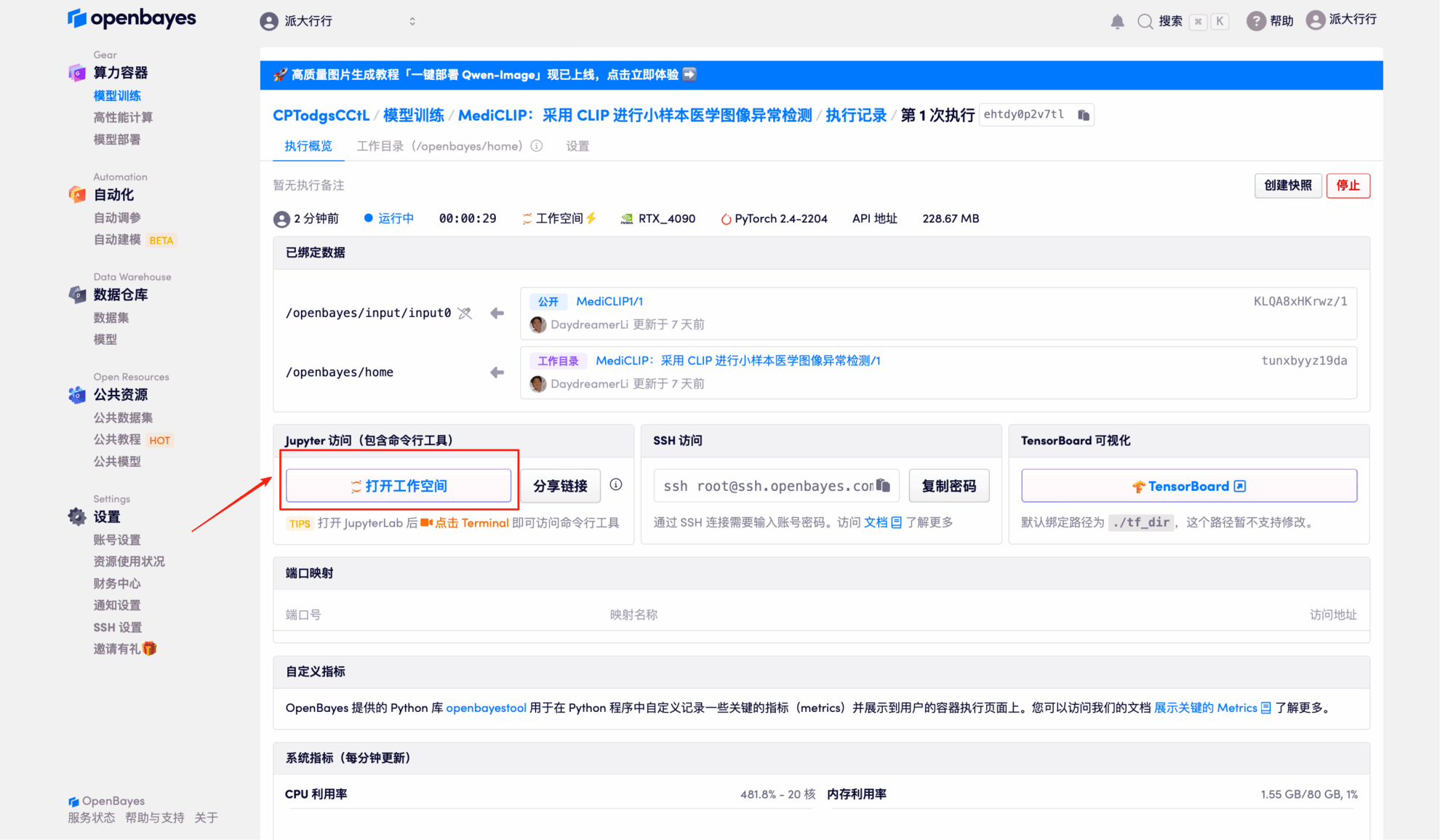

٤. انتظر حتى يتم تخصيص الموارد. سيستغرق الاستنساخ الأول دقيقتين تقريبًا. عندما تتغير الحالة إلى "قيد التشغيل"، انقر على "فتح مساحة العمل".

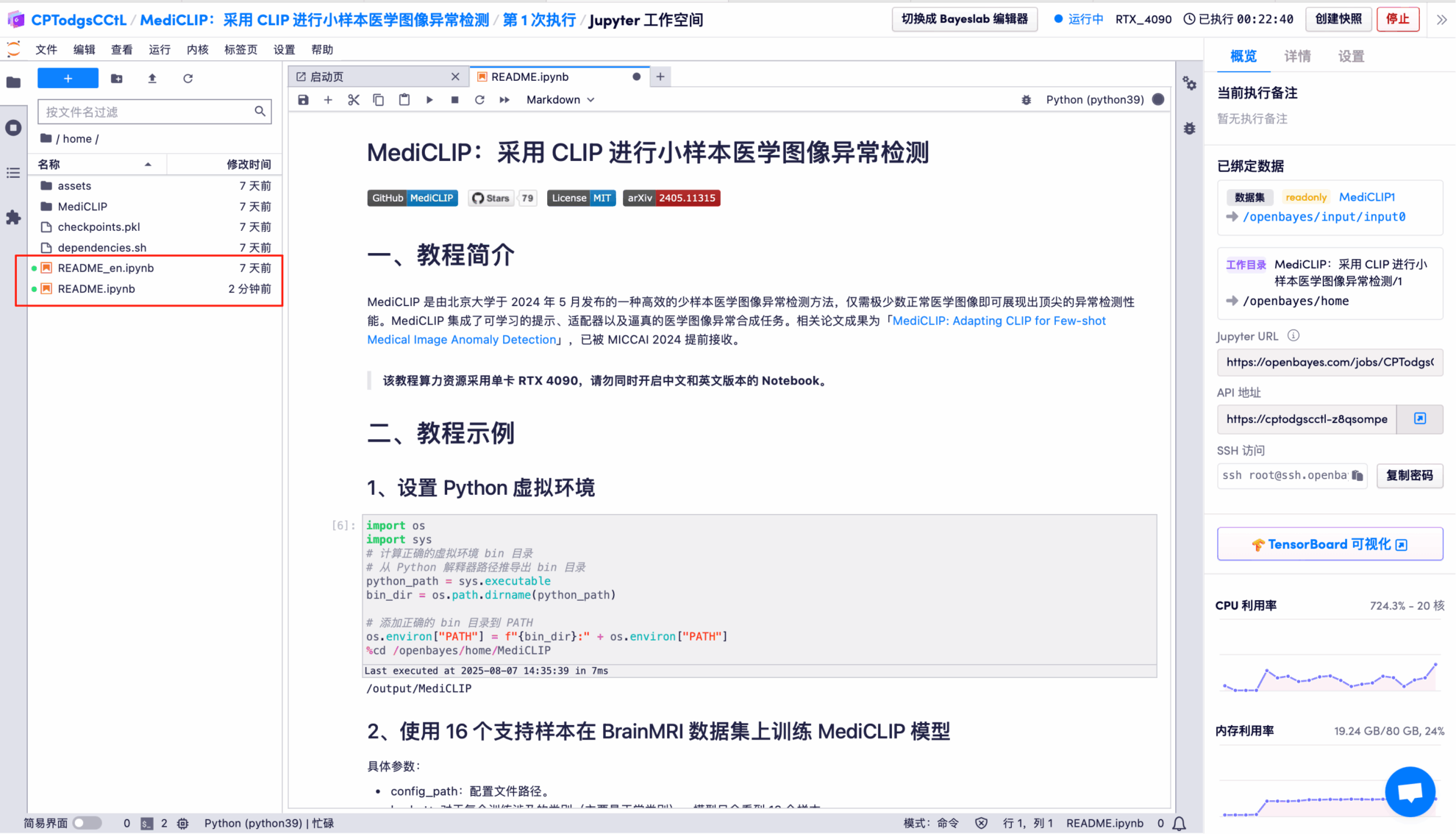

٥. انقر نقرًا مزدوجًا على اسم المشروع في المجلد الأيسر لبدء استخدامه. ملاحظة: يستخدم هذا البرنامج التعليمي وحدة معالجة رسومية واحدة من نوع RTX 4090. لا تفتح كلا النسختين الصينية والإنجليزية من جهاز الكمبيوتر المحمول في نفس الوقت؛ افتح إحداهما فقط. يُنصح باستخدام ملف README.ipynb (النسخة الصينية أسهل في القراءة).

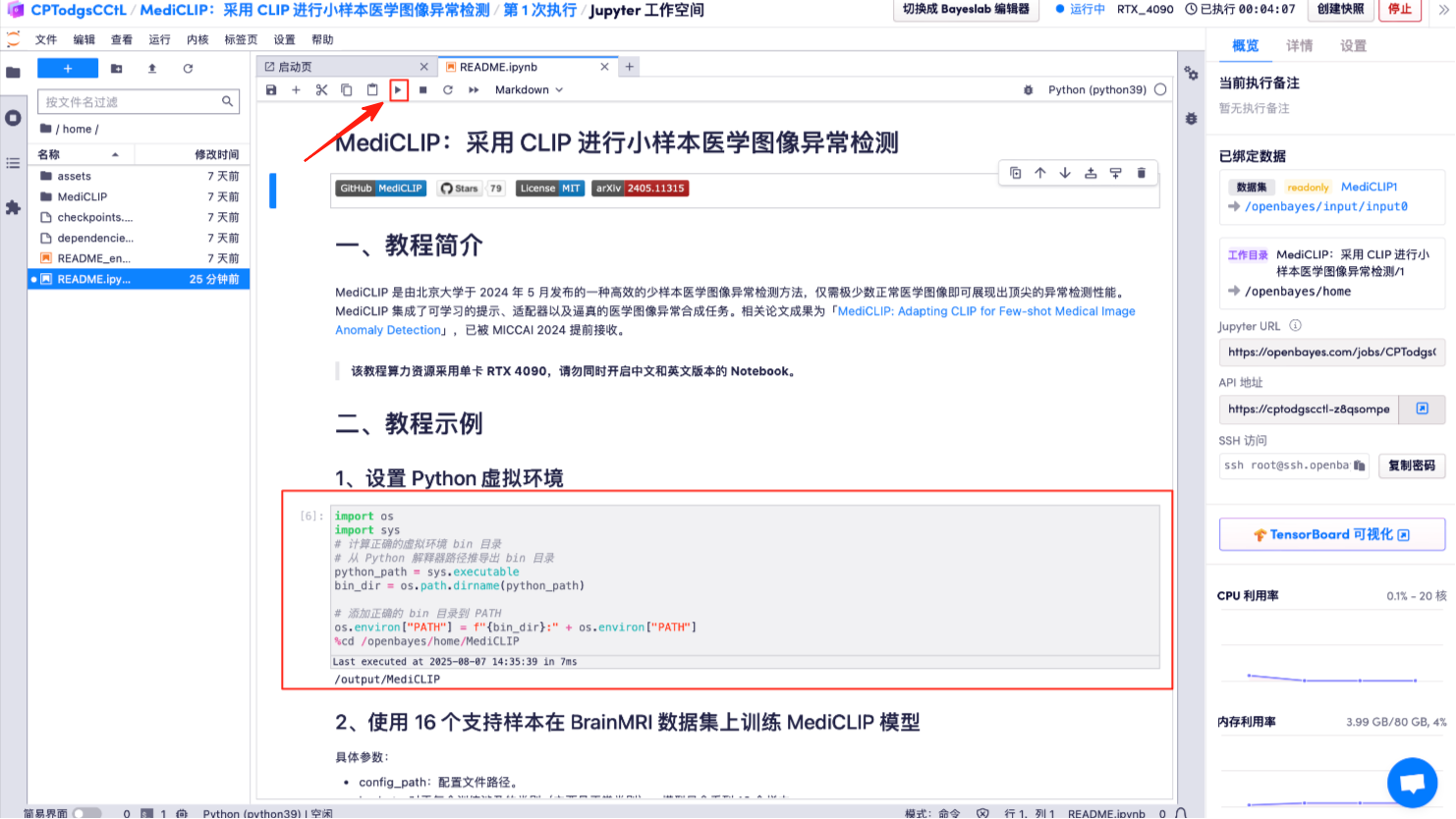

6. انقر فوق زر "تشغيل" أعلاه: قم بإعداد بيئة Python الافتراضية.

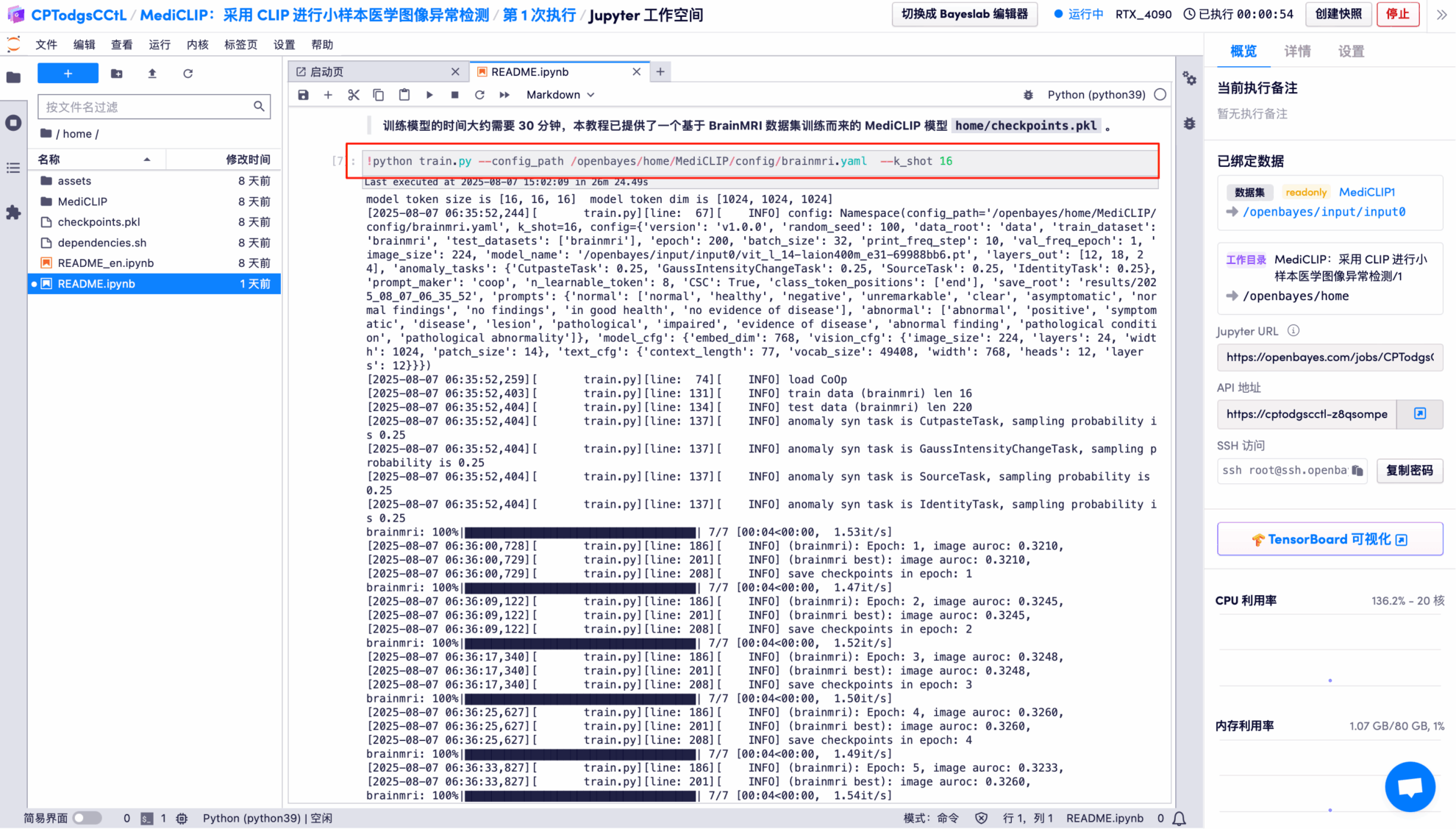

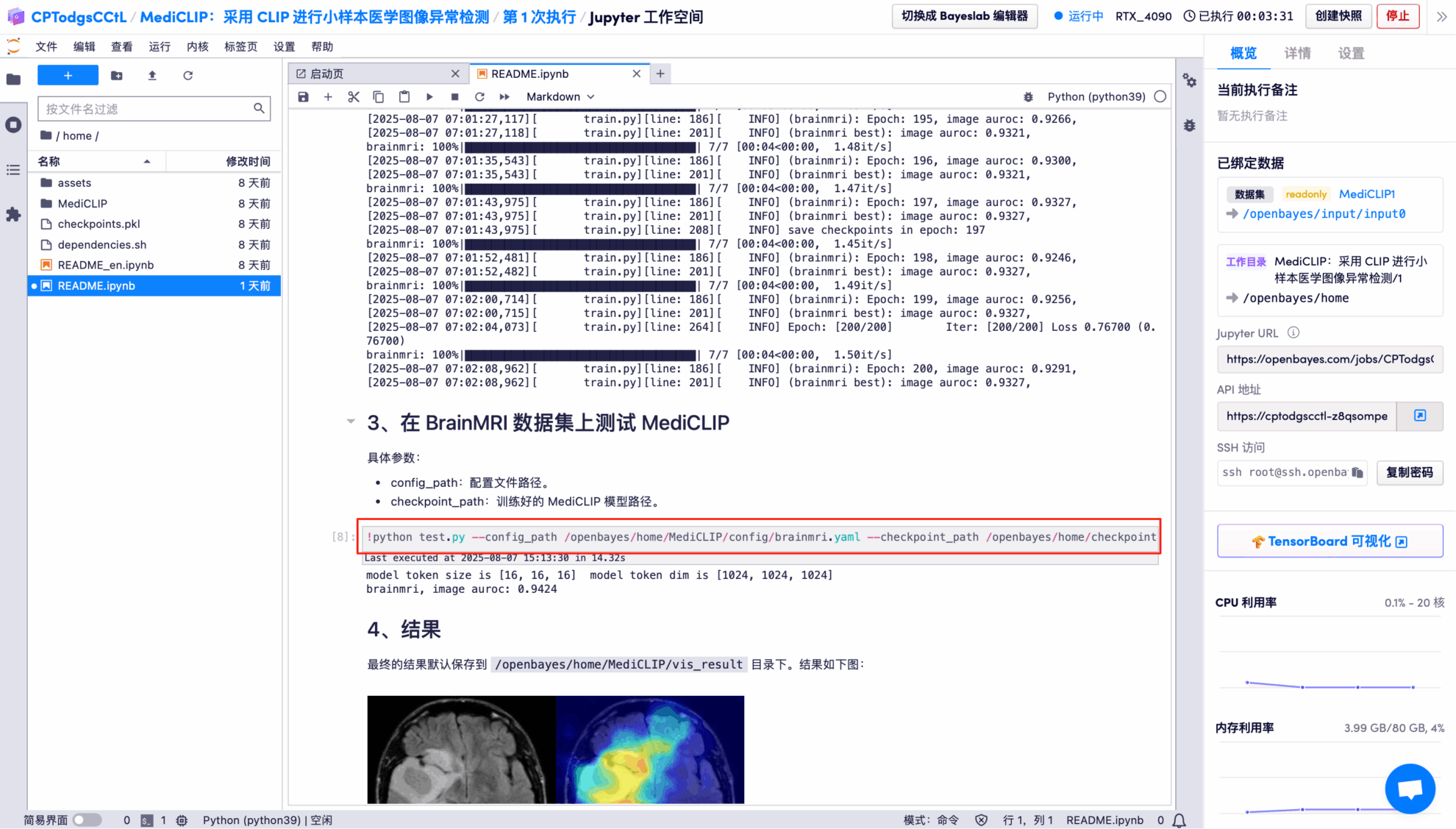

7. تم تدريب نموذج MediCLIP على مجموعة بيانات BrainMRI باستخدام 16 عينة دعم.

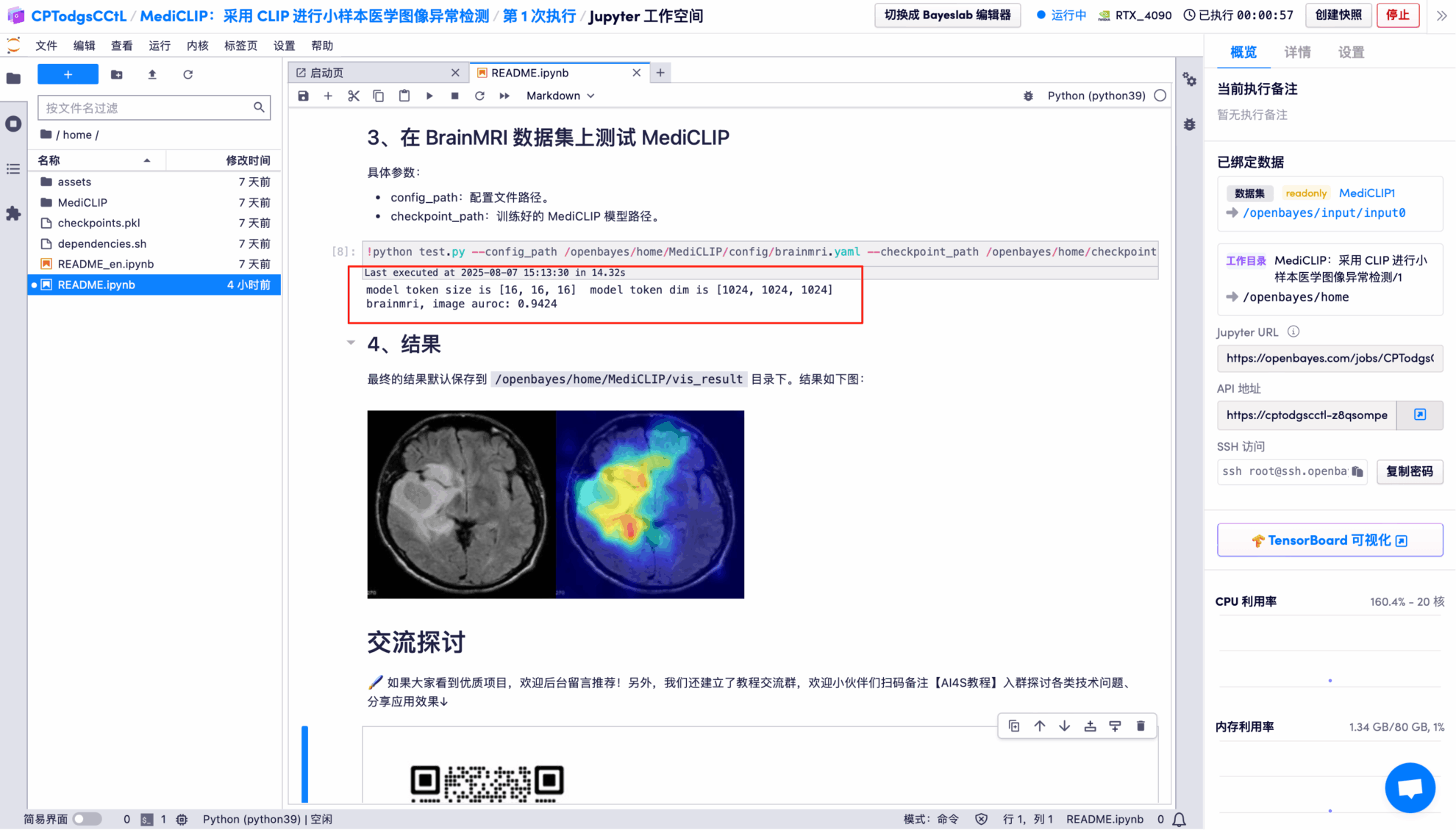

8. استخدم النموذج المدرب لاختبار مجموعة بيانات BrainMRI.

عرض التأثير

تظهر نتائج الإخراج أن النموذج يعمل بشكل جيد للغاية في التصنيف الثنائي للصور في مجموعة اختبار BrainMRI، مع AUROC بقيمة 0.9424 (قريبة من الدرجة الكاملة 1).

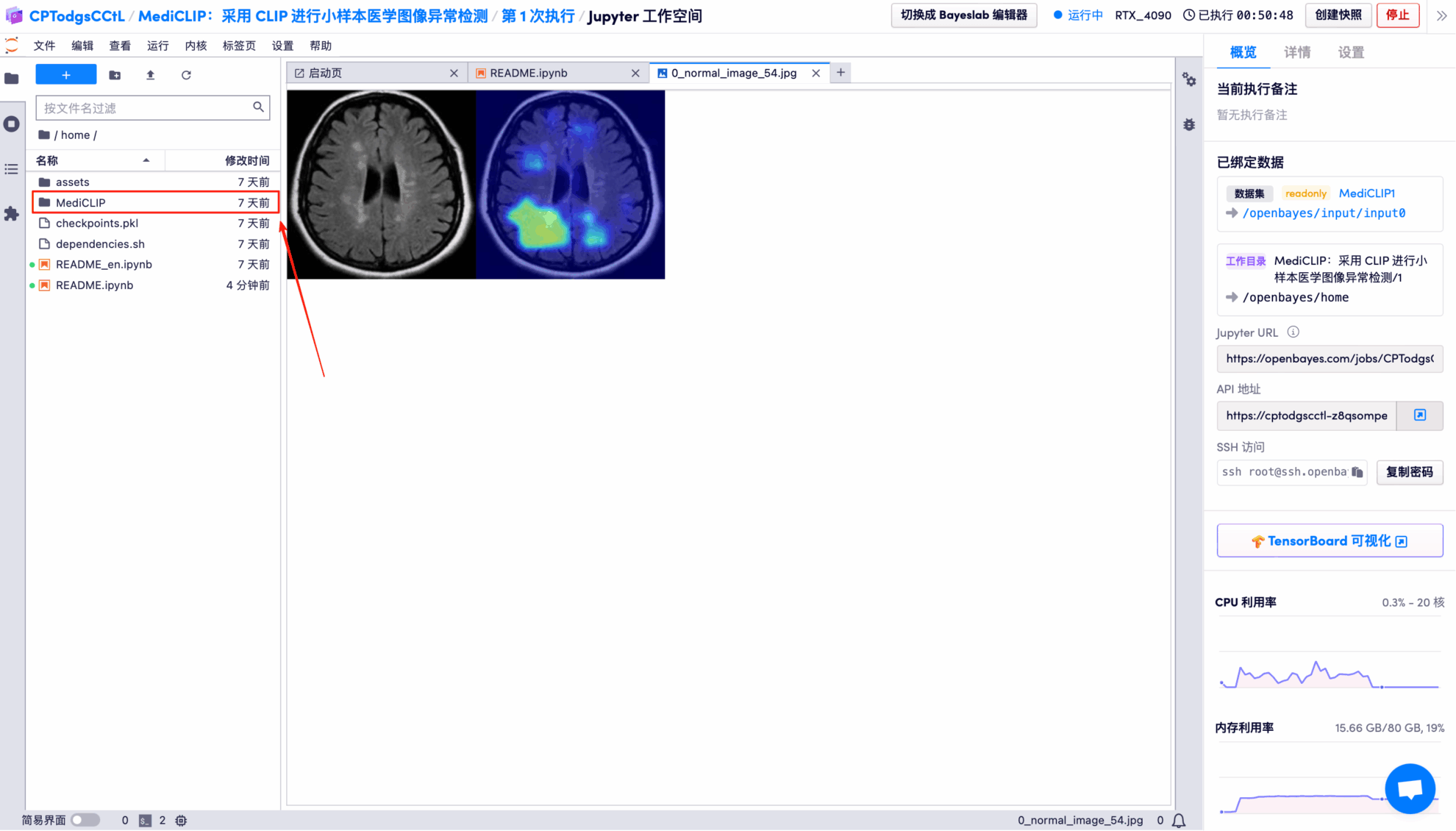

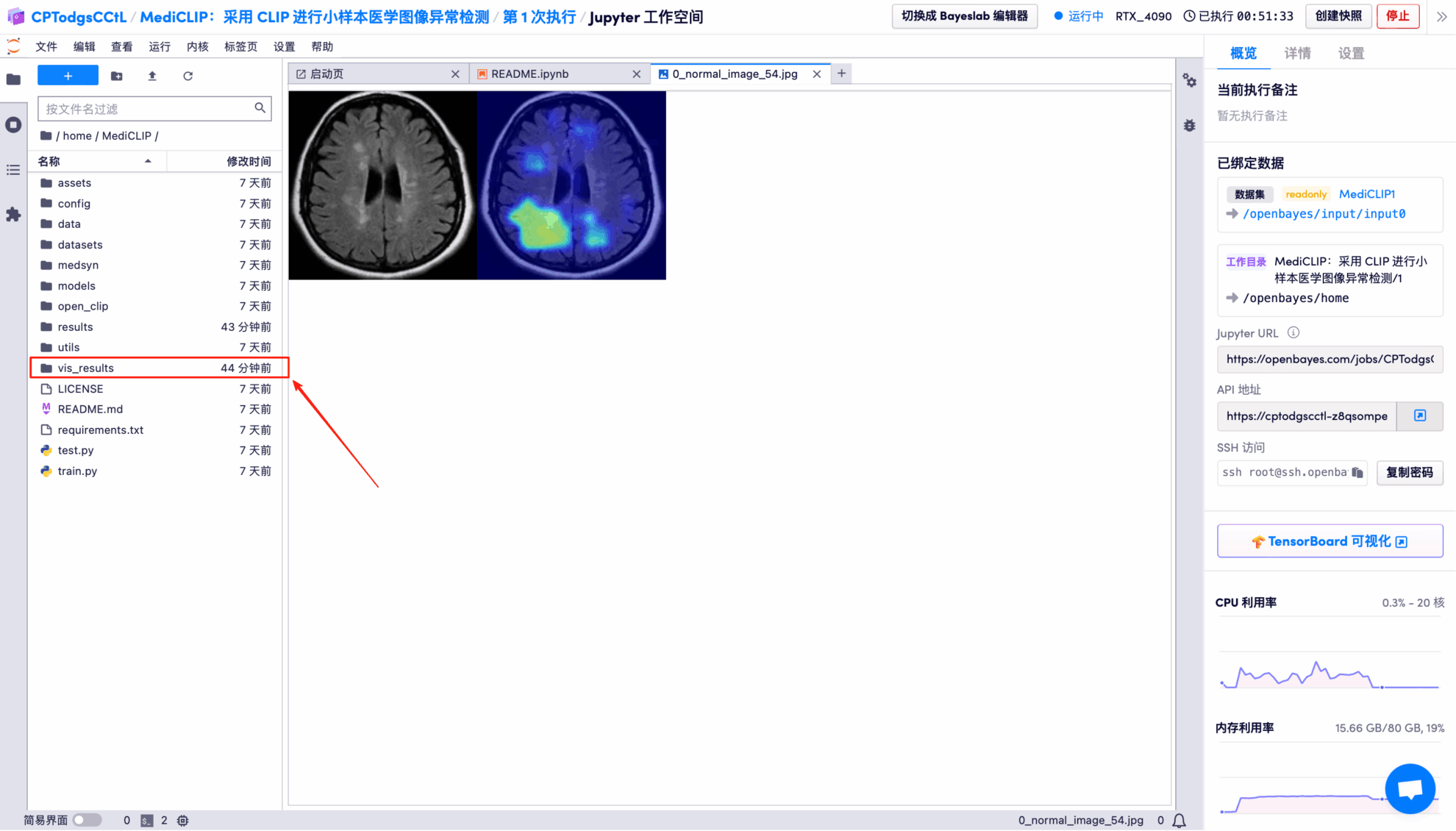

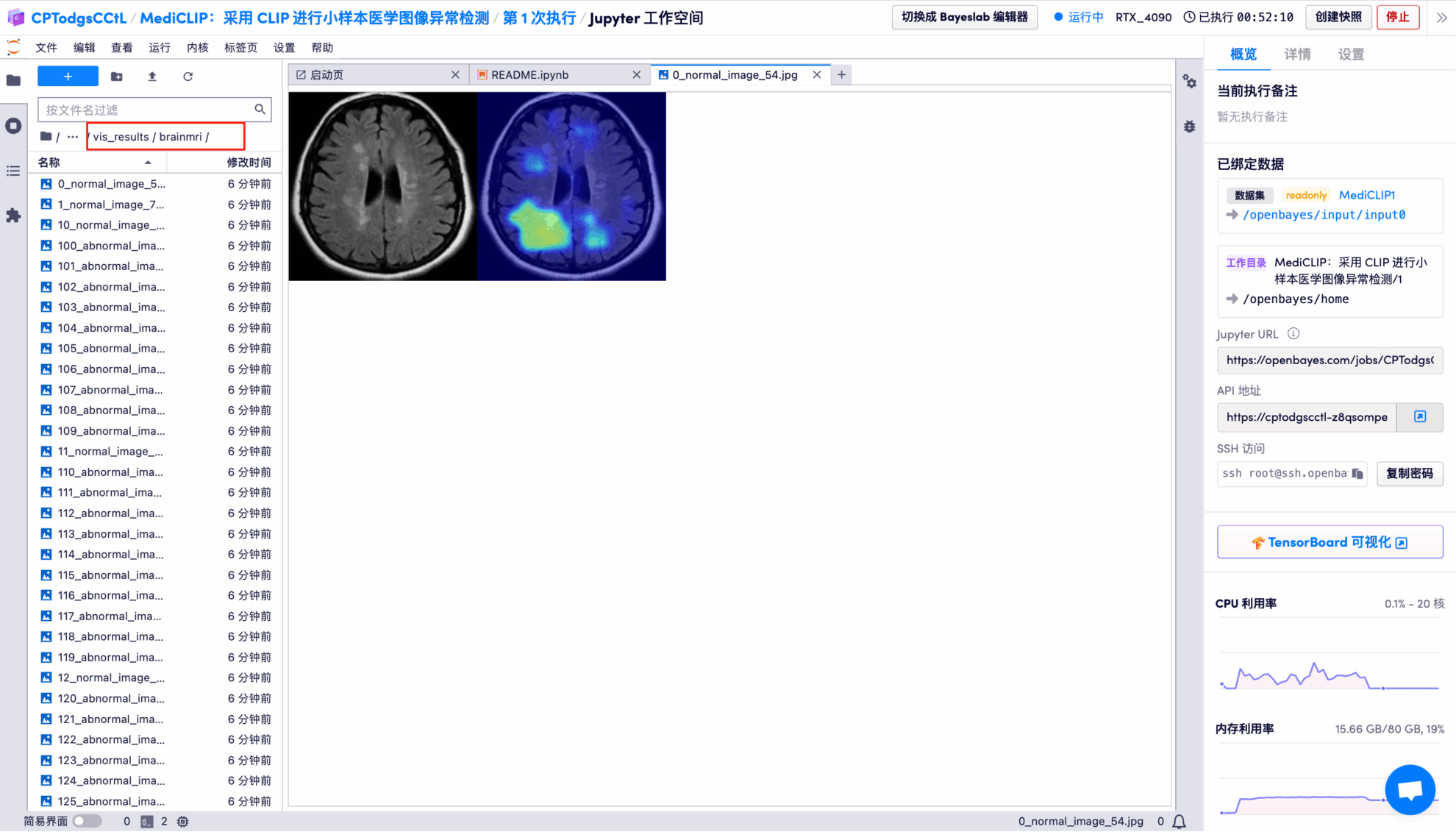

تُحفظ نتائج الكشف البصري للنموذج لكل صورة اختبار في مجلد openbayes//home/MediCLIP/vis_result افتراضيًا. يظهر الموقع المحدد في الشكل أدناه:

افتح صورة نتيجة الاختبار بشكل عشوائي، والتي يتم عرضها بوضوح وبديهية:

* اليسار: صورة الدماغ الأصلية

* يمين: تم تمييز "المنطقة غير الطبيعية"

ما سبق هو البرنامج التعليمي الذي توصي به HyperAI هذه المرة. الجميع مدعوون للحضور وتجربته!

رابط البرنامج التعليمي: