Command Palette

Search for a command to run...

ملخص الدروس العملية لـ vLLM، من تكوين البيئة إلى نشر النموذج الكبير، وتتبع الوثائق الصينية التحديثات الرئيسية

مع انتقال نموذج اللغة الكبير (LLM) تدريجيًا نحو الهندسة والنشر على نطاق واسع، أصبحت كفاءة التفكير، واستخدام الموارد، وقابلية تكيف الأجهزة قضايا أساسية تؤثر على تنفيذ التطبيقات. في عام 2023، قام فريق بحثي من جامعة كاليفورنيا، بيركلي، بإنشاء برنامج vLLM مفتوح المصدر، والذي قدم آلية PagedAttention لإدارة ذاكرة التخزين المؤقت KV بكفاءة، مما أدى إلى تحسين إنتاجية النموذج وسرعة الاستجابة بشكل كبير، وسرعان ما أصبح شائعًا في مجتمع المصدر المفتوح. حتى الآن، تجاوزت vLLM 46 ألف نجمة على GitHub وهي مشروع نجمي في إطار التفكير النموذجي الكبير.

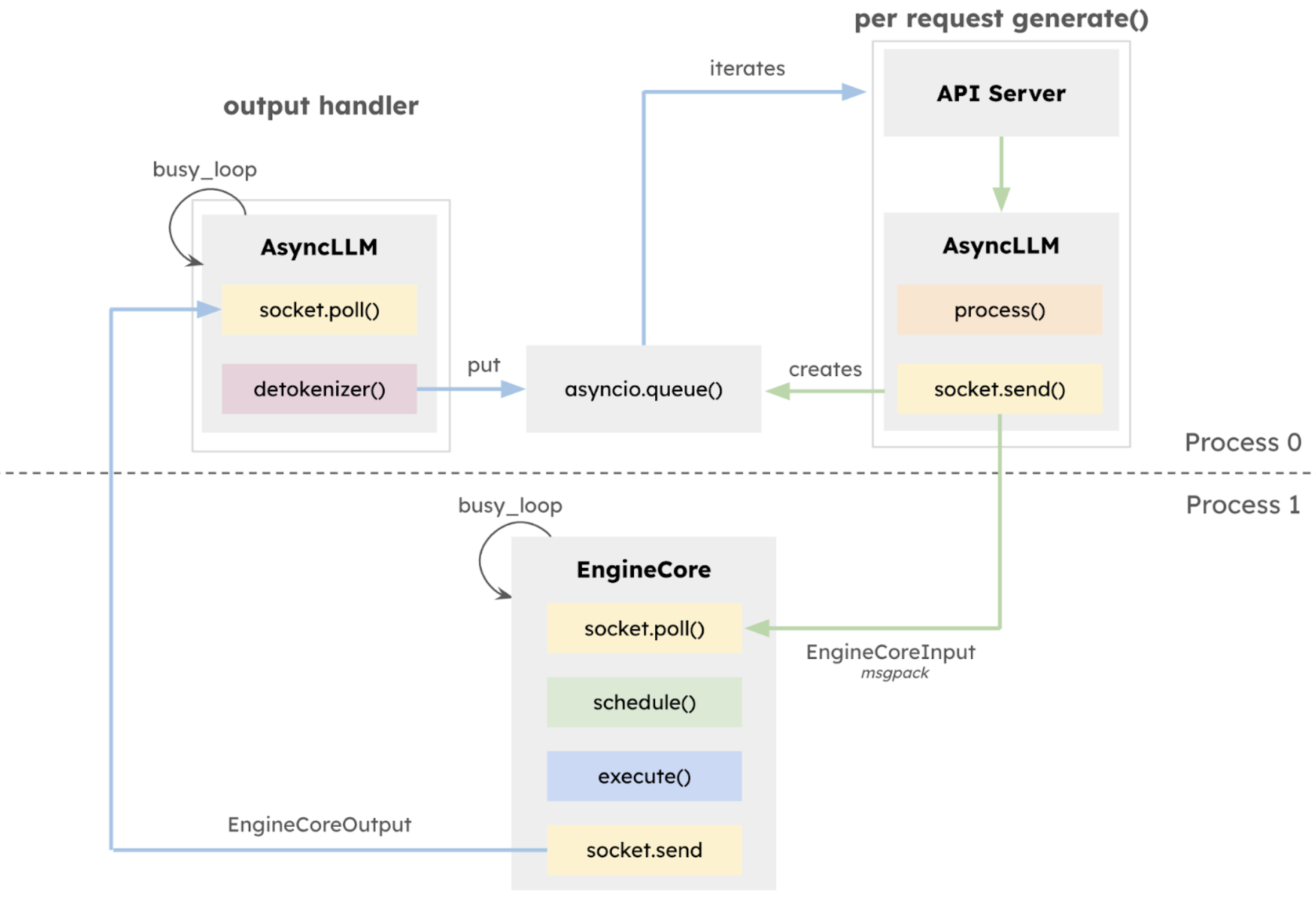

27 يناير 2025أصدر فريق vLLM الإصدار ألفا v1،تم إعادة هيكلة البنية الأساسية بشكل منهجي بناءً على أعمال التطوير التي تم إنجازها على مدار العامين الماضيين.إن جوهر هذه النسخة المحدثة v1 هو إعادة بناء شاملة لهندسة التنفيذ.تم تقديم EngineCore المعزول للتركيز على منطق تنفيذ النموذج، واعتماد التكامل العميق متعدد العمليات، وتحقيق التوازي في مهام وحدة المعالجة المركزية والتكامل العميق متعدد العمليات من خلال ZeroMQ، وفصل طبقة واجهة برمجة التطبيقات بشكل صريح عن جوهر الاستدلال، مما يحسن بشكل كبير من استقرار النظام.

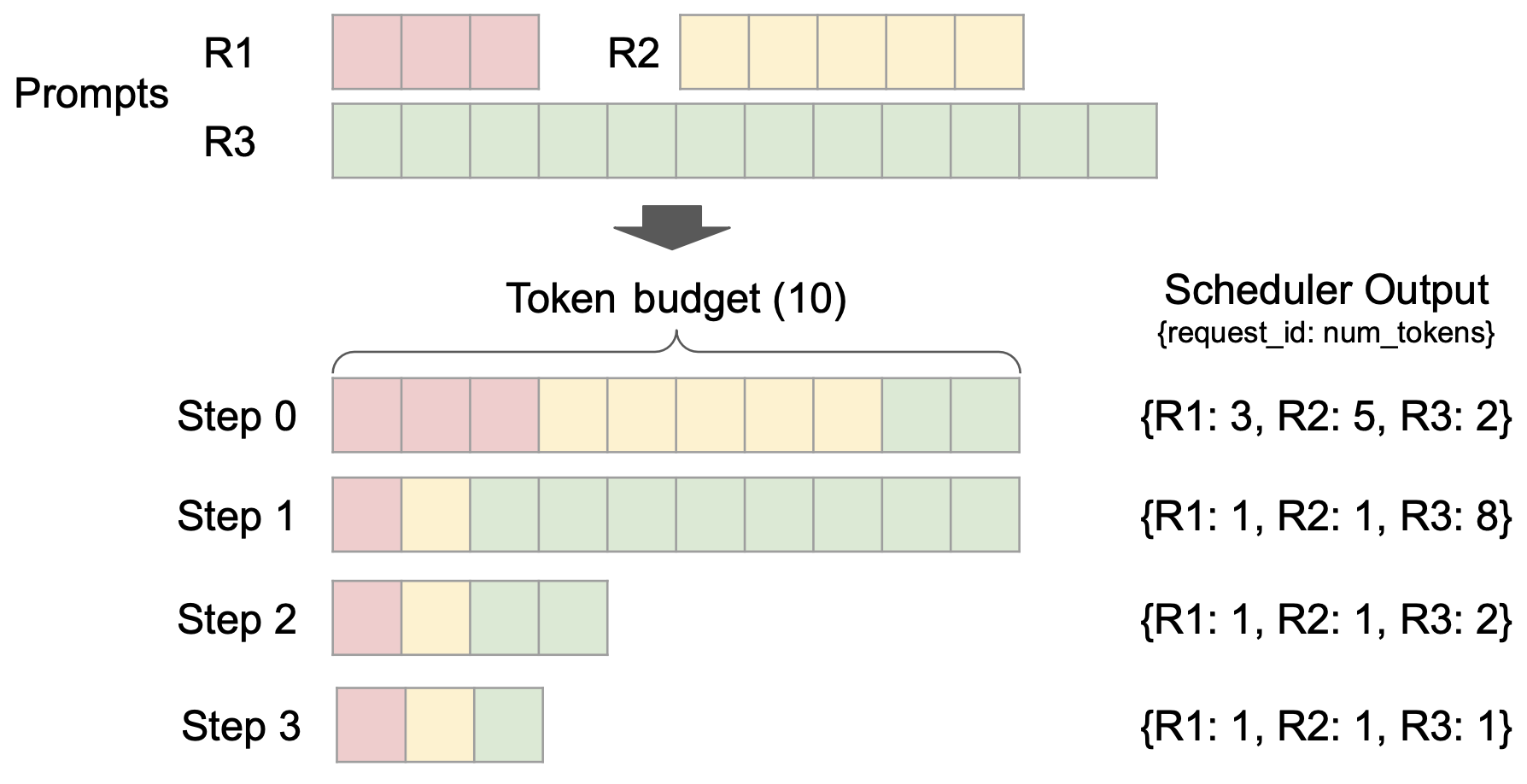

في الوقت نفسه، تم تقديم Unified Scheduler، الذي يتمتع بميزات جدولة دقيقة، ودعم فك التشفير المضاربي، والتعبئة المسبقة المقسمة، وما إلى ذلك.تحسين قدرات التحكم في زمن الوصول مع الحفاظ على معدل إنتاجية مرتفع.

أيضًا،يعتمد برنامج vLLM v1 على تصميم جدولة خالٍ من المراحل.تم تحسين معالجة إدخال المستخدم ورموز مخرجات النموذج، وتم تبسيط منطق الجدولة. لا يدعم المجدول التعبئة المسبقة المجزأة وتخزين البادئة فحسب، بل يمكنه أيضًا إجراء فك تشفير تخميني، مما يحسن كفاءة الاستدلال بشكل فعال.

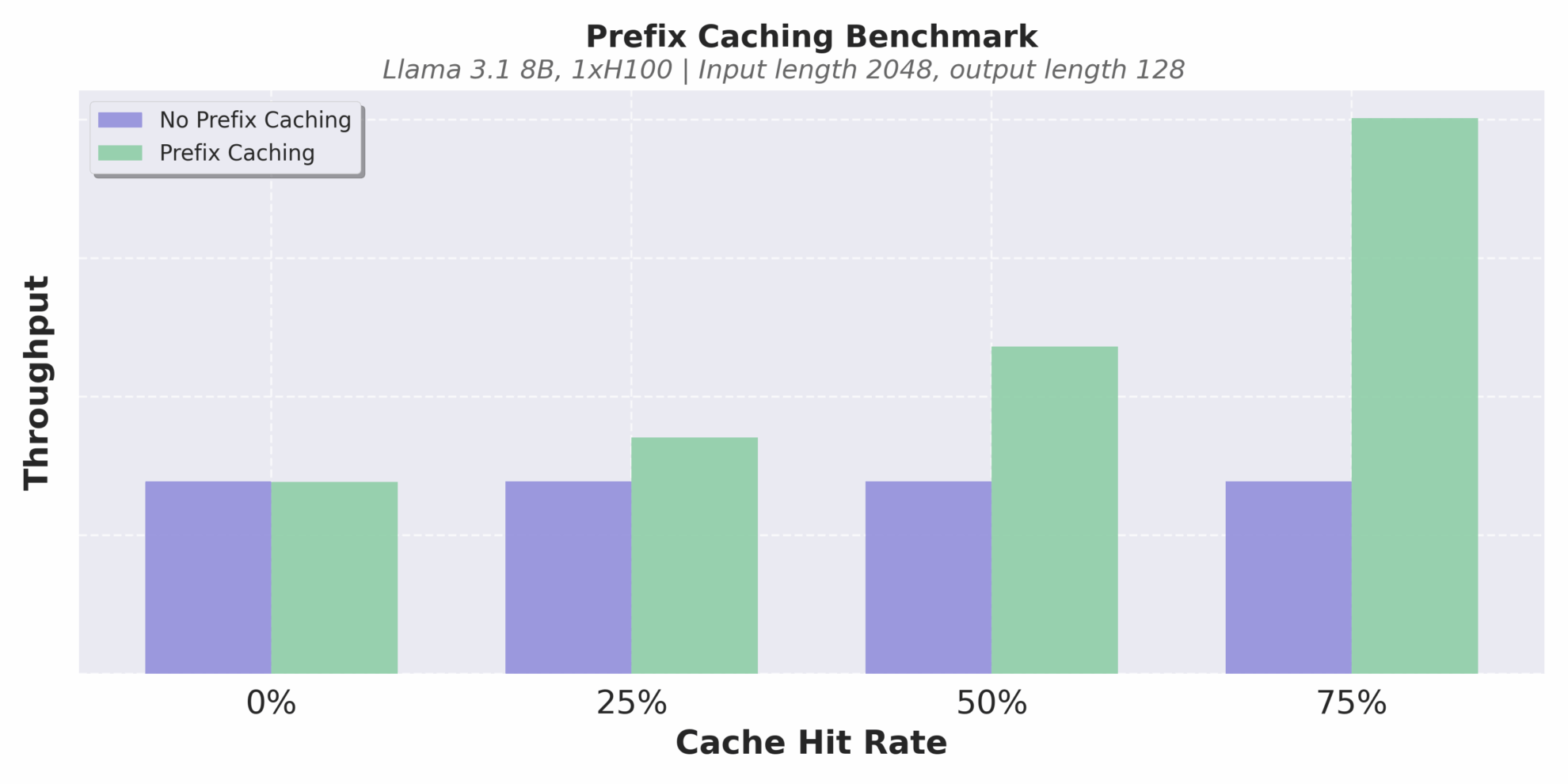

ويعد تحسين آلية التخزين المؤقت أحد أبرز الميزات. ينفذ vLLM v1 تخزين البادئة بدون تكلفة إضافية.حتى في سيناريوهات التفكير النصي الطويل مع معدلات إصابة ذاكرة التخزين المؤقت المنخفضة للغاية، فإنه يمكن أن يتجنب بشكل فعال الحسابات المتكررة ويحسن اتساق التفكير وكفاءته.

معدل الإنتاج عند معدلات إصابة مختلفة للذاكرة المؤقتة

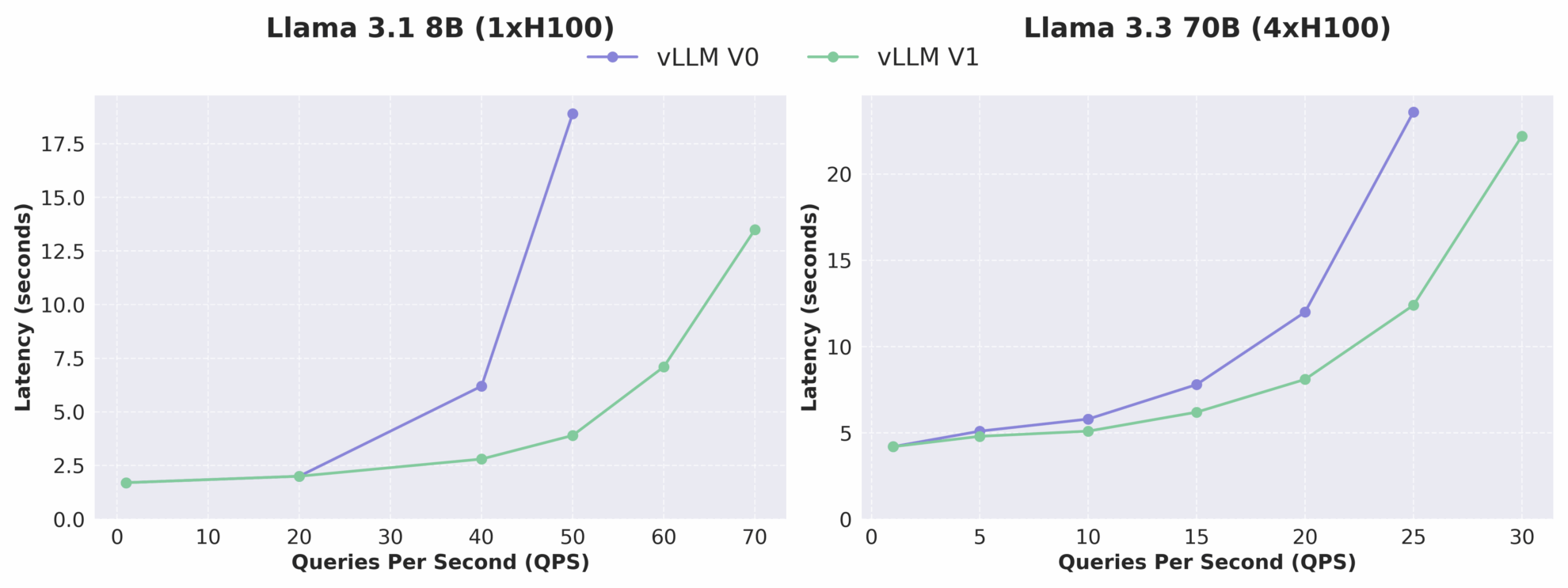

كما يمكن أن نرى من الشكل أدناه، تم زيادة إنتاجية vLLM v1 بما يصل إلى 1.7 مرة مقارنة بـ v0، وخاصة في حالة QPS العالية، حيث يكون تحسن الأداء أكثر أهمية. تجدر الإشارة إلى أن vLLM v1، باعتباره إصدارًا ألفا، لا يزال قيد التطوير النشط وقد يكون لديه مشكلات في الاستقرار والتوافق، ولكن اتجاه التطور المعماري الخاص به أشار بوضوح إلى الأداء العالي وقابلية الصيانة العالية والوحدات النمطية العالية، مما يضع أساسًا متينًا للفرق اللاحقة لتطوير ميزات جديدة بسرعة.

مقارنة العلاقة بين زمن الوصول وQPS بين vLLM V0 وV1

في الشهر الماضي فقط، قام فريق vLLM أيضًا بإجراء تحديث بسيط للإصدار، مع التركيز على تحسين توافق النموذج واستقرار التفكير. يقدم هذا الإصدار المحدث من vLLM v0.8.5 دعمًا لليوم الأول لنماذج Qwen3 وQwen3MoE، ويضيف تكوين نواة MoE المدمجة FP8_W8A8، ويصلح الأخطاء الحرجة في السيناريوهات المتعددة الوسائط، ويعزز بشكل أكبر قوة الأداء في بيئات الإنتاج.

من أجل مساعدتك في البدء باستخدام vLLM بكفاءة أكبر، قام المحرر بتجميع سلسلة من البرامج التعليمية العملية وحالات النموذج، والتي تغطي العملية الكاملة من التثبيت الأساسي إلى نشر الاستدلال.مساعدة الجميع على البدء بسرعة والحصول على فهم متعمق. الأصدقاء المهتمين، تعالوا وجربوها!

يمكن العثور على المزيد من المستندات والبرامج التعليمية الصينية الخاصة ببرنامج vLLM على:

البرنامج التعليمي الأساسي

1 . دليل البدء في برنامج vLLM: دليل خطوة بخطوة للمبتدئين

* التشغيل عبر الإنترنت:https://go.hyper.ai/Jy22B

يوضح هذا البرنامج التعليمي خطوة بخطوة كيفية تكوين وتشغيل vLLM، ويوفر دليلاً كاملاً للبدء في تثبيت vLLM، واستنتاج النموذج، وبدء تشغيل خادم vLLM، وكيفية تقديم الطلبات.

2 . استخدام vLLM للتفكير في Qwen2.5

* التشغيل عبر الإنترنت:https://go.hyper.ai/SwVEa

يوضح هذا البرنامج التعليمي بالتفصيل كيفية تنفيذ مهام الاستدلال على نموذج لغوي كبير مع معلمات 3B، بما في ذلك تحميل النموذج، وإعداد البيانات، وتحسين عملية الاستدلال، واستخراج النتائج وتقييمها.

3 . تحميل النماذج الكبيرة باستخدام vLLM , أداء التعلم من خلال عدد قليل من اللقطات

* التشغيل عبر الإنترنت:https://go.hyper.ai/OmVjM

يستخدم هذا البرنامج التعليمي vLLM لتحميل نموذج Qwen2.5-3B-Instruct-AWQ للتعلم من خلال عدد قليل من اللقطات. يشرح بالتفصيل كيفية استرجاع بيانات التدريب للحصول على أسئلة مماثلة لبناء الحوارات، واستخدام النموذج لتوليد مخرجات مختلفة، واستنتاج سوء الفهم والجمع بين الأساليب ذات الصلة للتصنيف المتكامل، وما إلى ذلك، لتحقيق عملية كاملة من إعداد البيانات إلى تقديم النتيجة.

4 . دمج LangChain مع vLLM , درس تعليمي

* التشغيل عبر الإنترنت:https://go.hyper.ai/Y1EbK

يركز هذا البرنامج التعليمي على استخدام LangChain مع vLLM، بهدف تبسيط وتسريع تطوير تطبيقات LLM الذكية، وتغطية مجموعة واسعة من المحتوى من الإعدادات الأساسية إلى التطبيقات الوظيفية المتقدمة.

نشر نموذج كبير

1 . نشر Qwen3-30B-A3B باستخدام vLLM

* الجهة المصدرة:فريق علي بابا كوين

* التشغيل عبر الإنترنت:https://go.hyper.ai/6Ttdh

أظهر Qwen3-235B-A22B قدرات مماثلة لتلك الخاصة بـ DeepSeek-R1 و o1 و o3-mini و Grok-3 و Gemini-2.5-Pro في اختبارات معيارية مثل الكود والرياضيات والقدرات العامة. ومن الجدير بالذكر أن عدد المعلمات النشطة لـ Qwen3-30B-A3B هو 10% فقط من QwQ-32B، ولكن أداءه أفضل. حتى نموذج صغير مثل Qwen3-4B يمكن أن يضاهي أداء Qwen2.5-72B-Instruct.

2 . نشر GLM-4-32B باستخدام vLLM

* الجهة المصدرة:زيبو منظمة العفو الدولية، جامعة تسينغهوا

* التشغيل عبر الإنترنت:https://go.hyper.ai/HJqqO

حقق GLM-4-32B-0414 نتائج جيدة في هندسة الكود، وتوليد القطع الأثرية، واستدعاء الوظائف، والإجابة على الأسئلة القائمة على البحث، وتوليد التقارير. على وجه الخصوص، في العديد من المعايير مثل إنشاء الكود أو مهام الإجابة على الأسئلة المحددة، يحقق GLM-4-32B-Base-0414 أداءً مماثلاً للنماذج الأكبر مثل GPT-4o وDeepSeek-V3-0324 (671B).

3 . النشر باستخدام vLLM , DeepCoder-14B-معاينة

* الجهة المصدرة:فريق أجينتيكا، معًا للذكاء الاصطناعي

* التشغيل عبر الإنترنت:https://go.hyper.ai/sYwfO

يعتمد النموذج على DeepSeek-R1-Distilled-Qwen-14B وتم ضبطه بدقة من خلال التعلم التعزيزي التوزيعي (RL). يحتوي على 14 مليار معلمة ويحقق دقة Pass@1 تبلغ 60.6% في اختبار LiveCodeBench v5، وهو ما يمكن مقارنته بـ o3-mini من OpenAI.

4 . النشر باستخدام vLLM , جيما-3-27ب-IT

* الجهة المصدرة:فريق MetaGPT

* التشغيل عبر الإنترنت:https://go.hyper.ai/0rZ7j

Gemma 3 هو نموذج متعدد الوسائط كبير الحجم يمكنه معالجة مدخلات النصوص والصور وإنشاء مخرجات نصية. توفر كل من الإصدارات المدربة مسبقًا والإصدارات الموجهة للتعليمات أوزانًا مفتوحة لمجموعة متنوعة من مهام إنشاء النصوص وفهم الصور، بما في ذلك الإجابة على الأسئلة والتلخيص والاستدلال. إن حجمها الصغير نسبيًا يمكّن من نشرها في البيئات ذات الموارد المحدودة. يستخدم هذا البرنامج التعليمي gemma-3-27b-it كعرض توضيحي لاستنتاج النموذج.

المزيد من التطبيقات

1 .OpenManus + QwQ-32B , تنفيذ وكيل الذكاء الاصطناعي

* الجهة المصدرة:فريق MetaGPT

* التشغيل عبر الإنترنت:https://go.hyper.ai/RqNME

OpenManus هو مشروع مفتوح المصدر أطلقه فريق MetaGPT في مارس 2025. ويهدف إلى تكرار الوظائف الأساسية لـ Manus وتزويد المستخدمين بحل وكيل ذكي يمكن نشره محليًا دون رمز دعوة. QwQ هو نموذج الاستدلال لسلسلة Qwen. وبالمقارنة مع نماذج ضبط التعليمات التقليدية، يتمتع QwQ بقدرات التفكير والاستدلال، ويمكنه تحقيق تحسينات كبيرة في الأداء في المهام اللاحقة، وخاصة المشكلات الصعبة. يوفر هذا البرنامج التعليمي خدمات الاستدلال لـ OpenManus استنادًا إلى نموذج QwQ-32B وgpt-4o.

2 .RolmOCR OCR فائق السرعة عبر السيناريوهات , معيار جديد لتحديد الهوية مفتوح المصدر

* الجهة المصدرة:ريدكتو اي

* التشغيل عبر الإنترنت:https://go.hyper.ai/U3HRH

RolmOCR هي أداة OCR مفتوحة المصدر تم تطويرها استنادًا إلى نموذج اللغة المرئية Qwen2.5-VL-7B. يمكنه استخراج النص من الصور وملفات PDF بسرعة وباستخدام منخفض للذاكرة، متفوقًا على الأدوات المماثلة مثل olmOCR. لا يعتمد RolmOCR على بيانات PDF، مما يسهل العملية ويدعم مجموعة واسعة من أنواع المستندات، مثل الملاحظات المكتوبة بخط اليد والأوراق الأكاديمية.

ما ورد أعلاه هو البرنامج التعليمي المرتبط بـ vLLM والذي أعده المحرر. إذا كنت مهتمًا، تعال واختبره بنفسك!

من أجل مساعدة المستخدمين المحليين على فهم وتطبيق vLLM بشكل أفضل،تعاون متطوعو مجتمع HyperAI لإكمال أول مستند vLLM باللغة الصينية، والذي أصبح الآن متاحًا بالكامل على hyper.ai.يغطي المحتوى مبادئ النموذج ودروس النشر وتفسيرات الإصدارات، مما يوفر للمطورين الصينيين مسارًا تعليميًا منهجيًا وموارد عملية.

يمكن العثور على المزيد من المستندات والبرامج التعليمية الصينية الخاصة ببرنامج vLLM على:https://vllm.hyper.ai