Command Palette

Search for a command to run...

GPT-4o صدمة قتل التنين! ChatGPT هو تطبيق تفاعلي متعدد الوسائط في الوقت الفعلي ومجاني للجميع. يتمتع بتفاعل صوتي سلس. هذا هو الفائز.

تم الكشف في أوائل شهر مايو عن أنه سيتم إطلاق محرك بحث في التاسع من الشهر؛ في 11 مايو، تم الإعلان رسميًا عن أنه سيتم إصدار تحديثات ChatGPT وGPT-4 في الساعة 10 صباحًا بالتوقيت المحلي في 13 مايو؛ ثم خرج سام ألتمان شخصيًا لدحض الشائعة، قائلاً "إنه ليس GPT-5، ولا هو محرك بحث"، بل "شيء جديد مثل السحر"؛ وبعد ذلك، بدأ مستخدمو الإنترنت في البحث بعمق في محتوى الإصدار من خلال أدلة مختلفة، وفي النهاية أصبح GPT-4.5 ووظيفة الاتصال ChatGPT من المرشحين الشائعين.

في البداية، مازح بعض مستخدمي الإنترنت بأن سام ألتمان كان يحاول سرقة الأضواء من مؤتمر Google I/O، ولكن بالمقارنة مع المواجهة بين Gemini 1.5 وSora، إذا لم يكن هناك شيء "صعب"، فربما لن يكون ألتمان على استعداد للمخاطرة بإصدار تحديث في اليوم السابق للمؤتمر السنوي لجوجل.

وهذا هو الحال بالفعل. كان مؤتمر البث المباشر عبر الإنترنت الذي عقدته شركة OpenAI، والذي بدا مرتجلاً، مُجهزًا بشكل جيد في الواقع.

لم يكن سام ألتمان حاضرًا في تحديثات الربيع الخاصة بشركة OpenAI، لكن مدير التكنولوجيا الرئيسي للشركة موري موراتي جلب سلسلة من التحديثات، بما في ذلك:

- جي بي تي-4o

- وظيفة التفاعل الصوتي في ChatGPT

- القدرات المرئية لـ ChatGPT

GPT-4o: تحسين الصوت، مجاني لجميع المستخدمين

منذ إصداره في مارس 2023، هيمن GPT-4 على المخططات لفترة طويلة. عندما يتم إصدار نموذج جديد، سيتم إخراجه للمقارنة، وهو ما يكفي لإثبات أدائه القوي. علاوة على ذلك، فإن GPT-4 هي أيضًا "بقرة حلوب" ذات قيمة تجارية كبيرة لشركة OpenAI في هذه المرحلة، وقد تعرضت لانتقادات متكررة من قبل ماسك لكونها "غير مفتوحة".

الأمر الأكثر أهمية هو أنه في مواجهة Llama مفتوح المصدر من Meta، وGemma مفتوح المصدر من Google، وGrok مفتوح المصدر من Musk، فإن النسخة المجانية من ChatGPT المستندة إلى GPT-3.5 تتعرض لضغط مضاعف. نظرًا لأن GPT-5 لم يظهر بعد، تكهن العديد من مستخدمي الإنترنت بأن OpenAI ستصدر نسخة جديدة من GPT-4 لتحل محل GPT-3.5.

كما كان متوقعًا، في البث المباشر اليوم، أصدرت OpenAI إصدارًا جديدًا، GPT-4o، وهو مجاني لجميع المستخدمين للاستخدام، وسيحصل المستخدمون المدفوعون على حد سعة أكبر بخمس مرات من المستخدمين المجانيين. يشير الحرف "o" إلى "omni"، وهو ما يشير إلى التحرك نحو تفاعل أكثر طبيعية بين الإنسان والحاسوب.

أعلن المدير التقني لشركة OpenAI، موري موراتي، أن GPT-4o يوفر قدرات الذكاء الاصطناعي على مستوى GPT-4 ويمكنه إجراء التفكير بناءً على الكلام والنص والرؤية. إنه يقبل أي مجموعة من النصوص والصوت والصورة المدخلة، ويمكنه إنشاء أي مجموعة من النصوص والصوت والصورة الناتجة.

انقر على الرابط لمشاهدة فيديو توضيحي لـ GPT-4o:

https://www.bilibili.com/video/BV1PH4y137ch

قبل GPT-4o، كان متوسط زمن الوصول للمحادثة مع ChatGPT باستخدام وضع الصوت 2.8 ثانية (GPT-3.5) و5.4 ثانية (GPT-4). لتحسين التجربة التفاعلية، قامت OpenAI بتدريب نموذج جديد شامل للنص والرؤية والصوت، مما يعني أن جميع المدخلات والمخرجات تتم معالجتها بواسطة نفس الشبكة العصبية، مما يقلل من فقدان المعلومات.

من حيث الأداء، يمكن لـ GPT-4o الاستجابة لإدخال الصوت في غضون 232 ميلي ثانية، مع متوسط وقت رد فعل يبلغ 320 ميلي ثانية، وهو ما يشبه وقت رد فعل البشر في المحادثة. بالإضافة إلى ذلك، يعمل GPT-4o على قدم المساواة مع GPT-4 Turbo على النصوص الإنجليزية والنصوص البرمجية، ويحسن أيضًا بشكل كبير على النصوص بلغات غير الإنجليزية، مما يحسن الجودة وسرعة التعرف في 50 لغة مختلفة. في نفس الوقت، أصبحت واجهة برمجة التطبيقات أسرع بمرتين من ذي قبل، ولكن السعر أرخص 50%.

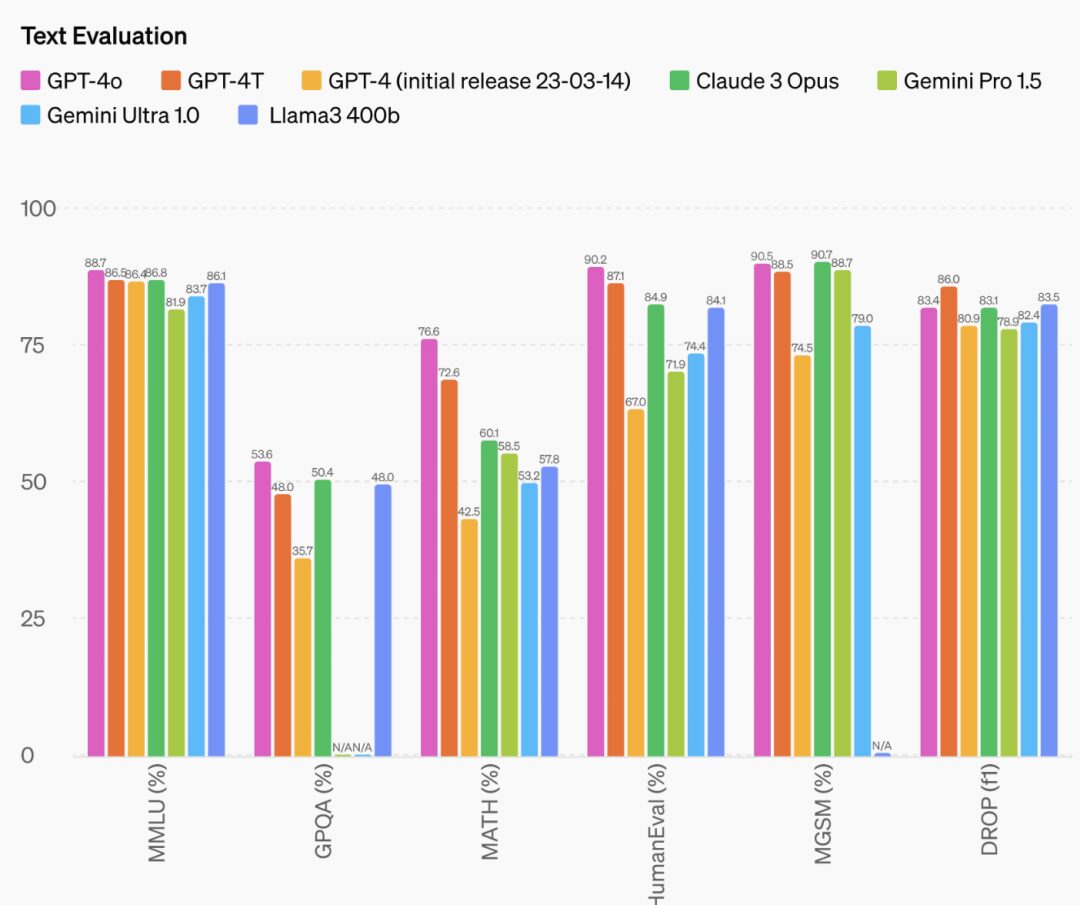

بالإضافة إلى ذلك، تم تحسين قدرة GPT-4o على التفكير بشكل كبير. تظهر البيانات الرسمية أن GPT-4o قد حقق درجة عالية جديدة بلغت 88.7% في اختبار 0-shot COT MMLU (أسئلة الحس السليم).

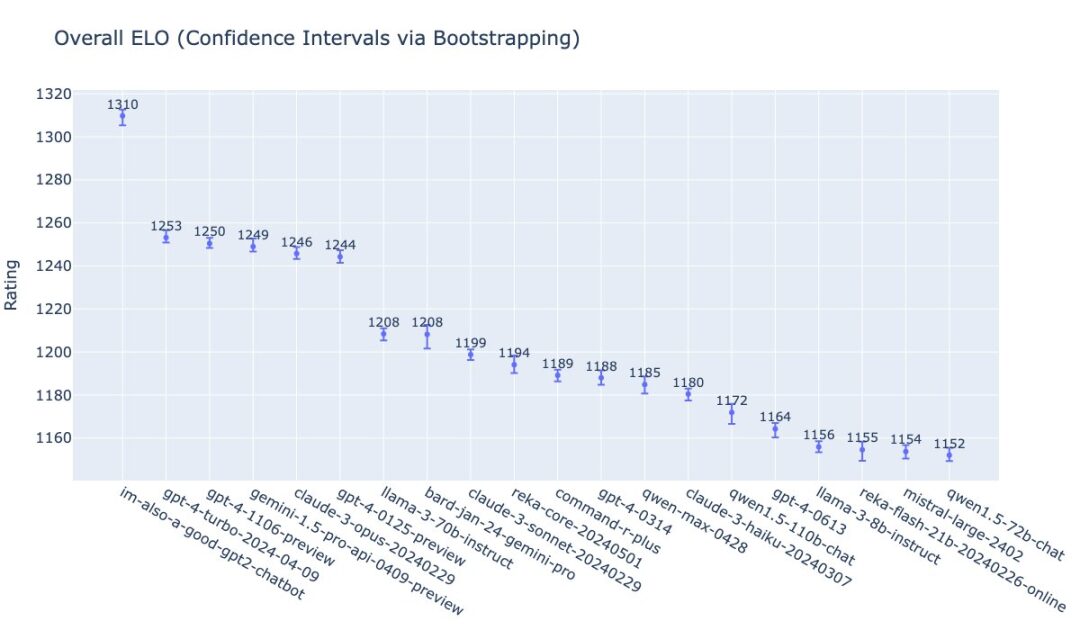

نشر ويليام فيدوس من OpenAI تصنيف GPT-4o على قائمة LMSys. الاسم الذي أطلقه الفريق على GPT-4o مثير للاهتمام أيضًا: im-also-a-good-gpt2-chatbot.

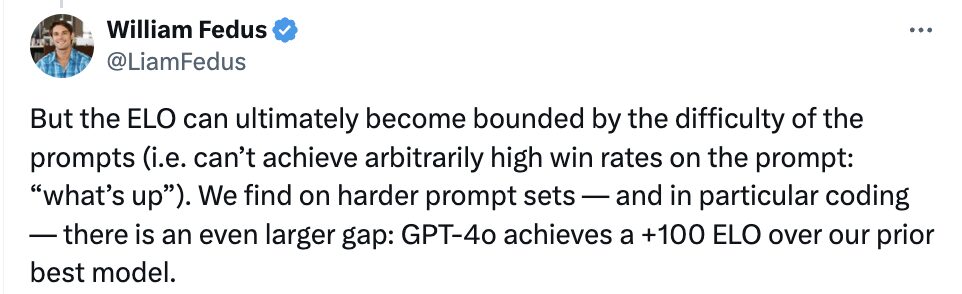

كما قدم أنه في مجموعات المطالبات الأكثر صعوبة، وخاصة في القدرة على الترميز، فإن مستوى GPT-4o أعلى بـ +100 ELO من النموذج الكبير الأكثر تقدمًا السابق من OpenAI.

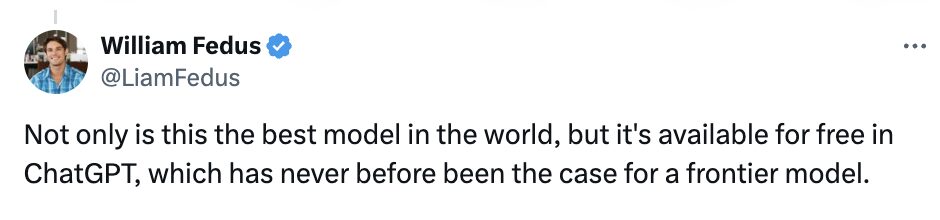

صرح ويليام فيدوس بصراحة أن GPT-4o ليس فقط أفضل نموذج في العالم، بل إنه متوفر مجانًا أيضًا في ChatGPT، مما يشكل سابقة في النماذج المتطورة.

إلى حد ما، يمكن اعتبار GPT-4o بمثابة تحديث OpenAI لمنتجاتها "مفتوحة المصدر". فيما يتعلق بالانتقادات المتكررة لعدم انفتاح OpenAI، قال سام ألتمان أيضًا في مدونته: "إحدى مهام OpenAI هي تزويد الناس بأدوات ذكاء اصطناعي قوية مجانًا (أو بأسعار مخفضة). أنا فخور جدًا بتقديمنا أفضل نموذج في العالم مجانًا في ChatGPT، بدون إعلانات أو أي شيء من هذا القبيل".

أشاد سام ألتمان أيضًا بأداء GPT-4o قائلاً: "يُعد وضع الصوت (والفيديو) الجديد أفضل واجهة حوسبة استخدمتها على الإطلاق. يُشبه الذكاء الاصطناعي في الأفلام؛ ولا تزال أصالته تُفاجئني بعض الشيء. من أهم التغييرات سرعة الاستجابة والقدرة على التعبير التي تصل إلى مستويات البشر."

وفي وقت لاحق، نشر ألتمان صورة "لها" على حسابه، ملمحا إلى أن نموذجه الجديد سوف يفتتح "عصرها".

من الجدير بالذكر أن وظيفة الصوت غير متاحة لجميع العملاء في واجهة برمجة التطبيقات GPT-4o.

وقالت OpenAI إن GPT-4o يأخذ أمان الأوضاع المختلفة في الاعتبار في تصميمه من خلال تقنيات مثل تصفية بيانات التدريب وتحسين سلوك النموذج من خلال التدريب اللاحق. كما أنشأ الفريق أيضًا نظامًا أمنيًا جديدًا لحماية مخرجات الكلام.

ومع ذلك، قالت شركة OpenAI إنها تخطط لطرح ميزات صوتية وفيديو جديدة لـ GPT-4o أولاً "لمجموعة صغيرة من الشركاء الموثوق بهم" في الأسابيع المقبلة، مشيرة إلى خطر إساءة الاستخدام.

ستصبح إمكانيات النص والصور الخاصة بـ GPT-4o متاحة في ChatGPT بدءًا من اليوم. في الأسابيع المقبلة، ستطلق OpenAI إصدارًا جديدًا من نموذج الكلام ألفا مع GPT-4o في ChatGPT Plus. يمكن للمطورين الآن أيضًا الوصول إلى GPT-4o في كل من الوضعين النصي والمرئي في واجهة برمجة التطبيقات.

عصرها هنا: التفاعل الصوتي العاطفي ChatGPT

في وقت مبكر من شهر فبراير من هذا العام، ذكر رئيس علاقات مطوري OpenAI السابق أن الشكل النهائي لـ ChatGPT ليس مجرد الدردشة.

وفي 11 مايو، قال سام ألتمان أيضًا في بودكاست أن OpenAI ستواصل تحسين وتعزيز جودة وظائف الصوت في ChatGPT، وقال إن التفاعل الصوتي هو وسيلة مهمة لأساليب التفاعل المستقبلية.

وفي المؤتمر الصحفي اليوم، أظهرت OpenAI أيضًا نتائجها المؤقتة في تحسين جودة الصوت في ChatGPT - تم تحقيق التفاعل الصوتي استنادًا إلى GPT-4o، وتم تحسين سرعة الاستجابة بشكل كبير.

على وجه التحديد، تنعكس ترقيات وتحديثات ChatGPT بشكل رئيسي في ثلاثة جوانب: التفاعل في الوقت الفعلي، والإدخال والإخراج متعدد الوسائط، وإدراك المشاعر.

من حيث التفاعل في الوقت الحقيقي، في العرض التوضيحي المباشر، يمكن لـ ChatGPT الرد على جميع أسئلة السائل بشكل فوري تقريبًا. إذا قام السائل بمقاطعة إجابة ChatGPT، فيمكنه أيضًا التوقف. كما قام موري موراتي أيضًا بإظهار قدرات الترجمة الفورية لبرنامج GPT-4o بناءً على طلب الجمهور.

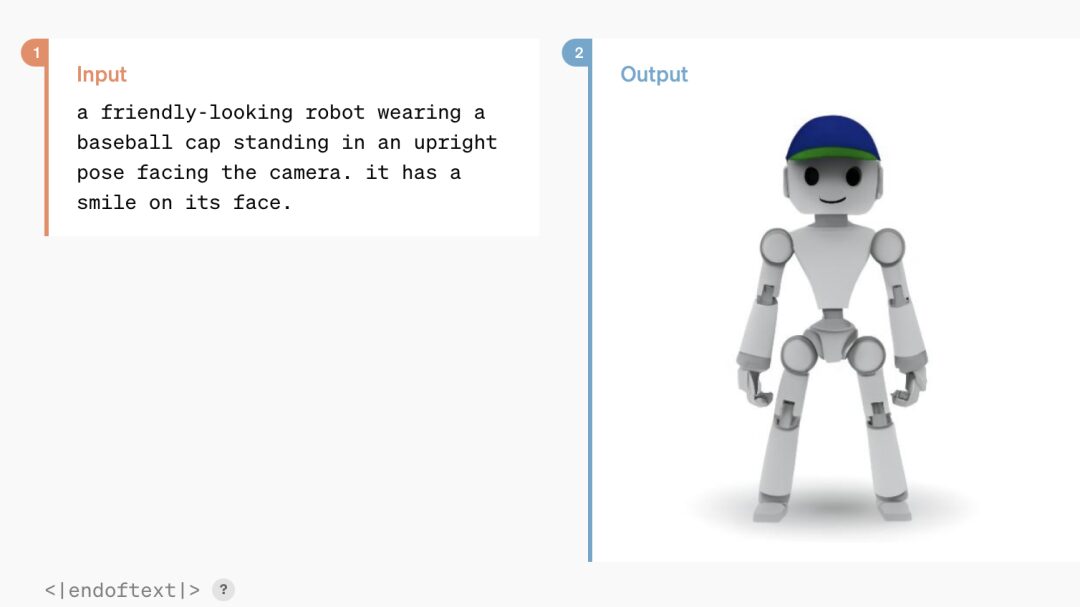

ليست هناك حاجة إلى الخوض في تفاصيل الإدخال/الإخراج متعدد الوسائط. يمكن لبرنامج ChatGPT المستند إلى GPT-4o التعرف على النص والصوت والمعلومات المرئية، والإجابة بأي شكل وفقًا للاحتياجات.

من حيث إدراك المشاعر وردود الفعل العاطفية، يمكن لـ ChatGPT المحدث تحليل مشاعر وجه الشخص بسرعة استنادًا إلى صوره الشخصية. كما يمكنه تعديل نبرة صوته وفقًا لمتطلبات المحاور، من الدراما المبالغ فيها إلى البرودة والميكانيكية، وحتى الغناء، مما يدل على مرونته الممتازة.

وفي هذا الصدد، قال موري موراتي: "نعلم أن هذه النماذج أصبحت أكثر تعقيدًا، لكننا نأمل أن تصبح التجربة التفاعلية أكثر طبيعية وبساطة، بحيث لا يتعين عليك الاهتمام بواجهة المستخدم على الإطلاق، ولكن التركيز فقط على التعاون مع GPT، وهو أمر مهم للغاية".

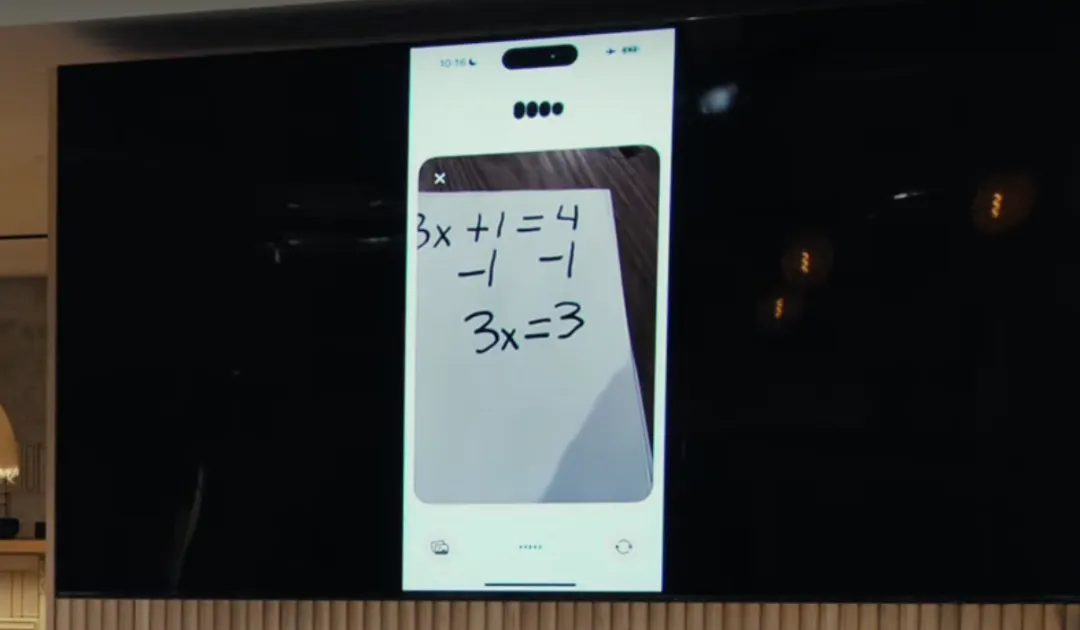

بالإضافة إلى ذلك، من حيث تحليل المنطق، يعمل GPT-4o أيضًا على تحسين القدرات البصرية لـ ChatGPT. بالنظر إلى الصورة التي التقطتها، يمكن لـ ChatGPT تصفح محتوى الصورة بسرعة والإجابة على الأسئلة ذات الصلة، مثل التقاط صورة لحل مسألة رياضية.

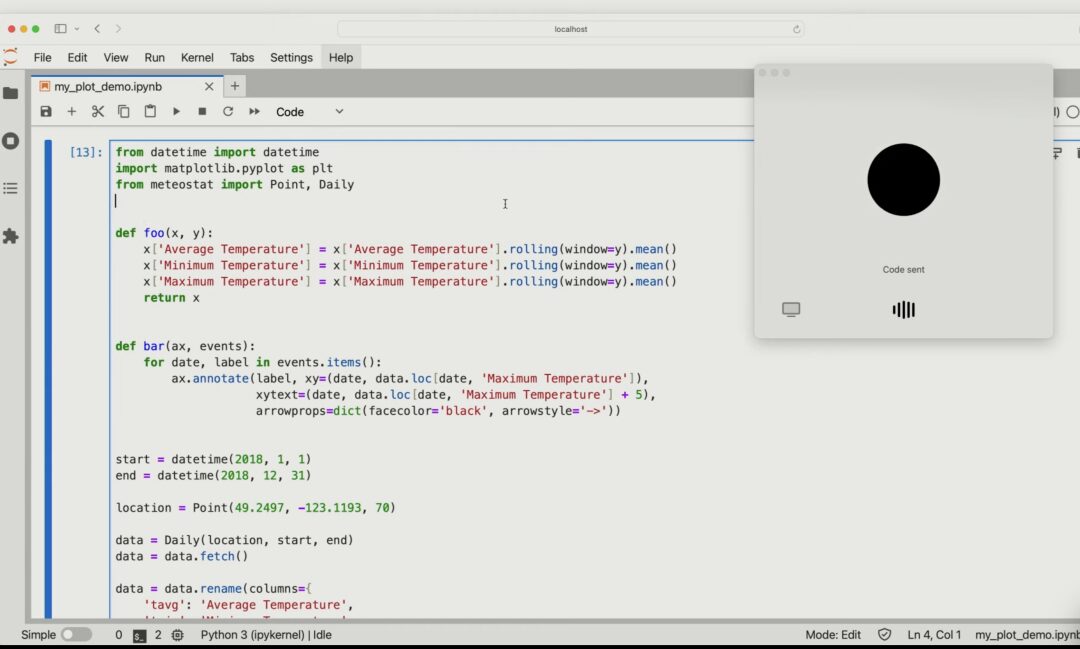

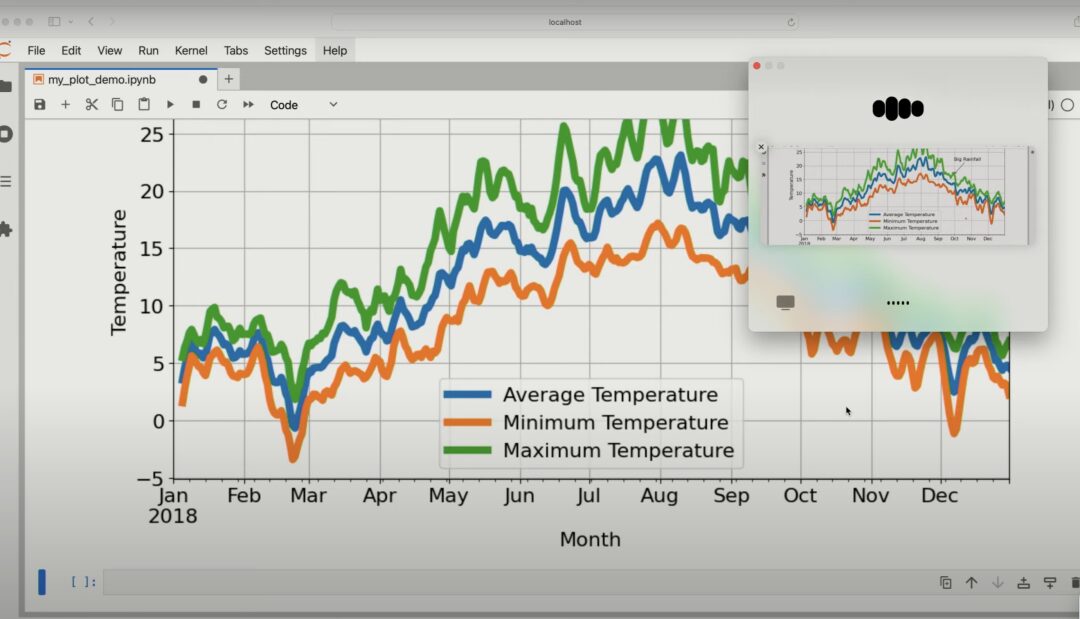

يمكنك أيضًا وصف المحتوى المحدد للكود استنادًا إلى صورة الكود المشتركة، وتحليل التأثير المحدد الذي سيحدث إذا تم تغيير أحد المتغيرات في الكود.

أعطِ GPT-4o مخططًا ويمكنه تحليل محتويات المخطط بالتفصيل.

تعمل هذه المحاولة المبتكرة من OpenAI على توسيع نطاق تطبيق ChatGPT عبر الصوت والنص والرؤية، مما يشير إلى أن التفاعل بين الإنسان والحاسوب قد يكون أكثر طبيعية وسلاسة في المستقبل.

وردًا على ذلك، ذكرت شركة OpenAI أن المساعدين الصوتيين الذين يعتمدون على الذكاء الاصطناعي والذين يتمتعون بالقدرات البصرية والصوتية لديهم نفس الإمكانات التحويلية التي تتمتع بها الهواتف الذكية. من الناحية النظرية، يمكنهم القيام بمجموعة من الأشياء التي لا يستطيع مساعدو الذكاء الاصطناعي الحاليون القيام بها، مثل العمل كمدرس أطروحة أو مدرس رياضيات، أو ترجمة إشارات المرور والمساعدة في حل مشاكل السيارات.

الكلمات الأخيرة

منذ ظهور GPT، تم اعتبار OpenAI بمثابة "المقياس" لعصر النموذج الكبير. العد التنازلي للشركات العملاقة التقليدية في وادي السيليكون:

- تتمتع شركة Microsoft بعلاقة حساسة مع OpenAI. إنها ليست مستثمرًا ماليًا فحسب، بل قامت أيضًا بنشر نموذج GPT في أعمالها الخاصة وتقدم خدمات سحابية لشركة OpenAI.

- بدأت شركة Apple في زيادة استثماراتها في الذكاء الاصطناعي التوليدي هذا العام وأصدرت نموذجها الكبير الخاص، لكنها بدأت متأخرة ولا يزال يتعين علينا أن نرى ما إذا كانت قادرة على هز مكانة OpenAI. وفي الوقت نفسه، هناك تقارير تفيد بأن شركة Apple تتعاون بالفعل مع OpenAI وGoogle في تطوير نماذج كبيرة.

- وباعتبارها أكبر مزود للبنية التحتية السحابية في العالم، أطلقت أمازون أيضًا نموذجها الكبير الخاص بها، Amazon Titan، ولكن هذا جزء فقط من خدمة الاستضافة السحابية Bedrock. على الرغم من أن أمازون استثمرت أيضًا في Anthropic، إلا أنه لا يزال يبدو من الصعب المنافسة مع OpenAI.

وبالمقارنة، يبدو أن شركة جوجل هي الشركة التي لديها أكبر أمل في المنافسة مع OpenAI. فهو لا يحتوي فقط على تراكم تقني عميق (هندسة Transformer تأتي من Google)، ولكنه يحتوي أيضًا على نظام بيئي غني للنماذج الكبيرة لإظهار قوتها.

ومع ذلك، قد يجد القراء الذين يتابعون جوجل أن هذا العملاق القديم لديه القليل من اللياقة البدنية "وانغ فينج" في عصر النماذج الكبيرة (رأس الكلب لإنقاذ الحياة) - من Bard وPaLM 2 اللذان يكونان أقل شأنا من GPT-4 في الأداء، إلى إصدار تحفة Gemini 1.5 التخريبية التي طغى عليها Sora، ومؤتمر Google I / O المقرر عقده في مارس طغى عليه البث المباشر "المرتجل" بواسطة OpenAI خلال أفضل فترة ترويجية...

هذا الصباح فقط (14 مايو)، أطلقت OpenAI "أفضل نموذج في العالم". أتساءل عما إذا كان بيتشاي سوف "يغير السيناريو" بين عشية وضحاها بعد مشاهدة المؤتمر الصحفي اليوم؟

سيتم الكشف عن الجواب غدا صباحا. نحن نتطلع إلى عودة Google وستواصل HyperAI تقديم التقارير المباشرة!