Command Palette

Search for a command to run...

أصدرت جامعة الجيوفيزياء الأمريكية دليلاً لتطبيقات الذكاء الاصطناعي، موضحةً 6 إرشادات رئيسية

تطبيقات الذكاء الاصطناعي المتفجرة: المخاطر والفرص تتعايش

وفي مجالات علوم الفضاء والبيئة، يتم استخدام أدوات الذكاء الاصطناعي بشكل متزايد في تطبيقات مثل التنبؤ بالطقس ومحاكاة المناخ وإدارة موارد الطاقة والمياه وغيرها. ويمكن القول إننا نشهد انفجارًا غير مسبوق في تطبيقات الذكاء الاصطناعي، وعلينا أن نفكر بشكل أكثر دقة في مواجهة الفرص والمخاطر الكامنة فيها.

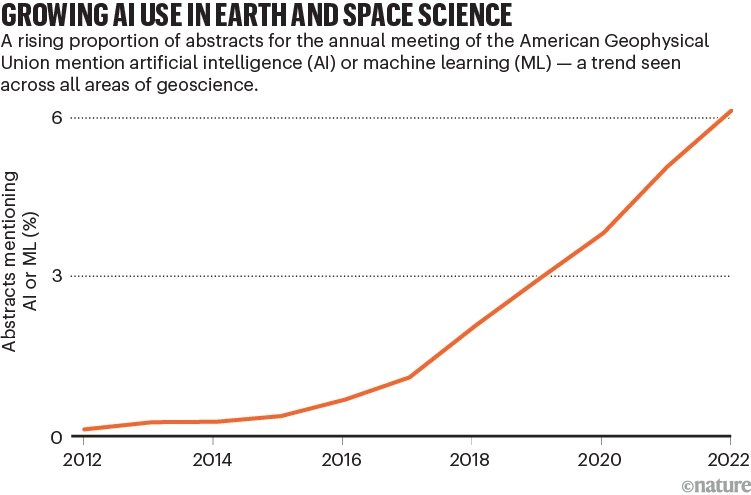

ويكشف تقرير المتابعة الصادر عن الاتحاد الجيوفيزيائي الأمريكي (AGU) عن التطبيق الواسع النطاق لأدوات الذكاء الاصطناعي.من عام 2012 إلى عام 2022، ارتفع عدد الأوراق البحثية التي تذكر الذكاء الاصطناعي في ملخصاتها بشكل كبير، مما يسلط الضوء على تأثيره الهائل في التنبؤ بالطقس، ومحاكاة المناخ، وإدارة الموارد، وأكثر من ذلك.

اتجاهات نشر الأبحاث المتعلقة بالذكاء الاصطناعي

ومع ذلك، في حين أن الذكاء الاصطناعي يطلق طاقة قوية، فإنه يجلب معه أيضًا مخاطر محتملة. ومن بينها، قد تؤدي النماذج غير المدربة بشكل كافٍ أو مجموعات البيانات المصممة بشكل غير صحيح إلى نتائج غير موثوقة أو حتى ضرر محتمل. على سبيل المثال، نظراً لتقارير الأعاصير كمجموعة بيانات إدخال، فقد تكون بيانات التدريب متحيزة تجاه المناطق ذات الكثافة السكانية العالية لأن المزيد من الأحداث الجوية يتم ملاحظتها والإبلاغ عنها هناك. ونتيجة لذلك، قد يبالغ النموذج في تقدير الأعاصير في المناطق الحضرية ويقلل من تقدير الأعاصير في المناطق الريفية، مما يتسبب في أضرار.

وتثير هذه الظاهرة أيضًا أسئلة مهمة: متى وإلى أي مدى يمكن للناس أن يثقوا في الذكاء الاصطناعي ويتجنبوا المخاطر المحتملة؟

بدعم من وكالة ناسا، جمعت AGU خبراء لتطوير مجموعة من المبادئ التوجيهية لتطبيق الذكاء الاصطناعي في علوم الفضاء والبيئة.، مع التركيز على القضايا الأخلاقية والمعنوية التي قد توجد في تطبيقات الذكاء الاصطناعي. ولا يقتصر الأمر على مجال محدد مثل علوم الفضاء والبيئة، بل يوفر أيضًا إرشادات لتطبيقات الذكاء الاصطناعي الشاملة. تم نشر محتوى ذو صلة في مجلة "Nature".

نُشرت الورقة في مجلة Nature

رابط الورقة:

https://www.nature.com/articles/d41586-023-03316-8

اتبع الحساب الرسمي ورد على "الإرشادات" للحصول على ملف PDF الكامل للورقة

ستة إرشادات للمساعدة في بناء الثقة

في الوقت الحالي، لا يزال العديد من الأشخاص على الهامش فيما يتعلق بمدى موثوقية الذكاء الاصطناعي/التعلم الآلي. لمساعدة الباحثين/مؤسسات البحث العلمي على بناء الثقة في الذكاء الاصطناعي، وضعت AGU ستة مبادئ توجيهية:

ومن أجل الحفاظ على المعنى الأصلي، قام المؤلف بربط الترجمة والنص الأصلي معًا.

إرشادات للباحثين

1. الشفافية والتوثيق والتقارير

في أبحاث الذكاء الاصطناعي والتعلم الآلي، تعد الشفافية والتوثيق الشامل أمرًا بالغ الأهمية. لا ينبغي توفير البيانات والرموز فقط، بل يجب أيضًا توفير المشاركين وكيفية حل المشكلة، بما في ذلك التعامل مع عدم اليقين والتحيز. ينبغي أن يؤخذ الشفافية في الاعتبار طوال عملية البحث، من تطوير المفهوم إلى التطبيق.

2. القصدية، وقابلية التفسير، وقابلية التفسير، وقابلية الاستنساخ، وقابلية التكرار

عند إجراء البحوث باستخدام الذكاء الاصطناعي/التعلم الآلي، من المهم التركيز على القصدية، والقدرة على التفسير، وإمكانية التكرار، والقدرة على التكرار. إعطاء الأولوية للأساليب العلمية المفتوحة، وتحسين إمكانية تفسير النماذج وإمكانية إعادة إنتاجها، وتشجيع تطوير أساليب لشرح نماذج الذكاء الاصطناعي.

3. المخاطر والتحيز والآثار

يعد فهم وإدارة المخاطر والتحيزات المحتملة في مجموعات البيانات والخوارزميات أمرًا بالغ الأهمية للبحث. ومن خلال فهم أفضل لمصادر المخاطر والتحيز، والطرق لتحديد هذه القضايا، يمكن إدارة النتائج السلبية والاستجابة لها بشكل أكثر فعالية، مما يؤدي إلى تعظيم المنفعة العامة والفعالية.

4. الأساليب التشاركية

في أبحاث الذكاء الاصطناعي والتعلم الآلي، من المهم جدًا اعتماد نهج شامل في التصميم والتنفيذ. التأكد من أن الأشخاص من مختلف المجتمعات والمجالات المهنية والخلفيات لديهم صوت، وخاصة للمجتمعات التي قد تتأثر بالبحث. إن الإنتاج المشترك للمعرفة والمشاركة في المشاريع والتعاون أمر ضروري لضمان الشمولية في البحث.

إرشادات للمنظمات الأكاديمية (بما في ذلك معاهد الأبحاث والناشرين والجمعيات والمستثمرين)

5. التوعية والتدريب والممارسات القيادية

يتعين على المنظمات الأكاديمية تقديم الدعم للصناعة والتأكد من توفير التدريب على الاستخدام الأخلاقي للذكاء الاصطناعي والتعلم الآلي للباحثين والممارسين والممولين ومجتمع الذكاء الاصطناعي والتعلم الآلي الأوسع. ينبغي للمجتمعات العلمية والمؤسسات والمنظمات الأخرى توفير الموارد والخبرات، ودعم التدريب على أخلاقيات الذكاء الاصطناعي والتعلم الآلي، وتثقيف صناع القرار المجتمعي حول قيمة وقيود الذكاء الاصطناعي والتعلم الآلي في البحث حتى يمكن اتخاذ قرارات مسؤولة للحد من آثاره السلبية.

6. اعتبارات للمنظمات والمؤسسات والناشرين والجمعيات والجهات الممولة

تقع على عاتق المنظمات الأكاديمية مسؤولية أخذ زمام المبادرة في وضع وإدارة السياسات المتعلقة بالقضايا الأخلاقية للذكاء الاصطناعي والتعلم الآلي، بما في ذلك مدونات السلوك والمبادئ وطرق إعداد التقارير وعمليات صنع القرار والتدريب. ويجب عليهم توضيح القيم وتصميم هياكل الحوكمة، بما في ذلك البناء الثقافي، لضمان تنفيذ ممارسات الذكاء الاصطناعي والتعلم الآلي الأخلاقية. وعلاوة على ذلك، فإن إنفاذ هذه المسؤوليات عبر المنظمات والمؤسسات أمر ضروري لضمان تنفيذ الممارسات الأخلاقية في جميع أنحاء المجال.

نصائح أكثر تفصيلاً حول تطبيقات الذكاء الاصطناعي

1. احذر من الفجوات والتحيزات

عندما يتعلق الأمر بنماذج الذكاء الاصطناعي والبيانات، كن حذرًا من الفجوات والتحيزات. يمكن لعوامل مثل جودة البيانات والتغطية والتحيز العنصري أن تؤثر على دقة وموثوقية نتائج النموذج، مما قد يؤدي إلى مخاطر غير متوقعة.

على سبيل المثال، تكون التغطية أو صحة البيانات البيئية في بعض المناطق أفضل بكثير من مناطق أخرى. ستوفر المناطق ذات الغطاء السحابي المتكرر (مثل الغابات المطيرة الاستوائية) أو المناطق ذات التغطية الأقل من أجهزة الاستشعار (مثل القطبين) بيانات أقل تمثيلا.

إن ثراء وجودة مجموعات البيانات غالبًا ما يصب في صالح المناطق الغنية ويتجاهل المجموعات المحرومة، بما في ذلك المجتمعات التي عانت تاريخيًا من التمييز. تُستخدم هذه البيانات في كثير من الأحيان لتقديم التوصيات وخطط العمل للجمهور والشركات وصناع السياسات. على سبيل المثال، في بيانات الصحة، تكون خوارزميات الأمراض الجلدية المدربة على البيانات البيضاء أقل دقة في تشخيص الآفات الجلدية والطفح الجلدي لدى السود.

وينبغي للمؤسسات التركيز على تدريب الباحثين، ومراجعة دقة البيانات والنماذج، وإنشاء لجان مهنية للإشراف على استخدام نماذج الذكاء الاصطناعي.

2. تطوير طرق لشرح كيفية عمل نماذج الذكاء الاصطناعي

عندما يقوم الباحثون بإجراء الأبحاث ونشر الأوراق البحثية باستخدام النماذج الكلاسيكية، يتوقع القراء في كثير من الأحيان منهم توفير إمكانية الوصول إلى الكود الأساسي والمواصفات ذات الصلة. ومع ذلك، لا يُطلب من الباحثين حتى الآن صراحةً تقديم مثل هذه المعلومات، مما يؤدي إلى نقص الشفافية والقدرة على شرح أدوات الذكاء الاصطناعي التي يستخدمونها. وهذا يعني أنه حتى لو تم استخدام نفس الخوارزمية لمعالجة نفس البيانات التجريبية، فإن الطرق التجريبية المختلفة قد لا تكرر النتائج بدقة. لذلك، في الأبحاث المنشورة علنًا، ينبغي للباحثين توثيق كيفية بناء نماذج الذكاء الاصطناعي ونشرها بشكل واضح حتى يتمكن الآخرون من تقييم النتائج.

ويوصي الباحثون بإجراء مقارنات بين النماذج وتقسيم مصادر البيانات إلى مجموعات مقارنة للفحص. وتحتاج الصناعة بشكل عاجل إلى المزيد من المعايير والإرشادات لشرح وتقييم كيفية عمل نماذج الذكاء الاصطناعي بحيث يمكن تقييم النتائج التي تنتجها بمستوى من الثقة الإحصائية يتناسب مع مستوى البيانات المنتجة.

يعمل الباحثون والمطورون حاليًا على تقنية تسمى الذكاء الاصطناعي القابل للتفسير (XAI)، والتي تهدف إلى منح المستخدمين فهمًا أفضل لكيفية عمل نماذج الذكاء الاصطناعي من خلال قياس مخرجاتها أو تصورها. على سبيل المثال، في مجال التنبؤ بالطقس على المدى القصير، تستطيع أدوات الذكاء الاصطناعي تحليل كميات كبيرة من بيانات المراقبة بالاستشعار عن بعد التي يتم الحصول عليها كل بضع دقائق، وبالتالي تحسين القدرة على التنبؤ بالكوارث الجوية الشديدة.

إن التوضيح الواضح لكيفية الوصول إلى النتائج أمر ضروري لتقييم صحة وفائدة التوقعات. على سبيل المثال، عند التنبؤ باحتمالية ومدى الحرائق أو الفيضانات، يمكن أن يساعد هذا التفسير البشر في اتخاذ قرار بشأن ما إذا كان ينبغي تنبيه الجمهور أو استخدام مخرجات نماذج الذكاء الاصطناعي الأخرى. في علوم الأرض، يحاول XAI تحديد أو تصور خصائص بيانات الإدخال لفهم مخرجات النموذج بشكل أفضل. ويحتاج الباحثون إلى دراسة هذه التفسيرات والتأكد من مصداقيتها.

يتم استخدام أدوات الذكاء الاصطناعي لتقييم الملاحظات البيئية

3. بناء الشراكات وتعزيز الشفافية

ويحتاج الباحثون إلى التركيز على الشفافية في كل مرحلة: مشاركة البيانات والرموز، والنظر في إجراء المزيد من الاختبارات لضمان إمكانية التكرار والإعادة، ومعالجة المخاطر والتحيزات في أساليبهم، والإبلاغ عن عدم اليقين. تتطلب هذه الخطوات وصفًا أكثر تفصيلاً للطريقة. ولضمان الشمولية، ينبغي أن تضم فرق البحث خبراء في استخدام أنواع مختلفة من البيانات، فضلاً عن أعضاء المجتمع الذين قد يشاركون في توفير البيانات أو الذين قد يتأثرون بنتائج البحث. على سبيل المثال، يجمع أحد المشاريع القائمة على الذكاء الاصطناعي بين المعرفة التقليدية لشعب ثارو في كندا والبيانات التي تم جمعها من خلال أساليب غير أصلية لتحديد المناطق الأكثر ملاءمة لتربية الأحياء المائية. (انظر go.nature.com/46yqmdr).

صور مشروع الاستزراع المائي

4. دعم مستدام لتنظيم البيانات وإدارتها

يجب أن تتوافق متطلبات إعداد التقارير عن البيانات والرموز والبرامج في مجالات البحث متعددة التخصصات مع مبادئ FAIR: إمكانية العثور عليها، والوصول إليها، والتوافق معها، وإعادة استخدامها. ولبناء الثقة في الذكاء الاصطناعي والتعلم الآلي، يجب أن تكون هناك مجموعات بيانات متاحة للعامة ذات جودة مثبتة، مع نشر الأخطاء والحلول علنًا.

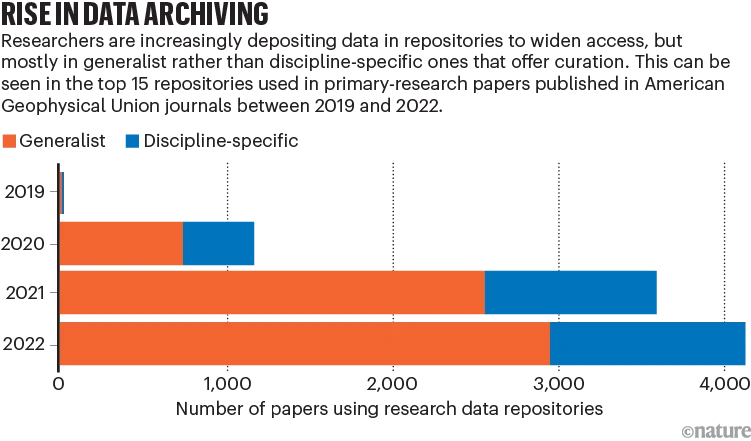

إن التحدي الحالي هو تخزين البيانات، حيث أن الاستخدام الواسع النطاق لمستودعات البيانات المشتركة قد يؤدي إلى مشكلات في البيانات الوصفية، مما يؤثر على تتبع مصدر البيانات والوصول الآلي. توفر بعض مستودعات بيانات الأبحاث التخصصية المتقدمة خدمات فحص الجودة واستكمال المعلومات، ولكن هذا يتطلب عادةً تكاليف القوى العاملة والوقت.

بالإضافة إلى ذلك، تشير المقالة إلى قضايا مثل تمويل المستودعات، والقيود المفروضة على أنواع المستودعات المختلفة، ونقص الطلب على المستودعات الخاصة بالمجال. ينبغي للمنظمات الأكاديمية ووكالات التمويل وغيرها من الجهات توفير استثمار مالي مستدام لدعم وصيانة مستودعات البيانات المناسبة.

يختار الباحثون بشكل متزايد مستودعات البيانات المشتركة

5. انظر إلى التأثير طويل المدى

وبينما ندرس التطبيق الواسع النطاق للذكاء الاصطناعي والتعلم الآلي في العلوم، يتعين علينا أن ننظر إلى التأثير الطويل الأمد وأن نضمن أن هذه التقنيات قادرة على تقليص الفجوات الاجتماعية، وتعزيز الثقة، وإشراك الآراء والأصوات المختلفة بشكل نشط.

ماذا تقول الصين عن استخدام الذكاء الاصطناعي

"كيفية استخدام الذكاء الاصطناعي وكيفية استخدامه بشكل جيد" هو أيضًا موضوع ساخن في مجال الذكاء الاصطناعي في بلدي في السنوات الأخيرة.

في نظر الجلستين لهذا العام، يعد الذكاء الاصطناعي أحد أكثر المجالات نشاطًا في ابتكار التكنولوجيا الرقمية، مع الذكاء الاصطناعي التوليدي (أيه آي جي سيإن النماذج المدربة مسبقًا واسعة النطاق، والذكاء الاصطناعي القائم على المعرفة تطلق فرصًا جديدة في الصناعة، ونحن بحاجة إلى اغتنام "نافذة الوقت" للتطور التكنولوجي.

اقترح لي جون، مؤسس ورئيس مجلس الإدارة والرئيس التنفيذي لمجموعة شاومي، تشجيع ودعم سلسلة صناعة الابتكار العلمي والتكنولوجي، وتعزيز التخطيط وتخطيط صناعة الروبوتات الحيوية؛ تسريع صياغة معايير أمن البيانات لدورة حياة السيارات بأكملها لتوجيه التنمية الصناعية؛ بناء آلية ومنصة لتبادل بيانات السيارات لتعزيز تبادل واستخدام بيانات السيارات.

ويأمل مؤسس شركة 360 تشو هونغ يي في إنشاء مزيج "مايكروسوفت + OpenAI" في الصين، وقيادة الأبحاث حول تكنولوجيا النماذج الكبيرة، وإنشاء نظام بيئي مفتوح للابتكار من أجل التمويل الجماعي مفتوح المصدر.

واقترح الأكاديمي تشانغ بولي إنشاء مشروع خاص كبير لتصنيع الأدوية الحيوية، ودعم البحث والتطوير للتقنيات والمعدات الرئيسية لتصنيع الأدوية الذكية، وتشجيع تطوير المعدات الصيدلانية الحيوية.

ويمكن ملاحظة أن ممثلي وأعضاء الدورتين متفائلون جدًا بشأن مسار الذكاء الاصطناعي. وبالإضافة إلى تمكين التكنولوجيا، نأمل أيضًا أن يتمكن الذكاء الاصطناعي من المساعدة بشكل أفضل في تطوير الشركات والمجتمع في ظل مبادئ بناء الثقة واستخدامها بحذر.

مراجع:

https://www.nature.com/articles/d41586-023-03316-8

https://doi.org/10.22541/essoar.168132856.66485758/v1