Command Palette

Search for a command to run...

تفكيك StyleCLIP: تصميم نصي حسب الطلب، يشبه برنامج Photoshop البشري

الجميع على دراية بـ StyleGAN. تم إصدار هذه الشبكة التنافسية التوليدية الجديدة بواسطة NVIDIA،من خلال استعارة نقل الأسلوب، يمكن إنشاء عدد كبير من الصور الجديدة القائمة على الأسلوب بسرعة.

يتمتع StyleGAN بقدرة تعلم قوية ويقوم بإنشاء صور لا يمكن تمييزها عن الصور الحقيقية.ومع ذلك، فإن هذه الطريقة في التعلم والإبداع الثانوي المبنية على "النظر إلى الصور" أصبحت تقليدية ومحافظة إلى حد ما بعد استخدامها مرات عديدة.

باحثون من الجامعة العبرية وجامعة تل أبيب وشركة أدوبي للأبحاث،يجمع بشكل إبداعي بين القوة التوليدية لمولد StyleGAN المدرب مسبقًا وإمكانيات اللغة المرئية لـ CLIP.تقديم طريقة جديدة لتعديل صور StyleGAN – من خلال النص، كل ما "تكتبه" سيولد الصورة التي تريدها..

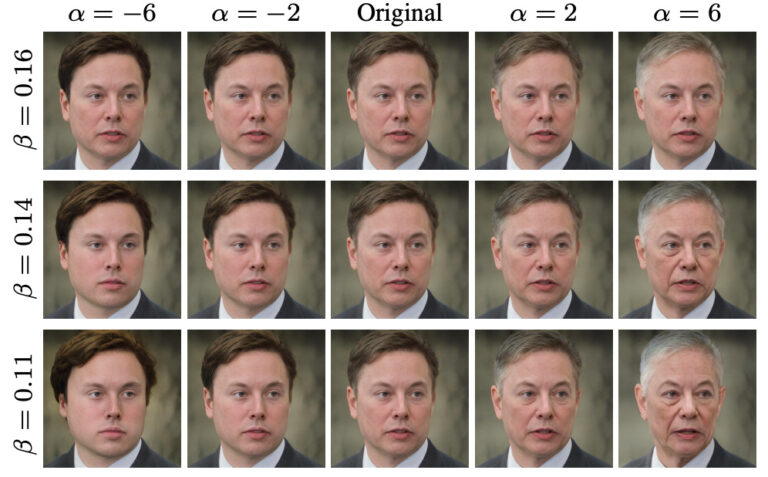

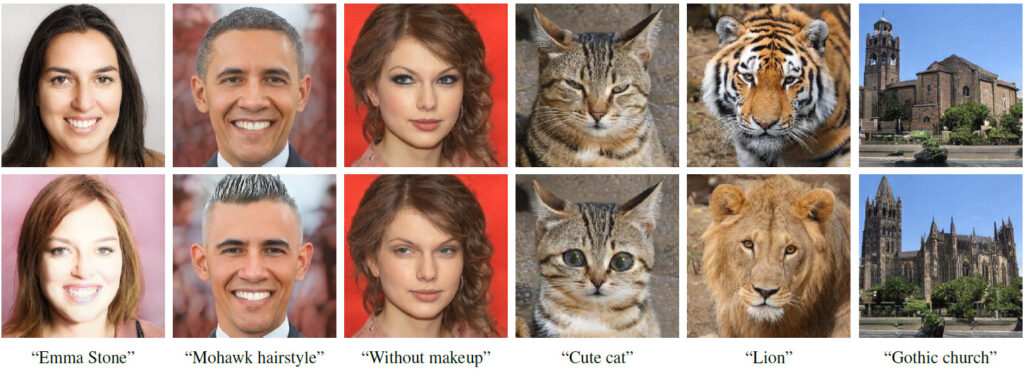

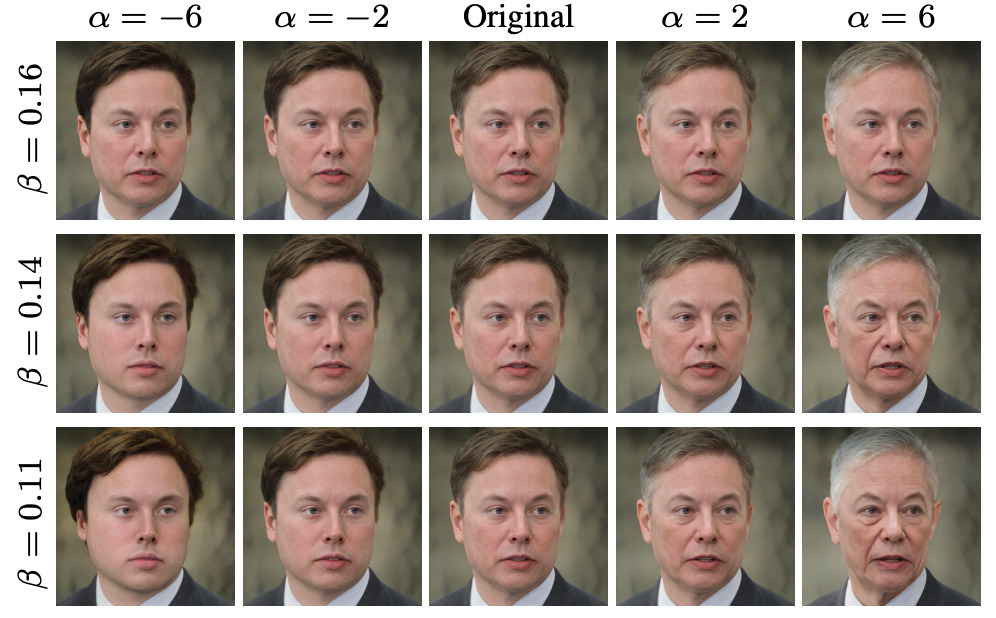

الصف الأول هو صورة الإدخال، والصف الثاني هو نتيجة العملية

النص الموجود أسفل كل عمود من الصور يتوافق مع النص الذي يحرك تغيير الصورة

من هو StyleCLIP؟

StyleCLIP، كما يوحي الاسم، هو عبارة عن مزيج من StyleGAN وCLIP.

يستخدم StyleGAN ميزة Image Inversion لتمثيل الصور ككود كامن، ثم يتحكم في نمط الصورة عن طريق تحرير الكود الكامن وتعديله.

CLIP تعني التدريب المسبق للغة الصورة التباينية. إنها شبكة عصبية تم تدريبها على 400 مليون زوج من الصور والنصوص. يمكنه إخراج الصورة الأكثر صلة استنادًا إلى وصف نصي معين.

في هذه الورقة، درس الباحثون ثلاث طرق لدمج StyleGAN وCLIP:

- تحسين المتجه الكامن الموجه بالنص، حيث يتم استخدام نموذج CLIP كشبكة خسارة.

- قم بتدريب Latent Mapper لجعل المتجه الكامن يتوافق مع النص المحدد واحدًا تلو الآخر.

- في StyleSpace الخاص بـ StyleGAN، يتم تعيين وصف النص إلى الاتجاه العالمي للصورة المدخلة للتحكم في كثافة عمليات الصورة ودرجة الفصل.

أعمال ذات صلة

2.1 الرؤية واللغة

التمثيلات المشتركةهناك العديد من المهام التي يمكن من خلالها تعلم تمثيلات الرؤية واللغة عبر الوسائط (VL)، مثل استرجاع الصور المستندة إلى النص، وترجمة الصور، والإجابة البصرية. مع نجاح BERT في مهام اللغة المختلفة، تستخدم طرق التعلم الافتراضي الحالية عادةً المحولات لتعلم التمثيلات المشتركة.

إنشاء ومعالجة الصور الموجهة بالنص

قم بتدريب شبكة GAN مؤهلة للحصول على تضمينات نصية من مشفر مدرب مسبقًا لتوليد صور موجهة بالنص.

2.2 معالجة صور الفضاء الكامن

لقد ثبت أن المساحة الكامنة الوسيطة لـ StyleGANيمكن تحقيق عدد كبير من عمليات التحليل ومعالجة الصور ذات المغزى،على سبيل المثال، تدريب شبكة لترميز صورة معينة في متجه تضمين للصورة المعالجة، وبالتالي تعلم كيفية إجراء معالجة الصور بطريقة شاملة.

يتم إجراء معالجة الصورة مباشرة على النص المدخل، بإشراف نموذج CLIP المدرب مسبقًا. نظرًا لأن CLIP تم تدريبه على مئات الملايين من أزواج النصوص والصور،لذلك، هذه الطريقة عالمية ويمكن استخدامها في العديد من المجالات دون الحاجة إلى شرح البيانات لحقول محددة أو معالجة محددة.

3. معالجة الصور النصية باستخدام StyleCLIP

يستكشف هذا العمل ثلاث طرق لمعالجة الصور المعتمدة على النص:تجمع كل هذه الأساليب بين القوة التوليدية لـ StyleGAN مع التمثيل الغني للرؤية واللغة المشتركة لـ CLIP.

4. التحسين الكامن

الطريقة البسيطة لاستخدام CLIP لتوجيه معالجة الصور هي من خلال تحسين الكود الكامن المباشر.

5. الخريطة الكامنة

التحسين الكامن هو عالمي.لأنه تم تحسينه خصيصًا لجميع أزواج وصف الصورة المصدر والنص.الجانب السلبي هو أن تحرير صورة واحدة قد يستغرق عدة دقائق من وقت التحسين، والطريقة حساسة إلى حد ما لقيم المعلمات الخاصة بها.

النص الموجه المستخدم هنا هو "مفاجأة"

تكون طبقات StyleGAN المختلفة مسؤولة عن مستويات مختلفة من التفاصيل في الصورة المولدة.

6. الاتجاهات العالمية

ربط الإشارات النصية باتجاه عالمي واحد في Style Space الخاص بـ StyleGAN، والذي ثبت أنهأكثر تميزًا من المساحات الكامنة الأخرى.

مناسب لشدات التشغيل المختلفة وعتبات الفصل

مؤلف الورقة: من الجامعات الإسرائيلية، مع التركيز على GAN

المؤلف الأول للدراسة، أور باتاشنيك، هو طالب دراسات عليا في علوم الكمبيوتر في جامعة تل أبيب.يعمل بشكل رئيسي في المشاريع المتعلقة بتوليد الصور ومعالجتها. إنها مهتمة جدًا بتعلم الآلة، والرسومات الحاسوبية، والرؤية الآلية.يعمل بشكل أساسي في المشاريع المتعلقة بتوليد الصور ومعالجتها، وقد نشر العديد من الأوراق البحثية المتعلقة بـ StyleGAN.

زونغزي وو، مؤلف آخر للورقة البحثية،طالب دكتوراه في مركز إدموند وليلي صفرا لعلوم الدماغ في الجامعة العبرية في القدس.أعمل حاليًا بشكل أساسي في مختبر HUJI Machine Vision، حيث أعمل على مشاريع مع الأستاذين داني ليشينسكي وإيلي شيختمان من معهد أبحاث Adobe.

يركز Zongze Wu على المواضيع المتعلقة برؤية الكمبيوتر.مثل الشبكات التنافسية التوليدية، ومعالجة الصور، وترجمة الصور، وما إلى ذلك.

وفقًا للسيرة الذاتية لـ Zongze Wu،من عام 2011 إلى عام 2016، درس في جامعة تونغجي، وتخصص في المعلوماتية الحيوية.بعد التخرج، التحق زونجزي وو بالجامعة العبرية في القدس للحصول على درجة الدكتوراه في علم الأعصاب الحسابي.

شرح مفصل لثلاث طرق تجمع بين StyleGAN وCLIP

وفقًا للورقة البحثية ذات الصلة بـ StyleCLIP، قام الباحثون بتطوير ثلاث طرق لدمج StyleGAN و CLIP.تعتمد هذه الطرق الثلاث على التحسين الكامن، والمُخطط الكامن، والاتجاه العالمي على التوالي.

1. بناءً على التحسين الكامن

يقدم هذا البرنامج التعليمي بشكل أساسي تحرير الوجه استنادًا إلى التحسين التكراري. يقوم المستخدم بإدخال تعبير نصي ويحصل على صورة وجه محررة تتوافق مع النص.

الخطوة 1: إعداد بيئة الكود

import os

os.chdir(f'./StyleCLIP')

! pip install ftfy regex tqdm

! pip install git+https://github.com/openai/CLIP.gitالخطوة 2 إعداد المعلمات

experiment_type = 'edit' # 可选: ['edit', 'free_generation']

description = 'A person with blue hair' # 编辑的描述,需要是字符串

latent_path = None # 优化的起点 (一般不需修改)

optimization_steps = 100 # 优化的步数

l2_lambda = 0.008 # 优化时候 L2 loss 的权重

create_video = True # 是否将中间过程存储为视频

args = {

"description": description,

"ckpt": "/openbayes/input/input0/stylegan2-ffhq-config-f.pt",

"stylegan_size": 1024,

"lr_rampup": 0.05,

"lr": 0.1,

"step": optimization_steps,

"mode": experiment_type,

"l2_lambda": l2_lambda,

"latent_path": latent_path,

"truncation": 0.7,

"save_intermediate_image_every": 1 if create_video else 20,

"results_dir": "results"

}الخطوة 3: تشغيل النموذج

from optimization.run_optimization import main

from argparse import Namespace

result = main(Namespace(**args))الخطوة 4: تصور الصور قبل وبعد المعالجة

# 可视化图片

from torchvision.utils import make_grid

from torchvision.transforms import ToPILImage

result_image = ToPILImage()(make_grid(result.detach().cpu(), normalize=True, scale_each=True, range=(-1, 1), padding=0))

h, w = result_image.size

result_image.resize((h // 2, w // 2))

الخطوة 5: احفظ عملية التحسين كمخرج فيديو

#@title Create and Download Video

!ffmpeg -y -r 15 -i results/%05d.png -c:v libx264 -vf fps=25 -pix_fmt yuv420p /openbayes/home/out.mp4عنوان الوصول الكامل إلى دفتر الملاحظات

2. استنادًا إلى Latent Mapper

الخطوة الأولى هي إعداد بيئة الكود

الخطوة 2: تعيين المعلمات

الخطوة 3: تشغيل النموذج

الخطوة 4: تصور الصور قبل وبعد المعالجة

انقر للزيارةدفتر ملاحظات كامل

3. بناءً على الاتجاه العالمي

يقدم هذا البرنامج التعليمي كيفية تعيين معلومات النص في المساحة الكامنة في StyleGAN وتعديل محتوى الصورة بشكل أكبر. يمكن للمستخدمين إدخال وصف نصي والحصول على صورة وجه محررة تتطابق بشكل وثيق مع النص وتتمتع بفصل جيد للميزات.

الخطوة 1: إعداد بيئة الكود

الخطوة 2: إعداد StyleCLIP

الخطوة 3. إعداد e4e

الخطوة 4: حدد الصورة واستخدم dlib لمحاذاة الوجه

الخطوة 5: عكس الصورة المراد تحريرها إلى المساحة الكامنة في StyleGAN

الخطوة 6: أدخل وصف النص

الخطوة 7: حدد قوة التلاعب (ألفا) وعتبة الفصل (بيتا) لتحرير الصورة

الخطوة 8: إنشاء مقطع فيديو لتوضيح عملية التحرير

انقر للزيارةدفتر ملاحظات كامل

حول OpenBayes

OpenBayes هي مؤسسة رائدة في مجال أبحاث الذكاء الآلي في الصين.يوفر عددًا من الخدمات الأساسية المتعلقة بتطوير الذكاء الاصطناعي، بما في ذلك حاويات قوة الحوسبة، والنمذجة التلقائية، والتعديل التلقائي للمعلمات.

وفي الوقت نفسه، أطلقت OpenBayes أيضًا العديد من الموارد العامة السائدة مثل مجموعات البيانات والبرامج التعليمية والنماذج.لتمكين المطورين من التعلم بسرعة وإنشاء نماذج التعلم الآلي المثالية.

قم بزيارة الآن openbayes.com وتسجيل،احصل على 600 دقيقة/أسبوعًا من استخدام vGPU و300 دقيقة أسبوعيًا من وقت الحوسبة المجاني لوحدة المعالجة المركزية

اتخذ إجراءً الآن واستخدم StyleCLIP لتصميم الوجه الذي تريده!

انقر للزيارةالبرنامج التعليمي الكامل