Command Palette

Search for a command to run...

كنت أعتقد أن Deepfake سيؤثر على الانتخابات الأمريكية، لكن اتضح أن مستخدمي الإنترنت كانوا قلقين للغاية

قبل الانتخابات الأمريكية عام 2020، كان الناس يشعرون بالقلق من أن الأخبار المزيفة ومقاطع الفيديو المزيفة قد تؤثر على نتائج الانتخابات. والآن، بعد أن ظهرت النتائج الأولية للانتخابات، يبدو أن المخاوف السابقة التي راودت الجميع لم تتحقق.

وأخيرًا، وصلت الانتخابات الأميركية، التي جذبت اهتمامًا عالميًا، إلى نتيجتها المؤقتة في السابع من نوفمبر/تشرين الثاني بالتوقيت المحلي للولايات المتحدة. بعد أربعة أيام من فرز الأصوات المكثف، حصل بايدن على أكثر من 270 صوتًا انتخابيًا، وأعلنت العديد من وسائل الإعلام الأمريكية الرئيسية فوز بايدن.

قبل فترة طويلة من الانتخابات، توقع العديد من الناس أن مقاطع الفيديو المزيفة ستلعب دورًا رئيسيًا في الانتخابات الأمريكية لعام 2020 وتتداخل مع الانتخابات. وتبحث العديد من المنصات الاجتماعية وحتى مجلس النواب الأمريكي عن استراتيجيات للتعامل مع Deepfakes مسبقًا.

الآن بعد انتهاء انتخابات عام 2020، وبالنظر إلى العملية الانتخابية بأكملها، هل كان لتقنية Deepfake تأثير حقيقي على الانتخابات الأمريكية كما كان الجميع قلقين؟

تجمّل نفسك وتشوّه خصمك؟ ترامب يحب Deepfakes

يبدو أن تقنية Deepfake كانت مقدر لها أن تتعرض للإساءة منذ نشأتها، وخاصة في المجال السياسي.

وفقًا لتقرير نشرته شركة Creopoint، وهي شركة استخبارات أعمال أمريكية، في سبتمبر/أيلول، ومع اقتراب موعد الانتخابات الأمريكية،نشر على الإنترنتلقد زاد عدد مقاطع الفيديو المزيفة بمقدار 20 ضعفًا في العام الماضي.

ومن بين الأهداف الرئيسية للفيديوهات المزيفة المشاهير والمديرين التنفيذيين. وقال كريوبوينت:60% من مقاطع الفيديو المزيفة الموجودة على منصتها تستهدف السياسيين.

هذه الفيديوهات المزيفة التي تستهدف السياسة الأمريكية عادة ما تمجد حزبا واحدا وتشوه سمعة حزب آخر. ومن المرجح أيضًا أن يترك هذا النوع من الفيديو انطباعًا عميقًا لدى الناس، كما أنه من السهل انتشاره، وبالتالي قد يؤثر في نهاية المطاف على حكم الناخبين على المرشحين.

ترامب مُمَجَّد

في مايو/أيار من هذا العام، نشر مستخدم تويتر @mad_liberals مقطع فيديو Deepfake. وفي الفيديو، تم تعديل صورة ترامب لتبدو وكأنها مشهد من فيلم الخيال العلمي "يوم الاستقلال". وتحول ترامب في المسرحية إلى الرئيس توماس ويتمور وألقى خطابا قال فيه "يتعين علينا أن نناضل من أجل بقائنا"، وبدا وكأنه بطل. وتم "استبدال" الجمهور أيضًا ليصبح فريق البيت الأبيض الداعم لترامب.

وقد أعاد ترامب تغريد هذا الفيديو المزيف بكل سرور في ذلك الوقت، وتم تشغيل الفيديو أكثر من 10 ملايين مرة في تلك الليلة.

بايدن يتعرض للتشهير

ويبدو أن ترامب حريص أيضًا على إعادة نشر بعض مقاطع الفيديو المزيفة التي تشوه سمعة منافسه بايدن.

في أبريل/نيسان من هذا العام، أعاد ترامب تغريد مقطع فيديو مزيف لبايدن وهو يخرج لسانه على تويتر، مع تسمية توضيحية تقول "جو المهمل" لتدمير صورة بايدن.

ومع ذلك، فإن قيام ترامب بإرسال مثل هذه الفيديوهات أو الصور المزيفة التي تشوه سمعة خصومه لم يكن له دائما تأثير إيجابي عليه. وعلق بعض الناخبين بخيبة أمل: "الرئيس الحقيقي لن يرسل مثل هذا المحتوى الغريب".

في الواقع، أي شخص لديه درجة معينة من الحكمة لن يصدق محتويات الفيديو المزيفة هذه. ولكن من الصعب تجنب أن تظل مجموعة معينة من الناس في حالة من الارتباك والتضليل، وهو ما قد يؤثر في نهاية المطاف على خياراتهم التصويتية في الانتخابات العامة.

نشرت وسائل الإعلام مقطع فيديو مزيفًا عميقًا، وحذرت مستخدمي الإنترنت من عواقب وخيمة

في أبريل 2018، تعاون الممثل الأمريكي جوردان بيل مع شركة BuzzFeed الإعلامية الإخبارية الأمريكية عبر الإنترنت لاستخدام تقنية الذكاء الاصطناعي لإنشاء مقطع فيديو مزيف لخطاب أوباما.

يستخدم الفيديو خطاب بيل كمصدر للفيديو ثم ينقل تحركاته إلى صورة أوباما.

وتبدو تعبيرات وجه أوباما وسلوكه في الفيديو طبيعية للغاية، ولا توجد أي علامات على تغير وجهه. لو لم يكشف المنتج جوردان بيل وموقع BuzzFeed الحقيقة شخصيًا، لكان من المحتمل أن يتم خداع العديد من الأشخاص.

وقال فريق الإنتاج إن الأمر استغرق منهم 60 ساعة فقط في المجموع لصنع الفيديو، باستخدام Adobe After Effects وأداة تغيير الوجه بالذكاء الاصطناعي FakeApp.

قالوا أنهم صنعوا ونشروا هذا الفيديو.الهدف من ذلك هو تذكير الجميع بعدم الثقة في ما يرونه أو يسمعونه على الإنترنت، وخاصة مقاطع الفيديو المزيفة.

وبمساعدة تقنية الذكاء الاصطناعي وبرامج تغيير الوجوه والدبلجة المجانية المختلفة، تم تخفيض عتبة تزوير مقاطع الفيديو، ويخشى بعض الخبراء الفنيين من العواقب المحتملة لهذه التقنيات.

"إذا استخدم أي شخص هذه التكنولوجيا لإنشاء مقاطع فيديو مزيفة واقعية لنشر معلومات كاذبة، أو حتى استخدمتها وسائل الإعلام والفرق الحزبية لتنفيذ دعاية كاذبة، فإن العواقب ستكون كارثية".

وهذا ليس قلقا بلا أساس.

في فبراير/شباط من هذا العام، في انتخابات الجمعية التشريعية لولاية دلهي في الهند، استخدم مانوج تيواري، أحد مرشحي حزب بهاراتيا جاناتا (BJP)، تكنولوجيا الاحتيال بالفيديو "للتحدث" بلغة لا يعرفها من أجل جمع الأصوات من أجل كسب أصوات الناخبين من اللغات الأقلية.

حقق هذا الفيديو نتائج جيدة. لم يتمكن معظم الناس من رؤية أي عيوب فيه، لذلك لم يكن الأمر مشكوكًا فيه في البداية فحسب، بل كان رد الفعل حماسيًا للغاية، مما أدى إلى حصول المرشح على المزيد من الأصوات.

وفي النهاية، لا يزال مستخدمو الإنترنت يشككون في صحة الفيديو. وفي وقت لاحق، أكدت وسيلة الإعلام التكنولوجية Vice أن الفيديو كان بالفعل Deepfake، وتم إنتاجه من قبل حزب الشعب الهندي نفسه وبالتعاون مع شركة علاقات عامة (انظر التفاصيل).الانتخابات البرلمانية الهندية: المرشحون يستخدمون تقنية DeepFake لتزييف مقاطع فيديو باللهجة الهندية لحشد الأصوات).

ولذلك، أعرب جان كلود جولدنشتاين، الرئيس التنفيذي لشركة كريوبوينت، وهي شركة الاستخبارات التجارية الأميركية المذكورة أعلاه، عن مخاوفه العميقة بشأن هذه الانتخابات الأميركية.

قال:"هناك عدد أكبر بكثير من مقاطع الفيديو المزيفة مما يمكنك تخيله، والأمر الأكثر إثارة للخوف هو أن التكنولوجيا والأدوات المستخدمة في صنع هذه المقاطع تتطور بسرعة أكبر من سرعة كشفها." وقال جولدنشتاين أيضًا إن "الانتخابات الرئاسية يجب أن تسمى انتخابات فيديو مزيفة".

كيفية القضاء على عواقب Deepfake: تعزيز الكشف والتشريعات

ولكن لحسن الحظ، لم يتسبب Deepfake في أي مشاكل في الانتخابات الأمريكية هذا العام فحسب، بل إنه لم يلعب حتى دورا مساعدا. وقد حلل بعض المتخصصين أن ذلك قد يعود إلى السببين الرئيسيين التاليين.

المنصات الاجتماعية تستعد ليوم ماطر: ضربات دقيقة

في الأشهر التي سبقت الانتخابات، اتخذت منصات التواصل الاجتماعي الرئيسية خطوات أكثر علنية لمراجعة المحتوى وتحديده وحذف المحتوى الكاذب على الفور مثل مقاطع الفيديو المزيفة.

فيسبوك:

في سبتمبر الماضي، أطلق فيسبوك تحدي اكتشاف التزييف العميقالهدف هو استخدام الأدوات المتطورة للكشف عن مقاطع الفيديو المزيفة التي تنتجها الحكومات ووسائل الإعلام والشركات وما إلى ذلك.

في يناير/كانون الثاني من هذا العام، نشر فيسبوك منشورًا على مدونته يقول فيه إنه سيحذف مقاطع الفيديو المزيفة والمحتوى الذي يحتوي على معلومات مضللة قبل الانتخابات.

تغريد:

في فبراير/شباط من هذا العام، أعلن تويتر عن سياسة جديدة بشأن الوسائط الإعلامية المصطنعة والمُتلاعب بها، قائلاً إنه سيتخذ إجراءات صارمة ضد محتوى الوسائط الذي تم تغييره أو تزويره بشكل كبير، بما في ذلك التحرير أو الاقتصاص أو الدبلجة أو أي صور خيالية لأشخاص حقيقيين. وسوف يضع تويتر علامة تحذيرية على مثل هذا المحتوى.

على سبيل المثال،وفي وقت سابق، نشر أحد المستخدمين المؤيدين لترامب مقطع فيديو استخدم فيه تقنية Deepfake لجعل بايدن يبدو وكأنه مجنون بعض الشيء.قال: "هل تتخيل أن يصبح بايدن رئيسًا للولايات المتحدة؟ لا يستطيع الإجابة على سؤال بسيط، أو حتى الإدلاء بتصريح بسيط؟" وقد تم بعد ذلك وضع علامة تحذيرية عليه من قبل تويتر.

تعمل مؤسسات البحث العلمي بشكل نشط على تحسين خوارزميات الكشف

ولمنع التدخل في الانتخابات من خلال المحتوى المزيف العميق، تعمل مؤسسات بحثية كبرى وشركات تكنولوجيا عملاقة أيضًا على تطوير خوارزميات للمساعدة في مكافحة محتوى المزيف العميق.

جوجل:

في سبتمبر/أيلول الماضي، أصدرت جوجل قاعدة بيانات مفتوحة المصدر تضم 3000 مقطع فيديو تم إنشاؤها بواسطة الذكاء الاصطناعي باستخدام مجموعة متنوعة من الخوارزميات المتاحة للجمهور. أنشأت Google مجموعة البيانات هذه بهدف إنشاء عدد كبير من الأمثلة للمساعدة في تدريب واختبار أدوات الكشف التلقائي عن Deepfake.

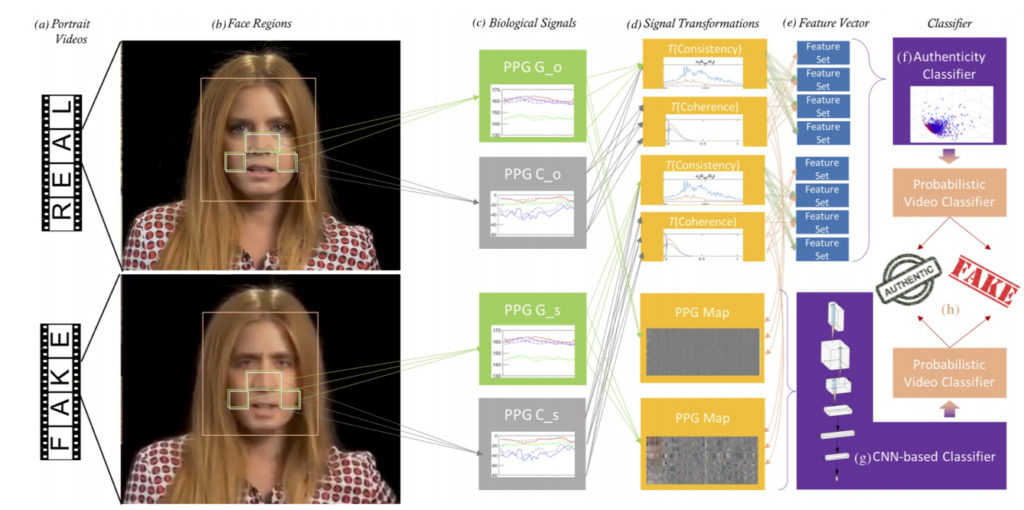

إنتل وجامعة بينجهامبتون:

في سبتمبر/أيلول من هذا العام، قام باحثون من جامعة بينجهامبتون وشركة إنتل بتطوير خوارزميةوتزعم الشركة أنها قادرة على استخدام إشارة ضربات القلب في الفيديو للكشف عما إذا كان الفيديو مزيفًا أم لا، مع معدل دقة يصل إلى 90%.ليس هذا فحسب، بل يمكن للخوارزمية أيضًا اكتشاف نماذج الجيل المحددة وراء مقاطع فيديو Deepfake (مثل Face2Face، وFaceSwap، وما إلى ذلك).

مايكروسوفت:

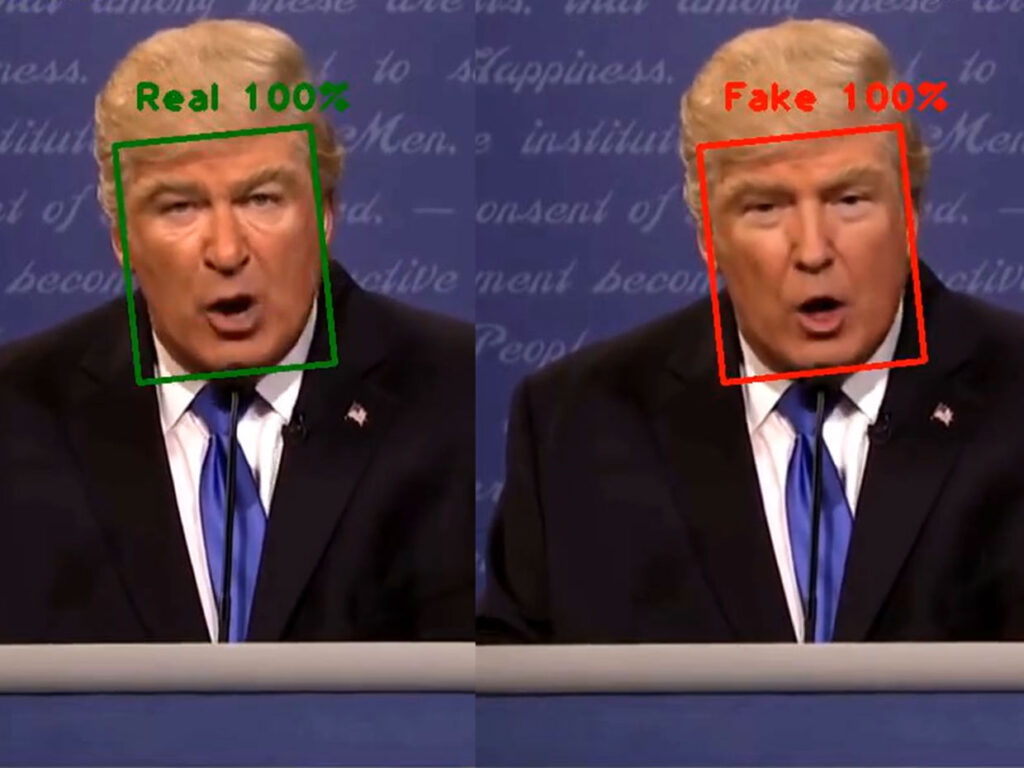

في سبتمبر/أيلول من هذا العام، عشية الانتخابات، أصدرت شركة مايكروسوفت أداة لكشف التزييف العميق تسمى "Video Authenticator"، والتي تشير إلى ما إذا كان الفيديو عبارة عن محتوى Deepfake من خلال عرض درجة الثقة أو "النسبة المئوية" للتلاعب والتعديل.

وبالتالي، ومع تزايد قدرة منصات التواصل الاجتماعي والإعلامية على تحديد المحتوى المزيف، فسوف يتم في نهاية المطاف القضاء على مثل هذه الفيديوهات في مهدها.

وفي الوقت نفسه، يتم سد الثغرات القانونية السابقة تدريجيا، كما أن محاسبة أولئك الذين يقومون بتزوير مقاطع الفيديو على العواقب السلبية سوف يجعل كل شيء واضحا.

على سبيل المثال، ينص القانون المدني في بلدي، الذي تم التصويت عليه وإقراره في مايو/أيار من هذا العام، بوضوح على أن استخدام التكنولوجيا للتلاعب بالفيديوهات يعد انتهاكاً للحق في التصوير، وهو مكتوب بوضوح في المادة 1019 من القانون (انظر"تغيير الوجوه باستخدام الذكاء الاصطناعي، والتلاعب بالأصوات، وما إلى ذلك، مُدرجة بوضوح في النسخة الجديدة من القانون المدني").

المادة 1019 [السلطة السلبية لحقوق الصورة] لا يجوز لأي منظمة أو فرد أن يسيء إلى صورة أو يشوّهها أو يسيء إليها. أو استخدام تكنولوجيا المعلومات لتزوير أو انتهاك حقوق صور الآخرين.لا يجوز لأحد إنتاج أو استخدام أو الكشف عن صورة حامل الحق في الصورة دون موافقة حامل الحق في الصورة، باستثناء ما ينص عليه القانون خلافًا لذلك.

في ظل الرقابة المزدوجة للتكنولوجيا والقانون، قد يدفع منتجو وموزعو مقاطع الفيديو المزيفة ثمنًا أعلى لأفعالهم. إذا أرادوا الانخراط في السياسة، فقد لا يكون الأمر سهلاً.

في هذه المرحلة تمت الإجابة على الأسئلة التي طرحناها في بداية مقالتنا. ولم تتسبب تقنية Deepfake في إحداث أي ضجة في الانتخابات الأمريكية هذا العام، ناهيك عن التدخل في الانتخابات، لذا فإن المخاوف السابقة التي أبداها مستخدمو الإنترنت كانت مبالغ فيها بحتة. ومع ذلك، في المستقبل، لا ينبغي التراخي في الرقابة ذات الصلة، ويجب علينا دائمًا منع التكنولوجيا من فعل الشر.

-- زيادة--