بقلم سوبر نيرو

العنوان مثير للقلق بعض الشيء. لقد كتبنا أيضًا عن شائعات تورينج قبل بضعة أيام. ليس هناك شك في أنه يعتبر "أبو الذكاء الاصطناعي" من قبل الصناعة.

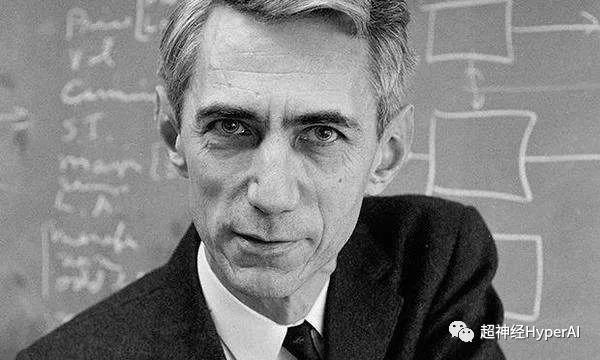

إن الشيخ الذي أكتب عنه اليوم هو أيضًا شخصية رائعة - شانون، الذي يطلق عليه المجتمع الأكاديمي بكل احترام لقب "أبو علم المعلومات". كما نعلم جميعًا، قدمت نظرية المعلومات مساهمات كبيرة لصناعة الذكاء الاصطناعي، لذلك نطلق على شانون لقب "عم الذكاء الاصطناعي".

كان شانون وسيمًا وواثقًا بنفسه عندما كان صغيرًا، وكان أيضًا قريبًا بعيدًا للمخترع إديسون

في 30 أبريل 1916، ولد كلود شانون في بلدة صغيرة تسمى جايلورد، ميشيغان، الولايات المتحدة الأمريكية. في هذا الوقت، كان تورينج بعيدًا في إنجلترا وكان قد كبر حتى أصبح عمره أربع سنوات. حصل شانون على درجة البكالوريوس في الرياضيات والهندسة الكهربائية من جامعة ميشيغان في عام 1936. وفي عام 1940، حصل على درجة الماجستير والدكتوراه في الرياضيات من معهد ماساتشوستس للتكنولوجيا وانضم إلى مختبرات بيل في عام 1941.

بالمقارنة مع تورينج، كانت حياة شانون أكثر سلاسة. توفي في 26 فبراير 2001 عن عمر يناهز 84 عامًا.

دعم عمي الكبير للذكاء الاصطناعي

إن نظرية المعلومات التي أسسها شانون ليست فقط حجر الأساس لعلم المعلومات والاتصالات، بل تظل أيضًا الأكثر أهميةإنه أساس نظري مهم للتعلم العميق.

تجمع نظرية المعلومات بين حساب التفاضل والتكامل ونظرية الاحتمالات والإحصاء وغيرها من التخصصات، وتلعب دورًا مهمًا للغاية في التعلم العميق:

-

وظائف فقدان الإنتروبيا المتقاطعة الشائعة؛

-

إنشاء شجرة قرار بناءً على الحد الأقصى من اكتساب المعلومات؛

-

تُستخدم خوارزمية فيتربي على نطاق واسع في معالجة اللغة الطبيعية والكلام؛

-

تُستخدم الشبكات العصبية المتكررة بشكل شائع في الترجمة الآلية، كما تُستخدم أجهزة التشفير وفك التشفير بشكل شائع في أنواع مختلفة من النماذج؛

نبذة تاريخية عن تطور نظرية المعلومات

دعونا نبدأ بمثال بسيط. الجملتان التاليتان تحتويان على كميات مختلفة من المعلومات.

"برونو كلب."

"برونو هو كلب بني كبير."

ومن الواضح أن الجملتين تنقلان كميات مختلفة من المعلومات. بالمقارنة مع الجملة الأولى، تحتوي الجملة الثانية على مزيد من المعلومات. إنه لا يخبرنا فقط أن برونو كلب، بل يخبرنا أيضًا بلون معطف الكلب وشكل جسمه.

لكن هاتين الجملتين البسيطتين كانتا أكبر مصدر إزعاج للعلماء والمهندسين في أوائل القرن العشرين.

أرادوا تحديد الاختلافات بين هذه المعلومات ووصفها رياضيا.

ولسوء الحظ، لم تكن هناك طريقة تحليلية أو رياضية متاحة بسهولة للقيام بذلك في ذلك الوقت.

ومنذ ذلك الحين، يبحث العلماء عن إجابة لهذا السؤال، على أمل العثور على الإجابة من جوانب مثل دلالات البيانات. ولكن اتضح أن مثل هذا البحث لا يخدم أي غرض آخر سوى تعقيد المشكلة.

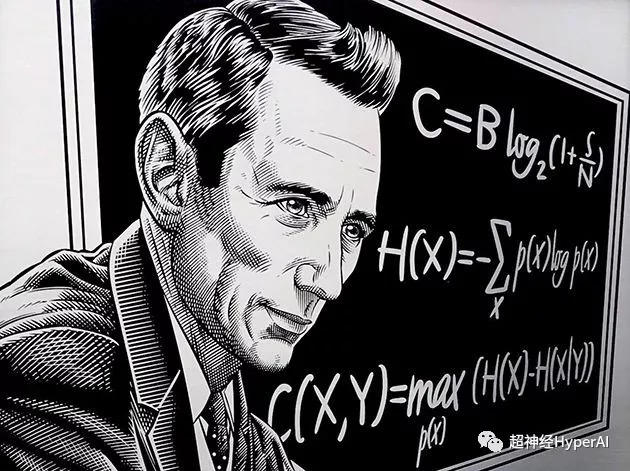

لم يكن الأمر كذلك حتى قدم شانون، عالم الرياضيات والمهندس، "إنتروبيا"بعد المفهوم. لقد تم أخيرا حل مشكلة القياس الكمي للمعلومات، الأمر الذي يمثل أيضا بداية دخولنا إلى "عصر المعلومات الرقمية".

لم يركز شانون على دلالات البيانات، بل على توزيع الاحتمالات و "ريبة"لتحديد كمية المعلومات وتقديمها "قليل"مفهوم قياس المعلومات.

ويعتقد أن دلالات البيانات ليست مهمة عندما يتعلق الأمر بمحتوى المعلومات.

لم تضع هذه الفكرة الثورية الأساس لنظرية المعلومات فحسب، بل فتحت أيضًا مسارات جديدة لتطوير مجالات مثل الذكاء الاصطناعي. ولذلك، يُعترف أيضًا بكلاود شانون باعتباره أبا عصر المعلومات.

العناصر المشتركة في التعلم العميق: الإنتروبيا

نظرية المعلومات لها العديد من السيناريوهات التطبيقية. وهنا نلقي نظرة أساسية على تطبيقاتها الأربعة الأكثر شيوعًا في مجالات التعلم العميق وعلوم البيانات.

إنتروبيا

وتعرف أيضًا باسم إنتروبيا المعلومات أو إنتروبيا شانون، وتستخدم لقياس النتائج غير المؤكدة. ويمكننا فهم ذلك من خلال التجربتين التاليتين:

-

قم برمي قطعة نقدية عادلة، بحيث يكون احتمال النتيجة 0.5؛

-

قم برمي قطعة نقدية متحيزة بحيث يكون احتمال النتيجة 0.99؛

من الواضح أنه من الأسهل التنبؤ بنتائج التجربة 2 مقارنة بالتجربة 1. وبالتالي، وبناءً على النتائج، فإن التجربة 1 أكثر عدم يقين من التجربة 2، ويتم استخدام الإنتروبيا خصيصًا لقياس هذا عدم اليقين.

إذا كانت النتائج التجريبية تحتوي على قدر أكبر من عدم اليقين، فإن إنتروبياها تكون أعلى، والعكس صحيح.

في تجربة حتمية حيث تكون النتيجة مؤكدة تمامًا، تكون الإنتروبيا صفرًا. في تجربة عشوائية تمامًا، مثل تجربة نرد عادل، هناك قدر كبير من عدم اليقين حول كل نتيجة، لذا فإن الإنتروبيا ستكون كبيرة جدًا.

هناك طريقة أخرى لتحديد الإنتروبيا وهي تعريف الإنتروبيا كدالة للمعلومات المتوسطة التي تم الحصول عليها عند ملاحظة نتائج تجربة عشوائية. كلما قل عدد النتائج، كلما قلت المعلومات المرصودة وانخفضت الإنتروبيا.

على سبيل المثال، في تجربة حتمية، نعلم دائمًا النتيجة، وبالتالي لا يتم الحصول على أي معلومات جديدة من ملاحظة النتيجة، وبالتالي فإن الإنتروبيا تساوي صفرًا.

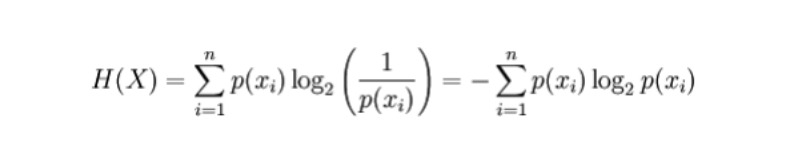

الصيغة الرياضية

بالنسبة للمتغير العشوائي المنفصل X، يتم تسجيل النتائج المحتملة على أنها x_1، ...، x_n، ثم تكون صيغة حساب الإنتروبيا على النحو التالي (يتم تمثيل الإنتروبيا بواسطة H، بت الوحدة):

حيث p(x_i) هو احتمال النتيجة التي ينتجها المتغير X.

طلب

-

إنشاء شجرة قرار تلقائية. أثناء عملية البناء، يمكن إجراء جميع اختيارات الميزات باستخدام معيار الإنتروبيا.

-

كلما زادت الإنتروبيا، كلما زادت المعلومات المتاحة، وكلما زادت قيمتها التنبؤية. وبناءً على ذلك، يمكننا أن نجد النموذج الأكثر قيمة، أي النموذج الذي يتمتع بأعلى إنتروبيا، من النموذجين المتنافسين.

العناصر المشتركة والمهمة في التعلم العميق: الانتروبيا المتقاطعة

الانتروبيا المتقاطعة

تعريف:يتم استخدام الإنتروبيا المتقاطعة بشكل أساسي لقياس الفرق في المعلومات بين توزيعين احتماليين. ويمكنه أن يخبرنا بمدى تشابه الاحتمالين.

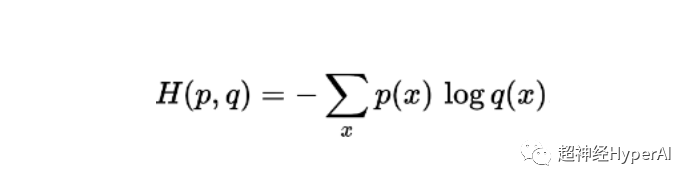

الصيغة الرياضية

صيغة حساب الإنتروبيا المتقاطعة لاحتمالين p وq محددين في نفس العينة هي (يتم تمثيل الإنتروبيا بواسطة H، بت الوحدة):

طلب

-

تُستخدم دالة فقدان الإنتروبيا المتقاطعة على نطاق واسع في نماذج التصنيف مثل الانحدار اللوجستي. عندما ينحرف التنبؤ عن الناتج الحقيقي، تزداد دالة فقدان الإنتروبيا المتقاطعة.

-

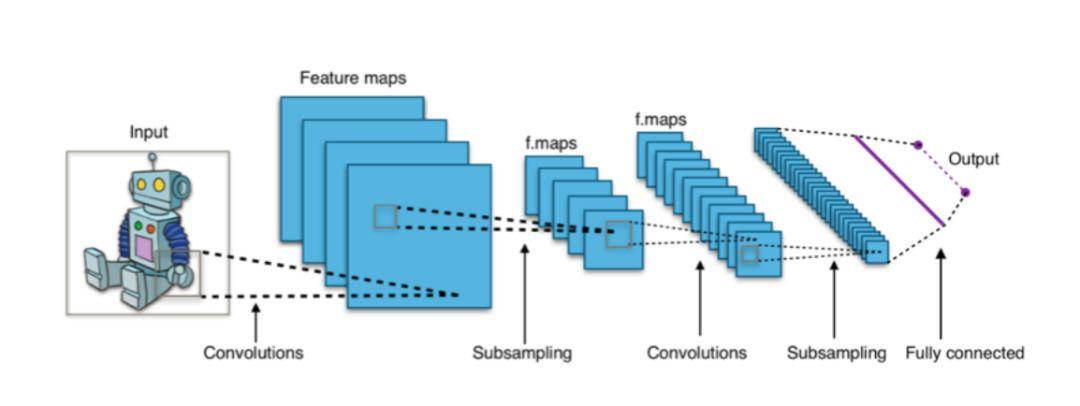

في هياكل التعلم العميق مثل شبكات CNN، غالبًا ما تستخدم طبقة "softmax" الناتجة النهائية دالة خسارة عبر الإنتروبيا.

الشكل 1: تستخدم المصنفات المستندة إلى CNN عادةً طبقة softmax كطبقة نهائية وتستخدم دالة فقدان الإنتروبيا المتقاطعة للتدريب.

العناصر المشتركة والمهمة في التعلم العميق: المعلومات المتبادلة

المعلومات المتبادلة

التعريف: يتم استخدام المعلومات المتبادلة لقياس درجة الاعتماد المتبادل بين توزيعين احتماليين أو متغيرين عشوائيين. ببساطة، يتعلق الأمر بمدى كمية المعلومات التي يحملها متغير واحد معه.

إن الارتباط بين المتغيرات العشوائية التي يتم التقاطها من خلال المعلومات المتبادلة يختلف عن الارتباط العام الذي يقتصر على المجال الخطي. ويمكنه أيضًا التقاط بعض المعلومات غير الخطية ذات الصلة وله نطاق أوسع من التطبيقات.

الصيغة الرياضية

صيغة المعلومات المتبادلة لمتغيرين عشوائيين منفصلين X و Y هي:

حيث p(x,y) هو توزيع الاحتمال المشترك لـ x و y، و p(x) و p(y) هما توزيع الاحتمال الهامشي لـ x و y، على التوالي.

طلب

- اختيار الميزة: لا يمكن للمعلومات المتبادلة التقاط الارتباط الخطي فحسب، بل يمكنها أيضًا الانتباه إلى الارتباط غير الخطي، مما يجعل اختيار الميزة أكثر شمولاً ودقة.

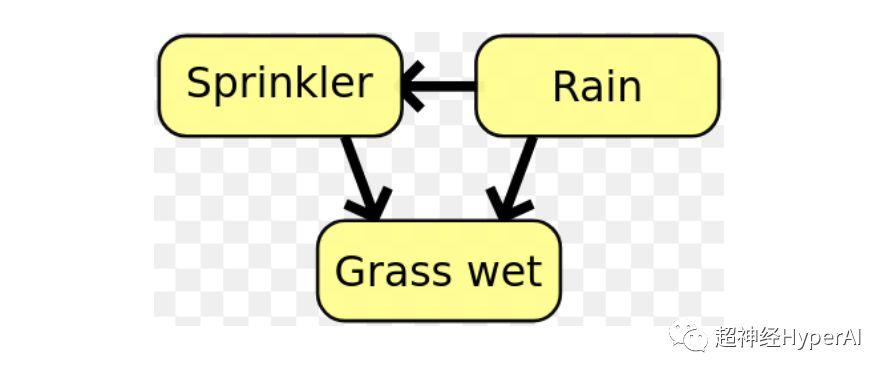

- في الشبكات البايزية، يتم استخدام المعلومات المتبادلة لتعلم بنية العلاقة بين المتغيرات العشوائية وتحديد قوة هذه العلاقات..

الشكل 1: في الشبكة البايزية، يمكن تحديد بنية العلاقة بين المتغيرات باستخدام المعلومات المتبادلة.

العناصر المشتركة والمهمة في التعلم العميق: تباعد KL

تباعد KL (تباعد كولباك-ليبلر)

يتم استخدام تباعد KL، المعروف أيضًا باسم الإنتروبيا النسبية، لقياس درجة الانحراف بين توزيعين احتماليين.

لنفترض أن البيانات التي نحتاجها موجودة في التوزيع الحقيقي P، ولكننا لا نعرف هذا P. في هذه الحالة، يمكننا إنشاء توزيع احتمالي جديد Q ليناسب التوزيع الحقيقي P.

نظرًا لأن البيانات في Q تقريبية فقط لـ P، فإن Q ليست دقيقة مثل P. وبالتالي، بالنسبة لـ P، سيتم فقد بعض المعلومات في Q، ويتم قياس كمية هذه المعلومات المفقودة من خلال تباعد KL.

يخبرنا تباعد KL عن مقدار المعلومات التي نفقدها عندما نقرر استخدام Q (تقريب لـ P). كلما اقترب تباعد KL من الصفر، اقتربت البيانات في Q من P.

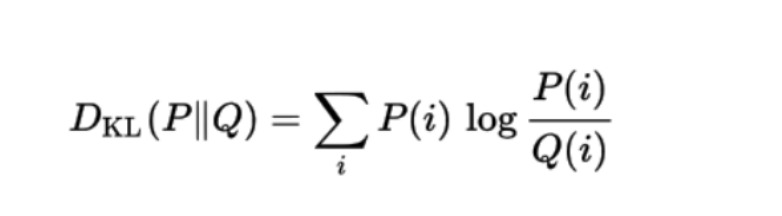

الصيغة الرياضية

الصيغة الرياضية لتباعد KL لتوزيع الاحتمالات Q مع توزيع الاحتمالات الآخر P هي:

طلب

يتم استخدام تباعد KL حاليًا في VAE (Variational Autoencoder) في أنظمة التعلم الآلي غير الخاضعة للإشراف.

في عام 1948، اقترح كلود شانون رسميًا "نظرية المعلومات" في ورقته البحثية الرائدة "نظرية رياضية للاتصال"، مما أدى إلى بداية عصر جديد. اليوم، تم استخدام نظرية المعلومات على نطاق واسع في العديد من المجالات مثل التعلم الآلي، والتعلم العميق، وعلوم البيانات.

جائزة شانون الأولى

كما نعلم جميعًا، فإن أعلى جائزة شرفية في صناعة الكمبيوتر هي جائزة تورينج. تأسست جائزة تورينج في عام 1966 من قبل جمعية آلات الحوسبة لإحياء ذكرى مساهمات تورينج المتميزة. وعلى نحو مماثل، تتمتع جائزة شانون بنفس القدر من الأهمية في مجال المعلومات.

الفرق هو أن تورينج توفي في عام 1954 ولم تكن لديه الفرصة لمعرفة أن العالم قد خصص له هذه الجائزة.

وكان شانون أكثر حظا بكثير. تم منح جائزة شانون من قبل تأسست جمعية IEEE في عام 1972 لتكريم العلماء والمهندسين الذين قدموا مساهمات بارزة في مجال نظرية المعلومات. وفي الجلسة الأولى، حصل شانون نفسه على جائزة شانون.

"فازت شانون بجائزة شانون، ويطلق عليها التاريخ اسم روتين شانون"