Command Palette

Search for a command to run...

مجموعة بيانات تقييم المعايير المتعددة الوسائط MMEvalPro

التاريخ

الحجم

عنوان URL للنشر

رابط الورقة البحثية

الوسوم

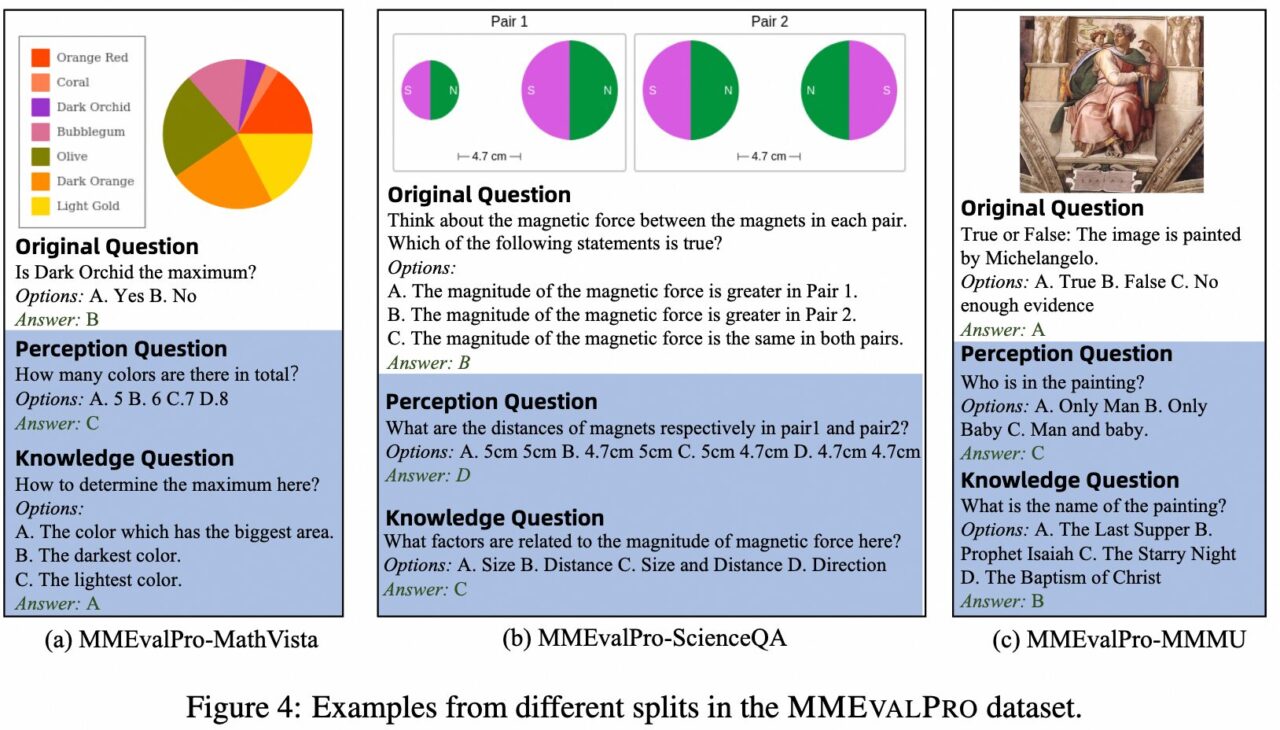

MMEvalPro هو معيار تقييم نموذج كبير متعدد الوسائط (LMMs) تم اقتراحه في عام 2024 من قبل فريق بحثي من جامعة بكين والأكاديمية الصينية للعلوم الطبية والجامعة الصينية في هونج كونج وعلي بابا. ويهدف إلى توفير طريقة تقييم أكثر موثوقية وكفاءة وحل المشاكل الموجودة في معايير التقييم المتعدد الوسائط الحالية. تحتوي المعايير المرجعية الحالية على تحيزات منهجية في تقييم نماذج اللغة الكبيرة (LMMs)، وحتى نماذج اللغة الكبيرة (LLMs) التي لا تتمتع بالوعي البصري يمكن أن تحقق أداءً غير تافه على هذه المعايير المرجعية، مما يقوض مصداقية هذه التقييمات. يعمل MMEvalPro على تحسين طرق التقييم الحالية من خلال إضافة سؤالين "رئيسيين" (سؤال إدراكي وسؤال معرفي)، مما يشكل "ثلاثية أسئلة" تختبر جوانب مختلفة من الفهم المتعدد الوسائط للنموذج.

المقياس التقييمي الرئيسي لـ MEvalPro هو "الدقة الحقيقية"، والذي يتطلب من النموذج الإجابة بشكل صحيح على جميع الأسئلة في ثلاثية للحصول على درجة. تتضمن العملية مراحل متعددة من المراجعة والتحقق من الجودة للتأكد من أن الأسئلة واضحة وذات صلة وتشكل تحديًا. يحتوي المعيار النهائي على 2138 ثلاثية سؤال، بإجمالي 6414 سؤالاً مختلفًا تغطي مواضيع ومستويات صعوبة مختلفة.

بناء الذكاء الاصطناعي بالذكاء الاصطناعي

من الفكرة إلى الإطلاق — سرّع تطوير الذكاء الاصطناعي الخاص بك مع المساعدة البرمجية المجانية بالذكاء الاصطناعي، وبيئة جاهزة للاستخدام، وأفضل أسعار لوحدات معالجة الرسومات.