Command Palette

Search for a command to run...

スケールネット

ScaleNetは、北京理工大学、ファーウェイ・ノアズ・アーク・ラボ、香港城市大学などの研究チームによって2025年10月に共同で提案され、関連する研究成果は論文として発表されました。 ScaleNet: 増分パラメータによる事前学習済みニューラルネットワークのスケールアップ 。

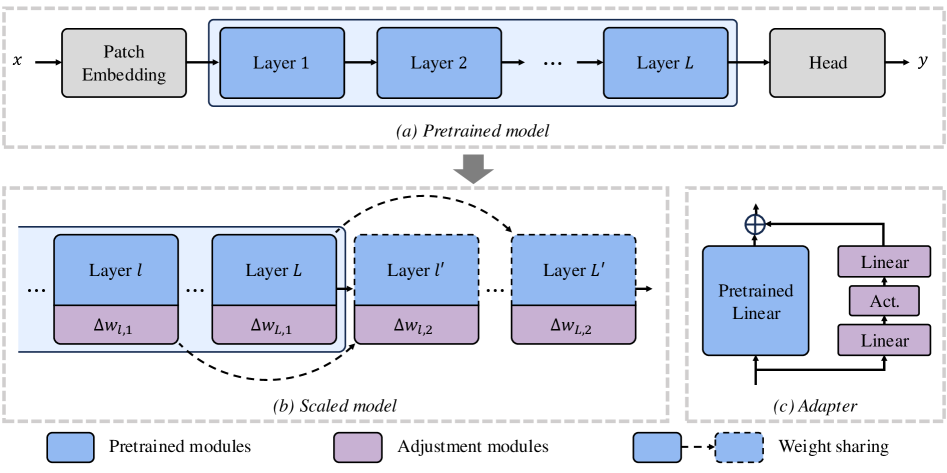

ScaleNetは、ViTモデルのスケーリングに効果的な手法です。従来のゼロからのトレーニングとは異なり、このパラダイムは、パラメータの増加を最小限に抑えながら、既存の事前トレーニング済みモデルを迅速にスケーリングできるため、ViTのスケーリングに費用対効果の高いソリューションを提供します。具体的には、ScaleNetは事前トレーニング済みのViTに追加のレイヤーを挿入することでモデルをスケーリングし、レイヤーごとの重み共有によってパラメータ効率を維持します。ImageNet-1Kデータセットを用いた広範な実験により、ScaleNetはゼロからトレーニングしたモデルを大幅に上回り、2倍の深度スケールを適用したDeiT-Baseモデルにおいて、わずか3分の1のトレーニングエポックでTP3T精度が7.421向上することが実証されています。