Command Palette

Search for a command to run...

ハイパーネットワーク

日付

HyperNetworks は、従来のニューラル ネットワークと比較して、モデルのパラメーター化にいくつかの違いがあるニューラル ネットワーク構造です。 2016年にGoogle Brainが発表した論文「ハイパーネットワーク」は、HyperNetworks では、1 つのニューラル ネットワークが別のニューラル ネットワークの重みやその他のパラメーターを生成するために使用されることを意味します。この生成されたネットワークはハイパーネットワークと呼ばれ、生成されるネットワークはターゲット ネットワークと呼ばれます。

通常、HyperNetwork はターゲット ネットワークの入力などの追加入力を受け取り、ターゲット ネットワークのパラメーターを生成します。このアプローチの主な利点は、ターゲット ネットワーク パラメーターを動的に生成できるため、モデルをさまざまなタスクや環境にさらに柔軟に適応できることです。

HyperNetworks には、メタ学習やアーキテクチャ検索などの分野で応用できる可能性があります。 HyperNetworksを利用することで、モデルの構造やパラメータの自動調整や最適化が可能となり、モデルの汎化能力や適応性が向上します。

安定した普及が進むハイパーネットワーク

HyperNetworks は Stable Diffusion を早期に導入した企業です 斬新なAI 微調整技術を開発。これは、スタイルを変更するために安定拡散モデルに接続される小さなニューラル ネットワークです。

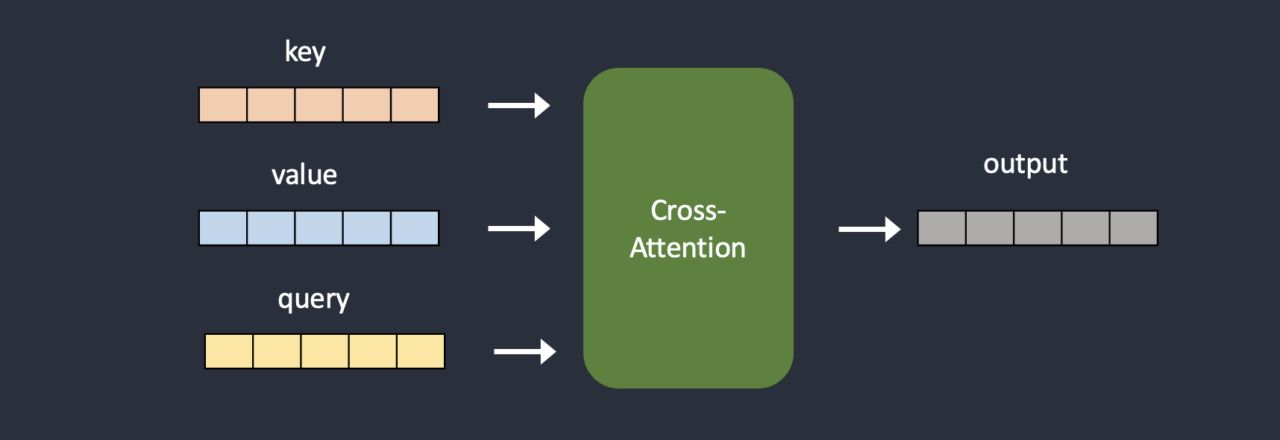

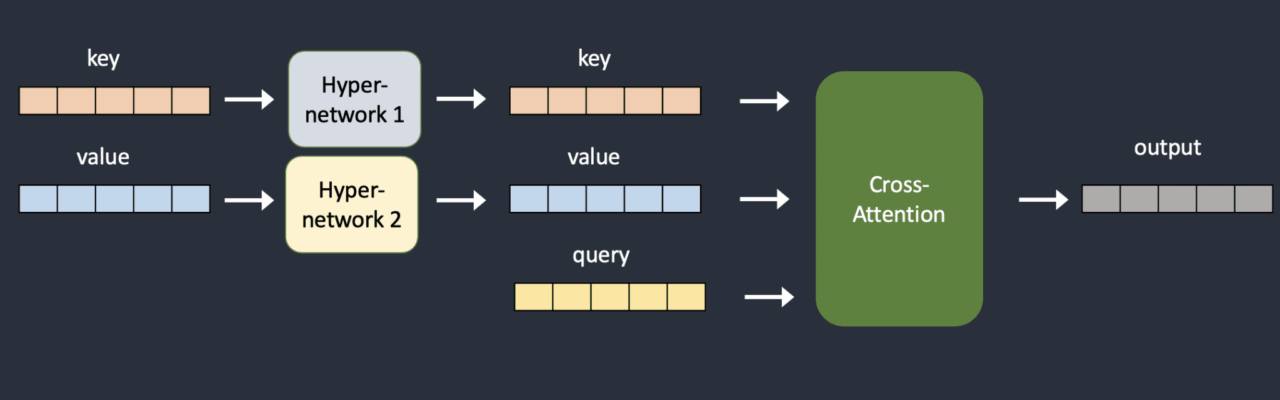

ハイパーネットワークは通常、単純なニューラル ネットワーク、つまりドロップアウト関数とアクティベーション関数を備えた完全に接続された線形ネットワークです。ニューラル ネットワークの入門コースで学ぶのと同じです。彼らは、キー ベクトルとクエリ ベクトルを変換する 2 つのネットワークを挿入することによって、クロス アテンション モジュールをハイジャックします。以下は、元のモデル アーキテクチャとハイジャックされたモデル アーキテクチャの比較です。

トレーニング中、安定拡散モデルはロックされていますが、接続されているハイパーネットワークにより変更が可能です。ハイパーネットワークが小さいため、トレーニングは高速であり、必要なリソースは限られています。トレーニングは通常のコンピューターで行うことができます。

参考文献

【1】ハイパーネットワーク