Command Palette

Search for a command to run...

Hunyuan-GameCraft-1.0: インタラクティブゲームビデオ生成フレームワーク

1. チュートリアルの概要

Hunyuan-GameCraft-1.0は、テンセントHunyuanチームと華中科技大学が2025年8月に共同で発表した、高ダイナミックなインタラクティブゲーム動画生成フレームワークです。キーボードとマウスの入力を共有カメラ表現空間に統合することで、きめ細かなモーションコントロールを実現し、複雑なインタラクティブ入力をサポートします。このフレームワークは、ハイブリッド履歴条件付きトレーニング戦略を導入し、動画シーケンスを自己回帰的に拡張し、ゲームシーン情報を保持し、長期的な時間的一貫性を確保します。モデル蒸留技術に基づくHunyuan-GameCraft-1.0は、推論速度を大幅に向上させ、複雑なインタラクティブ環境でのリアルタイム展開に適しています。このモデルは大規模なAAAゲームデータセットでトレーニングされており、優れた視覚的忠実度、リアリティ、モーション制御性を実証し、既存のモデルを大幅に上回っています。関連する研究論文も入手可能です。 Hunyuan-GameCraft: ハイブリッド履歴条件による高ダイナミックインタラクティブゲームビデオ生成 。

このチュートリアルでは、コンピューティング リソースとして 4 枚の RTX 4090 グラフィック カードを使用します。

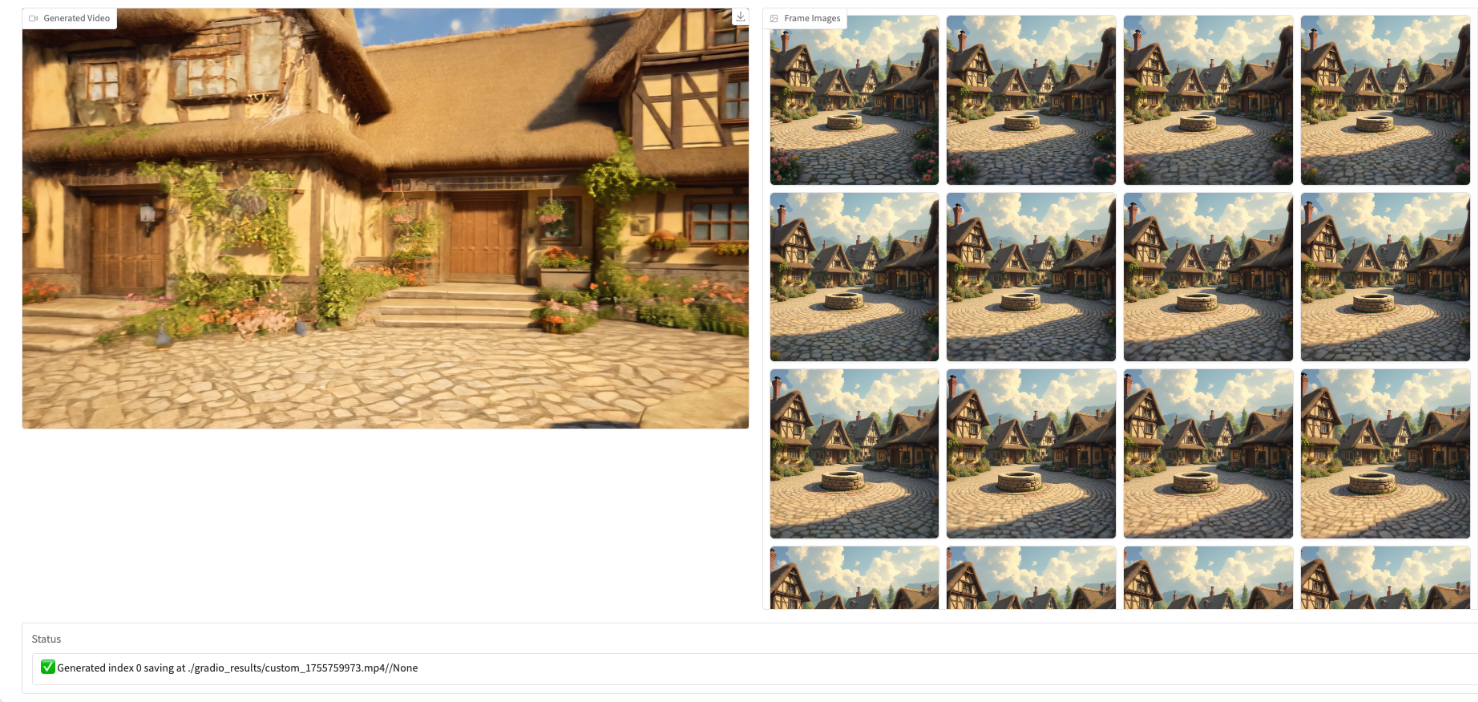

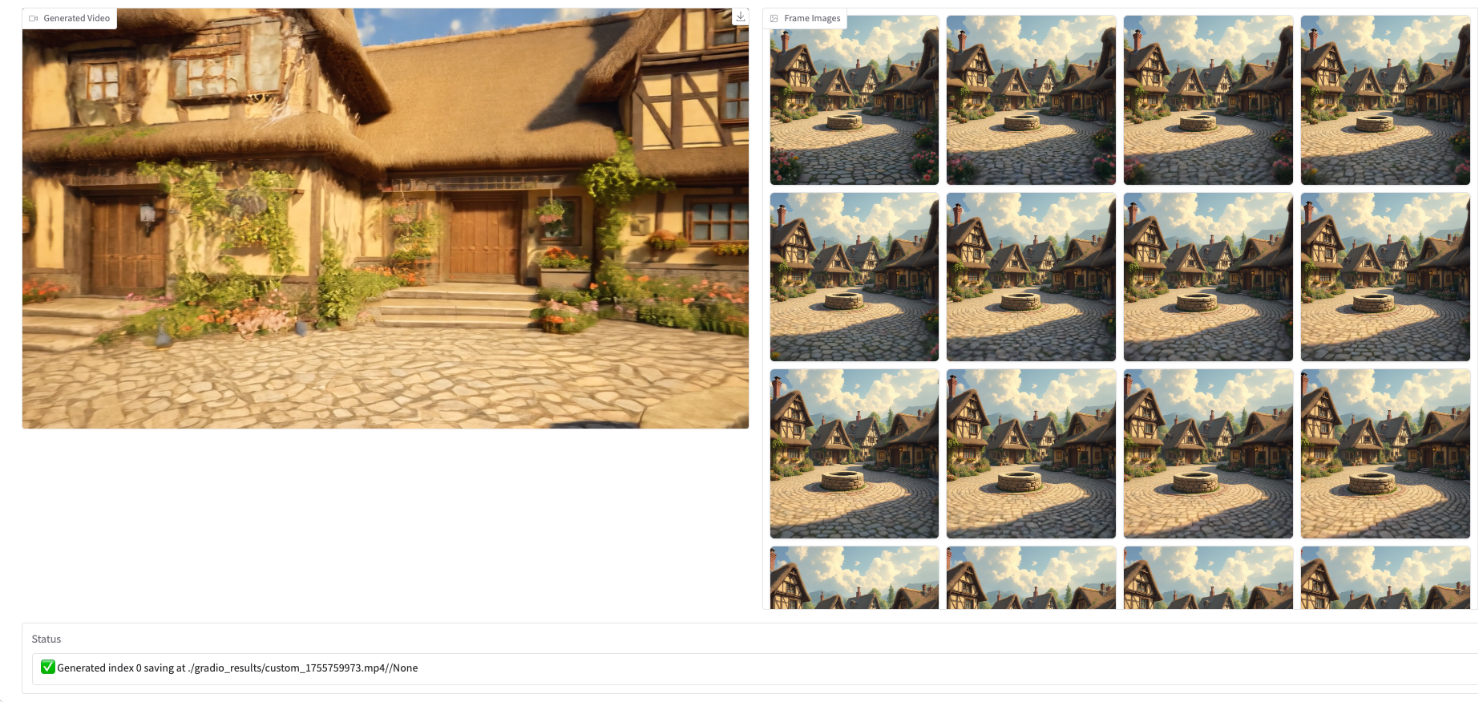

2. エフェクト表示

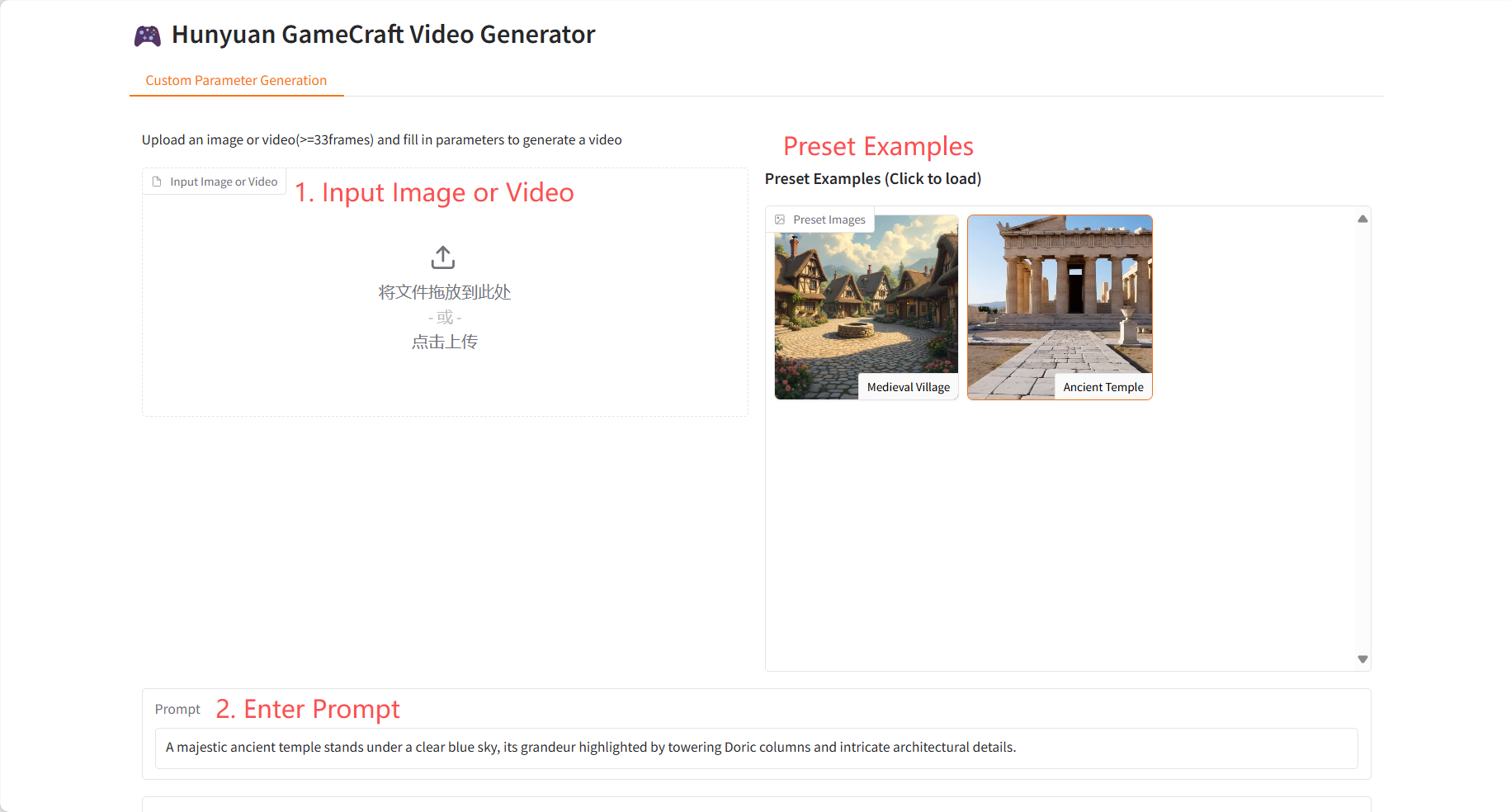

3. 操作手順

1. コンテナを起動します

2. 使用手順

「Bad Gateway」と表示される場合は、モデルが初期化中です。モデルのサイズが大きいため、5~6分ほどお待ちいただき、ページを更新してください。Gradioインターフェースを操作する前に、モデルの初期化が完了していることを確認してください。

注:推論ステップ数/動画フレーム数が多いほど、生成される効果は向上しますが、推論生成時間は長くなります。推論ステップ数/動画フレーム数を適切に設定してください(推論ステップ数が5、動画フレーム数が33の場合、動画生成に約15分かかります)。

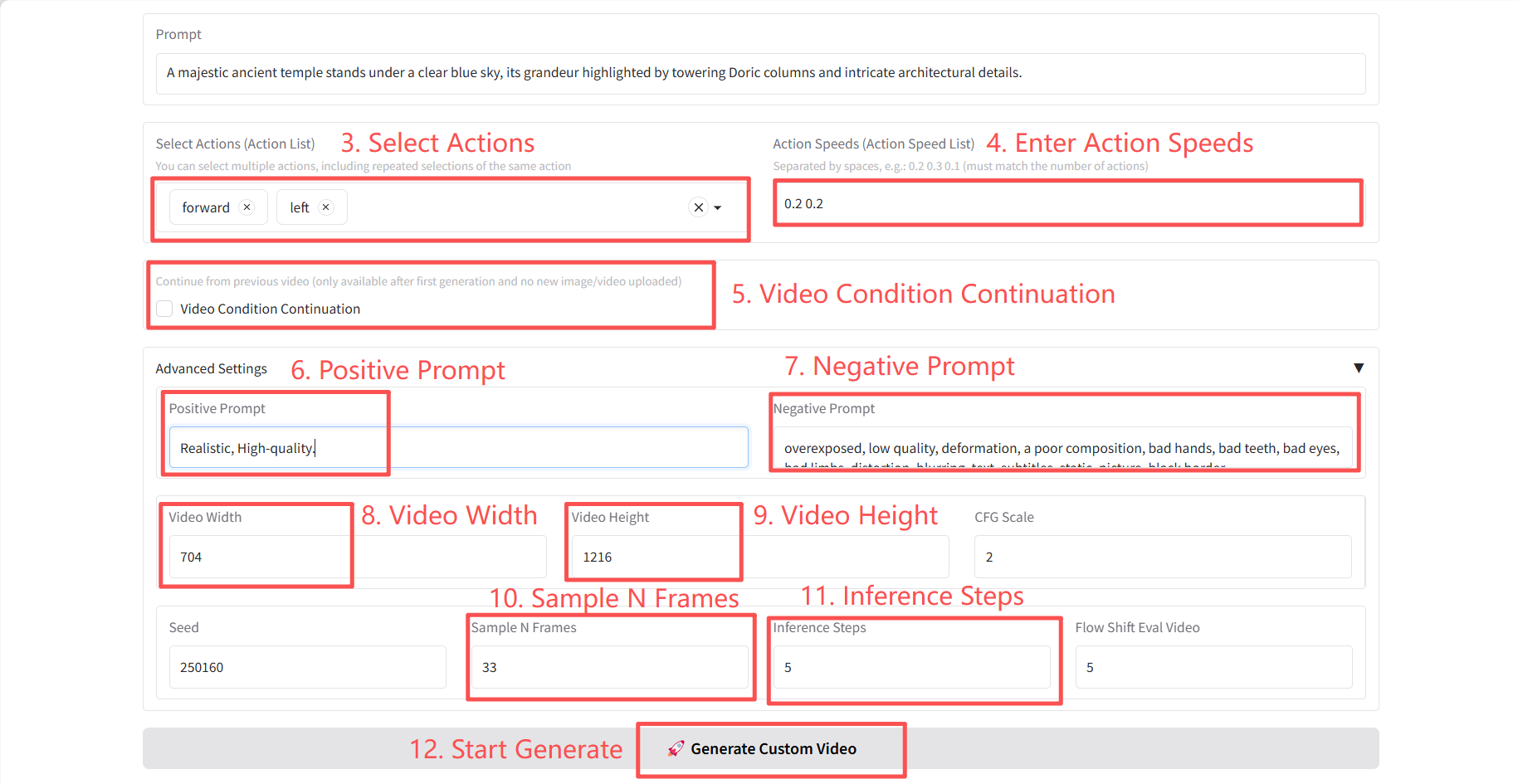

具体的なパラメータ:

- アクションを選択(アクションリスト):

- 前進: 方向を変えずに、現在の方向(カメラ/キャリアの正面)に沿って直線的に前進します。

- 左: 方向を変えずに、現在の方向の左に水平に移動します。

- right: 方向を変えずに、現在の方向の右に水平に移動します。

- 後方: 方向を変えずに、現在の方向と反対方向に直線で後方に移動します。

- up_rot: ビュー/ピッチ角度を水平軸を中心に上方向に回転します(ピッチ↑)。ビューの方向のみが変更され、位置は変更されません。

- right_rot: カメラを垂直軸を中心に右に回転させます (ヨー →)。位置は変更せず、方向のみを変更します。

- left_rot: カメラを垂直軸を中心に左に回転させます (ヨー ←)。位置は変更せず、方向のみを変更します。

- down_rot: ビュー/ピッチ角度を水平軸 (pitch↓) を中心に下方向に回転させます。位置は変更せず、ビューの方向のみを変更します。

- CFGスケール: プロンプトワードが生成される結果に与える影響を制御します。値が大きいほど、プロンプトワードとの適合度が高くなります。

- サンプル N フレーム: 生成されたビデオのフレームの合計数。

- 推論ステップ: ビデオ生成のための反復的な最適化ステップの数。

- フローシフト評価ビデオ: ビデオの滑らかさを制御するパラメータ。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

Githubユーザーに感謝 スーパーヤン このチュートリアルの展開。このプロジェクトの引用情報は次のとおりです。

@misc{li2025hunyuangamecrafthighdynamicinteractivegame,

title={Hunyuan-GameCraft: High-dynamic Interactive Game Video Generation with Hybrid History Condition},

author={Jiaqi Li and Junshu Tang and Zhiyong Xu and Longhuang Wu and Yuan Zhou and Shuai Shao and Tianbao Yu and Zhiguo Cao and Qinglin Lu},

year={2025},

eprint={2506.17201},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2506.17201},

}