Command Palette

Search for a command to run...

MiniCPM-V4.0: 極めて効率的な大規模エンドツーエンドモデル

1. チュートリアルの概要

MiniCPM-V 4.0は、清華大学自然言語処理研究所がWallfacer Intelligenceと共同で2025年8月にオープンソース化した、極めて効率的なエッジサイド大規模モデルです。MiniCPM-V 4.0は、SigLIP2-400MとMiniCPM4-3Bを基盤とし、総パラメータ数は41億です。MiniCPM-V 2.6の強力なシングルイメージ、マルチイメージ、動画理解性能を継承し、効率性を大幅に向上させています。Wallfacer Intelligenceは、iPhoneとiPad向けのiOSアプリケーションも同時にオープンソース化しました。OpenCompassベンチマークにおいて、MiniCPM-V 4.0の画像理解能力は、GPT-4.1-mini-20250414、Qwen2.5-VL-3B-Instruct、InternVL2.5-8Bを上回りました。関連研究論文も公開されています。 MiniCPM-V: スマートフォンで動作する GPT-4V レベルの MLLM 。

このチュートリアルでは、単一のRTX 4090グラフィックカードをコンピューティングリソースとして使用します。テスト用に、1枚または複数の画像を使ったチャット、動画を使ったチャット、そして少数のショットの3つの例が用意されています。

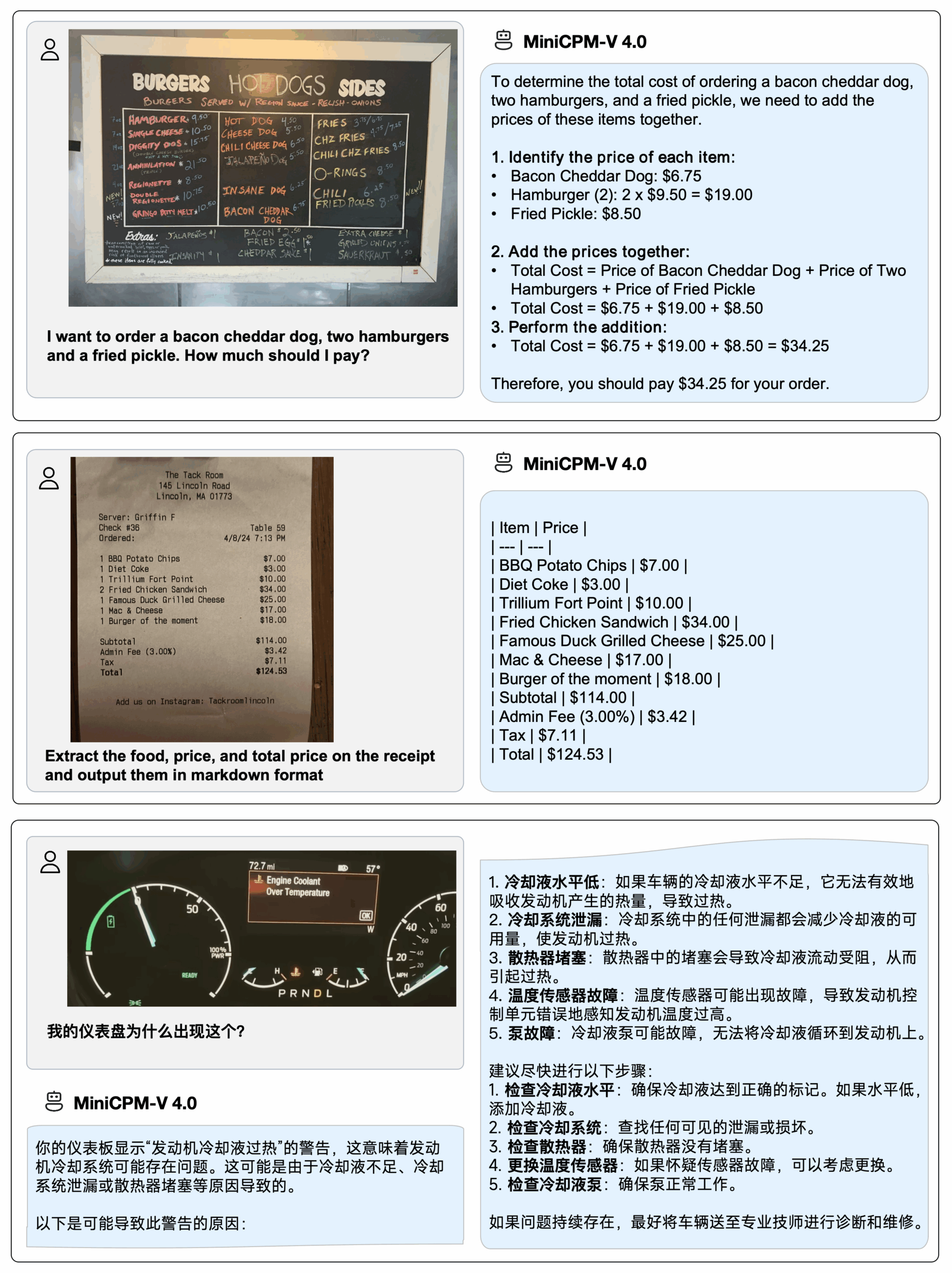

2. エフェクト表示

iPhone 16 Pro MaxにMiniCPM-V 4.0を導入し、iOSデモデモ ビデオは、編集されていない生の画面録画です。

3. 操作手順

1. コンテナを起動します

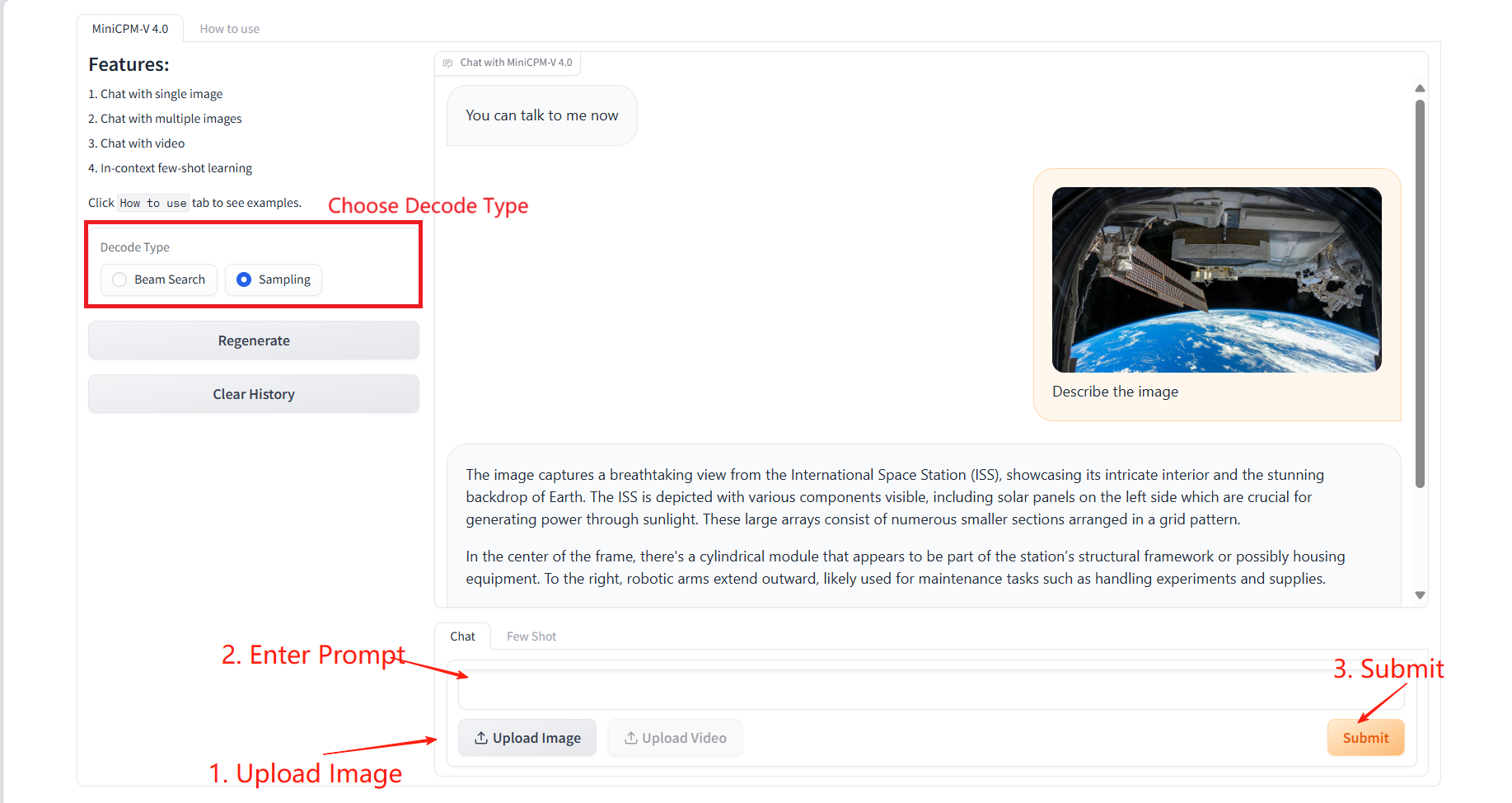

2. 使用手順

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、2〜3分ほど待ってページを更新してください。

「使い方」をクリックすると使い方ガイドが表示されます。

1. 単一または複数の画像でチャット

具体的なパラメータ:

- デコードタイプ:

- ビームサーチ:最も可能性の高い候補シーケンスを保持しようとする、非常に決定論的なデコード手法です。正確で一貫性のある出力が求められるシナリオに適しています。

- サンプリング:確率分布に基づいて次の単語をランダムにサンプリングします。出力はよりクリエイティブになりますが、不安定になる可能性があります。

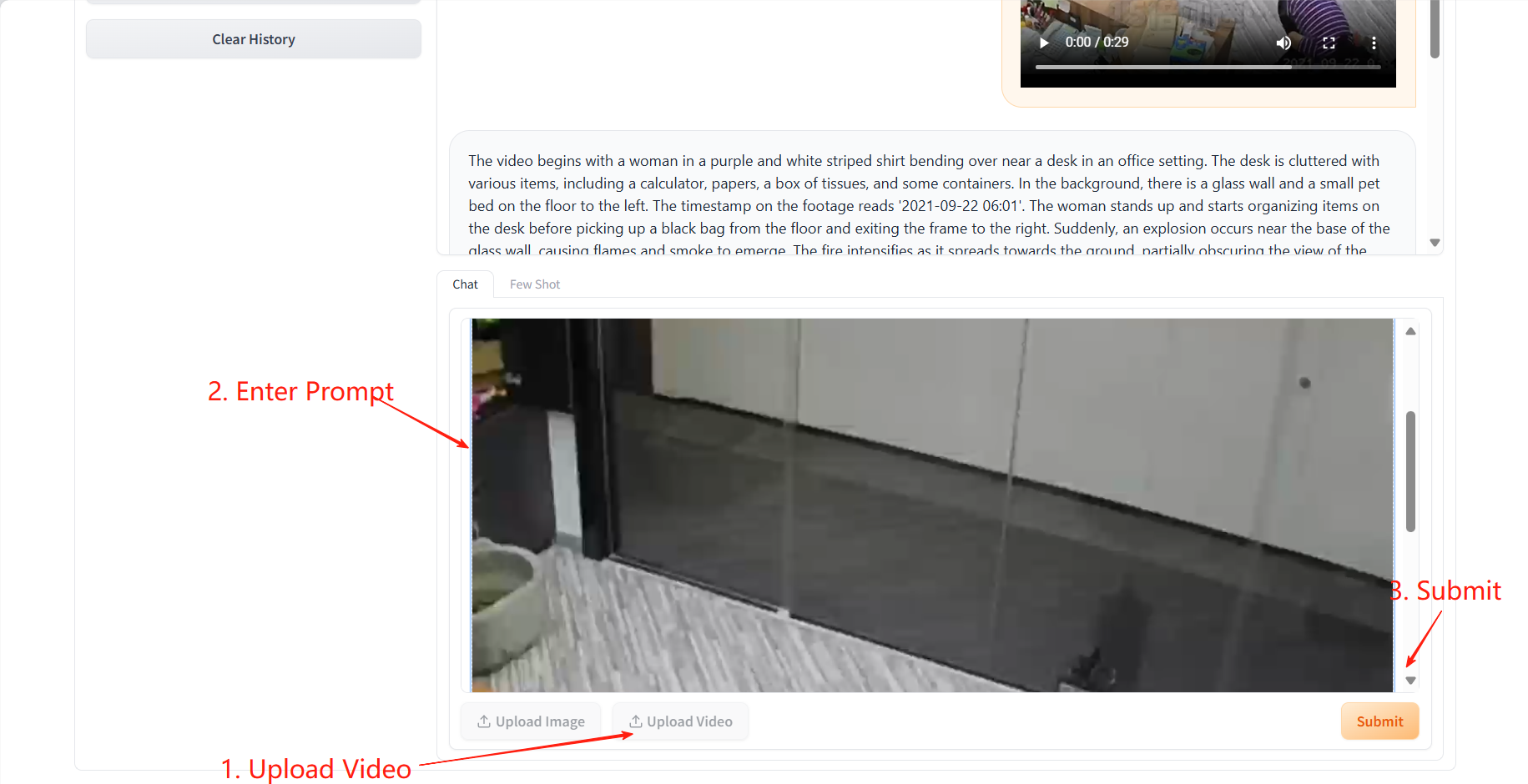

2. ビデオチャット

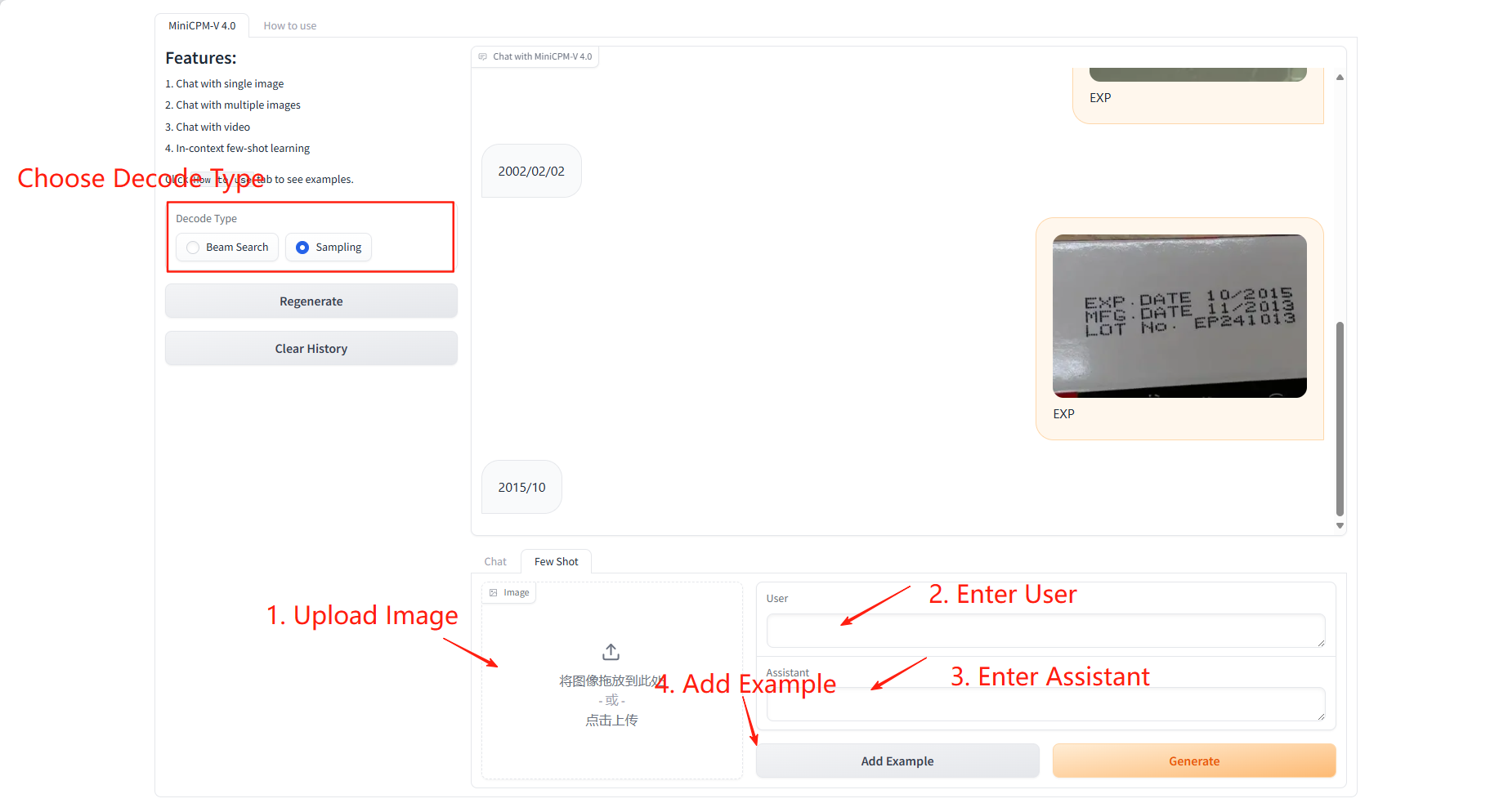

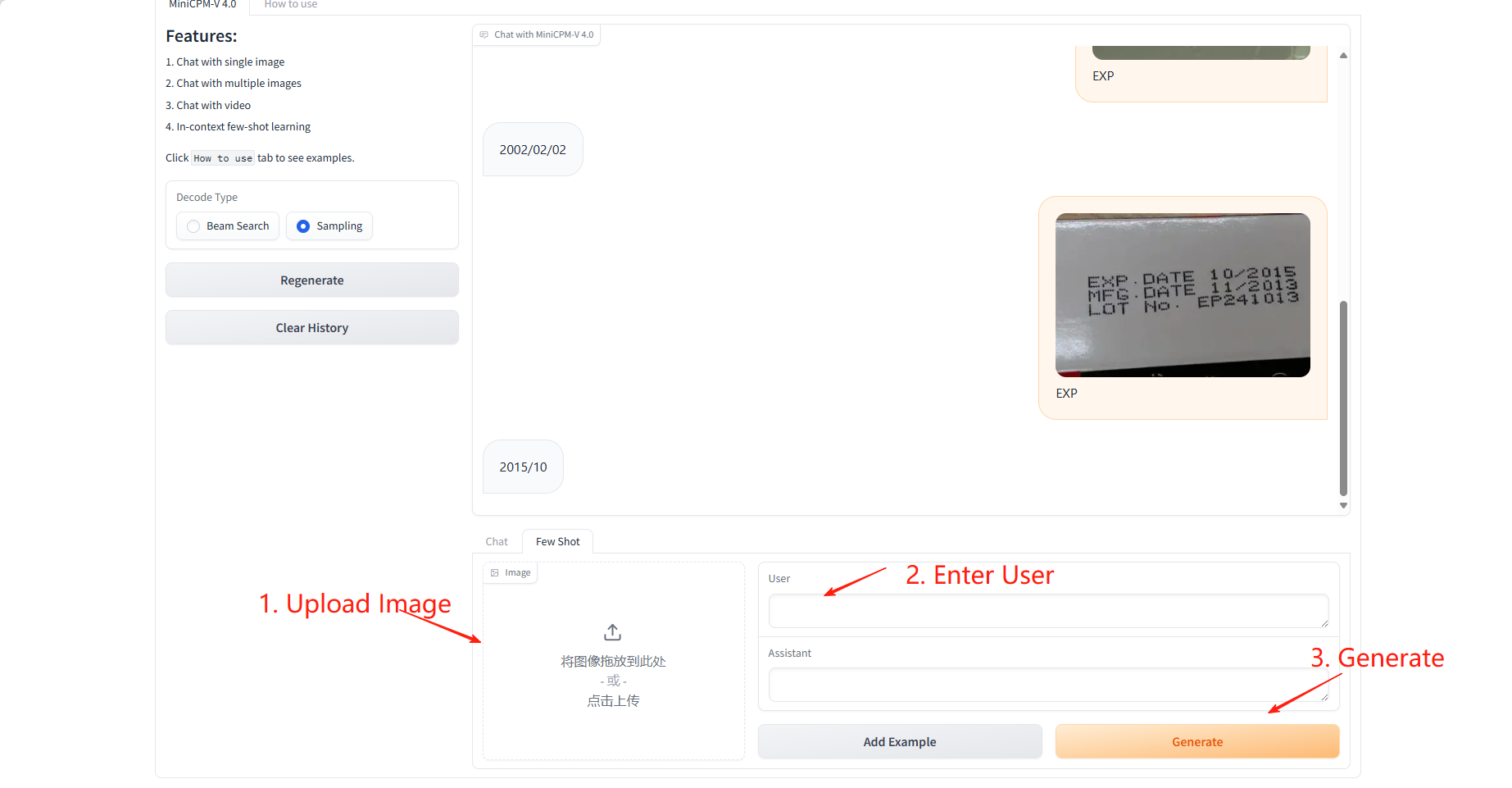

3. 少数のショット

サンプル学習

具体的なパラメータ:

- ユーザー: このサンプルに対して予測または学習するフィールドを入力します。

- アシスタント: このサンプルで学習するフィールドに対応する値を入力します。

結果予測

引用情報

このプロジェクトの引用情報は次のとおりです。

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={Nat Commun 16, 5509 (2025)},

year={2025}

}

@article{yao2024minicpm,

title={MiniCPM-V: A GPT-4V Level MLLM on Your Phone},

author={Yao, Yuan and Yu, Tianyu and Zhang, Ao and Wang, Chongyi and Cui, Junbo and Zhu, Hongji and Cai, Tianchi and Li, Haoyu and Zhao, Weilin and He, Zhihui and others},

journal={arXiv preprint arXiv:2408.01800},

year={2024}

}