Command Palette

Search for a command to run...

自己強制リアルタイムビデオ生成

1. チュートリアルの概要

2025年6月9日にXun Huangのチームによって提案されたSelf Forcingは、自己回帰ビデオ拡散モデルのための新しいトレーニングパラダイムです。これは、実コンテキストでトレーニングされたモデルが推論中に自身の不完全な出力に基づいてシーケンスを生成しなければならないという、長年の課題である露出バイアスに対処します。実コンテキストフレームに基づいて将来のフレームのノイズを除去する従来の方法とは異なり、Self Forcingはトレーニング中にキー値(KV)キャッシュを用いた自己回帰ロールアウトを実行し、各フレームの生成条件を以前に生成された出力に設定します。この戦略は、従来のフレームごとの目的関数のみに依存するのではなく、生成されたシーケンス全体の品質を直接評価するビデオレベルのグローバル損失関数によって監視されます。トレーニング効率を確保するために、数ステップの拡散モデルと確率的勾配切り捨て戦略が採用されており、計算コストとパフォーマンスのバランスが効果的に取られています。さらに、効率的な自己回帰ビデオ外挿を実現するために、ローリングキー値キャッシュメカニズムが導入されています。広範囲にわたる実験により、彼らの手法は単一のGPUで1秒未満の遅延でリアルタイムストリーミングビデオ生成を実現し、それよりもはるかに低速で非因果的な拡散モデルの生成品質と同等、あるいはそれを上回ることが実証されました。関連論文の結果は以下の通りです。 自己強制:自己回帰ビデオ拡散における訓練とテストのギャップを埋める 。

このチュートリアルでは、単一の RTX 4090 カードのリソースを使用します。

2. プロジェクト例

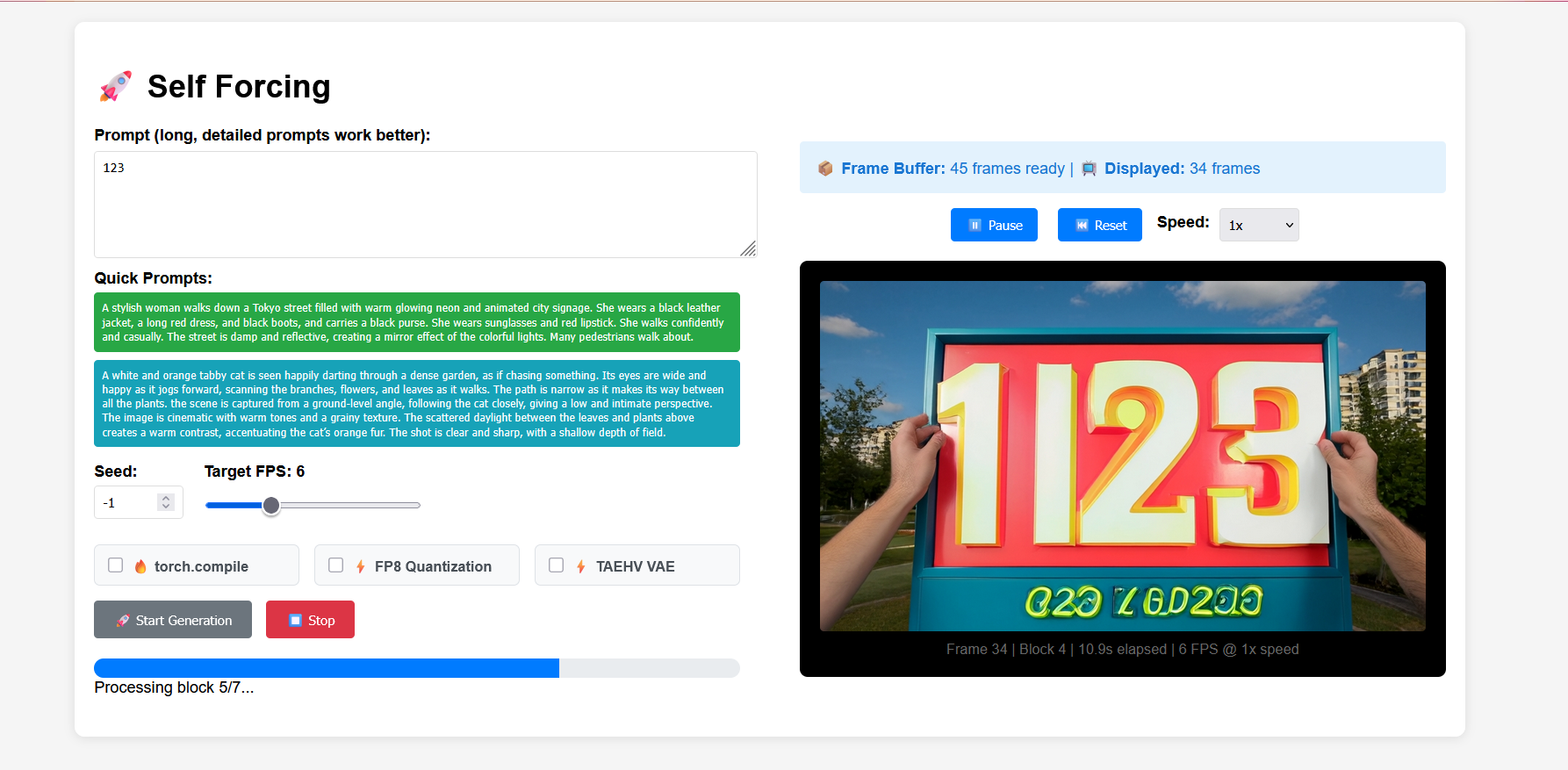

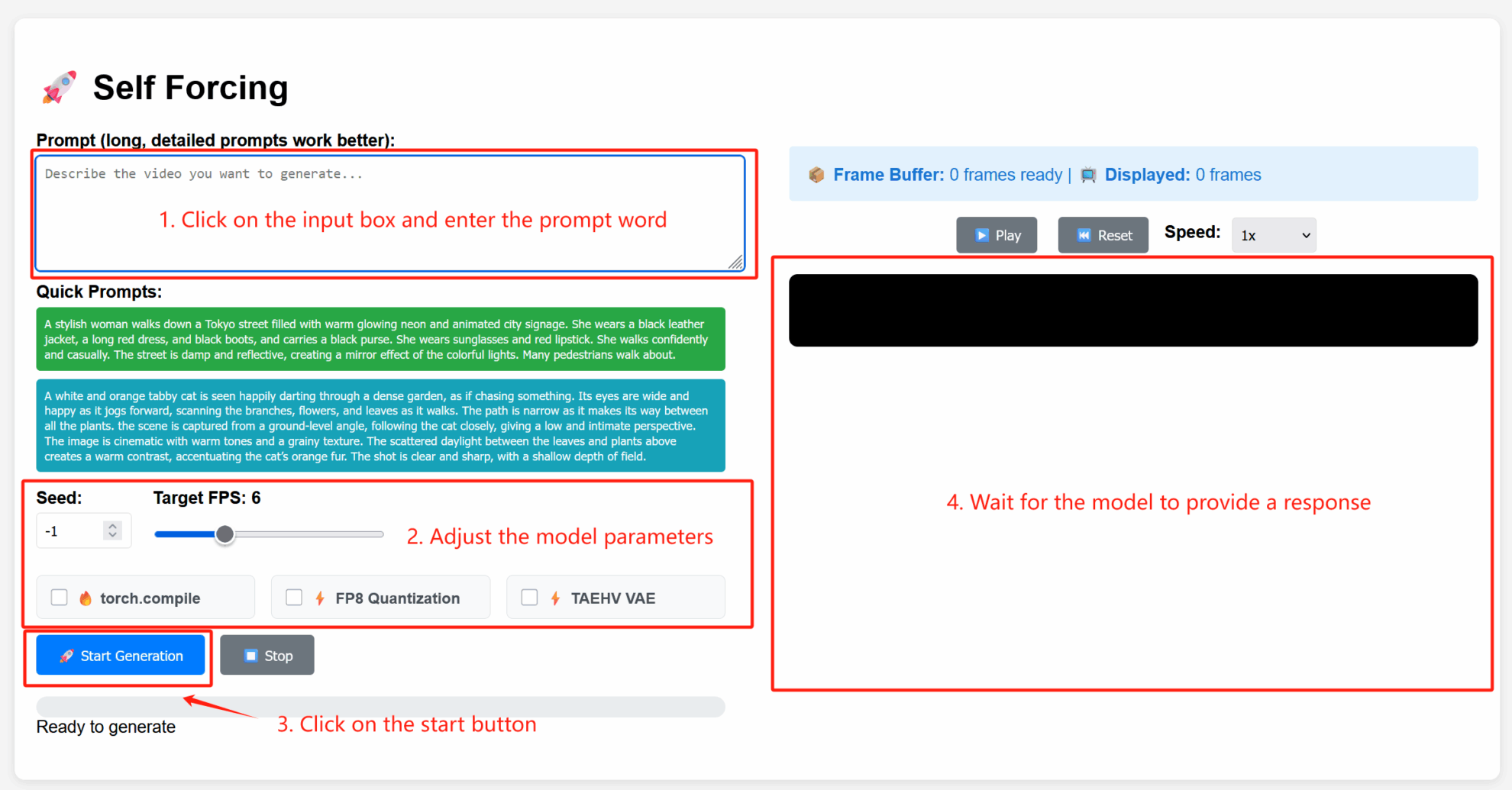

3. 操作手順

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

2. 使用手順

パラメータの説明

- 詳細設定:

- シード: 生成プロセスのランダム性を制御するランダムシード値。固定シードでも同じ結果が再現されます。-1 はランダムシードを示します。

- ターゲットFPS:目標フレームレート。デフォルト値は6で、生成されるビデオは1秒あたり6フレームになります。

- torch.compile: PyTorch コンパイルの最適化を有効にして、モデル推論を高速化します (環境サポートが必要)。

- FP8 量子化: 8 ビット浮動小数点量子化を有効にし、計算精度を下げて生成速度を上げます (品質に若干影響する場合があります)。

- TAEHV VAE: 使用される変分オートエンコーダ (VAE) モデルのタイプを指定します。これは、生成される詳細またはスタイルに影響する可能性があります。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

このプロジェクトの引用情報は次のとおりです。

@article{huang2025selfforcing,

title={Self Forcing: Bridging the Train-Test Gap in Autoregressive Video Diffusion},

author={Huang, Xun and Li, Zhengqi and He, Guande and Zhou, Mingyuan and Shechtman, Eli},

journal={arXiv preprint arXiv:2506.08009},

year={2025}

}