Command Palette

Search for a command to run...

LFM2-1.2B: 効率的なエッジ展開のためのテキスト生成モデル

1. チュートリアルの概要

LFM2-1.2Bは、Liquid AIが2025年7月10日にリリースしたLiquid Foundation Model(LFM)の第2世代です。ハイブリッドアーキテクチャに基づく生成AIモデルであり、業界最速のオンデバイス生成AIエクスペリエンスを提供することを目指しており、低レイテンシのオンデバイス言語モデルワークロード向けに設計されています。

LFM2-1.2Bは、新しいハイブリッドアーキテクチャを採用したモデルとして、乗算ゲーティングとショート畳み込みを革新的に組み合わせ、16個のブロック(10個のデュアルゲーティングショートレンジLIV畳み込みブロックと6個のグループクエリアテンションブロック)を含み、従来のモデルの処理効率と性能の欠点を解決しました。そのトレーニングは10兆トークンの事前トレーニングコーパスに基づいており、知識蒸留、大規模教師ありファインチューニング(SFT)、カスタム直接選好最適化(DPO)などの多段階トレーニング戦略を採用しています。知識、数学、命令追従、多言語機能など、複数のベンチマークカテゴリで同規模のモデルを凌駕し、より大きなパラメータスケールのモデルと競合することもできます。同時に、CPUでのデコードと事前充填速度はQwen 3の2倍、トレーニング効率は前世代のLFMの3倍です。 CPU、GPU、NPU ハードウェア上で効率的に実行できるため、エッジ デバイスの展開に柔軟で効率的なソリューションを提供します。

このチュートリアルでは、LFM2-1.2B をデモとして使用し、コンピューティング リソースには RTX 4090 を使用します。サポートされている言語: 英語、アラビア語、中国語、フランス語、ドイツ語、日本語、韓国語、スペイン語。

2. プロジェクト例

3. 操作手順

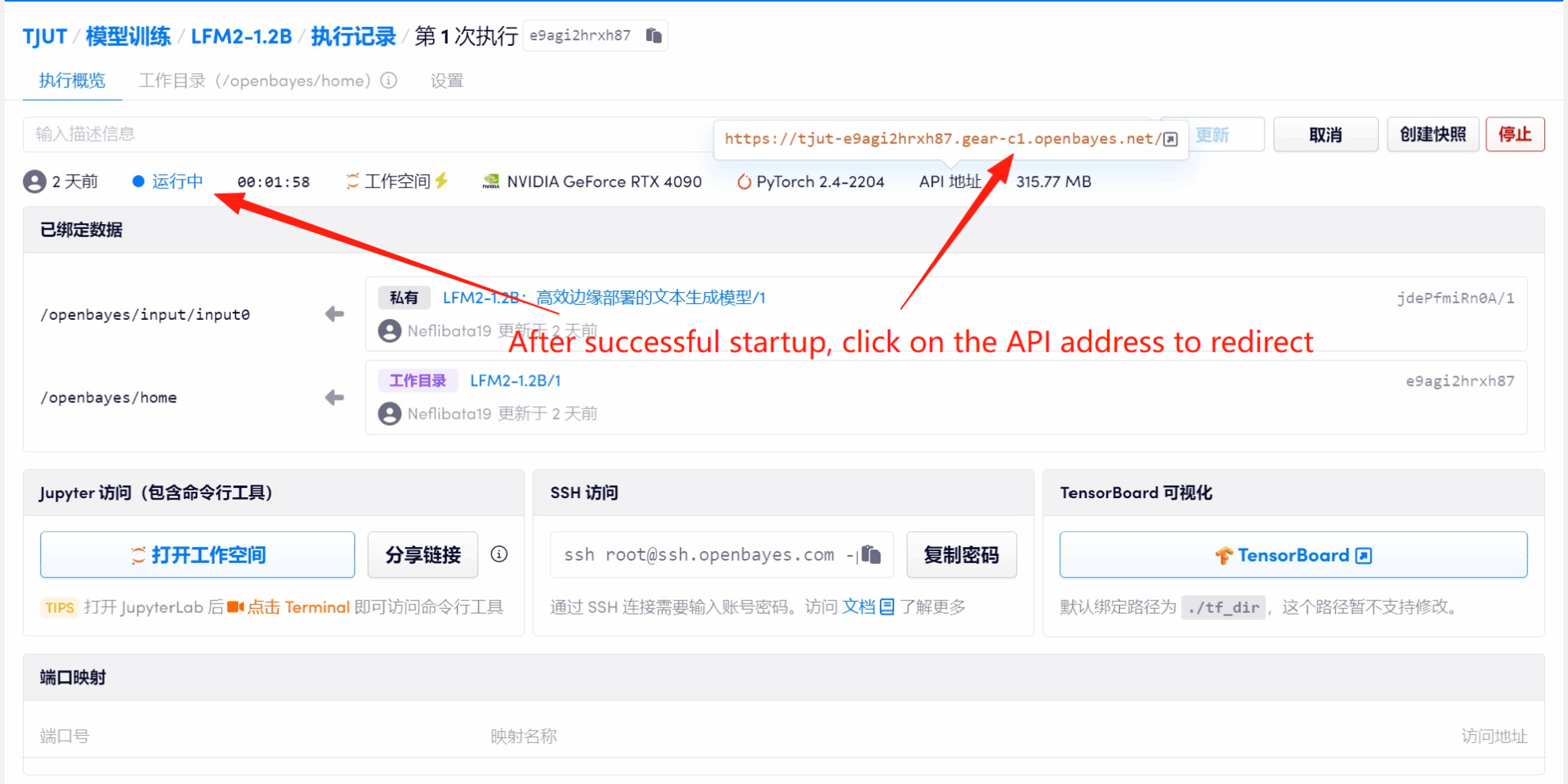

1. コンテナを起動した後、API アドレスをクリックして Web インターフェイスに入ります

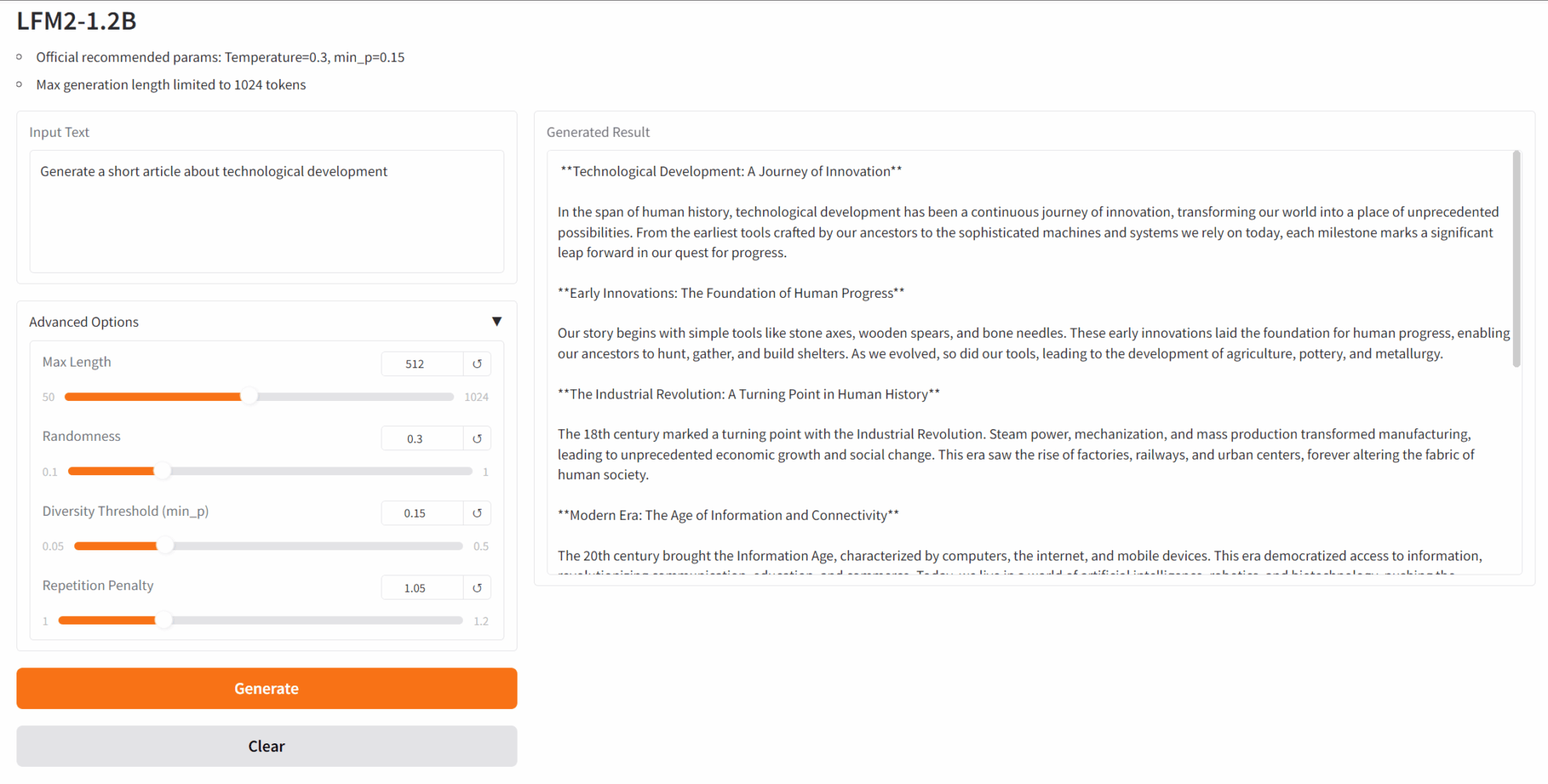

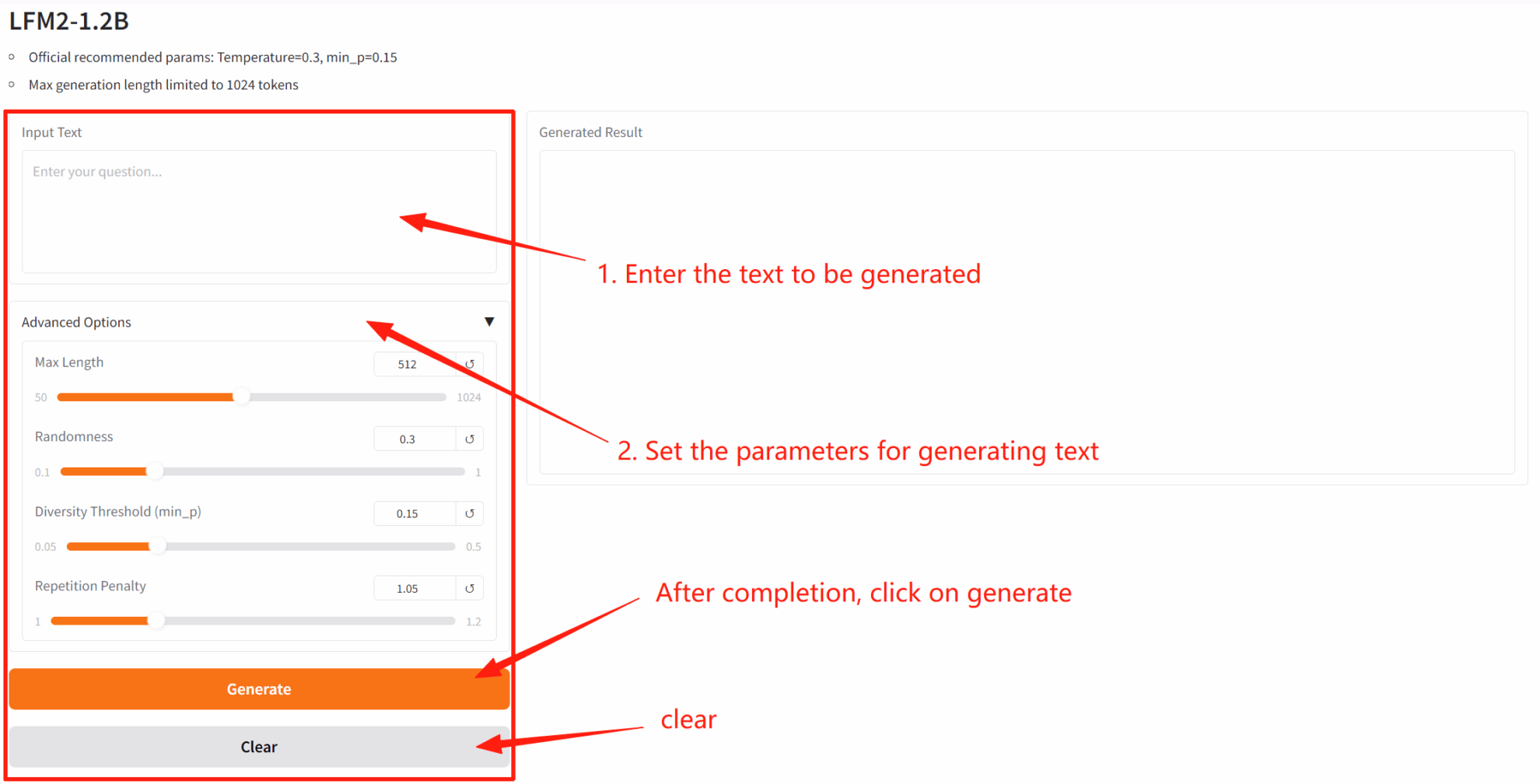

2. Web ページに入ると、モデルと会話を開始できます。

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、2〜3分ほど待ってページを更新してください。

4. 議論

良質なプロジェクトを見かけたら、ぜひバックグラウンドでメッセージを残して推薦してください!また、チュートリアル交流グループも開設しました。QRコードをスキャンして[SD Tutorial]とコメントしてグループに参加し、様々な技術的な問題について議論したり、応用結果を共有したりしてください。↓