Command Palette

Search for a command to run...

ワンクリック展開 GLM-4.1V-9B-Thinking

1. チュートリアルの概要

GLM-4.1V-9B-Thinkingは、Zhipu AIが清華大学のチームと共同で2025年7月2日にリリースしたオープンソースの視覚言語モデルです。複雑な認知タスク向けに特別に設計されており、画像、動画、文書などのマルチモーダル入力をサポートしています。GLM-4.1V-9B-Thinkingは、GLM-4-9B-0414ベースモデルをベースに、思考パラダイムを導入し、カリキュラムサンプリング(RLCS)によってモデルの機能を包括的に強化することで、100億パラメータの視覚言語モデルの中で最高のパフォーマンスを実現しました。18のリーダーボードタスクにおいて、パラメータ数が8倍のQwen-2.5-VL-72Bと同等か、それを上回りました。関連研究論文も入手可能です。 GLM-4.1V思考:スケーラブルな強化学習による多用途マルチモーダル推論に向けて 。

このチュートリアルのコンピューティングリソースには、RTX A6000カード1枚を使用します。このチュートリアルは、テキスト会話、画像、動画、PDF、PPTの理解をサポートしています。

2. エフェクト表示

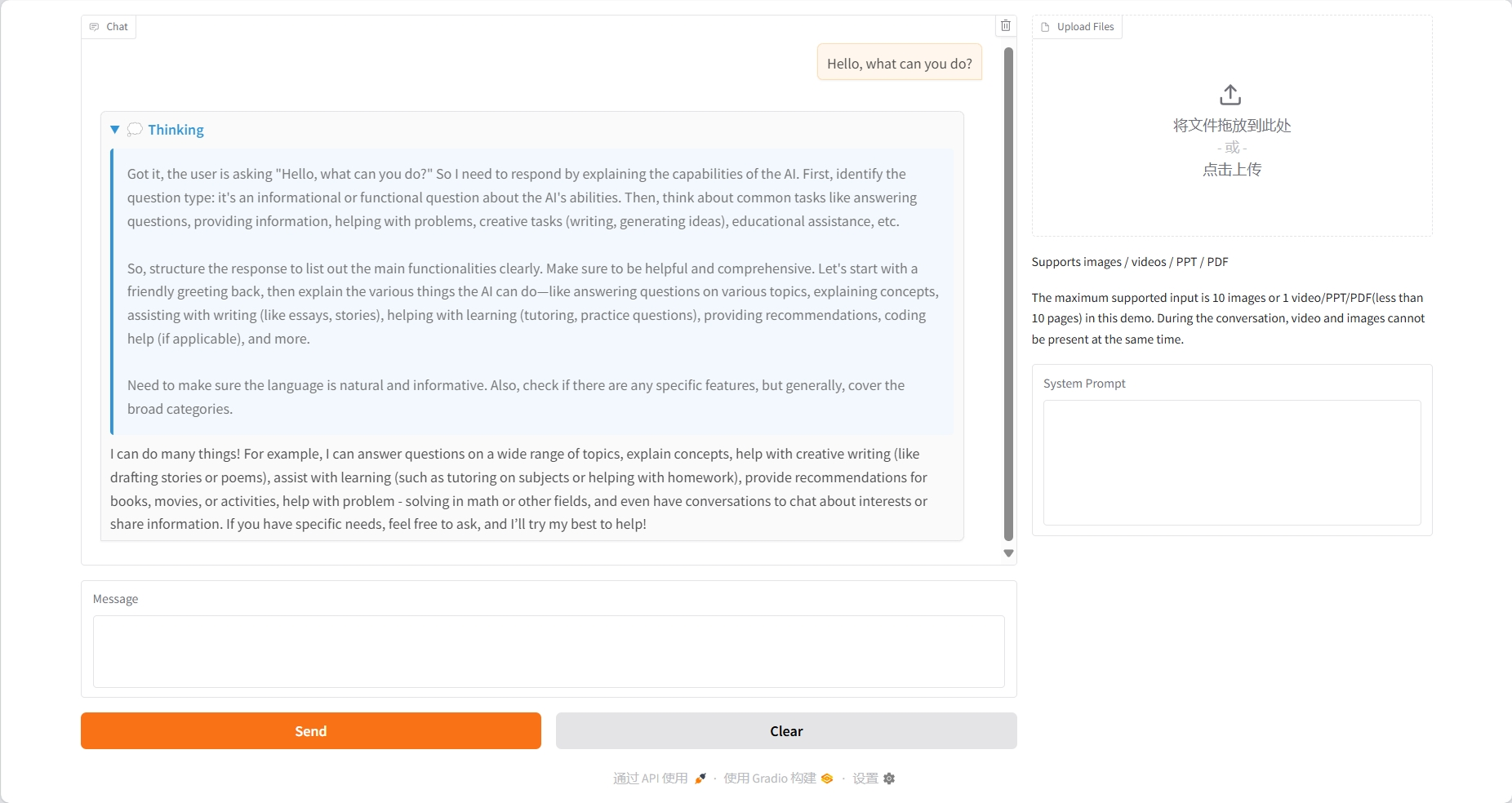

テキスト会話

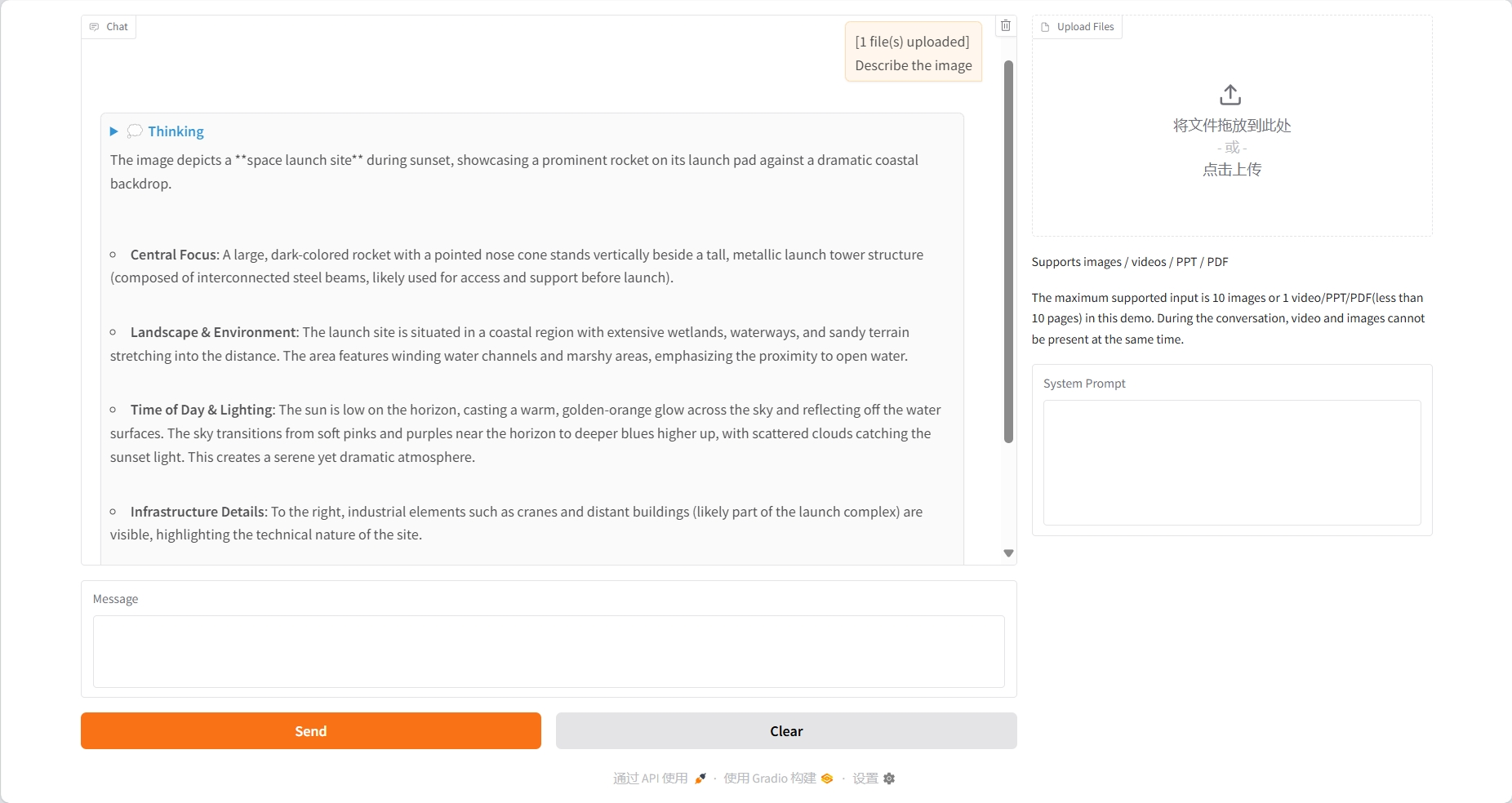

画像理解

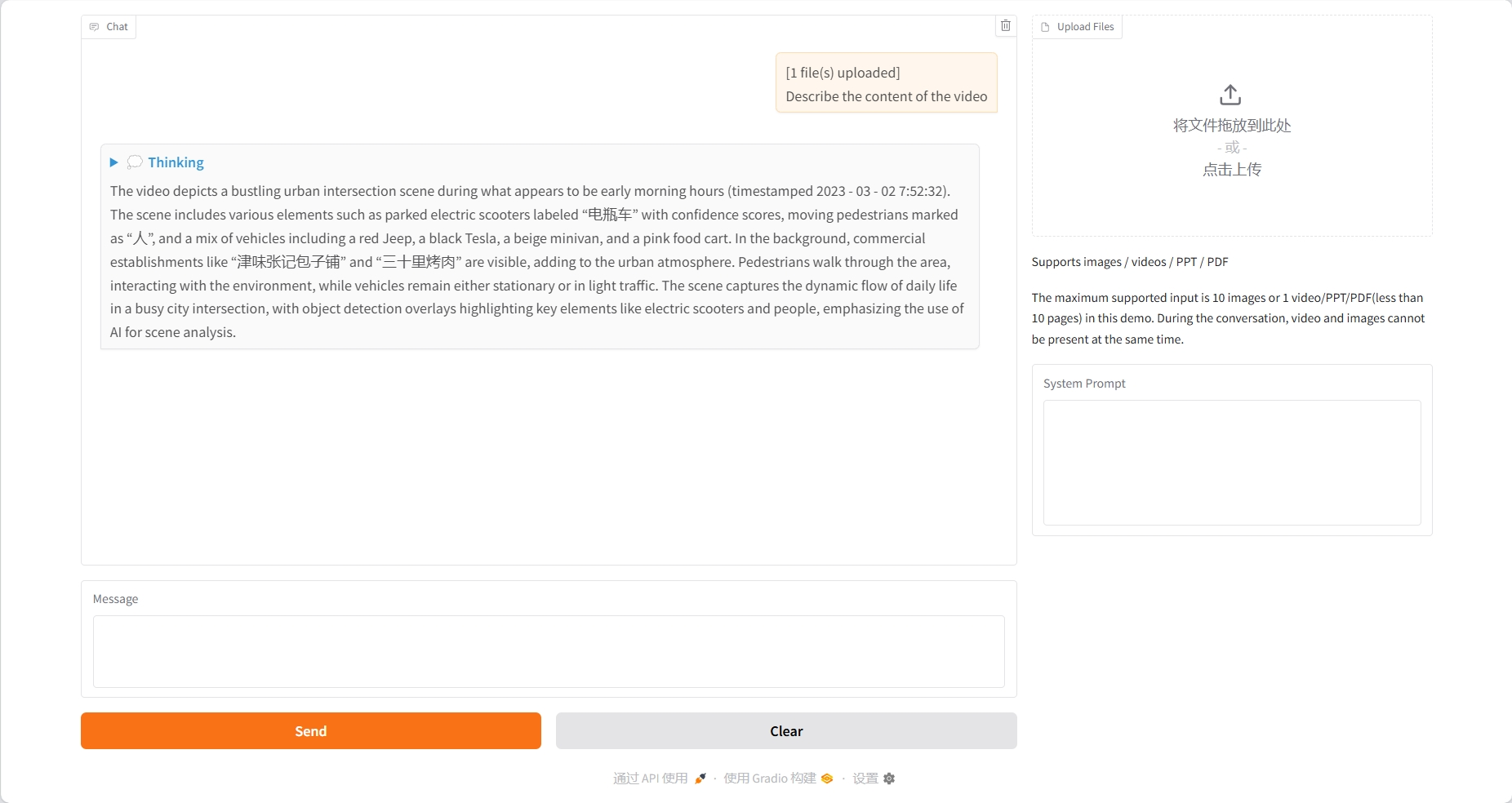

ビデオの理解

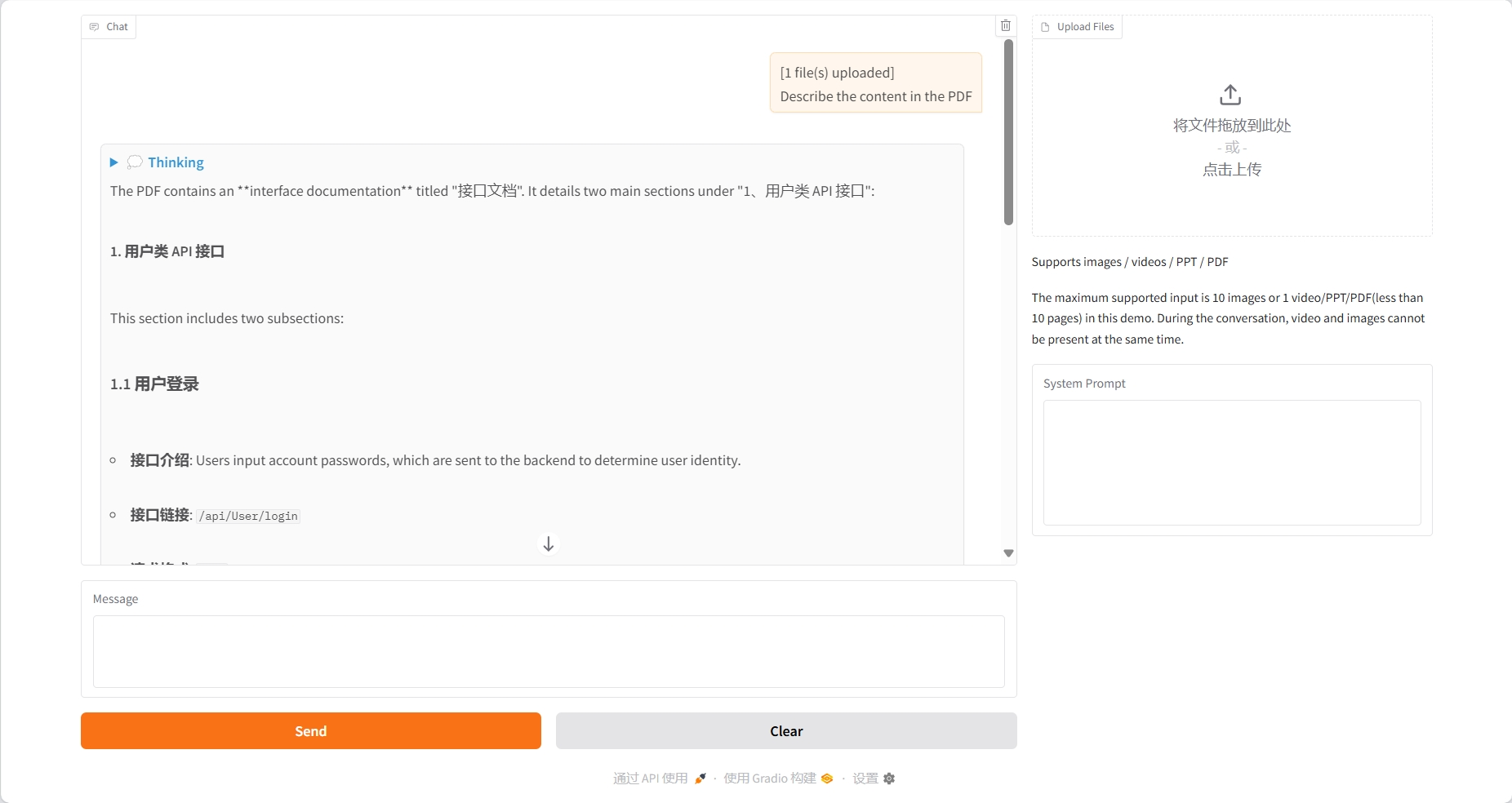

PDFの理解

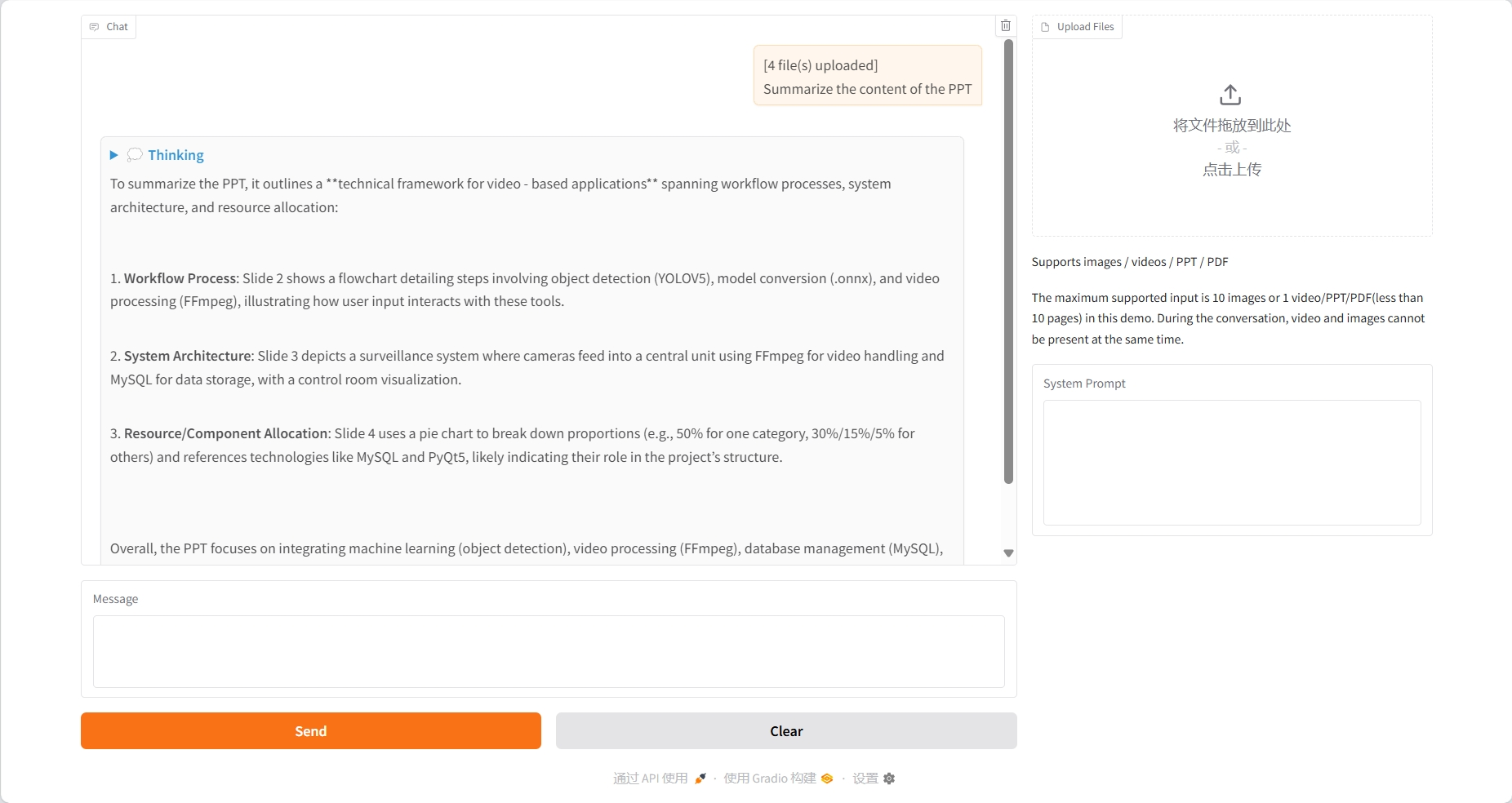

PPTの理解

3. 操作手順

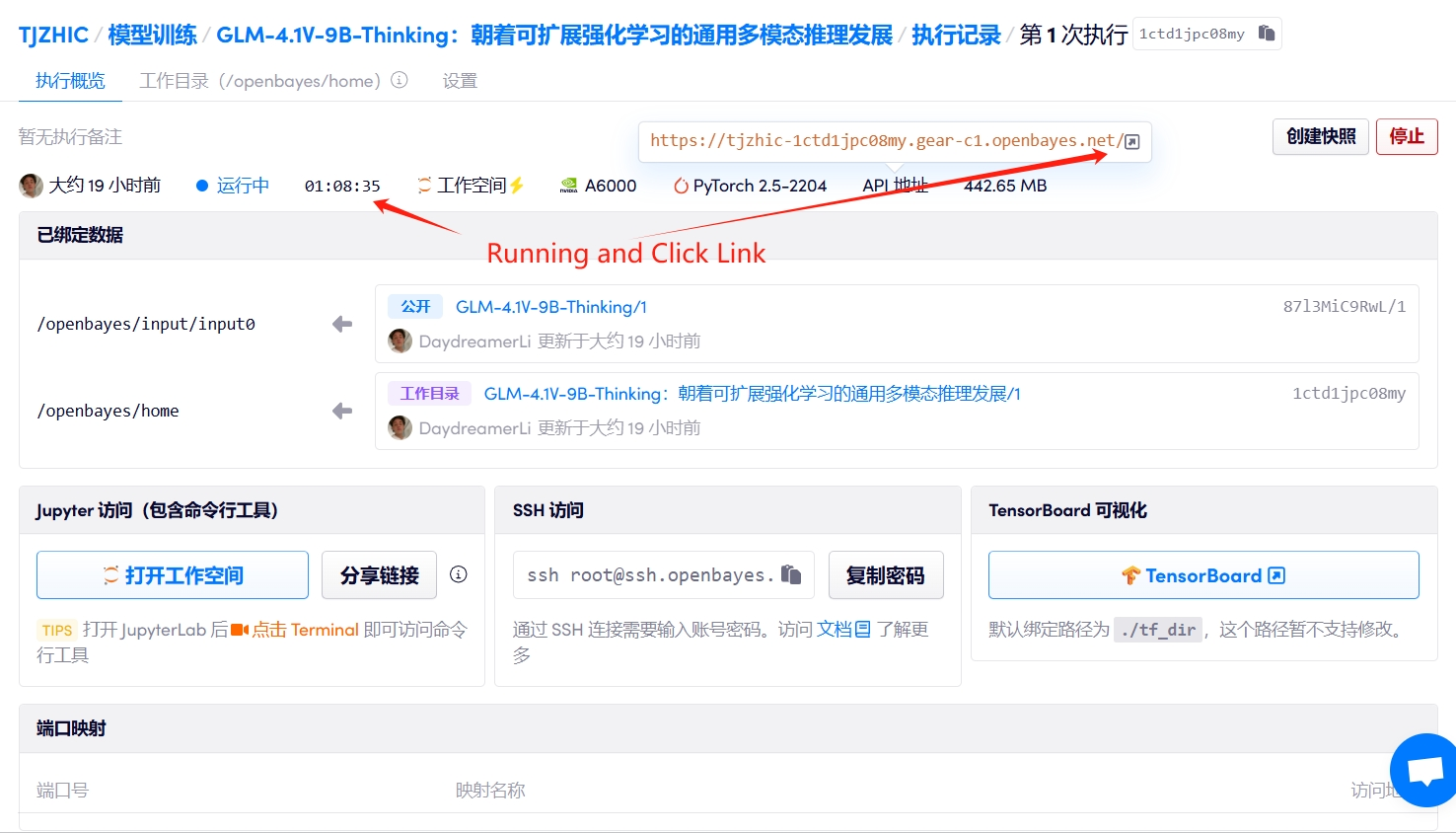

1. コンテナを起動します

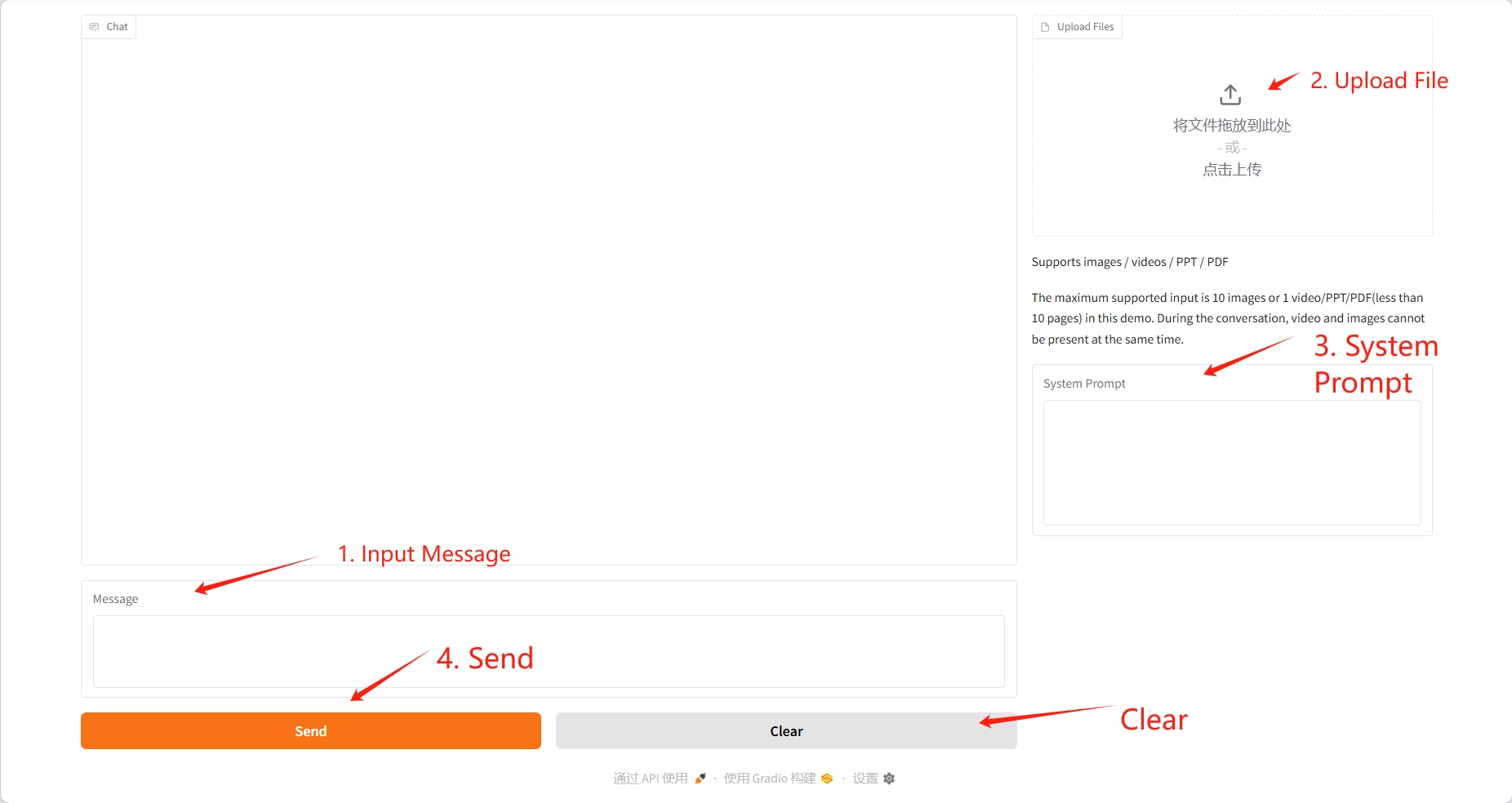

2. 使用手順

「Bad Gateway」と表示される場合、モデルが初期化中であることを意味します。モデルが大きいため、2〜3分ほど待ってページを更新してください。

アップロードする動画は10秒以内、PDFとPPTは10ページ以内としてください。会話中は動画と画像を同時に表示することはできません。会話ごとに操作をクリアすることをお勧めします。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。

引用情報

このプロジェクトの引用情報は次のとおりです。

@misc{glmvteam2025glm41vthinkingversatilemultimodalreasoning,

title={GLM-4.1V-Thinking: Towards Versatile Multimodal Reasoning with Scalable Reinforcement Learning},

author={GLM-V Team and Wenyi Hong and Wenmeng Yu and Xiaotao Gu and Guo Wang and Guobing Gan and Haomiao Tang and Jiale Cheng and Ji Qi and Junhui Ji and Lihang Pan and Shuaiqi Duan and Weihan Wang and Yan Wang and Yean Cheng and Zehai He and Zhe Su and Zhen Yang and Ziyang Pan and Aohan Zeng and Baoxu Wang and Boyan Shi and Changyu Pang and Chenhui Zhang and Da Yin and Fan Yang and Guoqing Chen and Jiazheng Xu and Jiali Chen and Jing Chen and Jinhao Chen and Jinghao Lin and Jinjiang Wang and Junjie Chen and Leqi Lei and Letian Gong and Leyi Pan and Mingzhi Zhang and Qinkai Zheng and Sheng Yang and Shi Zhong and Shiyu Huang and Shuyuan Zhao and Siyan Xue and Shangqin Tu and Shengbiao Meng and Tianshu Zhang and Tianwei Luo and Tianxiang Hao and Wenkai Li and Wei Jia and Xin Lyu and Xuancheng Huang and Yanling Wang and Yadong Xue and Yanfeng Wang and Yifan An and Yifan Du and Yiming Shi and Yiheng Huang and Yilin Niu and Yuan Wang and Yuanchang Yue and Yuchen Li and Yutao Zhang and Yuxuan Zhang and Zhanxiao Du and Zhenyu Hou and Zhao Xue and Zhengxiao Du and Zihan Wang and Peng Zhang and Debing Liu and Bin Xu and Juanzi Li and Minlie Huang and Yuxiao Dong and Jie Tang},

year={2025},

eprint={2507.01006},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2507.01006},

}