Command Palette

Search for a command to run...

vLLM+Open WebUI の導入 KernelLLM-8B

1. チュートリアルの概要

このチュートリアルで使用されるコンピューティング リソースは、単一の RTX 4090 カードです。

KernelLLMは、Meta AIがGPUカーネル開発向けに開発した大規模言語モデルです。PyTorchモジュールを効率的なTritonカーネルコードに自動変換することで、高性能GPUプログラミングのプロセスを簡素化・高速化します。このモデルはLlama 3.1 Instructアーキテクチャをベースとし、80億個のパラメータを持ち、効率的なTritonカーネル実装の生成に重点を置いています。

2. プロジェクト例

3. 操作手順

1. コンテナを起動します

「モデル」が表示されていない場合は、モデルが初期化中であることを意味します。モデルが大きいため、2〜3分ほど待ってページを更新してください。

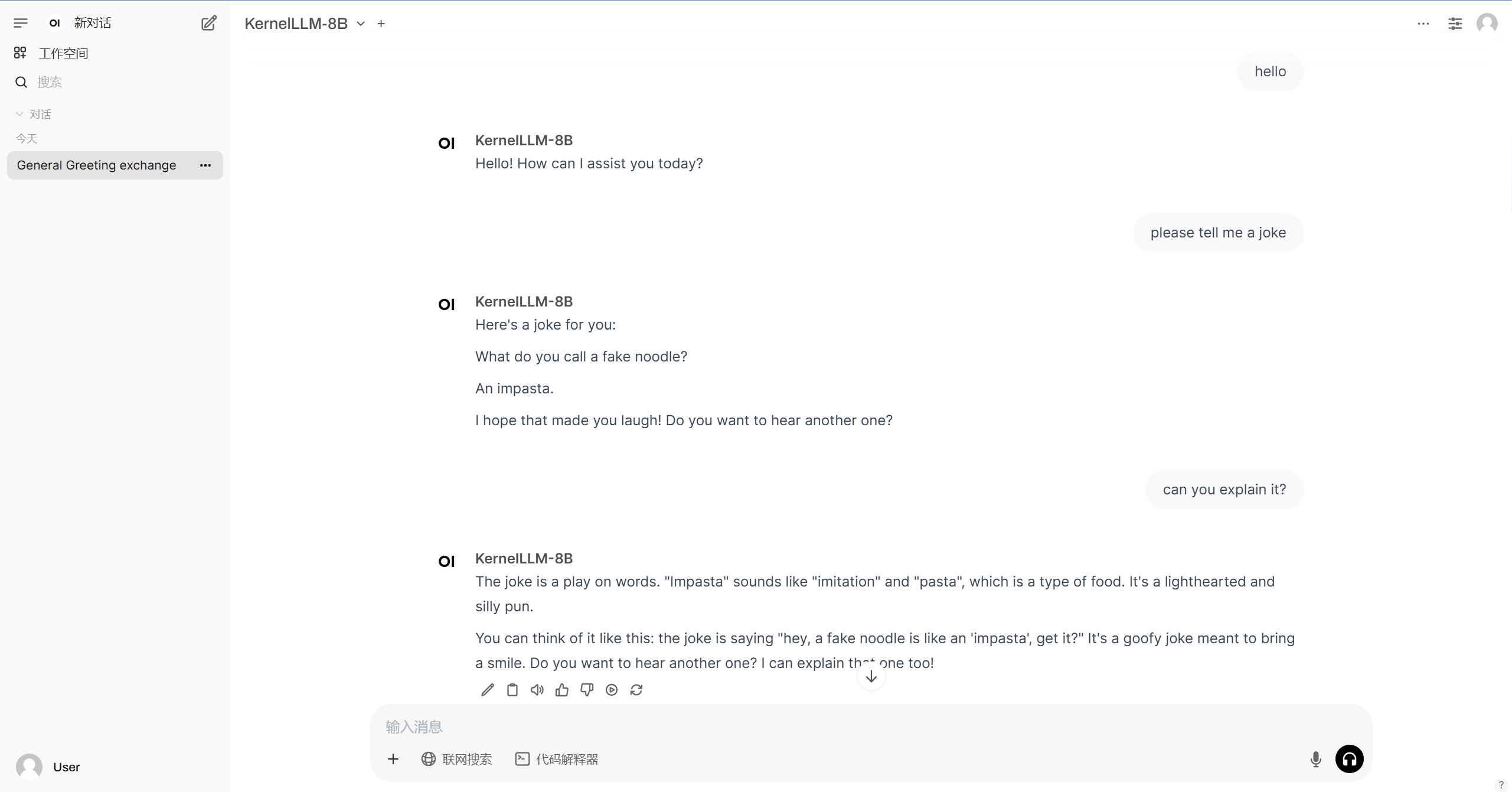

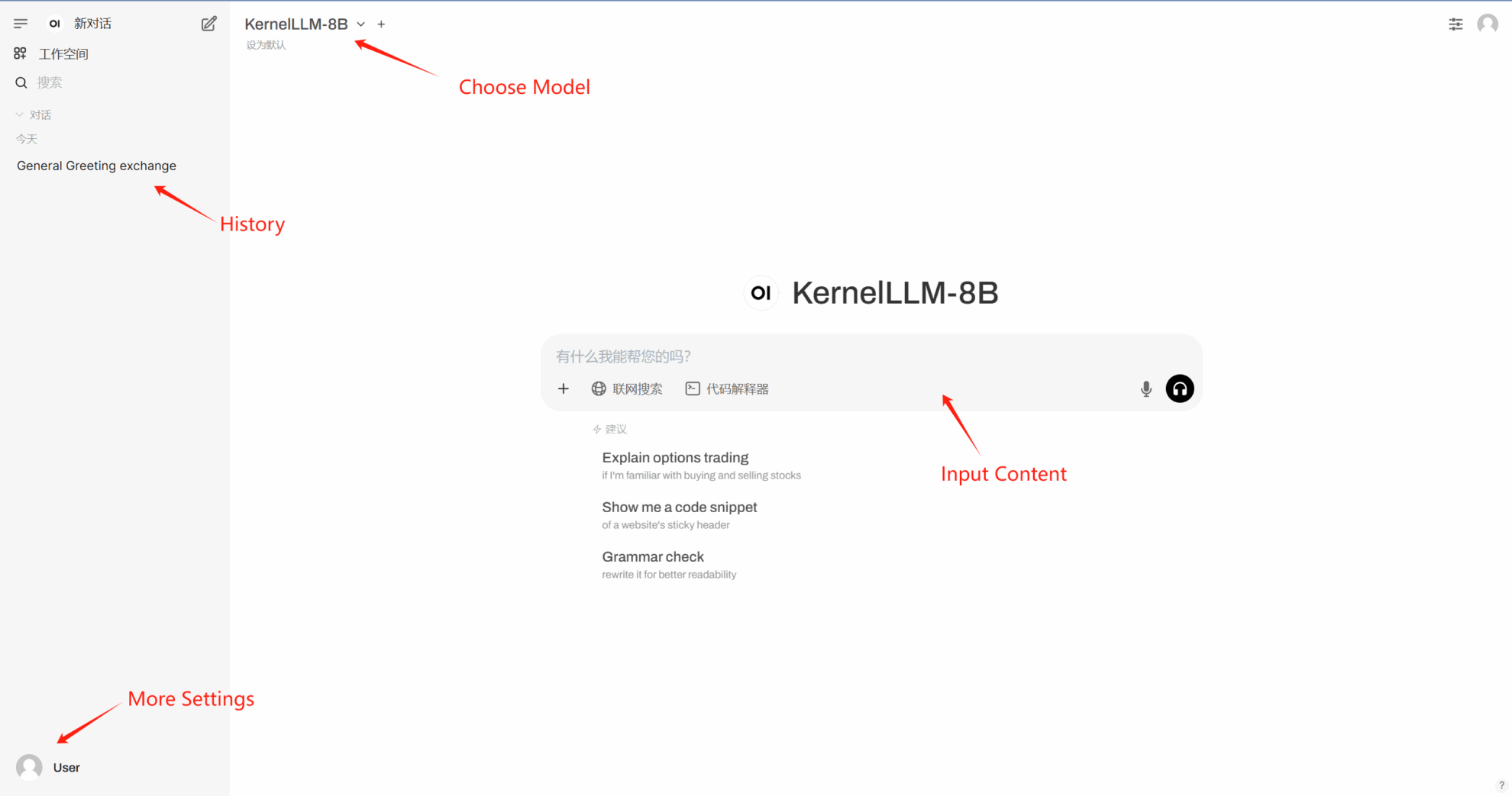

2. Web ページに入ると、モデルと会話を開始できます。

4. 議論

🖌️ 高品質のプロジェクトを見つけたら、メッセージを残してバックグラウンドで推奨してください。さらに、チュートリアル交換グループも設立しました。お友達はコードをスキャンして [SD チュートリアル] に参加し、さまざまな技術的な問題について話し合ったり、アプリケーションの効果を共有したりできます。